《Scatter Component Analysis: A Unified Framework for Domain Adaptation and Domain Generalization》学习

IEEE TRANSACTIONS ON PATTERN ANALYSIS AND MACHINE INTELLIGENCE

摘要

两个密切相关的框架,域自适应和域泛化,与此类任务有关,其中这些框架之间的唯一区别是未标记目标数据的可用性:域自适应可以利用未标记目标信息,而域泛化不能。

我们提出了散射分量分析(SCA),这是一种快速表示学习算法,可应用于域自适应和域泛化。SCA基于一个简单的几何度量,即散射,它在再生核希尔伯特空间上运行。

SCA找到了一种在最大化类的可分离性、最小化域之间的不匹配和最大化数据的可分离性之间进行权衡的表示;其中每一个都通过分散量化。

SCA的优化问题可以简化为广义特征值问题,从而得到快速精确的解。在基准跨域对象识别数据集上进行的综合实验验证了SCA的性能比几种最先进的算法快得多,并且在域自适应和域泛化方面都提供了最先进的分类精度。我们还表明,在域自适应的情况下,散射可以用来建立理论泛化界。

索引项:领域自适应、领域泛化、特征学习、核心方法、分散性和对象识别

一、介绍

开发对标记稀缺性和数据集偏差具有鲁棒性的学习算法是一个重要而紧迫的问题。

提出了域自适应[10]和域泛化[11]来克服上述问题。在这种情况下,域表示从中提取样本的概率分布,通常等同于数据集。

域自适应的目标是通过对源域的标签进行训练,并在训练期间利用目标域的未标记样本作为辅助信息,在目标域上生成良好的模型

域泛化问题出现在未标记的目标样本不可用,但可以访问多个源域的样本的情况下。

尽管域自适应和域泛化是密切相关的问题,但域自适应算法通常不能直接应用于域泛化,因为它们依赖于目标域中(未标记)样本的可用性。

非常需要开发能够更高效地计算、与域自适应和域生成兼容并提供最先进性能的算法。

1.1目标和目的

我们算法的基本思想是学习表示作为分类器的输入,该分类器对数据集偏差保持不变。直觉上,学习到的表达应包含四个要求:

- 使用不同标签分离点,

- 将数据作为一个整体分离(高方差),

- 不分离共享标签的点,

- 减少两个或多个域之间的不匹配。

本文的主要贡献如下:

- 第一个贡献是散射,这是一个简单的几何函数,量化了分布距其质心的均方距离。我们表明,上述四项要求可以通过离散度进行编码,并与线性判别分析、主成分分析、最大均值差异(MMD)和分布方差建立关系

- 第二个贡献是一种快速的基于分散的特征学习算法,可应用于领域自适应和领域泛化问题,即分散组件分析(SCA),见算法1。据我们所知,SCA是第一个适用于一系列领域自适应和泛化任务的多用途算法。SCA优化简化为广义特征问题,在时间复杂度方面允许与核PCA[26]相同的快速精确解。

- 第三个贡献是推导了域自适应情况下SCA的理论界。我们的理论分析表明,域分散控制着SCA的泛化性能。我们证明了在一定条件下,域散射控制离散距离。先前已经证明,离散距离可以控制域自适应算法的泛化性能

我们进行了广泛的实验,以评估SCA在域适配和域泛化设置中相对于一大套备选方案的性能。我们发现,在一系列视觉对象跨域识别中,SCA的执行速度远远快于现有技术,在准确性方面具有竞争力或更好的性能

1.2文章的组织

第2节描述了问题的定义,并回顾了领域自适应和领域泛化方面的现有工作。

第3节和第4节描述了我们提出的工具,以及相应的特征学习算法,即散射组件分析。

第5节介绍了SCA的理论域自适应范围。

第6节和第7节提供了综合评估结果和分析。

最后,第8节总结了本文。

二、背景与文献综述

设

S

=

{

x

i

,

y

i

}

i

=

1

n

~

P

S=\{x_i,y_i\}^n_{i=1}\sim\mathbb{P}

S={xi?,yi?}i=1n?~P可以是来自域的样本。对于相应的经验分布

P

^

(

x

,

y

)

=

1

n

∑

i

=

1

n

δ

(

x

i

,

y

i

)

(

x

,

y

)

\mathbb{\hat P}(x,y)=\frac{1}{n}\sum^n_{i=1}\delta_{(x_i,y_i)}(x,y)

P^(x,y)=n1?∑i=1n?δ(xi?,yi?)?(x,y),使用符号

P

^

\mathbb{\hat P}

P^是很方便的;其中d是Dirac delta。我们定义域自适应和域泛化如下,

定义1(域适配)

设

P

s

\mathbb{P}^s

Ps和

P

t

\mathbb{P}^t

Pt分别为源域和目标域,其中

P

s

≠

P

t

\mathbb{P}^s\ne\mathbb{P}^t

Ps=Pt。

从两个域中抽取样本,表示为

S

s

=

{

x

i

s

,

y

i

s

}

i

=

1

n

s

~

P

s

S^s=\{x^s_i,y^s_i\}^{n_s}_{i=1}\sim\mathbb{P}^s

Ss={xis?,yis?}i=1ns??~Ps和

S

u

t

=

{

x

i

t

}

i

=

1

n

t

~

P

X

t

S^t_u=\{x^t_i\}^{n_t}_{i=1}\sim\mathbb{P}^t_X

Sut?={xit?}i=1nt??~PXt?。域自适应的任务是学习良好的标记函数

f

P

t

f_{\mathbb{P}^t}

fPt?:

X

→

Y

X\rightarrow Y

X→Y给出

S

s

S^s

Ss和

S

u

t

S^t_u

Sut?作为训练示例。

定义2(域泛化)

Δ

=

{

P

1

,

…

,

P

m

}

\Delta=\{\mathbb{P}^1,\dots,\mathbb{P}^m\}

Δ={P1,…,Pm}可以是m个源域的集合,

P

t

?

Δ

\mathbb{P}^t\notin\Delta

Pt∈/Δ是目标域。表示为

S

d

=

{

x

i

d

,

y

i

d

}

i

=

1

n

d

~

P

d

S^d=\{x^d_i,y^d_i\}^{n_d}_{i=1}\sim\mathbb{P}^d

Sd={xid?,yid?}i=1nd??~Pd样本取自m个源域。域泛化的任务是学习标记函数

f

P

t

f_{\mathbb{P}^t}

fPt?:

X

→

Y

X\rightarrow Y

X→Y给出

S

d

,

?

d

=

1

,

…

,

m

S^d,\forall d=1,\dots,m

Sd,?d=1,…,m作为训练示例。

在实践中,域泛化要求

m

>

1

m>1

m>1才能正常工作,尽管

m

=

1

m=1

m=1可能不会违反定义2。请注意,如果

m

=

2

m=2

m=2和

P

X

t

∈

Δ

\mathbb{P}^t_X\in\Delta

PXt?∈Δ,则域泛化可以精确地简化为域自适应。

2.1域自适应

我们将域自适应算法分为三类:

- 分类器自适应方法

- 选择/重加权方法

- 基于特征变换的方法。

分类器自适应方法旨在通过利用源域或辅助域的知识,在目标域上学习良好的自适应分类器。

重新加权(选择方法)通过重新加权(选择)与目标实例“接近”的源实例来减少样本偏差。选择可被视为重新加权的“硬”版本。以协变量转移的名义研究了这一基本思想。

基于特征变换的方法可能是领域自适应中最流行的方法。

一些工作已经解决了域自适应的近似正确的理论界限。

2.2领域泛化

Blanchard等人[11]首先研究了这个问题,并提出了一种增强的支持向量机,将经验边缘分布编码到内核中,用于解决流式细胞术的自动选通问题。

领域泛化算法也已用于对象识别。

最近,提出了一种基于自动编码器的算法,通过多任务学习提取域不变特征

尽管域自适应和域泛化具有相同的目标(减少数据集偏差),但这些方法通常互不兼容-域自适应方法不能直接应用于域泛化,反之亦然

据我们所知,只有LRE-SVM可以应用于域自适应和域泛化。

DICA、撤销偏差或UML中的域泛化算法公式通常不允许考虑来自目标域的未标记数据。

此外,一些最先进的领域自适应和领域泛化算法,如TJM和LRE-SVM,需要解决计算复杂的优化问题,这会导致较高的时间上的复杂性。

在这项工作中,我们建立了一种克服上述问题的快速算法。

三、散度

我们在一个特征空间中工作,该空间是一个再生核希尔伯特空间(RKHS)

H

\mathcal{H}

H。主要动机是将原始输入转换到

H

\mathcal{H}

H上,

H

\mathcal{H}

H是高维或可能是无限维空间,希望新特征是线性可分离的。RKHS最重要的特性可能是通过核技巧允许对

H

\mathcal{H}

H进行计算上可行的转换。

定义3(希尔伯特空间中的再生核)。

设

X

\mathcal X

X为任意集,和

H

?

{

f

:

X

→

R

}

\mathcal H\subset\{f:\mathcal X\rightarrow\mathbb R\}

H?{f:X→R}是

X

\mathcal X

X上的Hilbert函数空间。

定义评估函数

L

x

:

H

→

R

L_x:\mathcal H\rightarrow\mathbb R

Lx?:H→R,通过

L

x

[

h

]

:

=

h

(

x

)

,

?

h

∈

H

L_x[h]:=h(x),\forall h\in\mathcal H

Lx?[h]:=h(x),?h∈H

如果函数

L

x

L_x

Lx?总是有界的,则

H

\mathcal H

H是再生核Hilbert空间:

对于所有的

x

∈

X

x\in\mathcal X

x∈X存在一个

λ

>

0

\lambda>0

λ>0

∣

L

x

[

h

]

∣

=

∣

h

(

x

)

∣

≤

λ

∥

h

∥

H

(1)

|L_x[h]|=|h(x)|\le\lambda\|h\|_{\mathcal H}\tag{1}

∣Lx?[h]∣=∣h(x)∣≤λ∥h∥H?(1)

因此,存在函数

?

:

X

→

H

\phi:\mathcal X\rightarrow\mathcal H

?:X→H(称为规范特征映射)满足:

∣

L

x

[

h

]

∣

=

?

h

,

?

(

x

)

?

=

h

(

x

)

对所有的

h

∈

H

,

x

∈

X

(2)

|L_x[h]|=\langle h,\phi(x)\rangle=h(x)对所有的h\in\mathcal H,x\in\mathcal X\tag{2}

∣Lx?[h]∣=?h,?(x)?=h(x)对所有的h∈H,x∈X(2)

因此,对于每个

t

∈

X

t\in\mathcal X

t∈X,可以写入

?

?

(

t

)

,

?

(

x

)

?

=

:

κ

(

t

,

x

)

\langle \phi(t),\phi(x)\rangle=:\kappa(t,x)

??(t),?(x)?=:κ(t,x)

函数

κ

:

X

×

X

→

R

\kappa:\mathcal X\times\mathcal X\rightarrow\mathbb R

κ:X×X→R被称为再生内核

表达式(1)是确保内积存在以及在域中的每个点计算H中每个函数的能力的最弱条件,而(2)在实践中提供了更有用的概念。

在引入散射之前,可以方便地首先使用均值映射将发送域表示为RKHS中的点

定义4(均值映射)。

假设

X

\mathcal X

X配备了一个内核,

H

\mathcal H

H是具有特征映射的相应RKHS,

?

:

X

→

H

\phi:\mathcal X\rightarrow\mathcal H

?:X→H

设

Δ

X

\Delta_{\mathcal X}

ΔX?表示

X

\mathcal X

X上的概率分布集。均值映射将

X

\mathcal X

X上的分布取为

H

\mathcal H

H中的点:

μ

:

Δ

X

→

H

:

P

?

E

x

~

P

[

?

(

x

)

]

=

:

μ

P

\mu:\Delta_{\mathcal X}\rightarrow\mathcal H:\mathbb P\mapsto\mathbb E_{x\sim\mathbb P}[\phi(x)]=:\mu_{\mathbb P}

μ:ΔX?→H:P?Ex~P?[?(x)]=:μP?

几何上,平均图是

?

\phi

?下分布图像的质心。我们将散射定义为图像中围绕其质心的点的方差:

定义5(散度)

分布

P

\mathbb P

P在

X

\mathcal X

X上相对于

?

\phi

?的散射为:

Ψ

?

(

P

)

:

=

E

x

~

P

[

∥

μ

P

?

?

(

x

)

∥

H

2

]

\Psi_{\phi}(\mathbb P):=\mathbb E_{x\sim\mathbb P}\left[\|\mu_{\mathbb P}-\phi(x)\|^2_{\mathcal H}\right]

Ψ??(P):=Ex~P?[∥μP???(x)∥H2?]

其中

∥

?

∥

H

\|\cdot\|_{\mathcal H}

∥?∥H?是

H

\mathcal H

H上的范数。

域的散射不能直接计算;相反,它是根据观察结果估计的。有限观测集

{

x

1

,

…

,

x

n

}

\{x_1,\dots,x_n\}

{x1?,…,xn?}的散射;相对于经验分布计算

P

^

(

x

)

:

=

1

n

∑

i

=

1

n

δ

x

i

(

x

)

其中

δ

x

i

(

x

)

=

{

1

if

x

i

=

x

0

else.

\hat{\mathbb{P}}(x):=\frac{1}{n}\sum^{n}_{i=1}\delta_{x_i}(x)其中\delta_{x_i}(x)=\begin{cases}1&\text{if}\quad x_i=x\\0&\text{else.}\end{cases}

P^(x):=n1?i=1∑n?δxi??(x)其中δxi??(x)={10?ifxi?=xelse.?

我们提供了一个定理,说明了真实散射和有限样本估计之间的差异如何随着样本大小而减小。

定理1(散射界)。

假设

P

\mathbb{P}

P是大小为n的所有样本的真实分布,

P

^

\hat{\mathbb{P}}

P^是其经验分布。

进一步假设

∥

?

(

x

)

∥

2

≤

M

\|\phi(x)\|^2\le M

∥?(x)∥2≤M对于所有

x

∈

X

x\in\mathcal X

x∈X。然后,

p

r

o

b

a

b

i

l

i

t

y

≥

1

?

δ

probability\ge 1-\delta

probability≥1?δ,

∣

Ψ

?

(

P

)

?

Ψ

?

(

P

^

)

∣

≤

M

2

l

o

g

(

2

δ

)

n

|\Psi_{\phi}(\mathbb P)-\Psi_{\phi}(\hat{\mathbb P})|\le M\sqrt{\frac{2log(\frac{2}{\delta})}{n}}

∣Ψ??(P)?Ψ??(P^)∣≤Mn2log(δ2?)??

注意,对于

M

M

M的较低值和

n

n

n的较高值,边界的右侧位置较小。此外,如果

κ

\kappa

κ是高斯核的形式,则边界仅取决于

n

n

n,因为

M

=

1

M=1

M=1

如果输入空间是向量空间,且

?

\phi

?是恒等式,则直接如下:

引理2(总方差为散布)

p维点集的散布(矩阵形式)

X

=

[

x

1

,

…

,

x

n

]

T

∈

R

n

×

p

\mathrm X=[\mathrm x_1,\dots,\mathrm x_n]^T\in\mathbb{R}^{n\times p}

X=[x1?,…,xn?]T∈Rn×p相对于单位映射

?

(

x

)

:

=

x

\phi(\mathrm x):=\mathrm x

?(x):=x,是总方差:

Ψ

(

X

)

=

1

n

T

r

(

X

?

X

ˉ

)

T

(

X

?

X

ˉ

)

=

Tr?Cov

(

X

)

\Psi(\mathrm X)=\frac{1}{n}Tr(\mathrm X-\bar {\mathrm X})^T(\mathrm X-\bar {\mathrm X})=\text{Tr Cov}(\mathrm X)

Ψ(X)=n1?Tr(X?Xˉ)T(X?Xˉ)=Tr?Cov(X)

其中

T

r

(

?

)

Tr(\cdot)

Tr(?)表示迹操作,

X

ˉ

=

[

x

ˉ

,

…

,

x

ˉ

]

T

\bar {\mathrm X}=[\bar {\mathrm x},\dots,\bar {\mathrm x}]^T

Xˉ=[xˉ,…,xˉ]T其中

x

ˉ

=

∑

i

=

1

n

x

i

ˉ

\bar {\mathrm x}=\sum^n_{i=1}\bar {\mathrm x_i}

xˉ=∑i=1n?xi?ˉ?

我们利用分散来制定一种称为分散组件分析的特征学习算法。具体而言,分散组件分析量化了SCA中所需的需求,以开发域自适应和泛化的有效解决方案,这将在下一节中描述。

四、散射成分分析

SCA的目标是有效地学习一种表示法,以改进域自适应和域泛化。该策略是将观测值转换为特征空间中的点配置,从而减少域失配。然后,SCA找到问题的表示形式(即特征空间的线性变换)

- 源域和目标域相似

- 具有相同标签的元素相似

- 具有不同标签的元素被很好地分离

- 整个数据的方差被最大化。

每个需求都可以通过导致四种结果的分散来量化:

- 域分散,

- 类间分散

- 类内分散

- 总分散

我们还将看到,通过修改输入域的配置,SCA可以轻松切换到域自适应或域泛化。

4.1总散射

给定m个域

P

X

1

,

…

,

P

X

m

在

X

\mathbb{P}^1_X,\dots,\mathbb{P}^m_X在\mathcal X

PX1?,…,PXm?在X,我们将总域定义为平均值

P

ˉ

X

=

1

m

∑

d

=

1

m

P

X

d

\bar{\mathbb{P}}_X=\frac{1}{m}\sum^m_{d=1}\mathbb{P}^d_X

PˉX?=m1?∑d=1m?PXd? 。总散射定义为

total?scatter

=

Ψ

?

(

P

ˉ

X

)

(3)

\text{total scatter}=\Psi_{\phi}(\bar{\mathbb{P}}_X)\tag{3}

total?scatter=Ψ??(PˉX?)(3)

值得强调的是,该定义是一般性的,因为它涵盖了域适应(

m

=

2

m=2

m=2,其中一个是目标域)和域泛化(

m

>

2

m>2

m>2)。

根据以下数据估计总散射,设

X

=

[

x

1

,

…

,

x

n

]

T

∈

R

n

×

p

X=[x_1,\dots,x_n]^T\in\mathbb R^{n\times p}

X=[x1?,…,xn?]T∈Rn×p是来自所有

m

m

m个域的未标记样本的矩阵(

n

=

∑

d

=

1

m

n

d

n=\sum^m_{d=1}n_d

n=∑d=1m?nd?,其中

n

d

n_d

nd?是第d维域中的示例数)。

给定一个特征映射

?

:

R

p

→

H

\phi:\mathbb{R}^p\rightarrow\mathcal H

?:Rp→H对应核

κ

\kappa

κ,定义一组按列向量排列的函数

Φ

=

[

?

(

x

1

)

,

…

,

?

(

x

n

)

]

T

\Phi=[\phi(x_1),\dots,\phi(x_n)]^T

Φ=[?(x1?),…,?(xn?)]T,取

{

?

(

x

i

)

}

i

=

1

n

\{\phi(x_i)\}^n_{i=1}

{?(xi?)}i=1n?为中心,减去平均值,协方差矩阵为

Cov

(

Φ

)

=

1

n

Φ

T

Φ

\text{Cov}(\Phi)=\frac{1}{n}\Phi^T\Phi

Cov(Φ)=n1?ΦTΦ。由引理2,

Ψ

?

(

P

ˉ

^

X

)

=

Tr?Cov

(

Φ

)

(4)

\Psi_{\phi}(\hat{\bar{\mathbb{P}}}_X)=\text{Tr Cov}(\Phi)\tag{4}

Ψ??(Pˉ^X?)=Tr?Cov(Φ)(4)

我们感兴趣的是对有限相关子空间应用线性变换后的总散点

W

:

H

→

R

k

W:\mathcal H\rightarrow\mathbb R^k

W:H→Rk,避免直接计算

?

:

X

→

H

\phi:\mathcal X\rightarrow\mathcal H

?:X→H,这可能是昂贵的或不可撤消的,我们使用内核技巧。

让

Z

=

Φ

W

∈

R

n

×

k

Z=\Phi W\in\mathbb R^{n\times k}

Z=ΦW∈Rn×k是n个变换后的特征向量,

[

K

]

i

,

j

=

[

Φ

Φ

T

]

i

,

j

=

[

κ

(

x

i

,

x

j

)

]

[K]_{i,j}=[\Phi\Phi^T]_{i,j}=[\kappa(x_i,x_j)]

[K]i,j?=[ΦΦT]i,j?=[κ(xi?,xj?)],确定了

B

∈

R

n

×

k

B\in\mathbb R^{n\times k}

B∈Rn×k之后使

W

=

Φ

T

B

W=\Phi^TB

W=ΦTB,变换后的散点总数为

Ψ

B

°

?

(

P

̄

^

X

)

=

Tr

?

(

1

n

B

?

K

K

B

)

(5)

\Psi_{\mathbf{B} \circ \phi}\left(\hat{\overline{\mathbb{P}}}_{X}\right)=\operatorname{Tr}\left(\frac{1}{n} \mathbf{B}^{\top} \mathbf{K K B}\right)\tag{5}

ΨB°??(P^X?)=Tr(n1?B?KKB)(5)

我们注意到,在我们的符号中,核主成分分析(KPCA)对应于优化问题

max

?

Ψ

B

°

?

(

P

̄

^

X

)

(6)

\max\Psi_{\mathbf{B} \circ \phi}\left(\hat{\overline{\mathbb{P}}}_{X}\right)\tag{6}

maxΨB°??(P^X?)(6)

4.2域散射

假设已知m个定义域

P

X

1

,

…

,

P

X

m

\mathbb P^1_X,\dots,\mathbb P^m_X

PX1?,…,PXm?在

X

\mathcal X

X,我们可以把集合

{

μ

P

X

1

,

…

,

μ

P

X

m

}

?

H

\{\mu_{\mathbb P^1_X},\dots,\mu_{\mathbb P^m_X}\}\subset\mathcal H

{μPX1??,…,μPXm??}?H作为一个来自某些区域潜在分布的样本,将样本配置为经验分布,计算散点相对于H产率域散点上的恒等图:

Ψ

(

{

μ

P

X

1

,

…

,

μ

P

X

m

}

)

=

1

m

∑

i

=

1

m

∥

μ

ˉ

?

μ

P

i

∥

2

(7)

\Psi(\{\mu_{\mathbb P^1_X},\dots,\mu_{\mathbb P^m_X}\})=\frac{1}{m}\sum^m_{i=1}\|\bar\mu-\mu_{\mathbb P^i}\|^2\tag{7}

Ψ({μPX1??,…,μPXm??})=m1?i=1∑m?∥μˉ??μPi?∥2(7)

其中

μ

ˉ

=

1

m

∑

i

=

1

m

μ

P

i

\bar\mu=\frac{1}{m}\sum^m_{i=1}\mu_{\mathbb P^i}

μˉ?=m1?∑i=1m?μPi?。注意,域散射与[19]中引入的分布方差一致。在一些域适应算法中,域散射与最大均值差异也有密切关系。

定义6:

F设为函数

f

:

X

→

R

f:\mathcal X\rightarrow\mathbb R

f:X→R的集合,区域

P

\mathbb P

P和

Q

\mathbb Q

Q之间的最大均值差异为

M

M

D

F

[

P

,

Q

]

:

=

sup

?

f

∈

F

(

E

P

[

f

(

x

)

]

?

E

Q

[

f

(

x

)

]

)

MMD_{\mathcal F}[\mathbb{P,Q}]:=\sup_{f\in\mathcal F}\left(\mathbb E_{\mathbb P}[f(x)]-\mathbb E_{\mathbb Q}[f(x)]\right)

MMDF?[P,Q]:=f∈Fsup?(EP?[f(x)]?EQ?[f(x)])

MMD从函数类F的角度衡量两个域彼此相似的程度。以下定理将区域散点与给定的两个域的MMD联系起来,其中感兴趣的情况是特征空间上的有界线性函数:

引理3(散射恢复MMD)

域

P

\mathbb P

P和

Q

\mathbb Q

Q在

X

\mathcal X

X上的散度为其(平方)最大均值差异:

Ψ

(

{

μ

P

,

μ

Q

}

)

=

1

4

M

M

D

F

2

[

P

,

Q

]

\Psi(\{\mu_{\mathbb P},\mu_{\mathbb Q}\})=\frac{1}{4}MMD^2_{\mathcal F}[\mathbb P,\mathbb Q]

Ψ({μP?,μQ?})=41?MMDF2?[P,Q]

其中

F

=

{

f

:

X

→

R

∣

f

是线性的,并且

∥

f

∥

F

≤

1

}

\mathcal F=\{f:\mathcal X\rightarrow\mathbb R|f是线性的,并且\|f\|_{\mathcal F}\le 1\}

F={f:X→R∣f是线性的,并且∥f∥F?≤1}

特别地,如果

?

\phi

?是由

X

\mathcal X

X上的特征核诱导的,那么

Ψ

(

{

μ

P

,

μ

Q

}

)

=

0

\Psi(\{\mu_{\mathbb P},\mu_{\mathbb Q}\})=0

Ψ({μP?,μQ?})=0当且仅当

P

=

Q

\mathbb P=\mathbb Q

P=Q。

请注意,该定理涉及两级概率分布:

- X \mathcal X X上的区域 P \mathbb P P和 Q \mathbb Q Q

- F \mathcal F F上的经验分布将 p = 1 2 p=\frac{1}{2} p=21?的概率分配给 μ P \mu_{\mathbb P} μP?和 μ Q \mu_{\mathbb Q} μQ?点, p = 0 p=0 p=0分配给其他点。

根据定义5,

Ψ

(

{

μ

P

,

μ

Q

}

)

=

1

2

∥

μ

ˉ

?

μ

P

∥

F

2

+

1

2

∥

μ

ˉ

?

μ

Q

∥

F

2

=

1

4

∥

μ

P

?

μ

Q

∥

F

2

\Psi(\{\mu_{\mathbb P},\mu_{\mathbb Q}\})=\frac{1}{2}\|\bar\mu-\mu_{\mathbb P}\|^2_{\mathcal F}+\frac{1}{2}\|\bar\mu-\mu_{\mathbb Q}\|^2_{\mathcal F}=\frac{1}{4}\|\mu_{\mathbb P}-\mu_{\mathbb Q}\|^2_{\mathcal F}

Ψ({μP?,μQ?})=21?∥μˉ??μP?∥F2?+21?∥μˉ??μQ?∥F2?=41?∥μP??μQ?∥F2?

引理3还告诉我们,如果X上的核是特征的,则域散射是一个有效的度量。特征核最重要的例子是高斯RBF核,它是下面理论结果和实验中使用的核。我们还注意到,MMD可以由[66]中提供的有界观测数据估计,这与定理1类似。

在

R

k

\mathbb R^k

Rk中,对变换后的特征空间的域散度估计如下。

假设有m个样本

S

u

d

=

{

x

i

d

}

i

=

1

n

d

~

P

X

d

S^d_u=\{\mathbf x^d_i\}^{n_d}_{i=1}\sim\mathbb P^d_{\mathbf X}

Sud?={xid?}i=1nd??~PXd?回想一下,

Z

=

Φ

W

=

K

T

B

\mathbf Z=\mathbf{\Phi W}=\mathbf{K}^T\mathbf{B}

Z=ΦW=KTB,式中

Z

=

[

z

1

,

…

,

z

n

]

T

\mathbf Z=[\mathbf z_1,\dots,\mathbf z_n]^T

Z=[z1?,…,zn?]T包含来自所有域的投影样本:

z

i

=

W

T

?

(

x

i

)

\mathbf z_i=\mathbf W^T\phi(\mathbf x_i)

zi?=WT?(xi?)和

K

=

[

K

11

?

K

1

m

?

?

?

K

m

1

?

K

m

m

]

∈

R

n

×

n

(8)

\mathbf{K}=\left[\begin{array}{ccc} \mathbf{K}^{11} & \cdots & \mathbf{K}^{1 m} \\ \vdots & \ddots & \vdots \\ \mathbf{K}^{m 1} & \cdots & \mathbf{K}^{m m} \end{array}\right] \in \mathbb{R}^{n \times n}\tag{8}

K=?

??K11?Km1?????K1m?Kmm??

??∈Rn×n(8)

是对应的核矩阵,其中

[

K

k

l

]

i

,

j

=

κ

(

x

i

k

,

x

j

l

)

[\mathbf K^{kl}]_{i,j}=\kappa(\mathbf x^k_i,\mathbf x^l_j)

[Kkl]i,j?=κ(xik?,xjl?),通过代数运算,域散射是

Ψ

B

(

{

μ

P

^

X

d

}

d

=

1

m

)

=

Tr

(

B

T

K

L

K

B

)

(9)

\Psi_{\mathbf B}(\{\mu_{\hat{\mathbb P}^d_{X}}\}^m_{d=1})=\text{Tr}(\mathbf B^T\mathbf {KLKB})\tag{9}

ΨB?({μP^Xd??}d=1m?)=Tr(BTKLKB)(9)

其中

[

L

k

l

]

i

,

j

=

m

?

1

m

2

n

k

2

[\mathbf L^{kl}]_{i,j}=\frac{m-1}{m^2n^2_k}

[Lkl]i,j?=m2nk2?m?1?的系数矩阵是

L

∈

R

n

×

n

\mathbf L\in\mathbb R^{n\times n}

L∈Rn×n如果

k

=

l

k=l

k=l和

?

1

m

2

n

k

n

l

-\frac{1}{m^2n_kn_l}

?m2nk?nl?1?否则。

4.3类散射

对于每一类

k

∈

{

1

,

…

,

C

}

k\in\{1,\dots,C\}

k∈{1,…,C},让

P

X

∣

k

l

\mathbb P^l_{X|k}

PX∣kl?表示

Y

=

k

Y=k

Y=k时总标记域

P

X

Y

l

=

1

q

∑

j

=

1

q

P

X

Y

j

\mathbb P^l_{XY}=\frac{1}{q}\sum^q_{j=1}\mathbb P^j_{XY}

PXYl?=q1?∑j=1q?PXYj?在X上的条件分布(标记域的数量q不一定等于源域的数量m)。

我们将类内散射和类间散射定义为

Ψ

?

(

P

X

∣

k

l

)

?

within-class-?

k

?scatter?

?and?

Ψ

(

{

μ

P

X

∣

k

=

1

l

,

…

,

μ

P

X

∣

k

=

C

l

}

)

?

between-classcatter?

.?

(10)

\underbrace{\Psi_{\phi}\left(\mathbb{P}_{X \mid k}^{l}\right)}_{\text {within-class- } k \text { scatter }} \text { and } \underbrace{\Psi\left(\left\{\mu_{\mathbb{P}_{X \mid k=1}^{l}}, \ldots, \mu_{\mathbb{P}_{X \mid k=C}^{l}}\right\}\right)}_{\text {between-classcatter }} \text {. }\tag{10}

within-class-?k?scatter?

Ψ??(PX∣kl?)???and?between-classcatter?

Ψ({μPX∣k=1l??,…,μPX∣k=Cl??})??.?(10)

类散射估计如下。

让

S

k

w

=

(

?

(

x

j

)

)

x

j

∈

k

\mathbf S^w_k=(\phi(\mathbf{x}_j))_{\mathbf{x}_j\in k}

Skw?=(?(xj?))xj?∈k?表示类k中源样本的

n

k

n_k

nk?元组。

S

k

w

\mathbf S^w_k

Skw?的质心为

μ

k

=

1

n

k

∑

x

i

∈

k

?

(

x

i

)

\mathbf{\mu}_k=\frac{1}{n_k}\sum_{\mathbf x_i\in k}\phi(\mathbf x_i)

μk?=nk?1?∑xi?∈k??(xi?)

此外,让

S

b

=

(

μ

1

,

…

,

μ

∣

C

∣

)

\mathbf S^b=(\mu_1,\dots,\mu_{|C|})

Sb=(μ1?,…,μ∣C∣?)表示所有类质心的n元组,其中质心k在

S

b

\mathbf S^b

Sb中出现

n

k

n_k

nk?次。则

S

b

\mathbf S^b

Sb的质心为源域质心:

1

n

∑

k

=

1

∣

c

∣

n

k

μ

k

\frac{1}{n}\sum^{|c|}_{k=1}n_k\mu_k

n1?∑k=1∣c∣?nk?μk?由此可知,类内散度为

Ψ

?

(

P

^

X

∣

y

k

l

)

=

Tr

(

∑

j

=

1

n

k

(

?

(

x

)

j

k

?

μ

k

)

(

?

(

x

)

j

k

?

μ

k

)

T

)

\Psi_{\phi}\left(\hat{\mathbb{P}}_{X \mid y_k}^{l}\right)=\text{Tr}\left(\sum^{n_k}_{j=1}(\phi(\mathbf x)_{jk}-\mu_k)(\phi(\mathbf x)_{jk}-\mu_k)^T\right)

Ψ??(P^X∣yk?l?)=Tr(j=1∑nk??(?(x)jk??μk?)(?(x)jk??μk?)T)

类间的散度是

Ψ

(

{

μ

P

^

X

∣

y

k

l

}

k

=

1

C

)

=

Tr

(

n

k

(

μ

k

?

μ

ˉ

)

(

μ

k

?

μ

ˉ

)

T

)

\Psi\left(\{\mu_{\hat{\mathbb P}^l_{X \mid y_k}}\}^C_{k=1}\right)=\text{Tr}\left(n_k(\mu_k-\bar{\mu})(\mu_k-\bar{\mu})^T\right)

Ψ({μP^X∣yk?l??}k=1C?)=Tr(nk?(μk??μˉ?)(μk??μˉ?)T)

上述方程的右边是类内和类间散点[24]的经典定义。因此经典的线性判别式是散射比

Fisher’s?linear?discriminant

=

Ψ

(

{

μ

P

^

X

∣

y

k

l

}

k

=

1

C

)

∑

k

=

1

C

Ψ

?

(

P

^

X

∣

y

k

l

)

\text{Fisher's linear discriminant}=\frac{\Psi\left(\{\mu_{\hat{\mathbb P}^l_{X \mid y_k}}\}^C_{k=1}\right)}{\sum^C_{k=1}\Psi_{\phi}\left(\hat{\mathbb{P}}_{X \mid y_k}^{l}\right)}

Fisher’s?linear?discriminant=∑k=1C?Ψ??(P^X∣yk?l?)Ψ({μP^X∣yk?l??}k=1C?)?

给定一个线性变换

W

:

H

→

R

k

\mathbf W:\mathcal H\rightarrow\mathbb R^k

W:H→Rk由引理2可知,类在投影特征空间

H

~

\tilde H

H~中的散射为

Ψ

B

(

{

μ

P

^

X

∣

y

k

l

}

k

=

1

C

)

=

Tr

(

W

T

Cov

(

S

b

)

W

)

=

Tr

(

B

T

P

s

B

)

(11)

\Psi_{\mathbf B}\left(\{\mu_{\hat{\mathbb P}^l_{X \mid y_k}}\}^C_{k=1}\right)=\text{Tr}(\mathbf W^T\text{Cov}(\mathbf S^b)\mathbf W)\\ =\text{Tr}(\mathbf B^T\mathbf{P}_s\mathbf B)\tag{11}

ΨB?({μP^X∣yk?l??}k=1C?)=Tr(WTCov(Sb)W)=Tr(BTPs?B)(11)

∑

k

=

1

C

Ψ

B

°

?

(

P

^

X

∣

y

k

s

)

=

∑

k

=

1

C

Tr

(

W

T

Cov

(

S

k

w

)

W

)

=

Tr

(

B

T

Q

s

B

)

(12)

\sum^C_{k=1}\Psi_{\mathbf B\circ\phi}\left(\hat{\mathbb{P}}_{X \mid y_k}^{s}\right)=\sum^C_{k=1}\text{Tr}(\mathbf W^T\text{Cov}(\mathbf S^w_k)\mathbf W)\tag{12}\\ =\text{Tr}(\mathbf B^T\mathbf{Q}_s\mathbf B)

k=1∑C?ΨB°??(P^X∣yk?s?)=k=1∑C?Tr(WTCov(Skw?)W)=Tr(BTQs?B)(12)

P

s

=

∑

k

=

1

C

n

k

(

m

k

?

m

ˉ

)

(

m

k

?

m

ˉ

)

T

(13)

\mathbf{P}_s=\sum^C_{k=1}n_k(\mathbf m_k-\bar{\mathbf m})(\mathbf m_k-\bar{\mathbf m})^T\tag{13}

Ps?=k=1∑C?nk?(mk??mˉ)(mk??mˉ)T(13)

Q

s

=

∑

k

=

1

C

K

k

H

k

K

k

T

(14)

\mathbf{Q}_s=\sum^C_{k=1}\mathbf K_k\mathbf H_k\mathbf K_k^T\tag{14}

Qs?=k=1∑C?Kk?Hk?KkT?(14)

其中

m

k

=

1

n

k

∑

j

=

1

n

k

κ

(

?

,

x

j

k

)

,

m

ˉ

=

1

n

∑

j

=

1

n

κ

(

?

,

x

j

)

,

[

K

k

]

i

j

=

[

κ

(

x

i

k

,

x

j

k

)

]

\mathbf m_k=\frac{1}{n_k}\sum^{n_k}_{j=1}\kappa(\cdot,\mathbf x_{jk}),\bar{\mathbf m}=\frac{1}{n}\sum^{n}_{j=1}\kappa(\cdot,\mathbf x_{j}),[\mathbf K_k]_{ij}=[\kappa(\mathbf x_{ik},\mathbf x_{jk})]

mk?=nk?1?∑j=1nk??κ(?,xjk?),mˉ=n1?∑j=1n?κ(?,xj?),[Kk?]ij?=[κ(xik?,xjk?)]和中心矩阵

H

k

=

I

n

k

?

1

n

k

1

n

k

1

n

k

T

\mathbf H_k=\mathbf I_{n_k}-\frac{1}{n_k}\mathbf 1_{n_k}\mathbf 1_{n_k}^T

Hk?=Ink???nk?1?1nk??1nk?T?,其中

I

n

k

\mathbf I_{n_k}

Ink??表示

n

k

×

n

k

n_k\times n_k

nk?×nk?单位矩阵,

1

n

k

∈

R

n

k

\mathbf 1_{n_k}\in\mathbb R^{n_k}

1nk??∈Rnk?表示1的向量。

4.4算法

这里,我们通过合并上述四个量来制定SCA的学习算法。SCA的目标是通过解决以下表达式形式的优化问题来寻求一种表示

sup

?

{total?scatter}+{between-class?scatter}

{domain?scatter}+{within-class?scatter}

(15)

\sup\frac{\text{\{total scatter\}+\{between-class scatter\}}}{\text{\{domain scatter\}+\{within-class scatter\}}}\tag{15}

sup{domain?scatter}+{within-class?scatter}{total?scatter}+{between-class?scatter}?(15)

使用(5),(9),(11),和(12),可以更详细地指定上面的表达式:

arg?max

?

B

Ψ

B

°

?

(

P

̄

^

X

)

+

Ψ

B

(

{

μ

P

^

X

∣

y

k

l

}

k

=

1

C

)

Ψ

B

(

{

μ

P

^

X

d

}

d

=

1

m

)

+

∑

k

=

1

C

Ψ

B

°

?

(

P

^

X

∣

y

k

s

)

(16)

\argmax_{\mathbf B}\frac{\Psi_{\mathbf{B} \circ \phi}\left(\hat{\overline{\mathbb{P}}}_{X}\right)+\Psi_{\mathbf B}\left(\{\mu_{\hat{\mathbb P}^l_{X \mid y_k}}\}^C_{k=1}\right)}{\Psi_{\mathbf B}(\{\mu_{\hat{\mathbb P}^d_{X}}\}^m_{d=1})+\sum^C_{k=1}\Psi_{\mathbf B\circ\phi}\left(\hat{\mathbb{P}}_{X \mid y_k}^{s}\right)}\tag{16}

Bargmax?ΨB?({μP^Xd??}d=1m?)+∑k=1C?ΨB°??(P^X∣yk?s?)ΨB°??(P^X?)+ΨB?({μP^X∣yk?l??}k=1C?)?(16)

分子最大化可以鼓励SCA保持数据的总体可变性和类的可分离性。

最小化分母可以鼓励SCA找到源和目标域相似的表示形式,并且共享一个标签的源示例也相似。

目标函数。我们用三种方法重新构造(16)。首先,我们用线性代数来表示它。其次,我们插入超参数来控制散射之间的权衡,因为在特定情况下,一个散射量可能比其他散射量更重要。第三,我们施加

W

T

W

=

B

T

K

B

\mathbf W^T\mathbf W=\mathbf B^T\mathbf{KB}

WTW=BTKB很小的约束来控制解决方案的规模。

明确地,SCA找到一个投影矩阵

B

=

[

b

1

,

b

2

,

…

,

b

k

]

\mathbf B=[\mathbf b_1,\mathbf b_2,\dots,\mathbf b_k]

B=[b1?,b2?,…,bk?]解决了约束优化问题

arg?max

?

B

∈

R

n

×

k

Tr

(

B

T

(

1

?

β

n

K

K

+

β

P

)

B

)

Tr

(

B

T

(

δ

K

L

K

+

Q

+

K

)

B

)

(17)

\argmax_{\mathbf B\in\mathbb R^{n\times k}}\frac{\text{Tr}(\mathbf B^T(\frac{1-\beta}{n}\mathbf {KK}+\beta\mathbf P)\mathbf B)}{\text{Tr}(\mathbf B^T(\delta\mathbf {KLK}+\mathbf Q+\mathbf K)\mathbf B)}\tag{17}

B∈Rn×kargmax?Tr(BT(δKLK+Q+K)B)Tr(BT(n1?β?KK+βP)B)?(17)

其中

P

=

[

P

s

0

n

s

×

n

t

0

n

t

×

n

s

0

n

t

×

n

t

]

,

Q

=

[

Q

s

0

n

s

×

n

t

0

n

t

×

n

s

0

n

t

×

n

t

]

\mathbf{P}=\left[\begin{array}{cc} \mathbf{P}_{s} & \mathbf{0}_{n_{s} \times n_{t}} \\ \mathbf{0}_{n_{t} \times n_{s}} & \mathbf{0}_{n_{t} \times n_{t}} \end{array}\right], \mathbf{Q}=\left[\begin{array}{cc} \mathbf{Q}_{s} & \mathbf{0}_{n_{s} \times n_{t}} \\ \mathbf{0}_{n_{t} \times n_{s}} & \mathbf{0}_{n_{t} \times n_{t}} \end{array}\right]

P=[Ps?0nt?×ns???0ns?×nt??0nt?×nt???],Q=[Qs?0nt?×ns???0ns?×nt??0nt?×nt???]

和

β

,

δ

>

0

\beta,\delta>0

β,δ>0分别为控制总散点、类间散点和域散点的权衡参数。

注意,上述优化对于缩放

B

?

α

B

\mathbf B\mapsto \alpha \mathbf B

B?αB是不变的。因此,优化(17)可以改写为

arg?max

?

B

∈

R

n

×

k

Tr

(

B

T

(

1

?

β

n

K

K

+

β

P

)

B

)

s.t.?Tr

(

B

T

(

δ

K

L

K

+

Q

+

K

)

B

)

=

1

(18)

\argmax_{\mathbf B\in\mathbb R^{n\times k}}\text{Tr}\left(\mathbf B^T\left(\frac{1-\beta}{n}\mathbf {KK}+\beta\mathbf P\right)\mathbf B\right)\\ \text{s.t. Tr}(\mathbf B^T(\delta\mathbf {KLK}+\mathbf Q+\mathbf K)\mathbf B)=1\tag{18}

B∈Rn×kargmax?Tr(BT(n1?β?KK+βP)B)s.t.?Tr(BT(δKLK+Q+K)B)=1(18)

得到拉格朗日量

J

(

B

)

=

Tr

(

B

T

(

1

?

β

n

K

K

+

β

P

)

B

)

?

Tr

(

(

B

T

(

δ

K

L

K

+

Q

+

K

)

B

?

I

k

)

Λ

)

(19)

J(\mathbf B)=\text{Tr}\left(\mathbf B^T\left(\frac{1-\beta}{n}\mathbf {KK}+\beta\mathbf P\right)\mathbf B\right)\\ -\text{Tr}((\mathbf B^T(\delta\mathbf {KLK}+\mathbf Q+\mathbf K)\mathbf B-\mathbf I_k)\Lambda)\tag{19}

J(B)=Tr(BT(n1?β?KK+βP)B)?Tr((BT(δKLK+Q+K)B?Ik?)Λ)(19)

为求解(17),设一阶导数

?

J

(

B

)

?

B

=

0

\frac{\partial J(\mathbf B)}{\partial \mathbf B}=0

?B?J(B)?=0,导出广义特征问题

(

1

?

β

n

K

K

+

β

P

)

B

?

=

(

δ

K

L

K

+

Q

+

K

)

B

?

Λ

(20)

\left(\frac{1-\beta}{n}\mathbf {KK}+\beta\mathbf P\right)\mathbf B^*=(\delta\mathbf {KLK}+\mathbf Q+\mathbf K)\mathbf B^*\Lambda\tag{20}

(n1?β?KK+βP)B?=(δKLK+Q+K)B?Λ(20)

其中

Λ

=

diag

(

λ

1

,

…

,

λ

k

)

\Lambda=\text{diag}(\lambda_1,\dots,\lambda_k)

Λ=diag(λ1?,…,λk?)k是前导特征值,

B

=

[

b

1

,

…

,

b

k

]

\mathbf B=[\mathbf b_1,\dots,\mathbf b_k]

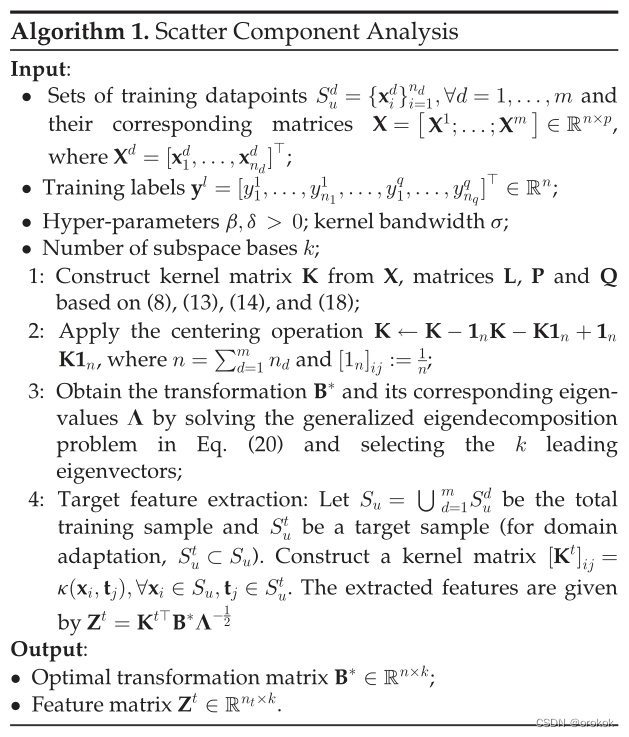

B=[b1?,…,bk?]包含相应的特征向量,算法1提供了SCA的完整摘要。

4.5与其他方法的关系

SCA与许多特性学习和领域适应方法密切相关。

通过(19)中的

β

=

δ

=

0

\beta=\delta=0

β=δ=0和

Q

=

0

\mathbf Q=0

Q=0的超参数恢复KPCA。设置

β

=

1

\beta=1

β=1和

δ

=

0

\delta=0

δ=0恢复KFD (Kernel Fisher Discriminant)方法[67]。

具有线性核的KFD等价于Fisher的线性判别法,这是[33]中提出的目标检测领域自适应方法的基础。

设置

β

=

0

\beta=0

β=0和

Q

=

0

\mathbf Q=0

Q=0(即忽略类分离),就产生了一种新的算法:与TCA密切相关的无监督散射成分分析(unsupervised Scatter Component Analysis, uSCA)。两种算法之间的区别是,TCA约束总方差和正则化变换,而uSCA权衡总方差和约束变换(回想一下,

W

T

W

\mathbf W^T\mathbf W

WTW应该很小)的动机是定理1。事实证明,uSCA在领域适配方面一贯优于TCA

从uSCA(17)中从分母中去掉

B

T

K

B

\mathbf B^T\mathbf{KB}

BTKB项,得到TCA[45]。TCA的半监督扩展SSTCA与SCA存在显著差异。SSTCA没有将类内和类间的分散合并到目标函数中,而是合并了一个派生自希尔伯特-施密特独立准则的项,该项最大限度地提高了标签上嵌入的依赖性。

在两个域[19]的情况下,uSCA本质上等价于无监督域不变成分分析(uDICA)。然而,对于SSTCA,受监督的DICA通过中心子空间的概念合并了与SCA不同的标签信息。特别是有监督的DICA要求所有的数据点都有标签,所以在我们的实验中不能应用。

4.6计算复杂度

计算矩阵K、L、P和Q需要

O

(

n

2

)

O(n^2)

O(n2)(算法1的第一行)。

因此,在解决特征分解问题(第2行)后,SCA的总复杂度为

O

(

k

n

2

)

O(kn^2)

O(kn2),或n的二次元。这种复杂度与KPCA和Transfer Component Analysis类似

与之前最先进的目标识别领域适应算法——转移联合匹配[15]相比,TJM采用交替特征分解过程,其中需要进行T迭代。使用我们的符号,TJM的复杂性是

O

(

T

k

n

2

)

O(Tkn^2)

O(Tkn2),

4.7超参数设置

在第4节中描述的SCA公式有四个超参数:

- 核的选择

- 子空间基数k

- 类间和总散射折衷 β \beta β

- 域散射 δ \delta δ

我们处理这个问题的策略是减少可调超参数的数量

对于内核的选择,我们选择了RBF内核

exp

(

?

∥

a

?

b

∥

2

σ

2

)

,

?

a

,

b

∈

X

\text{exp}(\frac{-\|\mathbf{a-b}\|^2}{\sigma^2}),\forall\mathbf{a,b}\in\mathcal X

exp(σ2?∥a?b∥2?),?a,b∈X其中核带宽

σ

\sigma

σ被解析地设置为以下聚合域中样本之间的中值距离

σ

=

median

?

(

∥

a

?

b

∥

2

2

)

,

?

a

,

b

∈

S

s

∪

S

t

(21)

\sigma=\operatorname{median}\left(\|\mathbf{a}-\mathbf{b}\|_{2}^{2}\right), \forall \mathbf{a}, \mathbf{b} \in S^{s} \cup S^{t}\tag{21}

σ=median(∥a?b∥22?),?a,b∈Ss∪St(21)

对于域适应,

δ

\delta

δ固定为1。因此,只有两个超参数是可调的:

k

k

k和

β

\beta

β。对于域泛化,

β

\beta

β设为1,即消除总的散点,

δ

\delta

δ被允许调优,可调超参数的数量保持不变。

该配置基于经验观察,设置

0

<

β

<

1

0 < \beta< 1

0<β<1并不比设置

β

=

1

\beta=1

β=1更好(如果不是更差的话),在域泛化案例的交叉验证和测试性能方面。在所有评估中,我们使用源标记数据进行5次交叉验证,以找到最优k和

β

\beta

β。我们发现,该策略足以为领域适应和泛化情况产生良好的SCA模型。

五、自适应性能分析

我们推导出一个域自适应界,显示了MMD在平方损失

l

(

y

,

y

′

)

=

(

y

?

y

′

)

2

l(y,y')=(y-y')^2

l(y,y′)=(y?y′)2情况下如何控制泛化性能。其主要思想是将MMD(即域散射)纳入差异距离[27]的适应界中。在[19]中根据域散射给出了域泛化的泛化界,见Remark 1。

让

Hyp

?

:

=

{

h

:

X

→

Y

}

\operatorname{Hyp}:=\{h:\mathcal X\rightarrow\mathcal Y\}

Hyp:={h:X→Y}表示从X到Y的一个假设函数类,其中X是一个紧集。给定一个定义在标签对上的损失函数

l

:

Y

×

Y

→

R

+

l:\mathcal Y\times \mathcal Y\rightarrow\mathbb R_+

l:Y×Y→R+?和分布

D

\mathbb D

D在

X

\mathcal X

X,设

L

D

(

h

,

h

′

)

=

E

x

~

D

[

?

(

h

(

x

)

,

h

′

(

x

)

)

]

\mathcal{L}_{\mathbb{D}}\left(h, h^{\prime}\right)=\mathbb{E}_{x \sim \mathbb{D}}[\ell(h(x),h'(x))]

LD?(h,h′)=Ex~D?[?(h(x),h′(x))]表示任意两个假设

h

,

h

′

∈

Hyp

?

h,h'\in\operatorname{Hyp}

h,h′∈Hyp的预期损失;我们考虑假设集

Hyp

?

\operatorname{Hyp}

Hyp是RKHS

H

\mathcal H

H的子集的情况。

我们首先引入差异距离,

disc

?

H

y

p

(

P

,

Q

)

\operatorname{disc}_{Hyp}(\mathbb{P,Q})

discHyp?(P,Q),它衡量两个分布

P

\mathbb P

P和

Q

\mathbb Q

Q之间的差异。

定义7(差异距离[27])。

设

Hyp

?

?

{

f

:

X

→

Y

}

\operatorname{Hyp}\subset\{f:\mathcal X\rightarrow\mathcal Y\}

Hyp?{f:X→Y}是一组函数,从X映射到Y。两个分布

P

\mathbb P

P和

Q

\mathbb Q

Q在

X

\mathcal X

X之间的差异距离定义为

disc

?

(

P

,

Q

)

=

sup

?

h

,

h

′

∈

Hyp

?

∣

L

P

(

h

,

h

′

)

?

L

Q

(

h

,

h

′

)

∣

(22)

\operatorname{disc}(\mathbb{P,Q})=\sup_{h,h'\in\operatorname{Hyp}}|\mathcal{L}_{\mathbb{P}}\left(h, h^{\prime}\right)-\mathcal{L}_{\mathbb{Q}}\left(h, h^{\prime}\right)|\tag{22}

disc(P,Q)=h,h′∈Hypsup?∣LP?(h,h′)?LQ?(h,h′)∣(22)

这个误差是对称的,满足三角形不等式,但它一般没有定义距离:

?

P

≠

Q

\exist\mathbb P\neq\mathbb Q

?P=Q有

disc

?

H

y

p

(

P

,

Q

)

=

0

\operatorname{disc}_{Hyp}(\mathbb{P,Q})=0

discHyp?(P,Q)=0

如果我们假设我们有一个通用的内核[69],[70],即

H

=

C

(

X

)

\mathcal H=C(\mathcal X)

H=C(X)作为拓扑空间,损耗

l

l

l是平方损耗[71],那么差异就是一个度量。通用核最重要的例子是高斯RBF核,它是下面实验中使用的核。

证明的主要步骤是找出域散度与误差距离之间的关系。我们可以在特殊情况下这样做,其中核是通用的,损失是均方误差。主要的技术挑战是差异距离在假设中是二次的(包括

h

(

x

)

2

和

h

(

x

)

h

′

(

x

)

h(x)^2和h(x)h'(x)

h(x)2和h(x)h′(x)的形式),而MMD是线性的。

定义8(乘法运算符)

设

C

(

X

)

C(\mathcal X)

C(X)为紧集X上具有上范数

∥

?

∥

∞

\|\cdot\|_{\infin}

∥?∥∞?的连续函数空间。给定

g

∈

C

(

X

)

g\in C(\mathcal X)

g∈C(X),定义乘法运算符为有界线性运算符

M

g

:

C

(

X

)

→

C

(

X

)

\mathbf M_g:C(\mathcal X)\rightarrow C(\mathcal X)

Mg?:C(X)→C(X)给出的

M

g

(

h

)

(

x

)

=

g

(

x

)

h

(

x

)

\mathbf M_g(h)(x)=g(x)h(x)

Mg?(h)(x)=g(x)h(x)

注意,一般的RKHS在乘法运算符下不是封闭的。然而,由于内核是通用的,因此

H

\mathcal H

H在乘法下是封闭的,因为连续函数

C

(

X

)

C(\mathcal X)

C(X)的空间在乘法下是封闭的。此外,我们还可以在

H

\mathcal H

H上定义范数

∥

?

∥

∞

\|\cdot\|_{\infin}

∥?∥∞?使用其识别

C

(

X

)

C(\mathcal X)

C(X)

引理4。

给定

g

,

h

∈

H

g,h\in\mathcal H

g,h∈H,其中

H

\mathcal H

H是配备了通用内核,它保持

∥

M

g

(

h

)

∥

H

=

∥

g

?

h

∥

H

≤

∥

g

∥

∞

?

∥

f

∥

H

\|\mathbf M_g(h)\|_{\mathcal H}=\|g\cdot h\|_{\mathcal H}\le\|g\|_{\infin}\cdot\|f\|_{\mathcal H}

∥Mg?(h)∥H?=∥g?h∥H?≤∥g∥∞??∥f∥H?

证明

简单的计算。引理需要一个通用核,因为

∥

g

?

h

∥

H

\|g\cdot h\|_{\mathcal H}

∥g?h∥H?仅在

g

?

h

∈

H

g\cdot h\in\mathcal H

g?h∈H。

我们现在展示了两个分布的域分散上界差异距离。

引理5(域散射边界差异)

设

H

\mathcal H

H是一个具有通用核的RKHS,假设的

l

(

y

,

y

′

)

=

(

y

?

y

′

)

2

l(y,y')=(y-y')^2

l(y,y′)=(y?y′)2是平方损失,考虑假设集

Hyp

?

=

{

f

∈

H

:

∥

f

∥

H

≤

1

和

∥

f

∥

∞

≤

r

}

\operatorname{Hyp}=\{f\in\mathcal H:\|f\|_{\mathcal H}\le 1和\|f\|_{\infin}\le r\}

Hyp={f∈H:∥f∥H?≤1和∥f∥∞?≤r}

其中

r

>

0

r>0

r>0是常数设

P

\mathbb P

P和

Q

\mathbb Q

Q是

X

\mathcal X

X上的两个域,那么下面的不等式成立:

disc

?

?

(

P

,

Q

)

?

discrepancy?

≤

8

r

Ψ

?

(

{

μ

P

,

μ

Q

}

)

?

domainscatter?

.

(23)

\underbrace{\operatorname{disc}_{\ell}(\mathbb{P}, \mathbb{Q})}_{\text {discrepancy }} \leq \underbrace{8 r \sqrt{\Psi_{\phi}\left(\left\{\mu_{\mathbb{P}}, \mu_{\mathbb{Q}}\right\}\right)}}_{\text {domainscatter }} .\tag{23}

discrepancy?

disc??(P,Q)??≤domainscatter?

8rΨ??({μP?,μQ?})???.(23)

引理5允许我们将域分散与[27]中证明的域适应的泛化界限联系起来。在说明边界之前,我们引入了Rademacher复杂度[59],它衡量了一类函数适合随机噪声的程度。该测度是界定经验损失和预期损失的基础

定义9 (Rademacher Complexity)

设G是一个从

X

×

Y

\mathcal X\times\mathcal Y

X×Y映射到

[

a

,

b

]

[a,b]

[a,b]的函数族,

S

=

(

z

1

,

…

,

z

n

)

∈

X

×

Y

S=(z_1,\dots,z_n)\in\mathcal X\times\mathcal Y

S=(z1?,…,zn?)∈X×Y样本大小为n。G相对于样本S的经验Rademacher复杂度为

?

^

S

(

G

)

=

E

σ

[

sup

?

g

∈

G

1

n

∑

i

=

1

n

σ

i

g

(

z

i

)

]

(24)

\hat{\Re}_{S}(G)=\underset{\sigma}{\mathbb{E}}\left[\sup _{g \in G} \frac{1}{n} \sum_{i=1}^{n} \sigma_{i} g\left(z_{i}\right)\right]\tag{24}

?^S?(G)=σE?[g∈Gsup?n1?i=1∑n?σi?g(zi?)](24)

其中

σ

=

(

σ

1

,

…

,

σ

n

)

T

\mathbf{\sigma}=(\sigma_1,\dots,\sigma_n)^T

σ=(σ1?,…,σn?)T为Rademacher变量,

σ

i

s

\sigma_is

σi?s独立的均匀随机变量在

{

?

1

,

+

1

}

\{-1,+1\}

{?1,+1}中取值。所有样本大小为n的Rademacher复杂度为

?

n

(

G

)

=

E

S

[

?

^

S

(

G

)

]

(25)

\Re_{n}(G)=\underset{S}{\mathbb{E}}[\hat{\Re}_{S}(G)]\tag{25}

?n?(G)=SE?[?^S?(G)](25)

我们现在有了所有的要素来根据领域分散来推导领域适应界限。

设

f

P

f_{\mathbb P}

fP?和

f

Q

f_{\mathbb Q}

fQ?分别为域

P

\mathbb P

P和

Q

\mathbb Q

Q上的真标记函数,

h

P

?

:

=

arg?min

?

h

∈

Hyp

L

P

(

h

,

f

P

)

h^*_{\mathbb P}:=\argmin_{h\in\text{Hyp}}\mathcal L_{\mathbb P}(h,f_{\mathbb P})

hP??:=argminh∈Hyp?LP?(h,fP?)和

h

Q

?

:

=

arg?min

?

h

∈

Hyp

L

Q

(

h

,

f

Q

)

h^*_{\mathbb Q}:=\argmin_{h\in\text{Hyp}}\mathcal L_{\mathbb Q}(h,f_{\mathbb Q})

hQ??:=argminh∈Hyp?LQ?(h,fQ?)成为最小化者。为了成功地进行域调整,我们将假设

L

P

(

f

P

,

f

Q

)

\mathcal L_{\mathbb P}(f_{\mathbb P},f_{\mathbb Q})

LP?(fP?,fQ?)很小。

定理6(域散射适应边界)。

设Hyp为从

X

\mathcal X

X映射到

R

\mathbb R

R的函数族,

S

X

P

=

(

x

1

t

,

…

,

x

n

s

t

)

~

P

S^{\mathbb P}_{\mathcal X}=(x^t_1,\dots,x^t_{n_s})\sim\mathbb P

SXP?=(x1t?,…,xns?t?)~P和

S

X

Q

=

(

x

1

t

,

…

,

x

n

t

t

)

~

Q

S^{\mathbb Q}_{\mathcal X}=(x^t_1,\dots,x^t_{n_t})\sim\mathbb Q

SXQ?=(x1t?,…,xnt?t?)~Q分别为源样本和目标样本。

对于任何假说

h

∈

Hyp

h\in\text{Hyp}

h∈Hyp,概率至少为

1

?

δ

1-\delta

1?δ,以下适应界限成立:

L

Q

(

h

,

f

Q

)

?

L

Q

(

h

Q

?

,

f

Q

)

?

regret?on?target?domain?

≤

L

P

^

(

h

,

h

P

?

)

?

empirical?loss?

+

2

q

R

^

S

X

P

(

H

y

p

)

?

Rademacher?complexity?

+

3

B

log

?

2

δ

2

n

t

?

O

(

1

/

?sample?size?

)

+

8

r

Ψ

?

(

{

μ

Q

,

μ

P

}

)

?

domain?scatter?

+

L

P

(

h

P

?

,

h

Q

?

)

?

deviation?of?optimal?solns?

(26)

\begin{aligned} &\overbrace{\mathcal{L}_{\mathbb{Q}}\left(h, f_{\mathbb{Q}}\right)-\mathcal{L}_{\mathbb{Q}}\left(h_{\mathbb{Q}}^{*}, f_{\mathbb{Q}}\right)}^{\text {regret on target domain }} \leq \overbrace{\mathcal{L}_{\hat{\mathbb{P}}}\left(h, h_{\mathbb{P}}^{*}\right)}^{\text {empirical loss }}+\overbrace{2 q \hat{\mathfrak{R}}_{S_{\mathcal{X}}^{\mathrm{P}}}(\mathrm{Hyp})}^{\text {Rademacher complexity }}\\ &+\underbrace{3 B \sqrt{\frac{\log \frac{2}{\delta}}{2 n_{t}}}}_{O(1 / \sqrt{\text { sample size })}}+\underbrace{8 r \sqrt{\Psi_{\phi}\left(\left\{\mu_{\mathbb{Q}}, \mu_{\mathbb{P}}\right\}\right)}}_{\text {domain scatter }}+\underbrace{\mathcal{L}_{\mathbb{P}}\left(h_{\mathbb{P}}^{*}, h_{\mathbb{Q}}^{*}\right)}_{\text {deviation of optimal solns }} \end{aligned}\tag{26}

?LQ?(h,fQ?)?LQ?(hQ??,fQ?)

?regret?on?target?domain??≤LP^?(h,hP??)

?empirical?loss??+2qR^SXP??(Hyp)

?Rademacher?complexity??+O(1/?sample?size?)?

3B2nt?logδ2?????+domain?scatter?

8rΨ??({μQ?,μP?})???+deviation?of?optimal?solns?

LP?(hP??,hQ??)???(26)

**证明。**固定

h

=

Hyp

h=\text{Hyp}

h=Hyp。由于平方损失是对称的,并且服从三角形不等式,[27]中的定理8(参见补充材料,可在线获得)暗示了这一点

L

Q

(

h

,

f

Q

)

?

L

Q

(

h

Q

?

,

f

Q

)

≤

L

P

(

h

,

h

P

?

)

+

disc

l

(

Q

,

P

)

+

L

P

(

h

P

?

,

h

Q

?

)

(27)

\mathcal{L}_{\mathbb{Q}}\left(h, f_{\mathbb{Q}}\right)-\mathcal{L}_{\mathbb{Q}}\left(h_{\mathbb{Q}}^{*}, f_{\mathbb{Q}}\right)\le \mathcal L_{\mathbb P}(h,h^*_{\mathbb P})+ \text{disc}_l(\mathbb Q,\mathbb P)\\ +\mathcal L_{\mathbb P}(h^*_{\mathbb P},h^*_{\mathbb Q})\tag{27}

LQ?(h,fQ?)?LQ?(hQ??,fQ?)≤LP?(h,hP??)+discl?(Q,P)+LP?(hP??,hQ??)(27)

将上述定理6与[27]中的定理9进行比较具有指导意义,[27]是扩展

disc

l

(

Q

,

P

)

\text{disc}_l(\mathbb Q,\mathbb P)

discl?(Q,P)在(27)的实证测量。用经验散射

Ψ

?

(

{

μ

P

^

,

μ

Q

^

}

)

\Psi_{\phi}(\{\mu_{\hat{\mathbb P}},\mu_{\hat{\mathbb Q}}\})

Ψ??({μP^?,μQ^??}),应用定理1。

定理6的意义有两方面。首先,强调了散射

Ψ

?

(

{

μ

P

,

μ

Q

}

)

\Psi_{\phi}(\{\mu_{\mathbb P},\mu_{\mathbb Q}\})

Ψ??({μP?,μQ?})控制了域适应的泛化性能。其次,该边界显示散射(也称为MMD)与[27]中提出的域适应理论之间的直接联系。请注意,这个界限可能对实际目的没有用处,因为它是松散和悲观的,因为它们适用于所有的假设和所有可能的数据分布。

六、实验一: 域适配

第一组实验评估了SCA在合成数据和真实物体识别任务上的域适应性能。合成数据旨在理解学习到的特征与其他算法相比的行为,而实际图像用于验证SCA的性能

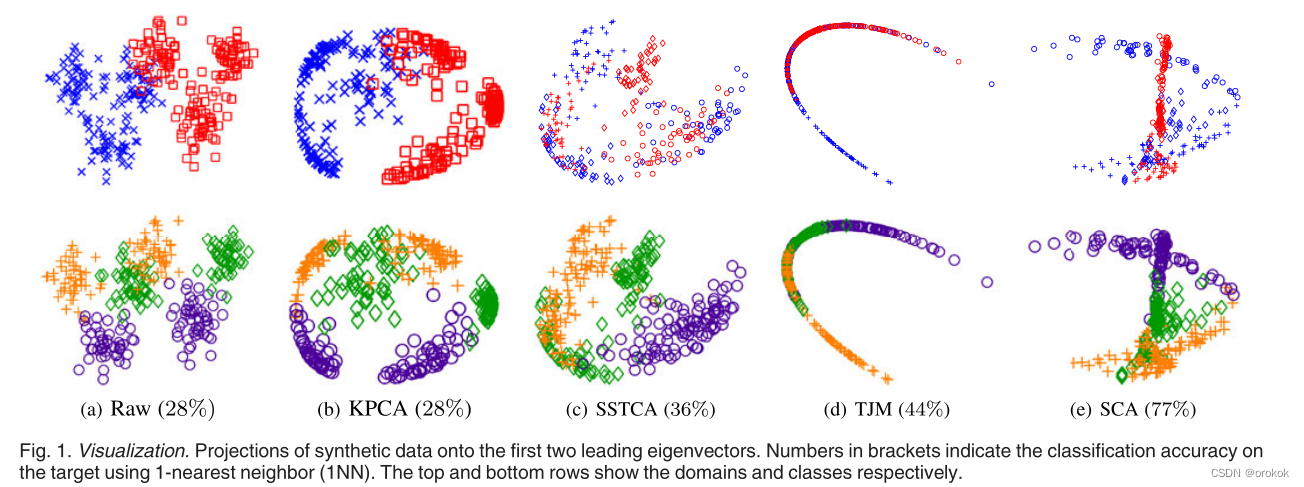

6.1合成数据

图1描绘了合成数据,它由三个类别下的六个聚类的二维数据点组成。每个聚类中的数据点都是由一个高斯分布

x

c

~

N

(

μ

c

,

σ

c

)

x^c\sim\mathcal N(\mu^c,\sigma^c)

xc~N(μc,σc),其中

μ

c

\mu^c

μc和

σ

c

\sigma^c

σc为第C聚类的均值和标准差。 所有算法都使用RBF内核

k

(

a

,

b

)

=

exp

?

(

?

∥

a

?

b

∥

2

2

σ

2

)

k(\mathbf{a,b})=\operatorname{exp}\left(-\frac{\|\mathbf{a-b}\|^2_2}{\sigma^2}\right)

k(a,b)=exp(?σ2∥a?b∥22??)

所有可调超参数均根据1-最近邻的测试精度进行选择。我们比较了核主成分分析(Kernel Principal Component Analysis)、半监督传输成分分析(Semi-Supervised Transfer Component Analysis, SSTCA)[45]、传输联合匹配[15]和SCA提取的特征。

6.2真实世界物体识别

我们总结了一系列跨域目标识别任务的完整域适应结果。利用了几个真实世界的图像数据集,如手写数字(MNIST[73]和USPS[74])和一般对象(MSRC [75], VOC2007 [6], Caltech-256 [76], Office[16])。

从这些数据集构建了三个跨域对:USPS+MNIST、MSRC+VOC2007和Office+Caltech

6.2.1数据设置

USPS+MNIST组合由手写数字数据集的下采样原始图像组成。

MSRC+VOC2007组合由240维图像组成,共享6个物体类别

Office+Caltech由10个类别的2,533张图片组成(每个域名每个类别8到151张图片)

6.2.2.基线和协议

我们比较了以下算法的分类性能:

- 基于原始特征的分类器(raw),

- KPCA

- 传输分量分析[45],

- SSTCA,

- 测地流核(GFK)[29],

- 传输稀疏编码[23]

- 子空间对齐[31]

- TJM[15]

- 无监督分散分量分析,

- SCA。

对于一个真实的设置,可调超参数通过5次交叉验证选择,仅根据源域的标签。

上述特征学习算法分别在三种不同的分类器上进行评价:

- 1-最近邻(1NN),

- 带线性核的支持向量机(L-SVM)[79],

- 域适应机器[36]。

6.2.3 1-最近邻分类精度

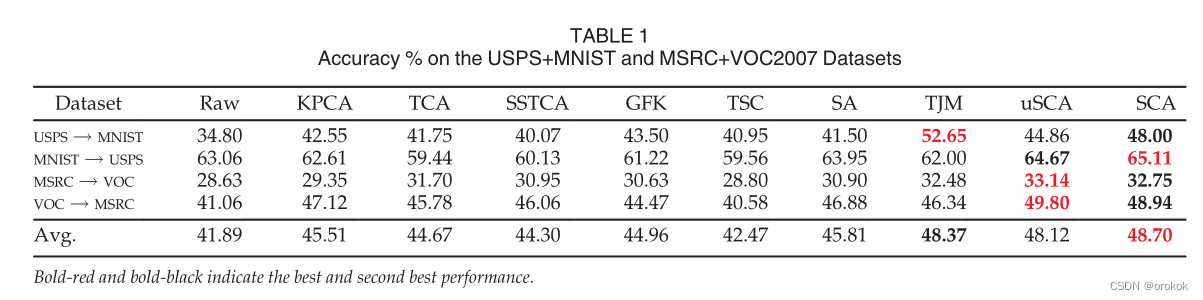

表1总结了USPS +MNIST和MSRC+VOC2007对的分类精度。

令人惊讶的是,SSTCA在培训期间也合并了标签信息,但没有表现出竞争力。

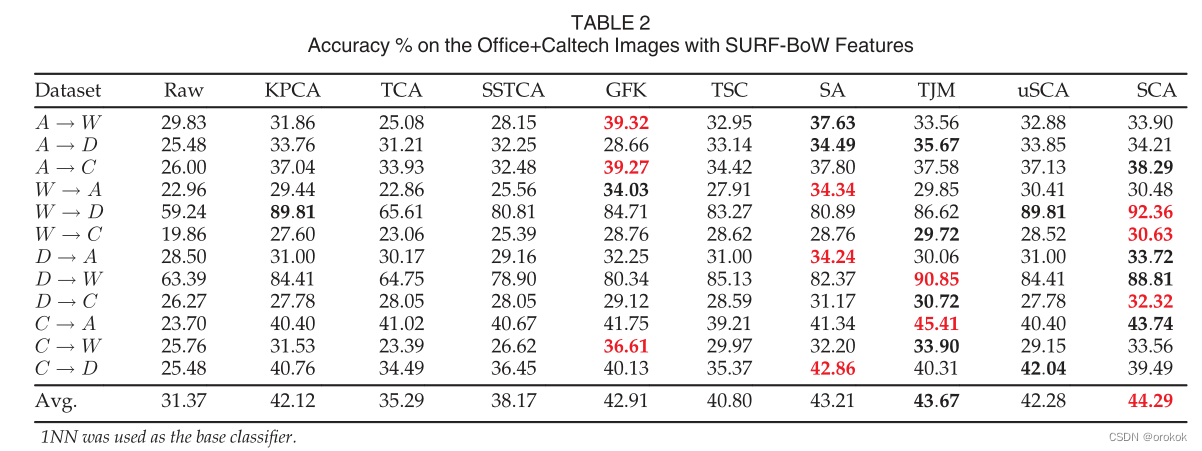

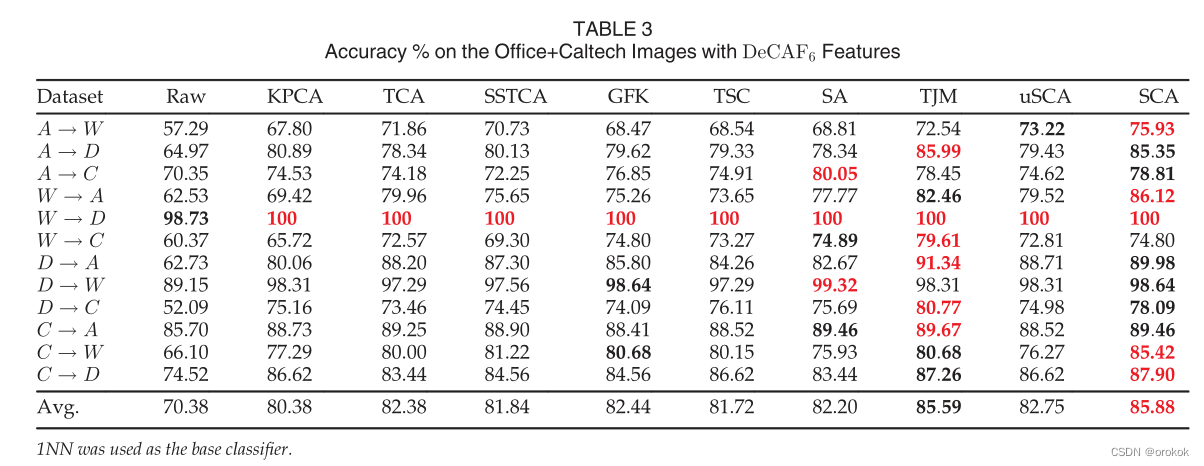

Office+Caltech对的结果汇总在表2 (SURF-BoW)和表3 (DeCAF6)中。

用于产生上述所有结果的算法的超参数仅使用源域的标签进行了调优。这是无监督域适应设置的唯一有效的调优协议。尽管如此,在文献中建立的一些最好的结果是使用目标标签上的超参数调整获得的。

用于产生上述所有结果的算法的超参数仅使用源域的标签进行了调优。这是无监督域适应设置的唯一有效的调优协议。尽管如此,在文献中建立的一些最好的结果是使用目标标签上的超参数调整获得的。

6.2.4.L-SVM和DAM的分类精度

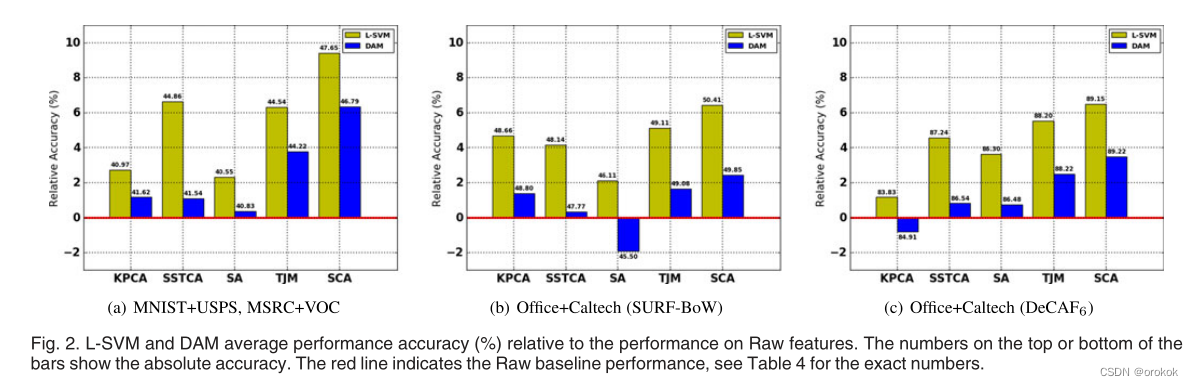

为了简洁起见,我们比较了图2所示的五种算法:KPCA、SSTCA、SA、TJM和SCA的性能。

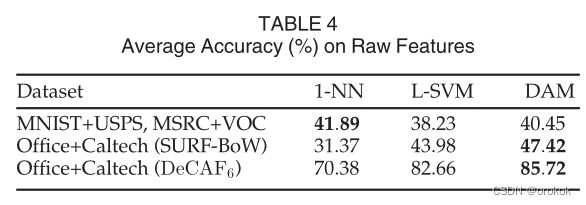

表4总结了Raw特性的绝对准确性。

从表4可以看出,DAM在Raw特性上的表现优于L-SVM。令人惊讶的是,当使用特征学习算法时,情况并非总是如此。此外,L-SVM总是产生更高的性能增益相对于原始特征。这可能是由于过拟合,因为DAM比L-SVM有更多的超参数。也就是说,将DAM与特征学习算法相结合使整个过程变得复杂——回想超参数的选择是基于对源数据的验证。

6.2.5运行时性能

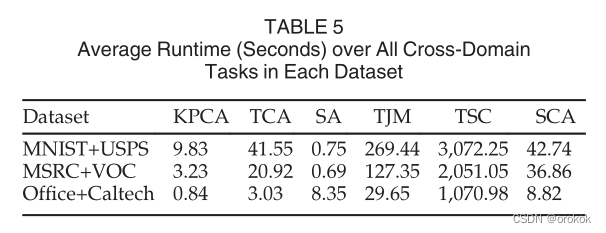

表5比较了SCA与其他一些算法:KPCA、TCA、SA、TSC和TJM在MNIST+USPS、MSRC+VOC和Office+Caltech(与DeCAF6)上的平均运行时性能。

七、实验二:领域泛化

我们在三个跨域数据集上评估了我们的算法:VLCS、Office+Caltech和IXMAS [80]

7.1数据设置

第一个跨域数据集,我们称之为VLCS,由PASCAL VOC2007 (V)[6]、LabelMe (L)[81]、Caltech-101 ?[76]和SUN09 (S)[82]数据集的图像组成,每个数据集代表一个域。

第二个跨域数据集是Office+Caltech数据集

第三个数据集是IXMAS数据集

7.2基线和协议

我们将我们的算法与以下基线进行了比较:

- 1NN: 1-最近邻分类器。

- L-SVM:带线性核的SVM分类器。

- 核主成分分析。

- Undo-Bias[21]:一种多任务svm消除数据集偏差的算法。

- UML[20]:一个基于结构化度量学习的算法,旨在为分类任务学习一个更少偏差的距离度量。

- DICA[19]:一种用于域泛化的核特征提取方法。

- LRE-SVM[22]:采用核范数正则化来施加低秩似然矩阵的非线性范例- svm模型。

我们使用最近邻作为所有基于特征学习的算法的基分类器:KPCA、DICA、uSCA/ uDICA和SCA。根据源域的标签选择可调超参数。

对于所有基于核的方法,核函数为RBF核,

k

(

a

,

b

)

=

exp

?

(

?

∥

a

?

b

∥

2

2

σ

2

)

k(\mathbf{a,b})=\operatorname{exp}\left(-\frac{\|\mathbf{a-b}\|^2_2}{\sigma^2}\right)

k(a,b)=exp(?σ2∥a?b∥22??),通过中值启发式计算内核带宽

σ

\sigma

σ。注意,在这种情况下,无监督的DICA几乎与uSCA相同。唯一的区别是uSCA对于域分散/分布方差项有一个控制参数

δ

>

0

\delta>0

δ>0。

7.3VLCS数据集上的结果

在这个数据集上,我们首先使用1-最近邻进行标准的训练测试评估

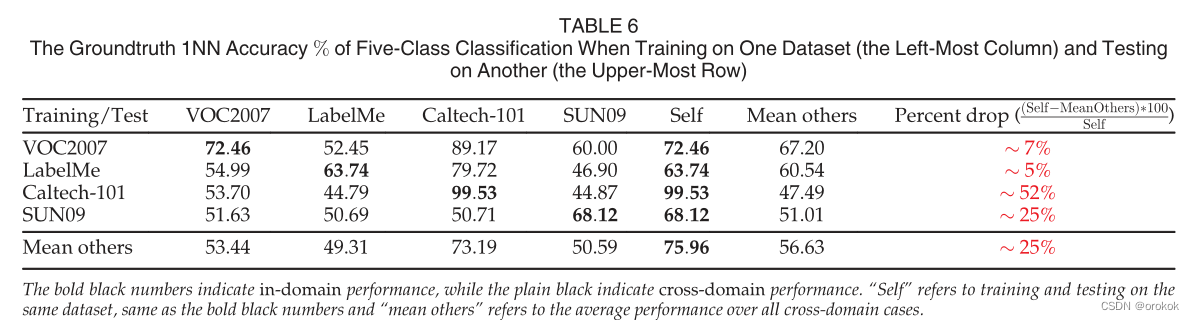

groundtruth评价结果如表6所示。

总的来说,尽管使用了最先进的深度卷积神经网络特征

D

e

C

A

F

6

DeCAF_6

DeCAF6?,但数据集确实存在偏差

然后,我们在7个跨域识别任务中评估了域泛化性能。完整结果汇总于表7。

7.4Office+加州理工学院数据集上的结果

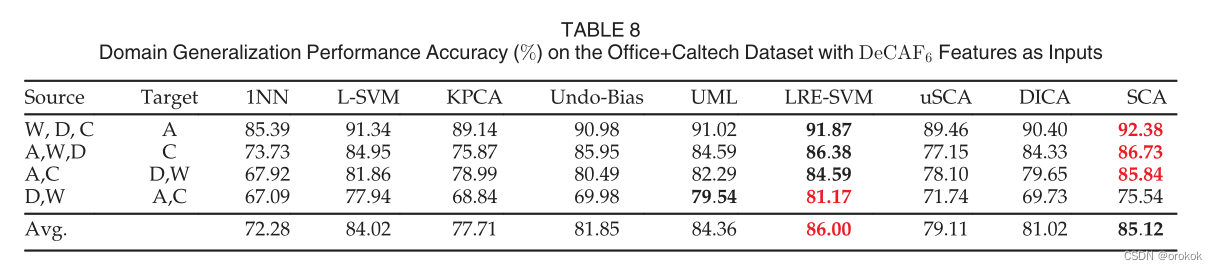

我们在Office+Caltech数据集构建的几个跨领域案例上评估了我们的算法。表8报告了4例

D

e

C

A

F

6

DeCAF_6

DeCAF6?患者的详细评价结果。

这表明,在特征学习过程中结合源域的标记信息确实可以改善Office+Caltech案例中的域泛化。

7.5IXMAS数据集上的结果

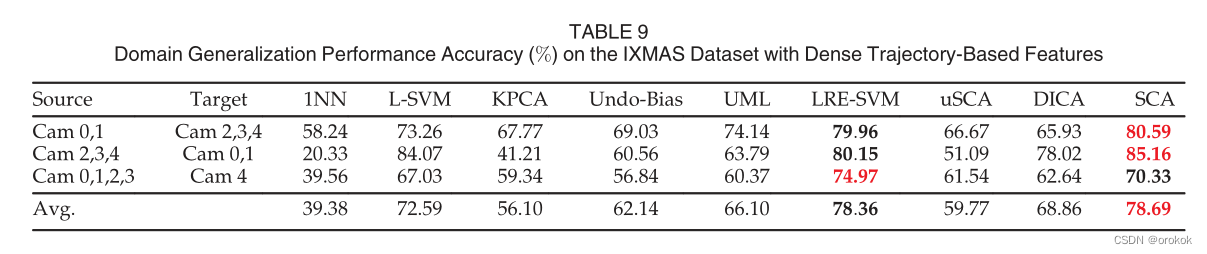

表9总结了在三个跨域案例中IXMAS数据集上的分类准确性。

7.6运行时性能

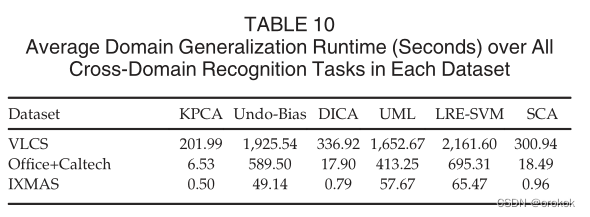

从表10中,我们可以看到SCA的运行时与KPCA和DICA相当,这是意料之中的,因为它们利用了相同的优化过程:使用广义特征值分解进行一次运行。

八、总结

基于散射的目标函数是对域适应和域泛化问题的相关结构进行编码的一种直接方法。

SCA使用数据子集之间的差异来构建一个线性转换,该转换减弱(标签内和域之间)不重要的差异,并放大有用的差异(标签之间和总体可变性)。

我们的理论分析表明,具有两个输入域的散射,即域散射,为域适应提供了泛化边界

SCA是Kernel PCA、Kernel Fisher Discriminant和TCA的自然扩展。相反,许多域适应方法使用目标函数,将总方差和MMD与本质上不同的量相结合,如图拉普拉斯算子[23]、稀疏性约束[15]、[23]、希尔伯特-施密特独立准则[45]或中心子空间[19]

通过将目标标签合并到类分散中,SCA可以很容易地扩展为半监督域适应。最后,我们指出,使用随机特性应该可以加速SCA处理大规模问题[84]。

因此,开发更基本的特征学习算法是至关重要的,它可以在广泛的情况下显著减少数据集偏差

Reference

Scatter Component Analysis: A Unified Framework for Domain Adaptation and Domain Generalization