MaskSplit: Self-supervised Meta-learning for Few-shot Semantic Segmentation

WACV 2022|paper|github|bilibili

一句话总结:首先使用显著性评估提取伪背景掩膜,再用掩膜分割分别创建支持集和查询集对,解决了自监督小样本语义分割缺少标签和掩膜所以难以确定其类别,以致于无法构建相同类别的支持集和查询集对的问题,首次注重自监督在FSS领域的应用问题

核心思想一是缺少样本就通过图像增强创造图像,二是在增强的基础上使用一分为二的掩膜分割方法构造支持和查询对

准备知识:

- 自监督训练:Dtrain仅由未标记的图像组成,没有遮罩或类标签

- 增强和掩膜分割

- 伪掩膜

一、用了什么方法解决了什么问题

- can neither provide support samples with class-specific masks, Dtrain缺少掩膜和标签

use unsupervised saliency to define pseudo groundtruth masks,使用调整的SimCLR - nor sample support and query image pairs from Dtrain such that the support and query images are known to belong to the same class. 难以构建相同类别的支持集和查询集对

create support and query pairs from each individual image, by adapting contemporary self-supervised representation learning practices and leveraging the spatial nature of the segmentation task.

Vsplit、Hsplit and MixedSplit

目的是形成彼此之间足够显着的支持和查询对

二、模型解析

- 在增强阶段

调整了Unsupervised semantic segmentation by contrasting object mask proposals中使用的显著性掩膜评估方法 --> 使用DeepUSPS方法在MSRA数据集上训练无监督显着性模型,然后使用显着性估计从头开始训练BAS-NET模型 - MaskSplit

灵感来源:单个对象的不同部分在视觉上有很大的不同。

随机将一侧视为支持前台掩码,另一侧视为查询前景掩码 - 网络结构

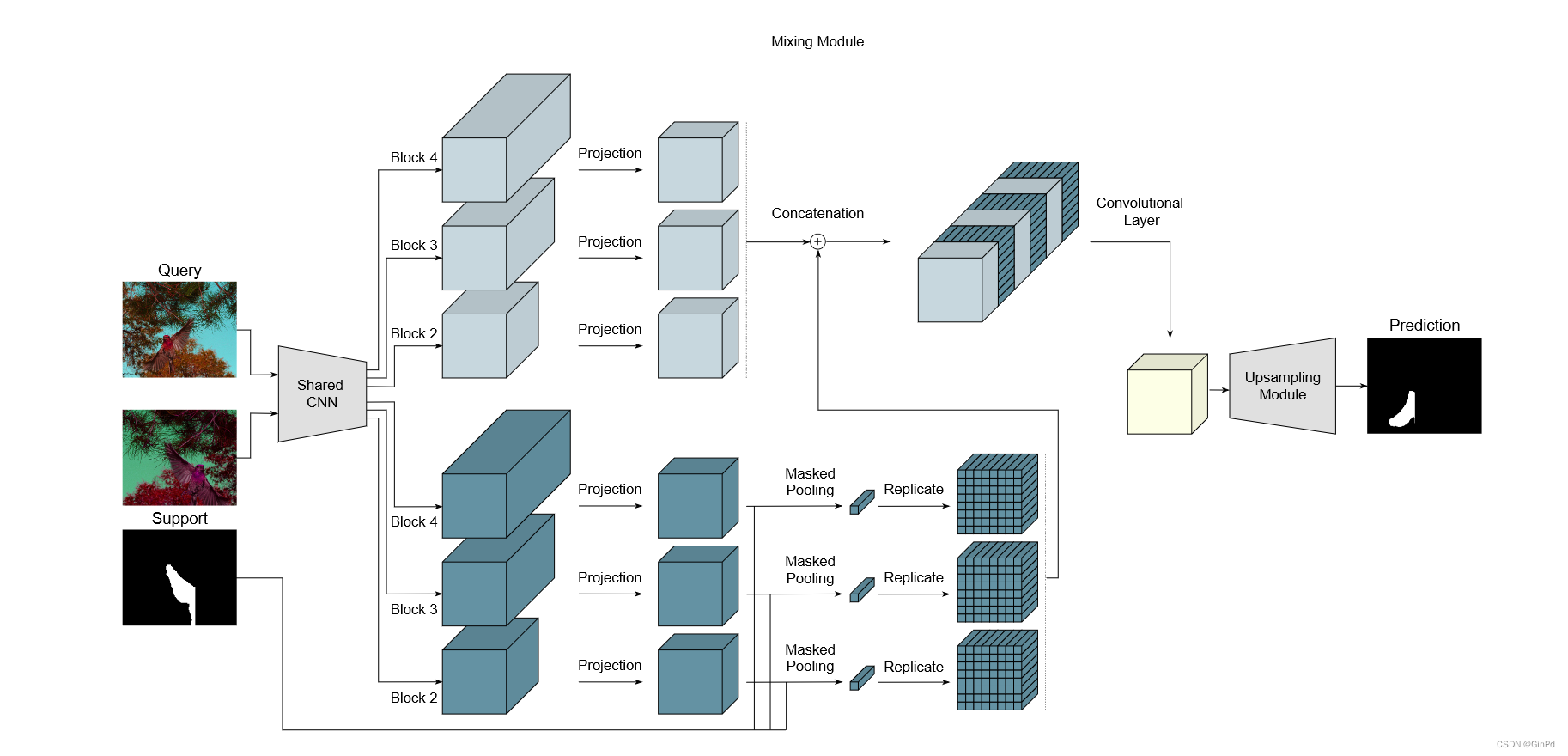

- 从查询和支持图像中提取特征的骨干网络

Backbone使用ResNet-101,它有4个主块,这些块由几个卷积层组成。为了保持空间分辨率,使用膨胀卷积而不是块2之后的跨步卷积,以便块2之后的所有特征映射的固定大小为原始图像的1/8。使用在ImageNet数据集上预先训练的主干模型。 - 将支持和查询特征混合在一起的混合模块

使用基于模型的架构 - 使用混合特征预测分割掩码的上采样网络

- 从查询和支持图像中提取特征的骨干网络

三、实验效果

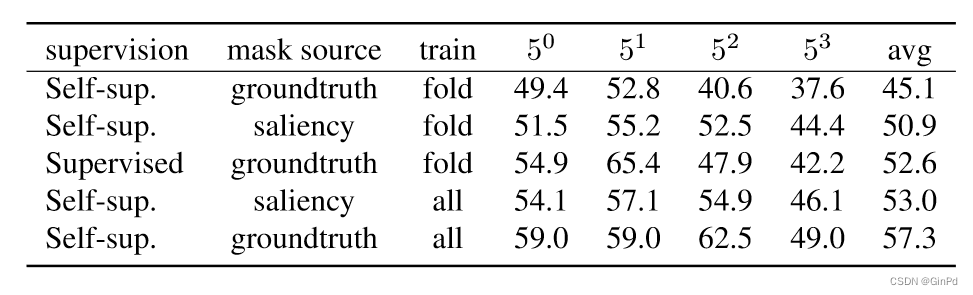

- Parallel|mIoU|PASKAL

- 与受监督对比

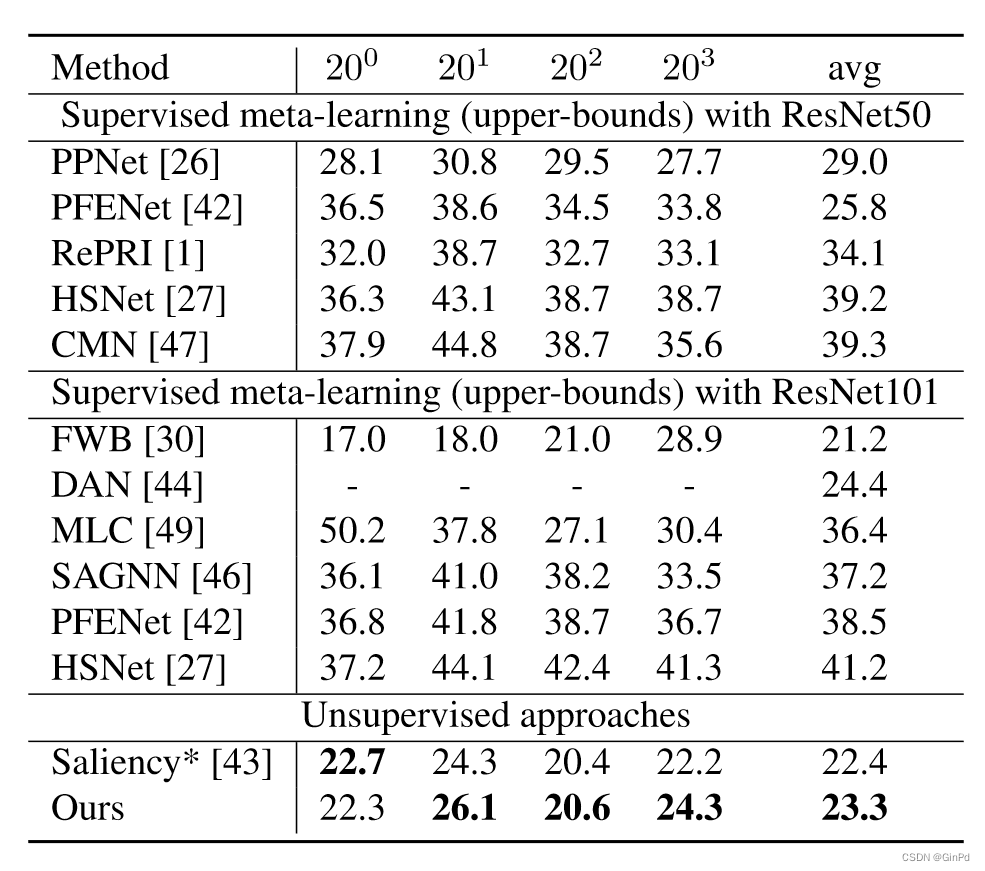

- Longitudinal|mIoU|COCO

在这里插入代码片

四、有何贡献或创新

- first work that addresses unsupervised few-shot segmentation problem on natural images.

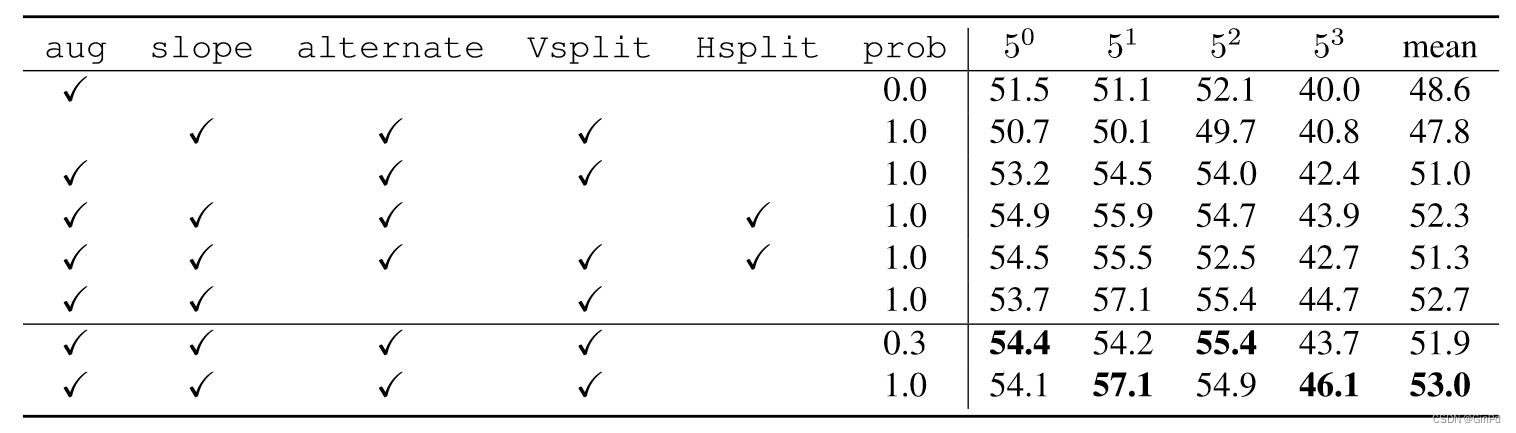

- 证明了增强对于创建视觉上不同的查询和支持示例是必要的,并且在自我监督学习过程中包含不同的增强可以显着增强训练

- 移除斜率选项会导致 mIoU 下降 2 个点,这意味着斜率提高了在情节中创建各种片段的可能性

- 应用增强可能会使分割的两侧在每一集中都足够不同。因此,双方之间不交替似乎不会产生重大影响