文章目录

前言

初学者往往对人工智能的认识不够广泛,往往就集中于深度学习这一块,在学习一段时间后再回头重新学习导论,用高屋建瓴的视角俯瞰自己曾经学习的领域,对以后的研究方向有很大的好处。

人工智能概览

人工智能的概念

严格来说,要给人工智能下定义不是一件容易的事情,毕竟人类自己都没有认清自己的智慧,所以人工智能更多的是各种假说,没有统一的严格定义。

人工智能能做什么

人工智能并非无所不能,事实上,从最开始人们通用人工智能的宏图伟业开始,人们不断受到打击,最终将注意力集中于模式识别上。模式识别专注于一个特定的任务,比如图像识别等。

从小到大来说,人工智能可以完成如下任务:

- 感知。深度学习有一个巨大的领域就是CV,计算机视觉有三大顶会,CVPR,ICCV,ECCV。另一个领域就是NLP,自然语言处理,也同样有顶会ACL。

- 行动。行动其实也可以理解为决策。

- 推理。推理是一种高级的智慧,现在没有任何一种人工智能能够实现真正的推理,尤其是因果推理。

- 通用任务。这一点是一个质变,也是现在人们着力解决的

- 真正的学习能力。

- 社会性。

- 创造力。

现在的人工智能还很笨,随着未来不断研究至创造力,人工智能就真的和人一样了。说实话,我感觉达到推理和通用任务的地步就行了,否则我真的怀疑人类是否会被人工智能推翻。

强人工智能与弱人工智能

说实话,现在的人工智能识别个猫猫狗狗都费劲,很明显都是弱人工智能。

图灵设计了图灵机架构,是当之无愧的计算机之父。而图灵奖也是当今计算机最高奖项,类比于诺贝尔奖,菲尔兹奖。

关于强人工智能的定义,图灵给出一个假设,如果通过了图灵测试,那么计算机就可以被认为是具有人类智能。

这种观点,注重人工智能的实用性,只要表现得和人一样就行,不需要管背后是否由推理逻辑支持。

由此,中文房间的观点被提出,如果房间里的智能体对知识并没有理解,只不过通过各种资料进行key:value的比对做出响应,那并不是真正的智能,即使是和人表现一样。这就像一个只会背答案的考生,虽然他把所有答案背会了,每次都能100分,但是他没有学会知识。

这种观点更关注智能的内核:逻辑推理。

两种观点我觉得不冲突吧,并没有争议,只是注重的点不同,人们最先实现的肯定是图灵智能,之后发展的更好才能实现中文房间级别的智能。

人工智能方法论

模拟层面

本质上,人工智能就是用人工制造的智能体去模拟实际的智能。

那模拟的方面就有很多:

- 神经层面。用生物的方法去真正地模拟神经元。

- 神经模型层面。将神经元模型简化为数学模型,从而构建神经网络。现在最流行的深度学习就是使用 σ ( w T x + b ) \sigma(w^Tx+b) σ(wTx+b)这种线性模型+激活函数的简化思路,更复杂的有脉冲神经网络的LIF模型,对神经元的模拟程度更高。

- 认知层面。这一层面对人的思考过程进行假设,抽象,和符号主义联系较大。

- 行为层面。这一层面只要保证智能体表现出像人一样的行为即可。

- 目标层面。这一层面只要能完成任务就好,什么方法都可以用,比如最优化,线性规划之类的非人方法。

三大理念

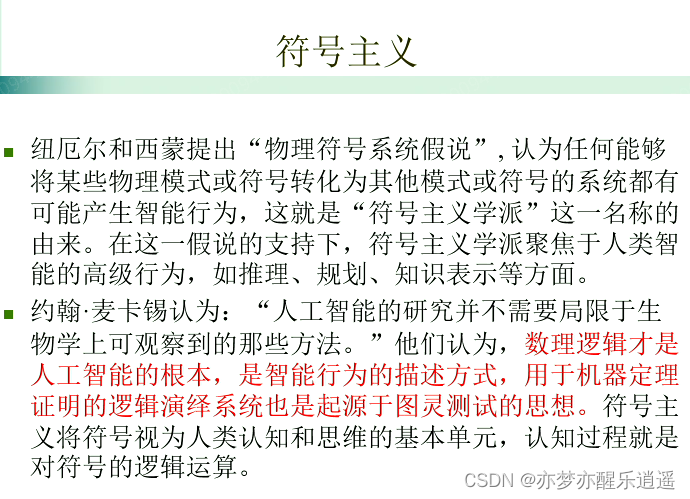

符号主义

用符号表达式表达知识,并且通过符号实现推理,认知。

符号主义认为,将物理模式或者符号转化为其他模式或者符号,这样的系统就有可能产生智能。

符号主义是最开始人们的理念,也是一个非常宏观的理念,后来发现走不通,于是开始走神经网络,现在神经网络这块又块走到头了,于是就又把视线投向了符号主义,其中脉冲神经网络也和符号主义有比较大的关系。

连结主义

现在主流的深度学习就是连结主义。

关键在于,节点模型,连接模型,训练算法。

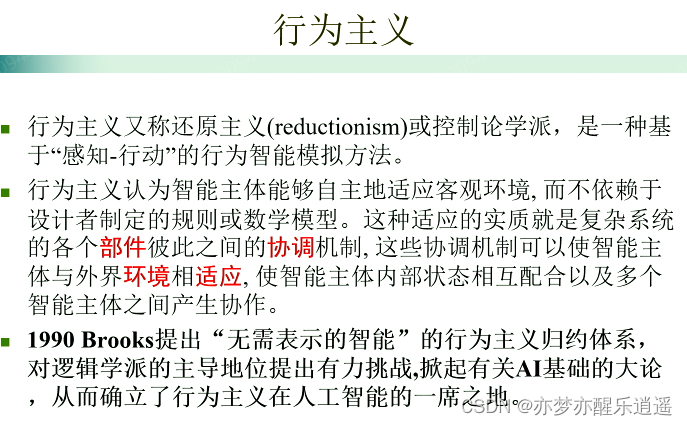

行为主义

行为主义发源于控制论,强化学习就是行为主义的体现。

行为主义着重于行为,智能体做出行为,影响环境,智能体收到反馈,调整状态,进行下一步行动。如此将经验积累下来,构成最终的智能体。

在维基百科中是这样介绍强化学习的:强化学习(RL)作为机器学习的一个子领域,其灵感来源于心理学中的行为主义理论,即智能体如何在环境给予的奖励或惩罚的刺激下(即与环境的交互中),逐步形成对刺激的预期,产生能获得最大利益的习惯性行为。它强调如何基于环境而行动,以取得最大化的预期利益。通俗的讲:就是根据环境学习一套策略,能够最大化期望奖励。由于它具有普适性而被很多领域进行研究,例如自动驾驶,博弈论、控制论、运筹学、信息论、仿真优化、多主体系统学习、群体智能、统计学以及遗传算法。

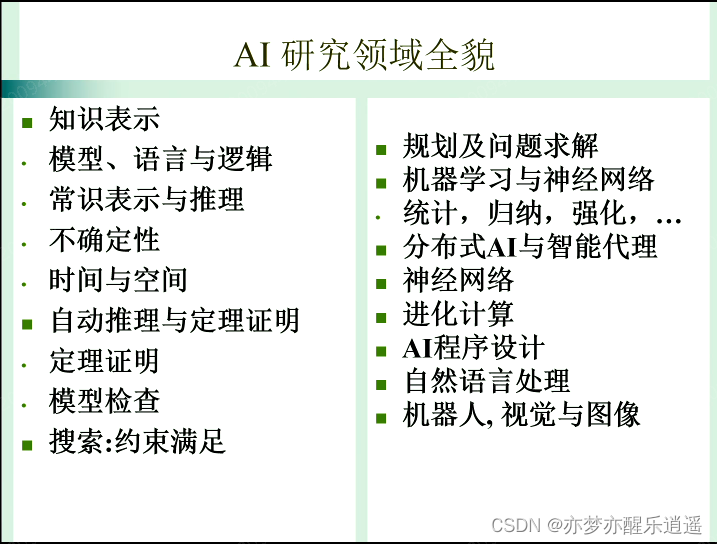

AI研究领域全貌

这个图稍微有点老,现在有很多新东西了。

人工智能主要理念浅析

Learning(学习)

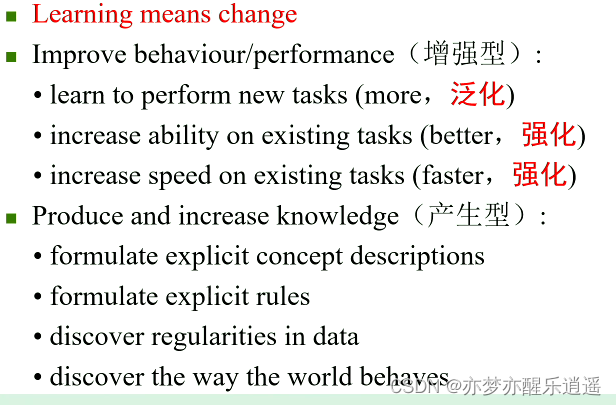

学习意味着变化。虽然这句话听起来像废话,但是至少说明了学习是一种积累的过程,而非直接灌输。

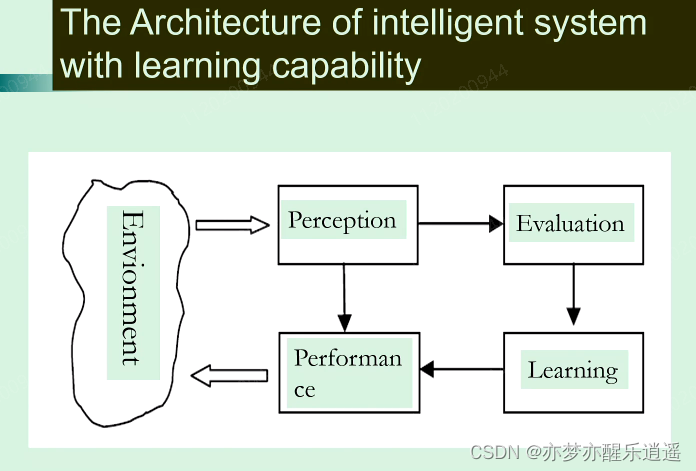

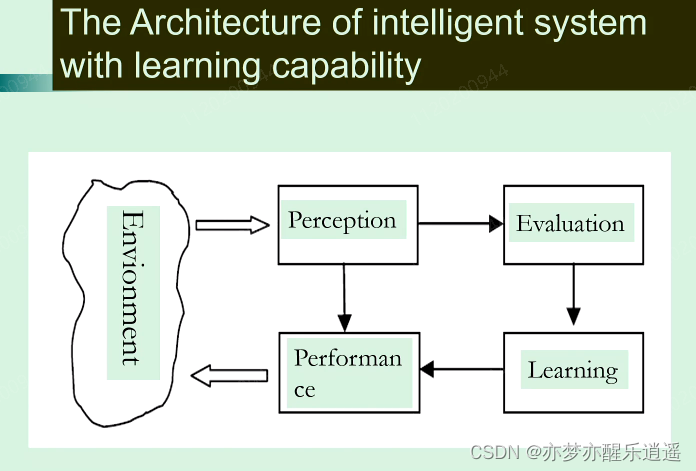

这张图并不全面,实际上只是强化学习的学习流程,而深度学习之类的梯度下降学习和这个还是有很大差别的。

学习还可以分成几个方面:

- 学习更多的任务

- 把已经学会的任务变得更好(比如提高准确率)

- 加速已有任务

之后就是产生,这个可以理解为创造。

学习还可以分为监督学习,非监督学习,半监督学习,强化学习。

监督学习其实是合理的,因为平时我们学东西也是有老师的,但是这样的代价比较大,能取得好的效果也是应该的。

非监督学习更多的是自发寻找分类,自发进行聚类,本质上,就是我即使不知道你是什么,但是我明白你们和他们并不一样,只需要能认识到区别,那就可以聚类。

半监督学习是折中。半监督学习采用大量的低成本的无标签数据+少量高成本标签数据,先用标签数据训练模型,再用模型在无标签数据上跑,其中必然有把握大的数据( P → 1 P\rightarrow 1 P→1),把这些无标签数据放到标签数据中,然后用新的标签数据训练新的模型,如此循环,直到无标签数据消耗完毕,标注+训练的任务就都完成了。

强化学习的经典过程如下图。

评估机器学习的效果,涉及到过拟合欠拟合,偏差,方差,鲁棒性,可解释性,计算复杂度(训练成本)。

连结主义

发展模型:

- M-P模型

- 感知机

- Hopfield Model,B-P学习方法

- 深度学习(Jeoffrey Hinton)

现在深度学习是连结主义最流行的方法,核心的主题有两个:

- 拓扑。这个可以理解为网络模型

- 算法。这个可以理解为建立在网络之上的训练算法

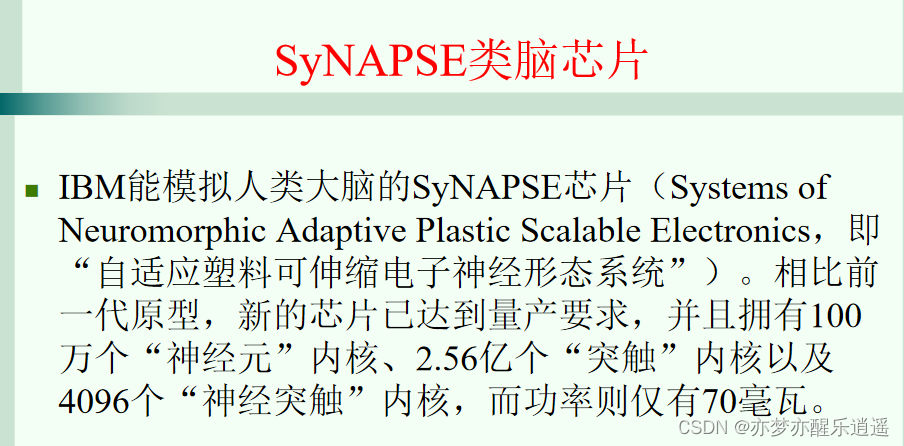

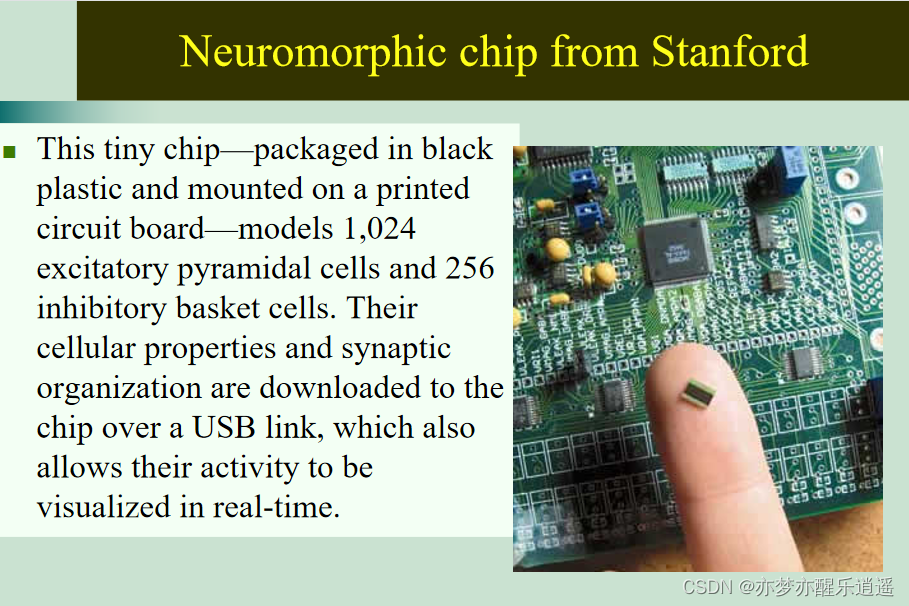

我研究的领域是以脉冲神经网络为代表的类脑智能。类脑智能的前景我觉得还是不错的,是一个很有意思的领域,其最佳的运行平台是类脑芯片。

符号主义AI

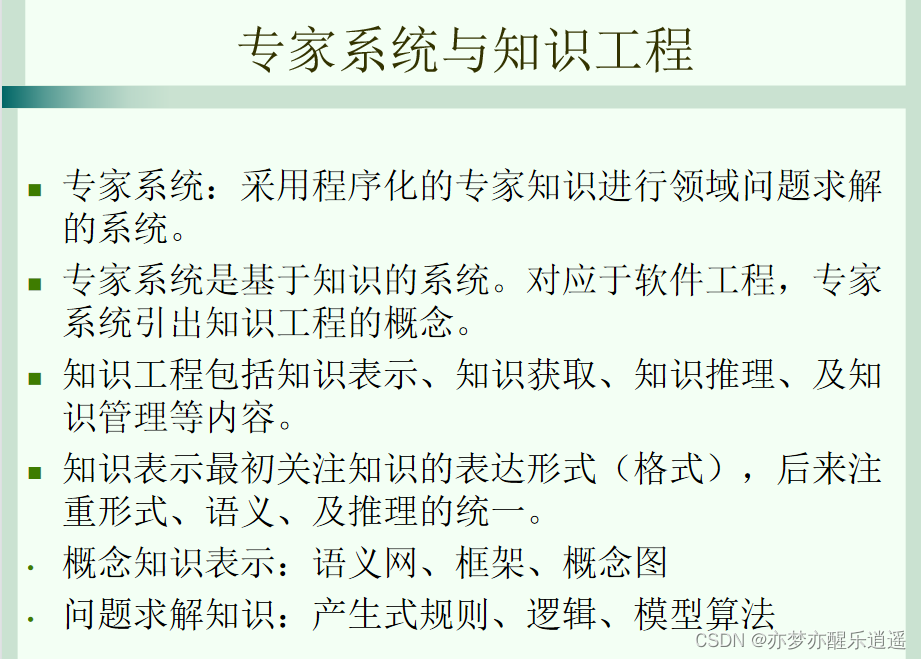

符号主义是人工智能最初的主流,大家刚开始的志向是很远大的,直接干通用人工智能。后来发现干不动。

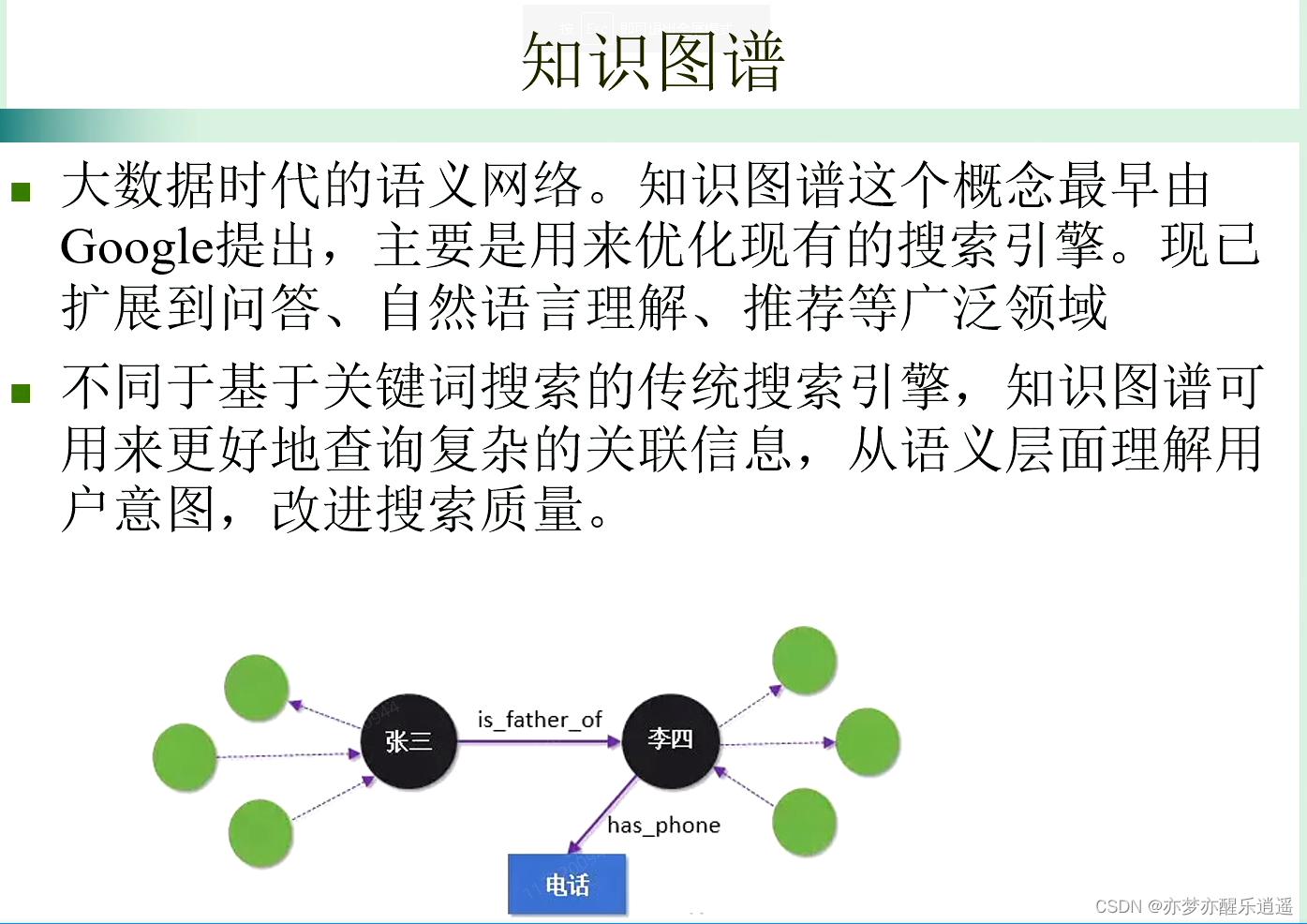

符号主义最开始是特定问题解决,之后发展专家系统,然后是知识工程,最后就是常识。

进化计算

进化计算的思路来源于达尔文进化论,最优化中的遗传算法就是这种思路。