论文地址:https://arxiv.org/abs/1505.04597

论文概要

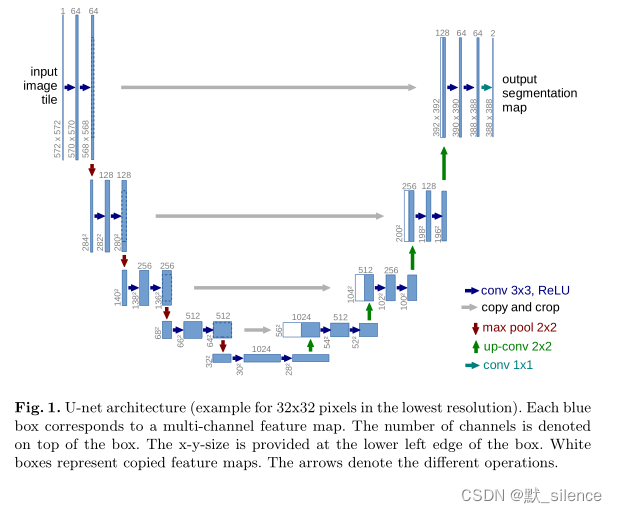

展示了一种网络结构:包括一条收缩路径(用于特征提取)和一条对称的扩展路径(用于获取精确的像素定位)。

这种网络只需要很少的图像进行训练,并在 ISBI 分割挑战上超过了先前最好的方法。而且运行速度很快,在单显卡上分割一张512*512大小的图像仅需不到一秒。

1、介绍

分类是卷积神经网络的经典用途,其输出的结果是单一的类别标签。然而在生物医学图像处理中,输出应该包含每个像素的定位(即每个像素是属于什么类别)。

这时出现了一种滑动窗口的网络训练方法,使用每个像素周围的patch来作为输入进行训练。

优点:

1、可以定位

2、训练数据从patch的角度来说大于训练图像

缺点:

1、速度慢。网络需要分开训练每个patch,并且patch有很多重叠的部分。

2、有在定位正确率和背景使用上的权衡。大的patch需要更多的池化层,降低了定位准确率,小的patch只使用了很少的背景信息。

所以在本文中,我们又引入了一个更加优雅的结构:全卷积网络(fully convolutional network,没有全连接层)。本文作者在FCN基础上进行修改和扩展,就得到了u-net。

2、网络结构

包含一个收缩路径和一个扩展路径。

收缩路径类似于典型的卷积网络结构,包括两个3*3的无填充卷积和一个2*2的最大池化层。池化层作为下采样,在每次下采样中将特征通道数变为之前的2倍。

扩展路径包括一个2*2的上采样和两个3*3的卷积。上采样每次将特征通道数变为之前的1/2,并与收缩路径相应裁剪好的特征图进行拼接。

最后一层是一个1*1的卷积层,将64个特征向量映射为类别个数。

3、训练

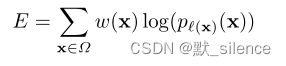

使用到了一个 energy function,形式类似于交叉熵损失函数

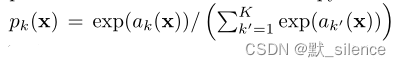

使用 softmax 来计算第 k 类的最大似然函数

p

k

(

x

)

p_k(x)

pk?(x)

上面的

α

k

(

x

)

α_k(x)

αk?(x) 表示在第 k 个特征通道的激活值

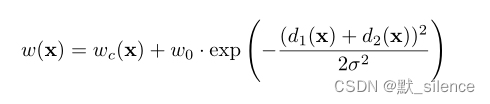

w w w 表示一张权重图,说明哪些像素点在训练中更加重要

对于 w ( x ) w(x) w(x) 的计算:

d

1

d_1

d1? 表示距离最近的细胞边界的距离,

d

2

d_2

d2? 表示距离第二近的细胞边界的距离

一个好的权重初始值是很重要的。对于我们的网络结构,初始权重可以从一个标准差为 2 / N \sqrt{2/N} 2/N? 的高斯分布获得。

N N N 表示一个神经元的输入节点数

3.1、数据增强

当数据较少时,数据增强在增强网络的不变性和鲁棒性上很重要。对于显微镜图像来说,主要需要平移、旋转的不变性、对于变形和灰度变换的鲁棒性。

可以用在3*3网格上的随机替换向量来生成形变,替换值可以在一个标准差为10像素的高斯分布中抽取。每个像素的替代是使用双三次插值法计算的

在收缩层最后的drop-out层进一步进行数据的增强

4、实验

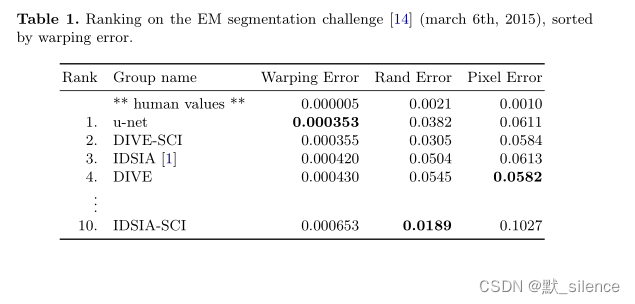

u-net对于电子显微镜下神经元结构的分割效果:

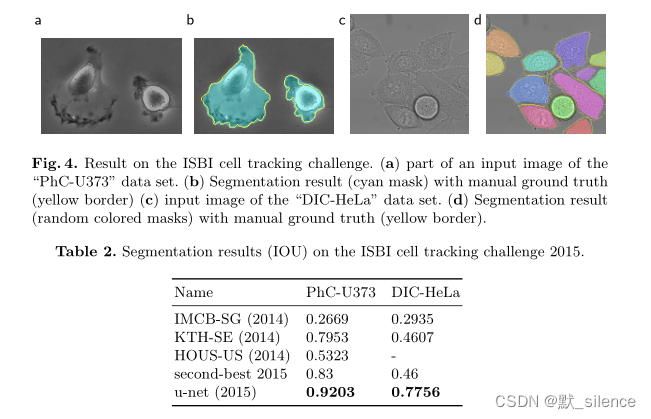

在光学显微镜下细胞的分割效果(IOU用来表示两个物体的重合度):

5、结论

u-net结构在不同的生物医学图像分割中获得了非常好的表现。由于数据的增强,它仅需较少的标注图像,并且有可以接受的训练时间。

个人总结

1、上采样和下采样的作用?

下采样用于缩小图像。上采样用于放大图像,主要有转置卷积、插值法。

在本论文中,卷积和下采样作为一个编码器,用于提取特征。卷积和上采样作为一个解码器,用于放大图像,从而对每个像素进行定位。

2、在网络中拼接的作用?

在进行下采样的过程中会丢失一些细节信息,可以拼接对应的图像来填补信息的缺失

参考资料

在阅读论文过程中,查阅了如下文章:

U-Net原理分析与代码解读:https://zhuanlan.zhihu.com/p/150579454?utm_id=0

上采样和下采样:https://blog.csdn.net/ytusdc/article/details/121452878

深度学习论文精读[2]:UNet网络:https://blog.csdn.net/weixin_37737254/article/details/125923940

Unet论文详解:https://blog.csdn.net/weixin_36474809/article/details/87931260