LSTM模型

1.什么是LSTM

LSTM全名叫做Long short-term memory,翻译过来就是长短期记忆

2.与RNN有什么区别:

严谨的描述:

- 1.RNN模型的结构中激活函数只有tanh;

- 2.LSTM模型的结构中加了输入门、遗忘门、输出门并引入sigmoid函数并结合tanh函数,添加求和操作,减少梯度消失和梯度爆炸的可能性。

大白话:

用笔记本记录自己大学四年的生活:

- RNN:从大一入学开始到大四毕业中每一分钟做的事情都会帮你记录下来,事无巨细,当工作几年后回忆大二的歌唱比赛,去翻笔记本时,由于记录的事情太多,不知道该从哪里翻起

- LSTM:会帮你记录比较重要的事情,而不重要的事情都不会被记录在上,当工作几年后回忆大二的歌唱比赛,只需要翻到大二的那一页便知道大二发生了哪些比较重要的事情

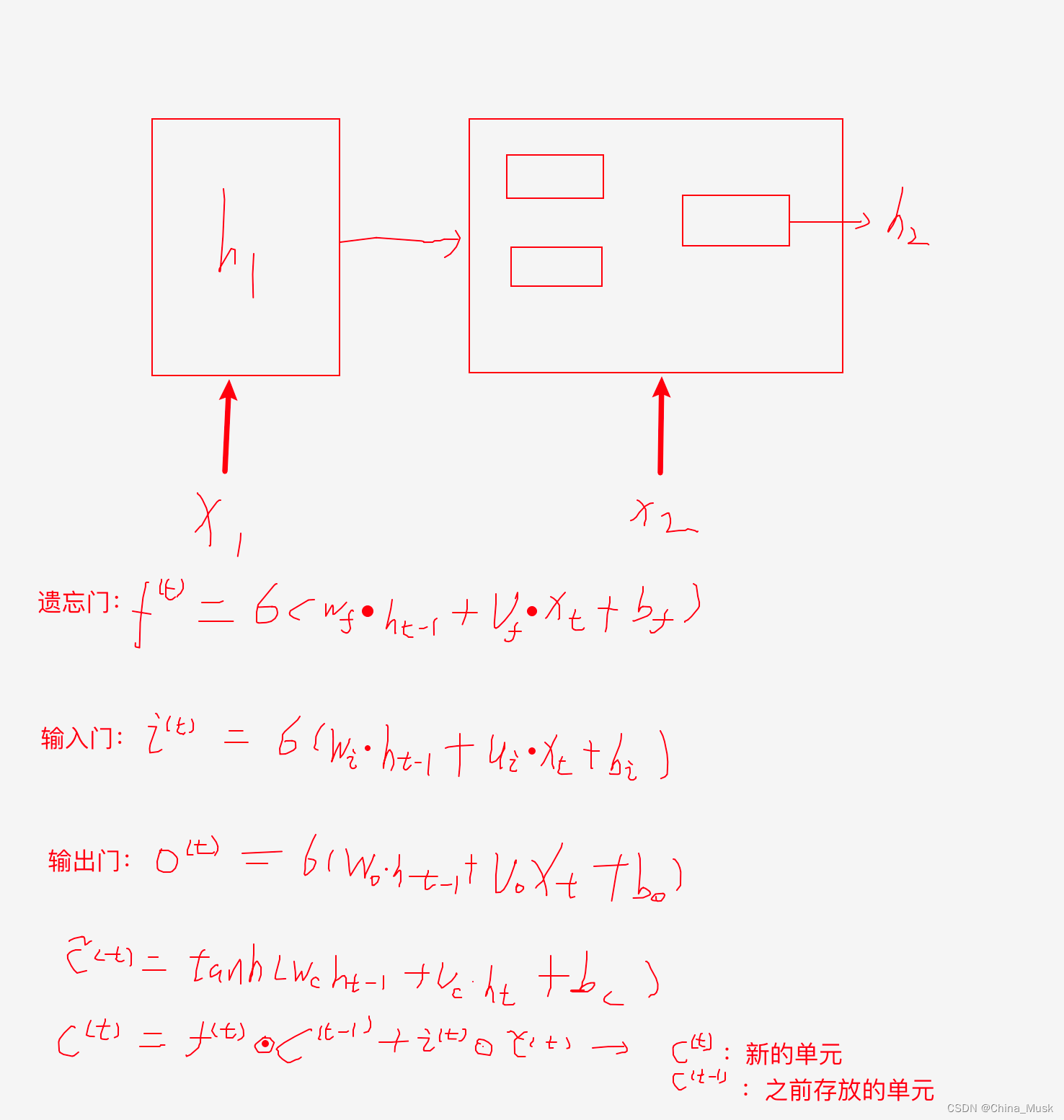

3.LSTM的结构:

通过LSTM的结构我来为大家解释LSTM是如果做到“留下x%旧的信息,保留x%的新信息”

首先我们看“遗忘门”是如何“遗忘”的:

σ

(

x

)

=

1

1

+

e

?

x

\sigma{(x)} = \frac{1}{1+e^{-x}}

σ(x)=1+e?x1?

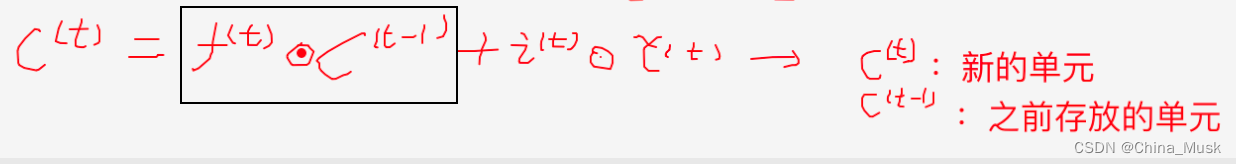

在逻辑回归中我们接触过这个函数,它的值域是(0,1)这说明一个问题,当我们得到的信息越不重要遗忘门就越近于0,当遗忘门越接近于0的时候画黑框这一项是不是也就越接近于0

那么这不就实现了“遗忘”。同样输入门和输出门也是同样的道理来决定保留多少新的信息,以及融合多少旧的信息和新的信息;

4.总结:

1.我将论文中核心部分放在了这里,如果需要看其他的部分,大家可以看一下这篇论文https://colah.github.io/posts/2015-08-Understanding-LSTMs/

2.RNN和LSTM是一对兄弟,即LSTM是特殊的RNN,而LSTM只是缓解了RNN存在的梯度爆炸或者梯度消失的问题,并没有完全解决