背景:尽管最近的自监督对比知识实现了最佳性能,但强迫网络学习这些知识可能会损害原始类识别任务的表示学习。

方法简介:1、采用另一种自监督增强任务来引导网络学习原始识别任务和自监督辅助任务的联合分布。它被证明是一种更丰富的知识,可以在不损失正常分类能力的情况下提高表示能力。

? ? ? ? ? ?2、以前的方法仅在最终层之间传递概率知识是不完整的。该方法将几个辅助分类器附加到分层的中间特征映射中,以生成不同的自监督知识,并执行一对一传递,以彻底地教授学生网络。

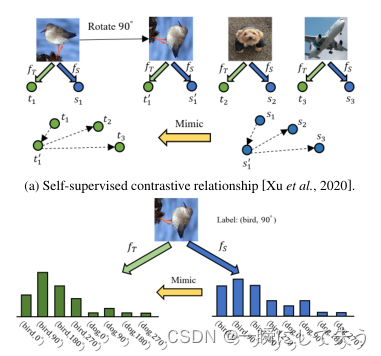

SSKD和HSAKD之间的自监督知识的差异:

(a) SSKD通过强制图像及其变换版本在特征嵌入空间中与其他负面图像闭合来应用对比学习。它将对比关系定义为知识。

(b) HSAKD将原始任务和自监督辅助任务统一为联合任务,并将自监督增广分布定义为知识。?

?1、模型方法

1.1自监督增广分布

使用CNN的常规分类网络,给出了原始类概率分布和自监督增广分布之间的差异。

a、CNN可以分解为特征提取器

和线性分类器

,其中μ和

是权重张量。

b、给定输入样本

,

是训练集,

是提取的特征嵌入向量,其中d是嵌入大小。

c、考虑一个卷积N类对象分类任务,其中标签空间N={1,···,N}。

d、带有softmax归一化的线性分类器将特征嵌入z映射到预测类概率分布

,其中σ是softmax函数,权重矩阵

,

是衡量分布平滑度的温度超参数。

创新:引入了一个额外的自监督任务来扩展传统的监督对象类空间。学习这种联合分布可以迫使网络生成更多信息和有意义的预测,同时受益于原始和辅助自监督任务。

假设我们用标签空间

定义M个不同的图像变换

,其中

表示同一变换,即

。

为了有效学习复合知识,将类空间从原来的监督对象识别任务和自监督任务变成了一个统一的任务。此任务的标签空间为K=N? M、 这里? 是笛卡尔积|K |=N? M,?其中|·|是标签集合的基数,*表示元素相乘。

a、给定一个变换样本

,通过在x上应用一个变换,

是提取的特征嵌入向量。

b、

?是联合标签空间K上的预测分布,其中权重张量

。使用

表示正态类概率分布,

表示自监督增广分布。

1.2辅助架构设计

? ? ? 具有各种分辨率的特征图编码各种模式的代表性信息。高分辨率特征映射通常呈现更细粒度的对象细节,而低分辨率特征映射则通常包含更丰富的全局语义信息。为了充分利用封装在单个网络中的分层特征映射,将多个中间辅助分类器添加到隐藏层中,以学习和提取分层自监督增强知识。

将传统分类网络表示为f(·),它映射输入样本

,j∈ M的普通类概率分布

。CNN通常利用阶段卷积块来随着网络深度的增加逐渐提取更粗糙的特征。

例子:用于ImageNet分类的流行ResNet-50包含连续的四个阶段,从不同阶段生成的提取特征图具有不同的粒度和模式。假设网络包含L个阶段,选择在每个阶段后附加一个辅助分类器,从而得到L个分类器

,其中

是第

阶段后的辅助分类器。

由逐级卷积块、全局平均池层和完全连接层组成。特征提取第

阶段后的特征图作为

,可以获得由

推断的自监督增广分布作为

。下图显示出了三级网络上辅助分类器的总体设计。

?

2、网络训练?

2.1教师网络训练

将教师骨干网络表示为

,将L个辅助分类器表示为

。为准备教师网络进行端到端训练过程。

一方面:通过常规的交叉熵(CE)损失来训练正常数据x的

,以拟合真实标签

?和

预测类概率分布。

另一方面:训练L个辅助分类器

,用于学习分层自监督增广分布。给定一个输入样本

,分别将从主干

生成的特征映射

馈送到

。由第

个分类器

推断的预测自监督增强分布是

使用CE损失训练所有辅助分类器,其中

上的自监督增强标签如下所示:

其中

,

表示交叉熵损失。使用

表示联合类空间K中

的自监督增强标签。训练教师的总体损失如下所示:

第一种损失:简单地拟合正常数据,以学习一般分类能力。

第二个损失:通过从主干网络派生的现有层次特征生成额外的自我监督增强知识。

这种方法有助于从自监督任务中提取比传统的完全监督任务更丰富的知识。

2.2学生网络训练

将学生骨干网络表示为

,将L个辅助分类器表示为

。在教师网络的监督下进行端到端训练过程。

总体损失包括来自预定义的真实标签的任务损失和来自预训练的教师网络的模仿损失。

2.2.1任务损失

强制

拟合正常数据x作为任务损失:

是预测类概率分布。还尝试强制L个辅助分类器

学习自监督增广分布。

对原始任务和自我监督任务的联合硬标签分配作为额外损失:

?和

是从

的第

阶段为输入

提取的特征图。

2.2.2模仿损失

一方面:将从教师网络的L个辅助分类器生成的分层自监督增强分布分别转移到学生网络的相应L个辅助分类。传输通过KL散度损失

以一对一的方式进行:

可以预期学生网络通过统一的自监督知识和原始班级全监督知识获得全面指导。信息性知识来自封装在高容量教师网络的隐藏层中的多尺度中间特征图。

另一方面:在教师和学生之间传递从最后一层生成的原始类概率分布。具体地说,我们传递从正常数据和变换数据

得出的知识,其中

。该损失公式:

没有明确强制学生主干

在任务丢失时拟合转换数据,以保持正常分类能力。但模仿从教师网络的这些转换数据中推断出的预测类概率分布的副产品也有利于学生网络的自我监督表征学习。

2.2.3总体损失

我们将任务损失和模仿损失总结为训练学生网络的总体损失

:

3、总结?

1、提出了一种用于KD的自监督增强任务,并利用设计良好的辅助分类器进一步传递从分层特征图中获得的丰富知识。

2、在KD领域的标准图像分类基准上实现了SOTA性能。它可以指导网络学习语义识别任务的一般特征表示。