目录

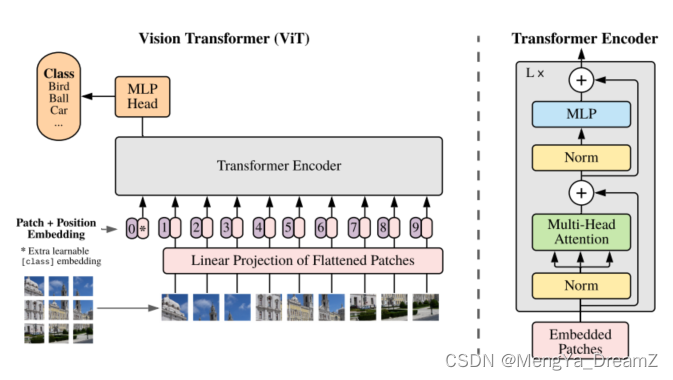

How the Vision Transformer processes image data ?

操作过程:

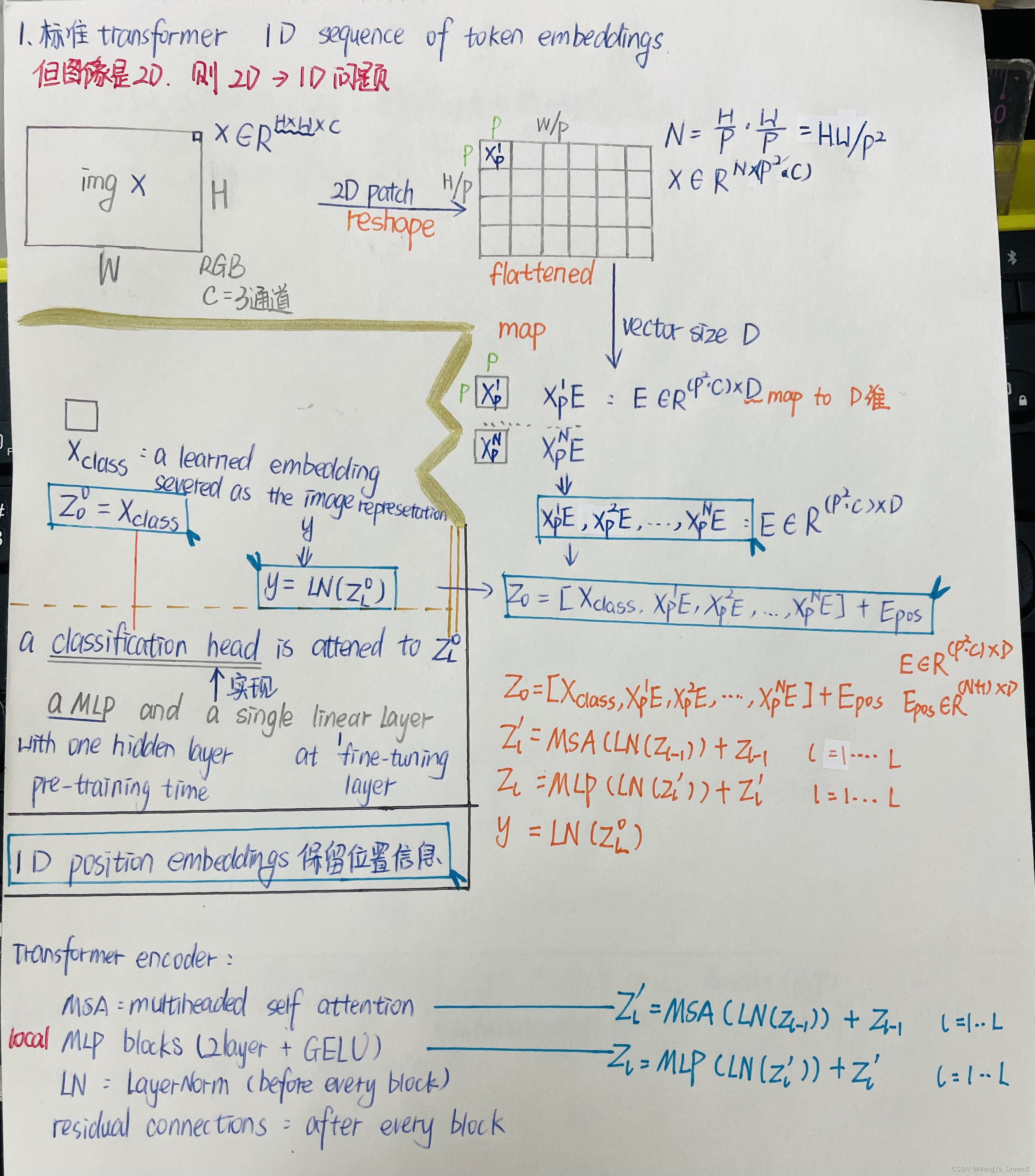

看似烂熟于心,实际还是有所偏差,这里丑放一张手稿,主要对应公式的由来。

- 图像由2D-1D到符合Transformer的输入,经历了reshape-flatted-map/proj-D维

- 分类作用class token,放在0位

- 位置编码1D position embedding(2D位置编码未见明显差异)

- 整个架构参考Transformer

位置偏差:?

- CNN而言,是局部的,拥有2维相邻结构,平移等方差应用于每一层

- ViT而言,只有MLP是局部的,平移方差;自注意力是全局的,因此patch之间的关系都需要从头学习(这个单词可以注意一下:Scratch)

混合架构:

这里主要是关于Transformer的输入问题,将图像处理后符合其输入,同理,就是将图符合输入即可,那么对于CNN输出的特征图也可视为Transformer输入的原始图,由此称为Hybrid。

对特征图的操作,甚至更为简单,因为特征图相当于1个1*1空间维度为1个patch,只需要将特征图的维度映射到Transformer的维度,后续加上class embedding + position embedding即可。

Pre-train ViT注意点:

利用预训练模型已经十分常见!这里提及了一些相关操作或注意事项。

- 通常remove预训练模型的prediction head,这个和具体任务有关。

- attach D*K前馈网络,实际就是具体任务对应的K个类别。

- Transformer确实可以处理不同长度的序列,但是,预训练的位置编码可能就失去了意义,因此需要利用2D interpolation对预训练模型的位置编码进行处理,主要依据他们在原始图像的位置。

模型命名及参数:

现有实践中,经常调用TiMM库直接进行Create_model,因此清楚命名尤为重要!

这里就能对Timm库所提供的预训练模型有所理解。

How the Vision Transformer processes image data ?

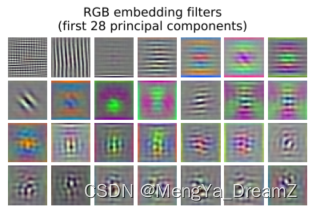

第一层:将flattened patch线性映射到较低的维度空间,下图展示了学习到的嵌入过滤器的顶部主成分。这些分量类似于每个补丁内精细结构的低维表示的可信的基础函数。

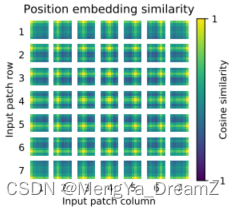

位置编码:一个可学习的位置编码加入其中,如下图,该模型学习用位置嵌入的相似性来编码图像中的距离,比如距离较近的patch往往有更相似的位置嵌入。此外,出现了行-列结构;同一行/列的斑块有相似的嵌入。最后,对于较大的网格,正弦结构有时更为明显。位置嵌入学习表征二维图像拓扑结构,这也是手工标记的二维感知嵌入变体没有产生改进得原因。(依旧存疑)

自注意力:?即使在最低层,依旧能够整合整个图像的信息。

what degree the network makes use of self-attention capability ?

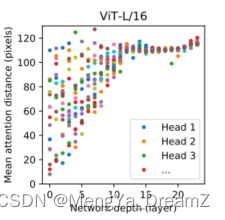

具体而言,注意力权重能够计算出信息在图像空间中被整合的平均距离。如下图所示,?"注意力距离 "类似于CNN中的感受野大小。可以发现,有些head在最低层就已经注意到了大部分的图像,这表明模型确实使用了全局整合信息的能力。其他head在低层的注意距离一直很小。这种高度局部化的注意力在ResNet+Transformer的混合模型中不太明显,表明它可能起到与CNN中早期卷积层类似的功能。此外,注意力距离随着网络深度的增加而增加。(高度局部化注意力在混合模型中并不明显,混合模型缓和了注意力的分布不均?!)。

?

训练适用的参数设置:

- Adam :?

?= 0.9 ,?

?= 0.999

- Batch_size :4096 (批处理大小就看自己情况了)

- Weight_decay : 0.1

当然,实验也发现参数也会影响性能。?