论文地址:https://arxiv.org/abs/2204.08470v1

文章目录

论文概要

本论文是一篇使用U-Net及其变形进行医学图像分割的简短综述,文中给出了关于医学图像分割逐步发展的俯瞰图,也讨论了深度神经网络的挑战和成功。在本文的最后我们将会看到医学图像分割(medical image segmentation,MIS)目前的挑战和未来的方向。

1. 介绍

选择了一个简单的分类方案,用于介绍一些流行的基于U-Net的深度神经网络用于MIS。我们从普通的U-Net开始,接着是U-Net的各种变形:跳跃连接,残差,循环,注意力机制,transformer。

U-Net是用于不同医学图像分割任务最流行的结构之一。

U-Net++有更多稠密的跳跃连接,可以帮助语义学习和平滑梯度。

R2U-Net是带有残差和循环连接的U-Net。

Attention U-Net使用attention gates来提升对于感兴趣区域的注意力。

Trans U-Net是一个U-Net和视觉transformer的混合网络,并带有注意力模块。

2. 方法

2.1 传统分割

传统的分割方法:基于阈值的分割、基于聚类的分割、均值漂移分割、图切割分割

基于阈值的分割:包括从直方图特征中找到合适的阈值,并使用该阈值对图像进行二值化。这种方法不适合处理多类别分割,也不能处理高强度变化。

基于聚类的分割:将相似的像素分组为簇,并为每个簇指定颜色标签。K-均值聚类是一种典型的聚类算法,可以将图像分割为 k 簇。这种方法主要的缺点是需要预先知道簇的数目。

均值漂移分割:本质上是一种爬山算法,使用窗口和窗口的均值用于爬山。所有属于一座山的像素被指定为相同的簇。

图切割分割:是最复杂的分割算法,基于最大流和最小割算法。

所有传统的分割算法都对自然图像进行了良好的分割,但在医学图像分割中表现出较差的性能。

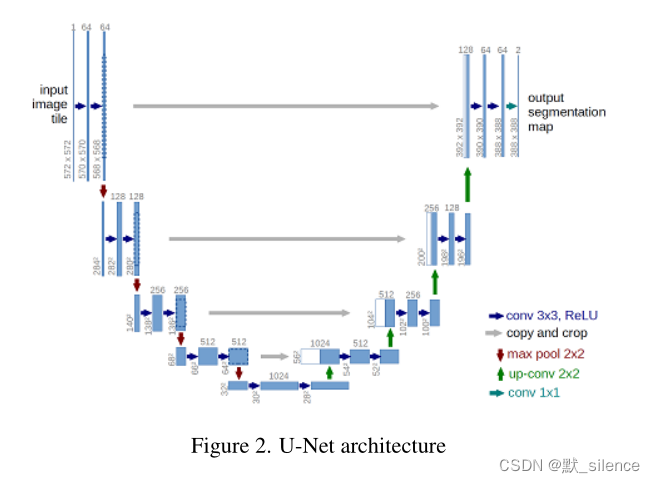

2.2 U-Net 2015

基于编码器-解码器的结构,是一个分层的上采样卷积层,伴随有对称的上采样卷积层。另外来自于编码器网络的特征图被连接到对应的解码器部分,用于提取语义信息。

左边的部分是收缩路径,被叫作编码器,因为它将高维空间的信息编码为低维的潜在表示。右边的部分是扩展路径,叫作解码器,它将低维的潜在表示解码为高维空间的分割图。

-

编码器包括3×3大小的卷积层,后面跟随着线性激活函数ReLU。这种conv-relu-conv-relu被称为一个卷积块。

-

编码器中最大池化的采样层用来减少特征图的空间维度

-

编码器中的特征图数量逐渐增加

-

解码器是编码器的一个对称结构,但是使用上卷积或转置卷积来提升特征图的高维空间维度

-

解码器中的特征图数量逐渐减少

-

另外,来自于编码器中的特征图被裁剪用以符合解码器特征图的维度与连接。

softmax层用来进行像素分类,从而生成特征图。U-Net是一个使用交叉熵损失函数训练的端到端网络。

通常在医疗任务中,数据的可用性是稀缺的,用少量数据学习的模型需要几个小时。令人惊讶的是这个需求被U-Net解决了。它使用少量的图像超过了其他的方法。

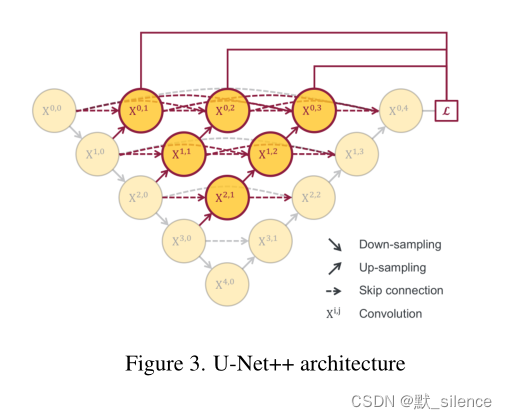

2.3 U-Net++ 2019

U-Net++是一个嵌套的U-Net结构,是稠密连接和深度监督的。嵌套和密集的跳跃连接用于向解码器部分提供正确的语义和粗分级信息。这种连接具有从所有先前层向当前层的前向连接。

这些稠密的连接有助于梯度消失问题、特征服用、加强特征传播。深度监督有助于在不同层学习粗-细粒度特征。在子网络的最后一层获得分割图像,并按照输入scale进行上采样,进行深度监督。

与U-Net主要的不同:

- 跳跃路径的卷积层

- 稠密的跳跃连接用于梯度流

- 深度监督

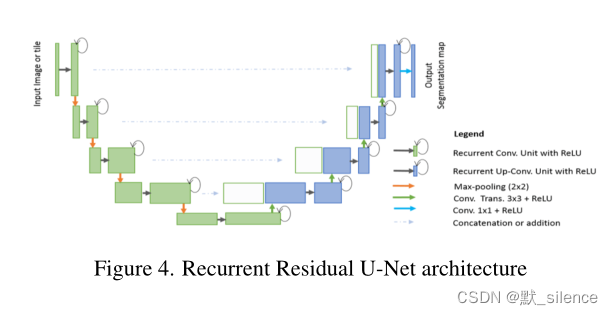

2.4 R2U-Net 2018

R2U-Net是基于流行的残差和循环技术建立的。

深度卷积网络在大多数视觉任务上表现很好,但是栈式的层存在限制,由于梯度小时和梯度爆炸问题导致。为了解决梯度消失,引入了skip/identity connections。identity connection可以简单定义为从上一个块到下一个块,跳过当前块的操作。

循环网络和它的变形大多数时候用于序列数据:自然语言、语音信号等。循环网络有循环反馈连接,从输出到输入。这个循环连接有助于学习序列的背景。

U-Net中的每个卷积块被替换成了一个循环-残差块。U-Net中编码器和解码器之间的裁剪和复制被替换成了一个更简单的特征串联。

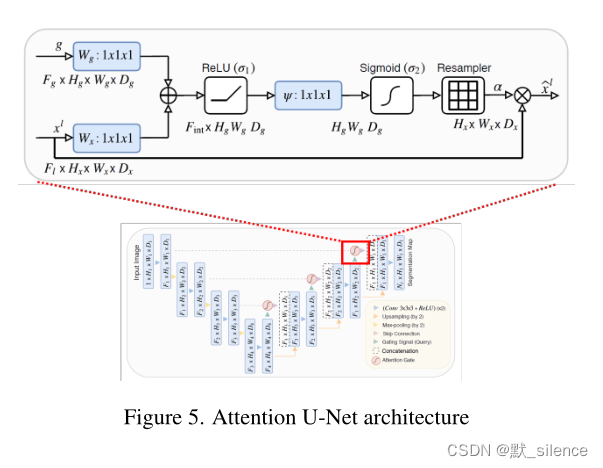

2.5 Attention U-Net 2018

注意力网络是一种在跳跃路径里有注意力门的混合结构。这些注意力门只向解码器通过重要的特征,抑制冗余的信息,为了分割图像更精确的重建。注意力机制首先使用在语言任务,idea被借用到了视觉任务。根本上讲,注意力门有助于学习附近的背景。有两种注意力门,软注意力和硬注意力。

软注意力输出权重在0和1之间的输入加权组合,这是一个可微函数。注意力网络在跳跃路径里使用软注意力门。如果数据集在RoI的形状和大小上有较大变化,则前面讨论的模型将受到影响。注意力门无疑问地突出重要特征,专注于RoI。

残差和稠密连接也存在于编码器和解码器之间。注意力门带来了额外的计算开销,但是提升了分割正确率。

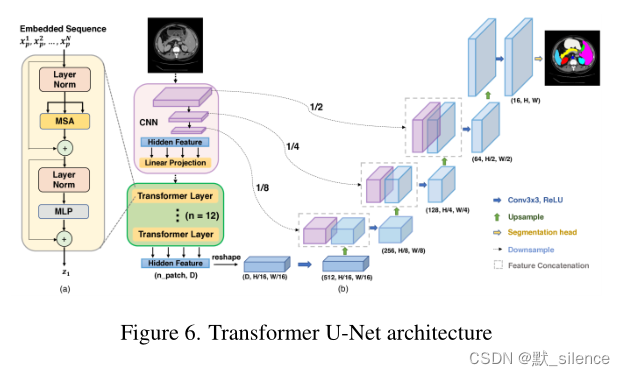

2.6 Trans U-Net 2021

当形状和大小变化较大时,全卷积网络有较差的表现。Trans U-Net是一个基于视觉transformer的结构。Transformer网络在语言翻译和语音翻译等序列到序列预测任务有了显著改进。Transformer包含多个头部自我关注模块,可提供全局自我关注。卷积神经网络有内在的局限性。由于卷积是局部操作,U-Net无法学习全局空间相关性。由于缺少底层细节,仅使用Transformer也是不可行的选择。

作者表明,通过将U-Net和Transformer相结合,我们可以实现两种网络的优点。TransUNet本质上是Transformer和U-Net的组合。在本工作中,Transformer使用全局表示对拼接图像特征进行编码,而解码器将特征向上采样至原始图像尺寸。

普通U-Net编码器被基于CNN的特征提取器取代,然后是Transformer层。在之前传递给解码器的过程中,编码的CNN特征和Transformer特征被适当地连接起来。这种编码方法有助于精确定位RoI。特征通过跳跃路径聚合在不同的层。减少了欠分割和过分割,更好的全局背景,更好的语义信息被学习。

作者展示了Trans U-Net表现一贯地好于最好的注意力网络

3. Disscussion

再次回顾我们的主要目标是开发一个精确的医学图像分割模型。任何MIS模型的目标都是在大部分的医学图像模式中提供更稳定的性能。

传统分割算法无法适用于特定的MIS任务。这些算法主要的优点是不需要训练数据。在U-Net开发之前,没有特殊注意网络设计的FCN相比于传统方法来说取得了部分成功。MIS在U-Net之后开始取得进步,使得MIS领域发生了革命性的变化,U-Net最主要的贡献:

- 通用性的图像分割结构,可以用于任意的分割任务。

- 提供合适的数据和训练时间,有高正确率。

- 甚至在有限的训练数据上取得成功

- 在医学分割应用上尤其成功

U-Net唯一的限制是它使用整个图像,所以当图像很大时需要一个较大的显存

U-Net++和R2U-Net使用了强大的技术,像残差和稠密连接,这些技术原本使用在其他视觉任务。这些方法轻微提升了性能但是复杂度很高。后面的Attention U-Net也有了轻微的性能提升,但是带来了高复杂度和附加的计算开销。只有TransU-Net在这两方面有一个合理的权衡。但TransU-Net相比于U-Net需要更多的训练数据。

我们看到U-Net四种不同的变形,除了TransU-Net另外的三种只有微小的性能提升。从2016年到2022年,MIS的进步缓慢,在transformer到来之后才开始回到正轨。

在某种程度上,医生和工程师都合理地接收了医学图像分割,然而还有不少的挑战存在。有:

- 执行分割的医学图像种类繁多

- 训练数据的可用性有限

- 噪声标签;不同临床图像注释器之间的注释偏差。

- 临床专家和机器学习研究人员之间缺少反馈回路。

很明显,神经结构是MIS成功的关键。因此,MIS的自动神经结构研究可能是研究人员寻找更好的MIS的潜在方向。众所周知,每个神经架构都是用一组超参数训练的,这导致了模型的成功。自动机器学习(AutoML)可以用来寻找正确的神经结构、数据增强技术、超参数、损失函数,引起了研究者极大的兴趣。模型解释是为了更好地理解模型并在此基础上进行构建。除了监督学习方法,自监督学习和弱监督学习在医学图像方向也可能成为解决弱标签和无标签数据的潜在方向。