论文地址: ACM-Net: Action Context Modeling Network for Weakly-Supervised Temporal Action Localization

1.介绍

ACM-Net全称action context modeling net,本文认为对于视频来说,除了独特的前景和背景帧外,还有大量语义模糊的动作上下文帧。将这些上下文帧分组到同一个背景类是没有意义的,因为它们在语义上与特定的动作类别相关。这在思想上与CoLa是一致的,Cola中获取困难动作与困难背景,也是这个道理。

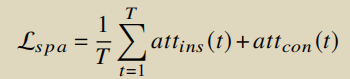

本文提出了一个ACM-Net 的动作上下文建模网络,它集成了一个三分支注意力模块,以同时计算每个时间的动作实例,上下文和非动作背景的可能性。然后,基于获得的三个分支注意力值,构建了三个分支类激活序列,分别表示动作实例,上下文和非动作背景。

三个贡献:

- 与之前将视频帧仅划分为前景帧和背景帧的方法不同,认为存在一些语义模糊的动作上下文帧。

- ACM-net集成了一个class-agnostic的三分支注意力模块,以同时测量包含动作实例,动作上下文和非动作背景帧的每个时间点的可能性。

- ACM-net优于当前最先进的方法

2.方法

2.1 ACM-net

特征提取

首先根据预定义的采样率将其划分为非重叠片段,然后应用预先训练好的网络来提取片段级特征。将视频片段保持为𝑆={𝑠(𝑡)}𝑇𝑡=0。至于片段𝑠(𝑡)的特征提取,利用RGB和光流分别对静态场景特征𝐹𝑟𝑔𝑏(𝑡)∈R𝐷和动作特征𝐹𝑓𝑙𝑜𝑤(𝑡) ∈ R𝐷进行编码,之后,连接𝐹𝑟𝑔𝑏(𝑡)和𝐹𝑓𝑙𝑜𝑤(𝑡)形成片段特征𝐹(𝑡) = [𝐹𝑟𝑔𝑏(𝑡),𝐹𝑓𝑙𝑜𝑤(𝑡)]∈R2𝐷。然后,将所有片段特征叠加,形成视频特征𝐹∈R𝑇×2𝐷。

特征嵌入

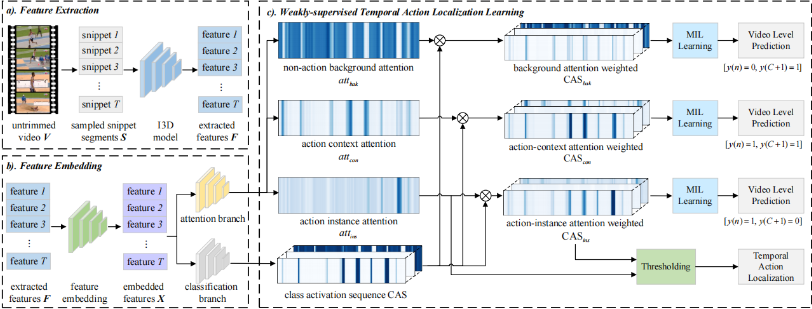

由于提取的特征𝐹没有为W-TAL任务从头开始训练,以便映射提取的视频特征𝐹到特定任务的特征空间,引入了一个特征嵌入模块。具体来说,使用一组卷积层和非线性激活函数来映射原始视频特征𝐹∈R𝑇×2𝐷到对应特定任务的视频特征𝑋∈R𝑇×2𝐷。形式上可以将特征嵌入模块表示为:

𝜃𝑒𝑚𝑏𝑒𝑑表示特征嵌入层的可训练卷积参数,ReLU是非线性激活函数。

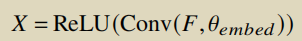

动作类激活建模

首先应用一个片段级动作分类分支来获得类激活序列(CAS)。尽管这种CAS不能很好地抑制那些语义模糊的动作上下文,但它能够抑制动作相关和非动作相关的帧。在形式上,可以将动作类激活分支表示如下:

注意力建模

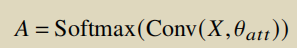

在本文中,将所有与动作相关的模糊上下文帧表示为动作上下文。首先引入三分支片段级动作注意力模块来检测class-agnostic动作实例,语义模糊上下文和非动作背景帧。具体来说,使用一个卷积层和softmax函数来测量每个片段包含动作实例,动作上下文或非动作背景的可能性。三分支注意力模块的输出为𝐴={(𝑎𝑡𝑡𝑖𝑛𝑠(𝑡),𝑎𝑡𝑡𝑐𝑜𝑛(𝑡),𝑎𝑡𝑡𝑏𝑎𝑘(𝑡))}𝑇𝑡=0∈R𝑇×3,其中𝑎𝑡𝑡𝑖𝑛𝑠(𝑡),𝑎𝑡𝑡𝑐𝑜𝑛(𝑡),𝑎𝑡𝑡𝑏𝑎𝑘(𝑡)分别表示片段𝑠(𝑡)分别是动作实例,动作上下文或背景的可能性。形式上将三分支片段级动作注意力模块表示如下:

𝜃𝑎𝑡𝑡表示三分支动作上下文注意力分支的可训练卷积层参数。

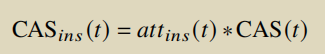

根据所得到的注意力值,为了区分动作实例,上下文和动作背景帧,分别构建了新的三分支类激活序列CAS𝑖𝑛𝑠,CAS𝑐𝑜𝑛和CAS𝑏𝑎𝑘。

多实例学习

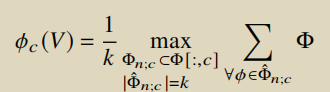

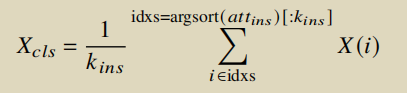

𝑉作为一包视频片段,每个片段实例由相应的类激活分数表示。为了衡量每个CAS的损失,将top-𝑘动作分类分数以及每个动作类别的所有视频片段,然后对它们进行平均,以构建视频级别的类激活分数。

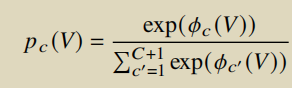

然后,对聚合的平均top-𝑘𝑎𝑐𝑡分数应用一个softmax函数,以获得每个动作类的视频级动作概率:

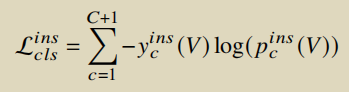

应用预测的视频级动作概率分布𝑝𝑐(𝑉)和ground-truth视频动作概率分布𝑦𝑐(𝑉)之间的交叉熵损失函数来对视频中不同的动作类进行分类。具体来说,对于CAS𝑖𝑛𝑠,可以将分类交叉熵损失表示为:

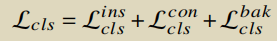

其中,𝑦𝑖𝑛𝑠𝑐是视频𝑉的第𝑐个类的归一化视频级标签。设置了视频级标签𝑦𝑖𝑛𝑠=[𝑦(𝑛)=1,𝑦(𝐶+1)=0],在CAS𝑖𝑛𝑠中,非动作背景和模糊的动作上下文片段被抑制。用类似的方法,可以分别得到交叉熵损失L𝑐𝑙𝑠𝑐𝑜𝑛和L𝑐𝑙𝑠𝑏𝑎𝑘。设置了视频级标签𝑦𝑐𝑜𝑛=[𝑦(𝑛)=1,𝑦(𝐶+1)=1],𝑦𝑏𝑎𝑘=[𝑦(𝑛)=0,𝑦(𝐶+1)=1],CAS𝑐𝑜𝑛和CAS𝑏𝑎𝑘更关注动作上下文和背景场景,而不是动作实例片段。

2.2 优化目标

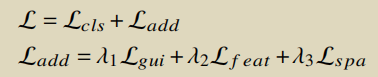

除了常规的分类损失L𝑐𝑙𝑠外,还应用了三个额外的损失来使网络获得更好的性能

- 注意力引导损失L𝑔𝑢𝑖,它用于约束动作实例注意力加权CAS𝑖𝑛𝑠与动作实例注意力相一致

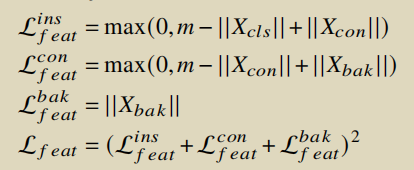

- 动作特征分离损失L𝑓𝑒𝑎𝑡,用于在特征范数空间中分离动作实例,动作上下文和背景片段特征

- 稀疏注意力损失L𝑠𝑝𝑎,约束动作实例和动作上下文分支更关注与动作相关的帧

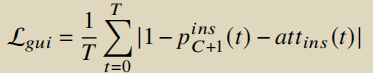

注意力引导损失

为了使动作分类分支在片段级区分动作实例片段和那些模糊的动作上下文帧,除了视频级交叉熵分类损失L𝑐𝑙𝑠外,引入了注意力引导损失。

动作特征分离损失

为了使嵌入视频片段的特征与动作实例,动作上下文和背景特征更加容易区分,在特征范数空间引入了动作特征分离损失L𝑓𝑒𝑎𝑡。

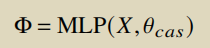

稀疏注意力损失

引入了稀疏注意力损失𝐿𝑠𝑝𝑎𝑟𝑠𝑒来约束网络优化过程,这是基于一个假设,一个动作可以被视频中的关键片段的稀疏子集识别