Abstract

本文提出了一个用于头部姿态估计的基于CNN的协同学习框架。框架包含了基于关键点和不基于关键点的两个分支,第一个分支需要先估计出关键点,然后提出了一个Landmark-MLP-Mixer模块来建模从关键点到头部姿态角之间的复杂映射关系,第二个分支则采用标签分布学习策略来估计头部姿态。这两个分支单独的情况下都可以进行头部姿态估计,作者说在这个框架下,这两个分支相互协作,相互促进和互补来学习语义信息。在网络中间,作者还引入了一个双分支的迁移模块来实现显式的语义交互,然后也设计了一个多损失策略来诱导隐式的信息交互。

1. 贡献(Contributions)

- 提出了一种基于CNN的头部姿态估计协同学习框架,在基于关键点、不基于关键点两个分支间相互协作;

- 引入一个LMM模块来建模在基于关键点分支中从关键点到头部姿态角的非线性映射关系。采用分类和回归任务相结合的方法,将头部姿态的标签分布作为不基于关键点分支分类任务的监督信息。

- 在网络中间提出了一个DBTM来实现显式语义交互,并引入一个union loss,诱导隐式信息交互。

2. 相关工作(Related work)

多任务学习

多任务学习是一种推断性的迁移学习,通过联合训练多个任务,同时允许不同任务之间的知识迁移,从而提高单个任务的泛化性。

在多任务学习过程中,神经网络具有在不同任务之间转移和共享知识的独特能力。在计算机视觉中,多任务学习已被广泛应用于同时学习语义分割等相关任务。在面部分析领域中,头部姿态估计常被用作协同估计面部地标的预处理步骤【1】。ASMNet【2】是一种轻量级的CNN架构,具有多任务学习功能,用于面部地标检测和姿态估计,可以实现两个任务之间的协同作用,提高单个任务的性能。Hyperface【3】通过卷积神经网络从图像中提取低级和高级特征,并将其用于单一框架中,执行人脸检测、关键点定位、性别分类和头部姿态估计等多个任务,实现了当时最先进的性能。在Retinaface中【4】,作者提出了边界框和面部关键点的多任务学习,以提高任务性能。在img2pose【5】中,作者构建了一个多任务网络,将头部姿态估计、人脸分类和人脸对齐联系起来。在MNN【6】中,作者提出了一个具有残差块和横向跳跃连接的编码器-解码器CNN来解决人脸分析多任务,利用了头部姿态、人脸关键点和以及关键点能见度之间的强依赖关系。在MNN中头部姿态由刚性变换的六个参数得到,并在编码器的最后一层输出。解码器的最后一层输出关键点的可见度和位置。

3. 方法(Method)

网络分为两个branch,landmark-based branch和landmark-free branch。在landmark-based branch中,分两个阶段,第一个阶段先回归出关键点,第二个阶段通过LMM模块基于关键点预测头部姿态。landmark-free branch采用回归和分类相结合的方式。最后的输出是基于两个branch共同输出做预测。

landmark-free branch是分类和回归相结合的,分类是指提取出的特征经过softmax得到标签的类别(分箱操作,在头部姿态估计领域很常见,把-180°到180°的label按间隔分成若干个类别,然后估计样本的姿态属于哪个类别),同时另一边经过检测头直接回归姿态角度。另外,作者称头部姿态是连续的,具有相邻姿态的面部图像是非常相似的,所以有必要考虑相邻头部姿态之间的关系。因此,作者引入了头部姿态的标签分布(label distribution)作为分类任务的监督信息,其实就是使用了一个ld loss,就是一个分类任务的标准交叉熵损失,与之前分箱操作是一样的,只是描述的高端了一些,也没有对最初提出分箱操作的文章引用【8】。

Backbone使用的是EfficientNet,GAP 模块是 global average pooling。

Landmark-MLP-Mixer 模块示意图如下,是启发于Google 的MLP-Mixer【7】并设计的,算是魔改一下,创新性不高。

DBTM模块是基于一篇CVPR 2020的多模态融合工作Mmtm【9】进行的魔改,创新性也不高,结构示意图如下所示。该模态主要的目的是希望通过两个backbone提取出来的特征相互交互。

最后除了以上的损失外,作者在训练的时候还增加了一个union loss,就是让两个分支输出的结果平均之后再计算loss。

4. 结果(Result)

在BIWI上训练的时候,该篇文章也是用FAN检测的68个人脸关键点作为ground truth来训练的。

1)姿态:在300W-LP上训练,在AFLW2000,BIWI上测试:在AFLW2000上跑到了SOTA(领先一点点),在BIWI上没跑到SOTA。

2)姿态:在BIWI上训练,在BIWI上测试:没跑到SOTA,且没有对比最新的文献。

3)关键点:AFLW上没跑到SOTA

4)关键点:AFLW2000上跑到了SOTA

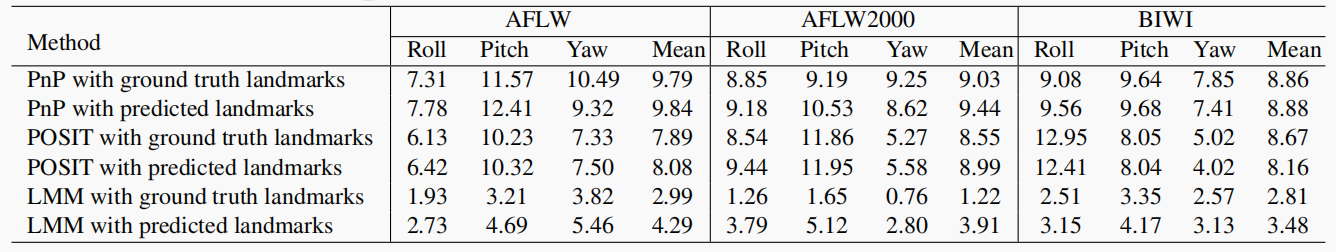

消融研究部分,作者还将本文的方法与传统基于集合的方法PnP和POSIT进行了对比,基于预测的landmark和基于真实的landmark都进行了实验。

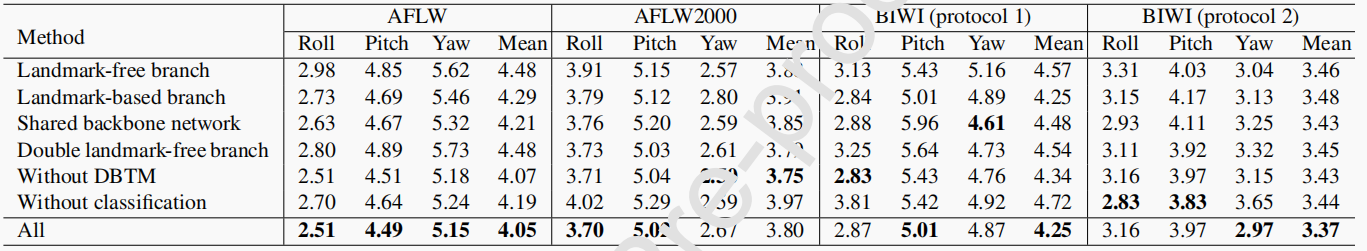

对模型中每一个部分都进行了消融研究,探索了各自的有效性。

参考文献

【1】Yang, H., Mou, W., Zhang, Y., Patras, I., Gunes, H., Robinson, P., 2015. Face alignment assisted by head pose estimation, in: Proceedings of the British Machine Vision Conference, pp. 130.1– 130.13. doi:10.5244/C.29.130.

【2】Fard, A.P., Abdollahi, H., Mahoor, M., 2021. Asmnet: A lightweight deep neural network for face alignment and pose estimation, in: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops, pp. 1521–1530. doi:10.1109/ CVPRW53098.2021.00168.

【3】Ranjan, R., Patel, V.M., Chellappa, R., 2017a. Hyperface: A deep multi-task learning framework for face detection, landmark localization, pose estimation, and gender recognition. IEEE Transactions on Pattern Analysis and Machine Intelligence 41, 121–135. doi:10.1109/ TPAMI.2017.2781233.

【4】Deng, J., Guo, J., Ververas, E., Kotsia, I., Zafeiriou, S., 2020. Retinaface: Single-shot multi-level face localisation in the wild, in: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 5203–5212. doi:10.1109/CVPR42600.2020. 00525.

【5】Albiero, V., Chen, X., Yin, X., Pang, G., Hassner, T., 2021. img2pose:Face alignment and detection via 6dof, face pose estimation, in: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 7617–7627. doi:10.1109/CVPR46437.2021. 00753.

【6】Valle, R., Buenaposada, J.M., Baumela, L., 2021. Multi-task head pose estimation in-the-wild. IEEE Transactions on Pattern Analysis and Machine Intelligence 43, 2874–2881. doi: 10.1109 / TPAMI.2020.3046323.

【7】Tolstikhin, I.O., Houlsby, N., Kolesnikov, A., Beyer, L., Zhai, X., Unterthiner, T., Yung, J., Steiner, A., Keysers, D., Uszkoreit, J., Lucic, M., Dosovitskiy, A., 2021. Mlp-mixer: An all-mlp architecture for

vision, in: Advances in Neural Information Processing Systems, pp. 24261–24272. doi:10.48550 /arXiv.2105.01601.

【8】Ruiz N, Chong E, Rehg J M. Fine-grained head pose estimation without keypoints[C] // Proceedings of the IEEE conference on computer vision and pattern recognition workshops. 2018: 2074-2083.

【9】 Joze, H.R.V., Shaban, A., Iuzzolino, M.L., Koishida, K., 2020. Mmtm: Multimodal transfer module for cnn fusion, in: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 13289–13299. doi:10.1109/CVPR42600.2020.01330.