疾病检测中的语音生物标识研究

概要:尽管语音识别技术随着以深度学习为代表的人工智能的发展得到了巨大的提升,但是如何将语音信息作为疾病检测的一种手段,这仍然是一个棘手的问题。随着多模态技术的发展,语音生物识别逐渐引起人们的关注。作为一种非侵入式的语音筛查工具,在数字健康、生命检测、家庭护理等场景下具有重要的应用价值。本研究将关注语音生物识别技术在疾病筛查,健康检测等方面的方法。

关键词:语音识别、语音生物标记物、多模态技术、疾病筛查

一、 研究概述

语音识别是以语音为研究对象,通过语音信号处理和模式识别等技术让机器能够自动识别和理解人类口述的语言。语音识别技术包含机器对语音信号的处理,机器对人类语义的理解,以及将语音信号转换为相应的文本或动作等过程。语音识别可以帮助计算机理解人类的行为,判断人类当前的情绪和状态。

目前,已经有大量的机器学习模型和深度学习模型被广泛应用到语音识别研究中[1-5],并取得了良好的效果。例如使用循环神经网络可以有效地利用语音中的上下文信息,使用卷积神经网络可以利用共享权值的方法减少计算复杂度,引入长短时记忆网络解决了梯度消失的问题,使得语音识别在近场条件下达到满足人们日常生活的标准。

随着以Attention[6]为代表的端到端语音识别技术的快速发展,一种基于Attention的Seq2Seq[7]的语音识别模型得到了学术界的极大关注,并取得了显著的效果。2017年Google提出的一种称为Transformer[8]的架构再一次取得了明显的改进效果。同时,生成式对抗网络(GAN)是近年来无监督学习方面最具有前景的一种深度学习框架。Ian J. Goodfellow等提出了一个对抗过程估计生成模型框架的全新方法[9],提升了语音识别的噪声鲁棒性。Zhang等[10]第一个将GAN引入到SnS分类任务中,为解决打鼾位点定位的医疗任务中的数据稀疏问题提供了一种思路。

尽管语音识别在整体水平上已经与人类水平相差不大,甚至已经超越了人类的平均水平,但是在某些特定场景中依然存在不少应用挑战,其中包括:如何保证在复杂场景下语音识别的鲁棒性;如何适应不同地区、不同人群的说话方式;如何使用少量的数据满足复杂专业的业务场景。

二、 研究内容

本研究将关注复杂医疗保健场景中语音生物识别[11-13]问题,建立基于多模态方法的语音生物标志物分析方法,促进疾病筛查和诊断效率的提升,创新医疗服务模式。

在医疗保健场景中,常见的语音识别应用是生成医疗档案(如病例、医嘱等)[14]。由于语音识别技术的应用,医生可以快速记录他们的声音,并同时记录诊断、治疗记录和其他重要的笔记,而不必占据业余时间。对于护理人员来说,使用语音识别技术可以减少他们在文书工作上的时间,使得能够花费更多的时间在病患身上。

随着可穿戴设备和便携式智能音箱的发展,进一步扩展了医疗保健服务的物理范围。语音生物识别技术可以通过感知和分析目标对象声音中的细微变化,来识别例如咳嗽、哮喘、COPD(慢性阻塞性肺疾病)等呼吸系统疾病的症状。尽管该方法不能代替医生的判断,但是通过快速广泛的筛查提供可靠的风险评分来指导可能需要额外诊断测试的人,从而使卫生系统能够更有效地分配诊断资源,这是语音生物标志物检测的重要价值之一。

除了呼吸系统疾病筛查之外,语音生物识别对于分析心理健康问题[15]也就有研究价值。当人体出现健康问题时,疾病的特异性干扰会对某个系统或多个系统产生细微的、难以察觉的,但具有特异性的变化,而这种变化是可以被用来进行计算分析的。以抑郁症[16]为例,患者往往会表现出言语迟缓、音量不稳定、发声颤抖、语言韵律异常等症状。有研究发现,抑郁症患者治疗前较治疗后,声带发声的时刻和强度在每次声带振动的周期中,波动都比较显著,并且波动程度与抑郁症的严重程度呈正相关。

同时,语音生物识别的研究也面临这一些问题。首先是使用场景的复杂化,这就导致了容易出现噪声干扰等问题;其次是语料的不足或缺失,一方面是特定类型语料库的缺少,另一方面是语义理解规则需要先验的专家知识。第三是个性化语言习惯问题,比如方言与普通话、中文与英文等,这可能要求语音生物识别系统具有个性化优化的能力。

三、 研究方法

3.1 深度学习模型

当前,深度学习模型在语音识别展现了非常好的效果,依据模型的不同,常用的方法有:

- CTC[17],即Connectionist Temporal Classification,从字面上看,它是一种用来解决时序类数据的分类问题。通过CTC,可以直接将语音在时间上的帧序列和相应的转录文字序列在模型训练过程中自动对齐,无需对每个字符或音素出现的起止时间段做标注,以实现直接在时间序列上进行分类。

- LAS[18],即Listen, Attend and Spell,是一种能够将语音直接转换为字符的端到端神经网络语音识别器,它不需要发音模型、HMMs或其他传统语音识别中的组件。

- RNN-T[19],即RNN-Transducer,是一种能够更好地对输出结果前后词之间的依赖关系进行建模的方法。它包含三个部分:Encoder、Prediction Network、Joint Network。对声学模型和语言模型分别建模,同时又通过Joint Network来联合优化,将说话人分离任务和语音识别任务融合在一起,提供了一种有效降低分离错误率的全新思路。

- Attention模型。类似于RNN-T,基于Attention的Encoder-Decoder模型也不需要对输出序列做相互独立的假设,但是与CTC和RNN-T不同,Attention不要求输出序列和输入序列按时间顺序对齐。针对语音识别,给定输入特征序列X和输出序列Y的编解码过程包括三个部分:Encoder,Decoder,以及Attention。其中Encoder相当于声学模型,Decoder相当于语言模型,Attention模块从Encoder输出所有向量序列,计算注意力权重,并基于该权重构建Decoder网络的上下文向量,进而建立输出序列与输入序列之间的对齐关系。

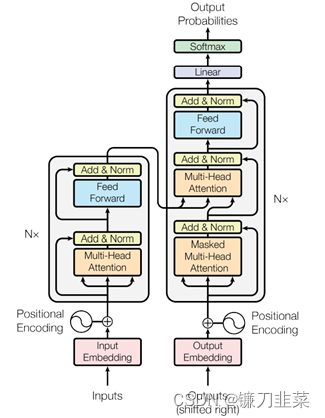

- Transformer。这种架构在每个Encoder和Decoder中均采用Attention机制,建立输入语音特征和识别结果之间的序列对应关系,本质上还是seq2seq的结构。Transformer模型架构如图1所示:

图1 Transformer模型框架[20]

3.2 多模态语音识别

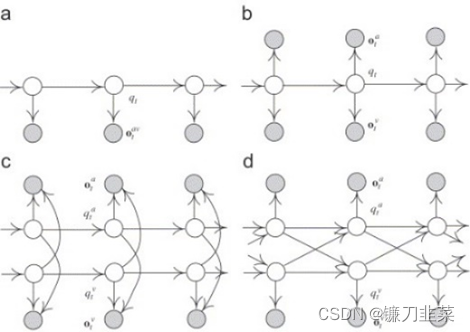

众所周知,除了语音外,人类还可以通过文字、表情、视频、动作等方式传递信息。传统的语音识别大都基于单一的语音信号,且容易受到环境中噪声等因素的干扰。因此,已经有大量的研究工作表明多模态方法优于单一模态的方法。多模态语音识别技术综合利用音频、视频甚至更多模态信息,以获得更高精度且对特定场景具有较强适应性的识别系统。早期的研究方法是基于HMM的多源数据建模方法(CHMM),将多模态数据作为统一HMM模型的观测变量[21]。

图2 传统基于HMM的多源数据建模方法[21]

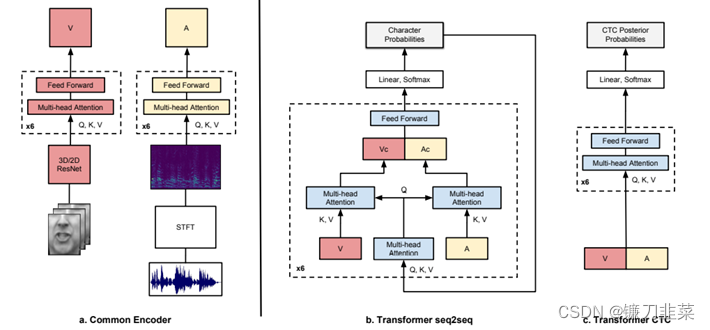

随着近年来的基于深度神经网络的多模态语音识别技术的发展,特别是端到端学习方法和大规模音视频数据库的出现,进一步提高了多模态语音识别的性能。Afouras等[22]开发了面向唇读句子的神经转换体系架构,并建立了两种基于Transformer Self-Attention的架构,还研究了在噪声条件下唇读对语音识别的辅助作用。

图3 基于Transformer的视听语音识别模型[22]

目前,虽然多模态语音识别已经取得了不错的效果,但是还有一些问题需要解决,特别是如何对异质的多模态数据进行合理融合。当前的通常做法是对多模态特征进行拼接或选择,但是这样没有考虑到各个模态在信息两、鲁棒性、时域解析度等特性上的差异,也没有考虑不同模态之间的相关性、互补性、异步性。尤其是在结合深度神经网络时,简单的特征层面融合会带来可解释性和可扩展性的降低。

根据Han等[23]的总结,多模态信息的融合策略可以分为三类,即特征层面的融合、决策层面的融合以及模型层面的融合。其中关于特征层面的融合在上文已经提到,对于决策层面的融合,通常的做法是基于多数投票制(majority voting)和边际抽样投票制(margin sampling voting)[24]。对于模型层面旨在整合不同模式(例如声音、视频等)的中间表示形式,可以利用该策略在深度神经网络的训练过程中引入概率模型整合多源数据表示进而提高数据融合的安全性、合理性和可解释性。

3.3语音生物标记检测

对于语音生物识别问题,麻省理工学院的研究人员提出了一种新的多模态处理框架,即Open Voice Brain Model(OVBM)[13],该框架首先通过在大的语音数据集上训练模型,然后进行迁移学习,使得学习到的特征即使是在小规模的患者数据集上也能够很好地改善阿尔兹海默症(AD)的检测准确度。同时,作者还表示该框架可以用于多种疾病的音频检测,并研究不同疾病之间是否存在共同的语音生物标记。

OVBM 框架构建了一个由四个单元构建的系统来检测生物标记组合,并为目标任务(如 AD 鉴别)提供了一个可解释的诊断框架。这四个单元分别是

- Sensory Stream,负责在较大的语音数据集上执行预训练过程,旨在提取个体物理层面的标记特征;

- Brain OS,将音频分割成重叠的块,并利用迁移学习策略,将生物标记模型调整到更小的目标数据集上;

- Cognitive Core,整合特定目标任务的医学知识来训练认知生物标记特征提取器;

- Symbolic Compositional Models 将微调的生物标记模型整合到一个图神经网络中,它在单独的音频块上的预测输出被输入到一个聚合引擎中,最终得到诊断结果和一个患者的显著性图。

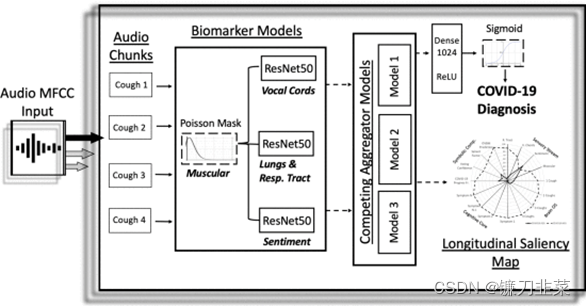

Laguarta等[25]将该框架应用在了COVID-19的检测中,首先记录患者的咳嗽音频数据,然后对数据执行两个预处理步骤,并将其输入到一个基于CNN的模型中,得到一个预筛选的诊断结果和一个生物标志物显著性图。

图4 以咳嗽录音为输入数据的COVID-19诊断框架[25]

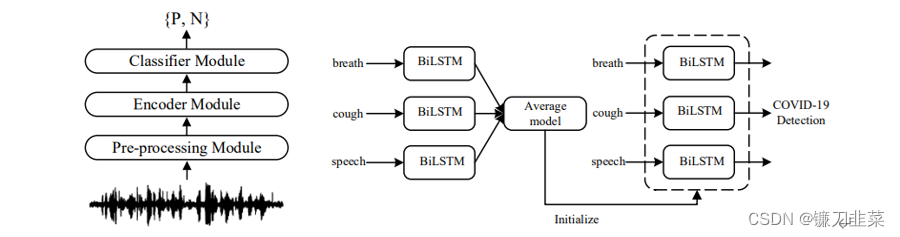

Chen等[26]提出了一种使用呼吸声、说话声和咳嗽声的基于双向长短时记忆(BiLSTM)网络的COVID-19检测方法。分别通过不同的声学信号去训练网络,为三个任务建立单独的模型,将其参数进行平均以得到一个平均模型,然后将其用于每个任务的BiLSTM模型的初始化。

图5 DiCOVA诊断模型示意图(左)及有监督的预训练流程(右)[26]

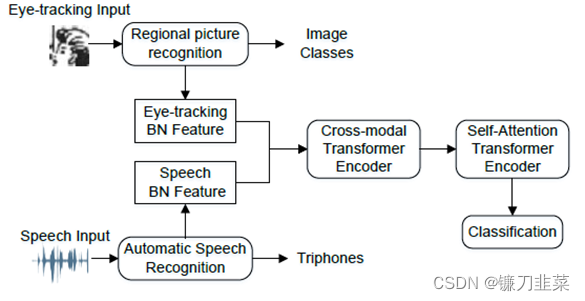

除此之外,Sheng等提出了一种融合语音和眼动信息进行痴呆检测的方法。首先,采用语音识别和区域图像识别模型提取受试者在图片描述任务中的语音和眼动特征。然后,采用深度学习融合两种模态的特征来判别痴呆患者和健康人群,包括用于特征融合的跨模态Transformer和最终分类的自注意力Transformer。

图6 一种融合语音和眼动信息的痴呆检测方法

四、 总结

在未来的研究中,一方面深入理解多模态语音识别的相关方法,并根据实际问题分析数据特点。当存在数据不足或者标签信息缺失时,考虑引入半监督的生成式对抗网络模型,通过将随机噪声映射到原始数据分布中,自动生成数据。另一方面探索基于OVBM的疾病检测方法在不同类型疾病中的应用模式,并将其与其他深度神经网络模型进行融合,进一步发展非侵入的疾病筛查方法。通过多模态语音生物标记物识别,提高医疗服务的信息化水平。

五、 参考文献

[1] G. Mark and Y. Steve, Application of Hidden Markov Models in Speech Recognition. now, 2008, p. 1.

[2] G. E. Dahl, D. Yu, L. Deng, and A. Acero, “Context-Dependent Pre-Trained Deep Neural Networks for Large-Vocabulary Speech Recognition,” IEEE Transactions on Audio, Speech, and Language Processing, vol. 20, no. 1, pp. 30-42, 2012, doi: 10.1109/TASL.2011.2134090.

[3] M. Mohri, F. Pereira, and M. Riley, “Speech Recognition with Weighted Finite-State Transducers,” Handbook of Speech Processing, 01/01 2008, doi: 10.1007/978-3-540-49127-9_28.

[4] A. Graves, A. Mohamed, and G. Hinton, “Speech recognition with deep recurrent neural networks,” in 2013 IEEE International Conference on Acoustics, Speech and Signal Processing, 26-31 May 2013 2013, pp. 6645-6649, doi: 10.1109/ICASSP.2013.6638947.

[5] H. Sak, A. Senior, and F. Beaufays, “Long short-term memory recurrent neural network architectures for large scale acoustic modeling,” Proceedings of the Annual Conference of the International Speech Communication Association, INTERSPEECH, pp. 338-342, 01/01 2014.

[6] K. Cho, B. Merrienboer, C. Gulcehre, F. Bougares, H. Schwenk, and Y. Bengio, “Learning Phrase Representations using RNN Encoder-Decoder for Statistical Machine Translation,” 06/03 2014, doi: 10.3115/v1/D14-1179.

[7] C.-C. Chiu et al., State-of-the-Art Speech Recognition with Sequence-to-Sequence Models. 2018, pp. 4774-4778.

[8] L. Dong, S. Xu, and B. Xu, “Speech-Transformer: A No-Recurrence Sequence-to-Sequence Model for Speech Recognition,” in 2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 15-20 April 2018 2018, pp. 5884-5888, doi: 10.1109/ICASSP.2018.8462506.

[9] I. Goodfellow et al., “Generative Adversarial Networks,” Advances in Neural Information Processing Systems, vol. 3, 06/10 2014, doi: 10.1145/3422622.

[10] Z. Zhang, J. Han, K. Qian, C. Janott, Y. Guo, and B. Schuller, “Snore-GANs: Improving Automatic Snore Sound Classification With Synthesized Data,” IEEE Journal of Biomedical and Health Informatics, vol. 24, no. 1, pp. 300-310, 2020, doi: 10.1109/JBHI.2019.2907286.

[11] V. Ramanarayanan, A. Lammert, H. Rowe, T. Quatieri, and J. Green, “Speech as a Biomarker: Opportunities, Interpretability, and Challenges,” Perspectives of the ASHA Special Interest Groups, vol. 7, pp. 1-8, 01/11 2022, doi: 10.1044/2021_PERSP-21-00174.

[12] J. Robin, J. Harrison, L. Kaufman, F. Rudzicz, W. Simpson, and M. Yancheva, “Evaluation of Speech-Based Digital Biomarkers: Review and Recommendations,” Digital Biomarkers, vol. 4, pp. 99-108, 10/01 2020, doi: 10.1159/000510820.

[13] J. Laguarta, F. Hueto, P. Rajasekaran, S. Sarma, and B. Subirana, Longitudinal Speech Biomarkers for Automated Alzheimer’s Detection. 2020.

[14] C.-C. Chiu et al., Speech Recognition for Medical Conversations. 2018, pp. 2972-2976.

[15] L. Palaniyappan, “More than a biomarker: could language be a biosocial marker of psychosis?,” npj Schizophrenia, vol. 7, no. 1, p. 42, 2021/08/31 2021, doi: 10.1038/s41537-021-00172-1.

[16] A. C. Trevino, T. F. Quatieri, and N. Malyska, “Phonologically-based biomarkers for major depressive disorder,” EURASIP Journal on Advances in Signal Processing, vol. 2011, no. 1, p. 42, 2011/08/16 2011, doi: 10.1186/1687-6180-2011-42.

[17] A. Graves, S. Fernández, F. Gomez, and J. Schmidhuber, Connectionist temporal classification: Labelling unsegmented sequence data with recurrent neural 'networks. 2006, pp. 369-376.

[18] W. Chan, N. Jaitly, Q. Le, and O. Vinyals, “Listen, attend and spell: A neural network for large vocabulary conversational speech recognition,” in 2016 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 20-25 March 2016 2016, pp. 4960-4964, doi: 10.1109/ICASSP.2016.7472621.

[19] A. Graves, Supervised Sequence Labelling with Recurrent Neural Networks. 2012.

[20] A. Vaswani et al., “Attention Is All You Need,” 06/12 2017.

[21] L. Xie and Z.-Q. Liu, “A coupled HMM approach to video-realistic speech animation,” Pattern Recognition, vol. 40, no. 8, pp. 2325-2340, 2007/08/01/ 2007, doi: https://doi.org/10.1016/j.patcog.2006.12.001.

[22] T. Afouras, J. S. Chung, A. Senior, O. Vinyals, and A. Zisserman, “Deep Audio-visual Speech Recognition,” IEEE Transactions on Pattern Analysis and Machine Intelligence, pp. 1-1, 2018, doi: 10.1109/TPAMI.2018.2889052.

[23] J. Han, Z. Zhang, Z. Ren, and B. Schuller, “Implicit Fusion by Joint Audiovisual Training for Emotion Recognition in Mono Modality,” in ICASSP 2019 - 2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 12-17 May 2019 2019, pp. 5861-5865, doi: 10.1109/ICASSP.2019.8682773.

[24] K. Qian et al., “Can Machine Learning Assist Locating the Excitation of Snore Sound? A Review,” IEEE Journal of Biomedical and Health Informatics, vol. 25, no. 4, pp. 1233-1246, 2021, doi: 10.1109/JBHI.2020.3012666.

[25] J. Laguarta, F. Hueto, and B. Subirana, “COVID-19 Artificial Intelligence Diagnosis Using Only Cough Recordings,” IEEE Open Journal of Engineering in Medicine and Biology, vol. 1, pp. 275-281, 2020, doi: 10.1109/OJEMB.2020.3026928.

[26] X.-Y. Chen, Q.-S. Zhu, J. Zhang, and L.-R. Dai, Supervised and Self-supervised Pretraining Based COVID-19 Detection Using Acoustic Breathing/Cough/Speech Signals. 2022.