学习目标:

- 论文StyleSwin

- 简单了解SwinTransfrmer和StyleGAN

- 吴恩达深度学习视频

学习内容:

- 具体了解StyleSwin的代码和结构

- 了解SwinTransformer的结构及Shifted Window

- 了解StyleGAN的结构

- 吴恩达深度学习视频

学习时间:

10.16-10.21

学习产出:

StyleSwin

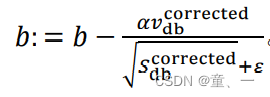

1、介绍

2、结构

-

生成器

左边:潜在向量z通过归一化后输入由8个全连接层组成的映射网络,然后输出潜在空间向量w,空间向量w经过仿射变换作为控制向量控制AdaIN的风格注入。

右边:输入4x4x512的常量特征图,经过绝对位置编码(正弦位置编码)进入基础层(StyleBasicLayer),输入到自适应归一化和残差连接,然后由A控制进行样式注入。特征图输入双注意力层(Double Attn),在Double Attn中有一个相对位置编码进行窗口定位,Double Attn中进行常规窗口(W-MSA)和移位窗口(SW-MSA)计算,计算完后特征图进入下一个自适应归一化和残差连接,进行风格注入,经过MLP层输出特征图。特征图经过上采样和绝对位置编码进入下一层。每次const和w进入Layer后会输出特征图输入到tRGB中输出一张RGB图像向后累加。最后,经过不断的上采样形成高分辨率的特征图,累加的RGB生成图片输出。 -

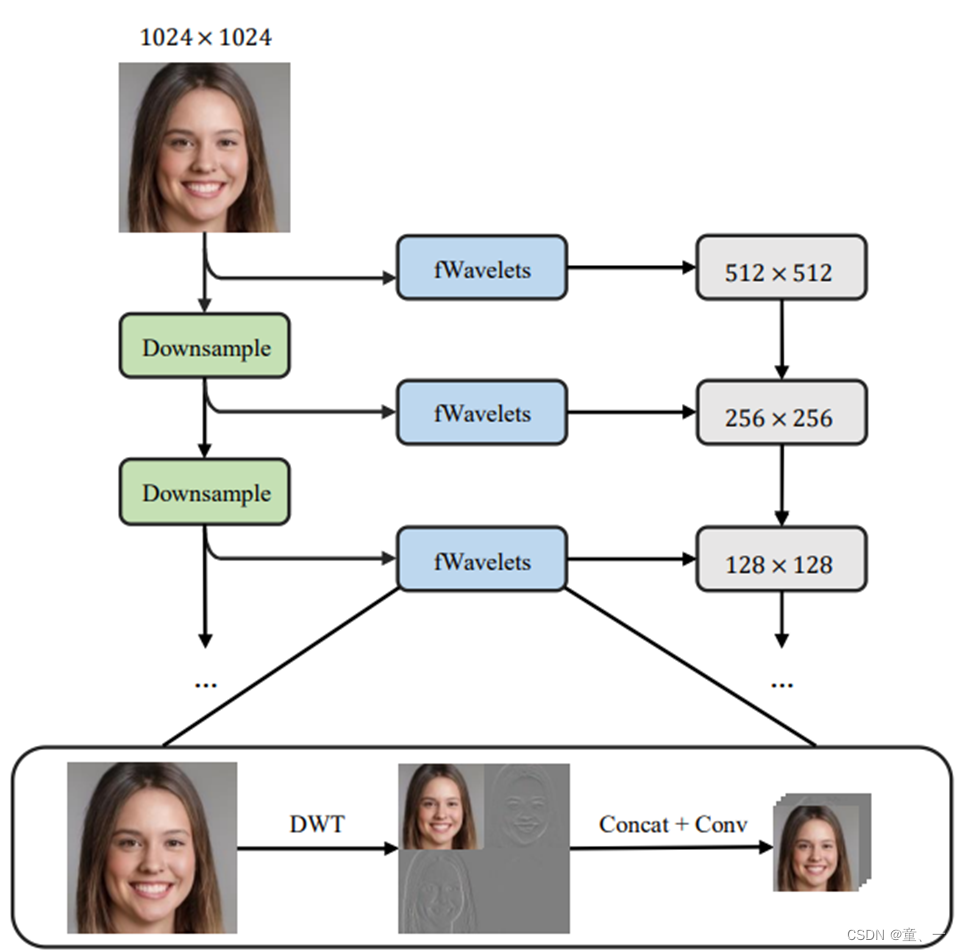

鉴别器

鉴别器采用SWAGAN论文中的鉴别器。

鉴别器核心是小波变换,将图像分解为一系列通道,每个通道代表不同范围的频率内容,使用Haar小波记录信息。图像通过一系列的低通和高通的小波滤波器被分为四个子带:LL,LH,HL,HH,并用作小波系数。

鉴别器会向每个块提供相应分辨率的小波系数,输入图像经过fWavelets(类似StyleGAN2的FromRGB)分解提取特征,将特征向下合并到更高分辨率派生的特征表示中。

Downsample:分散的图像通过IWT(逆小波变换)还原,使用双线性下采样后使用DWT(离散小波变换)继续提取特征。特征会送往下一层。

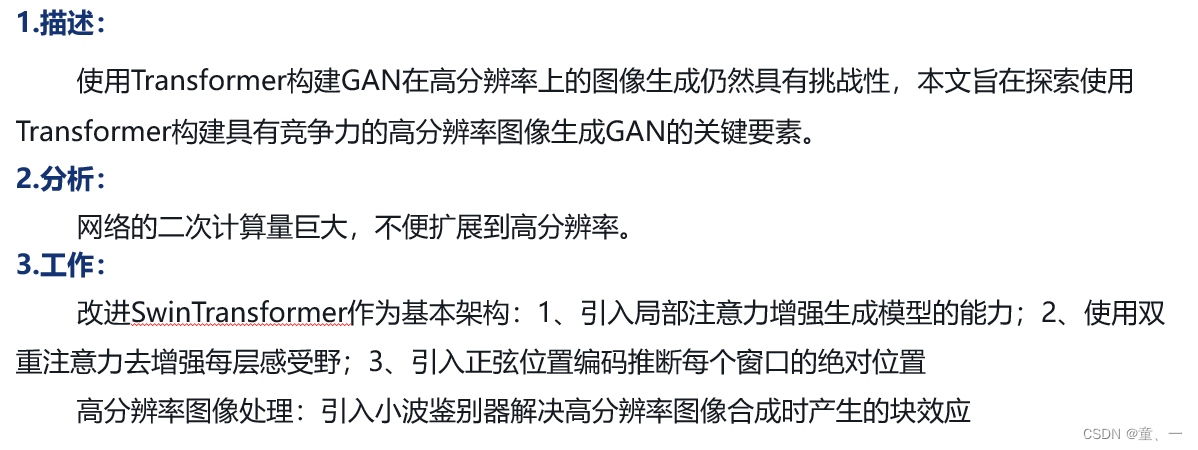

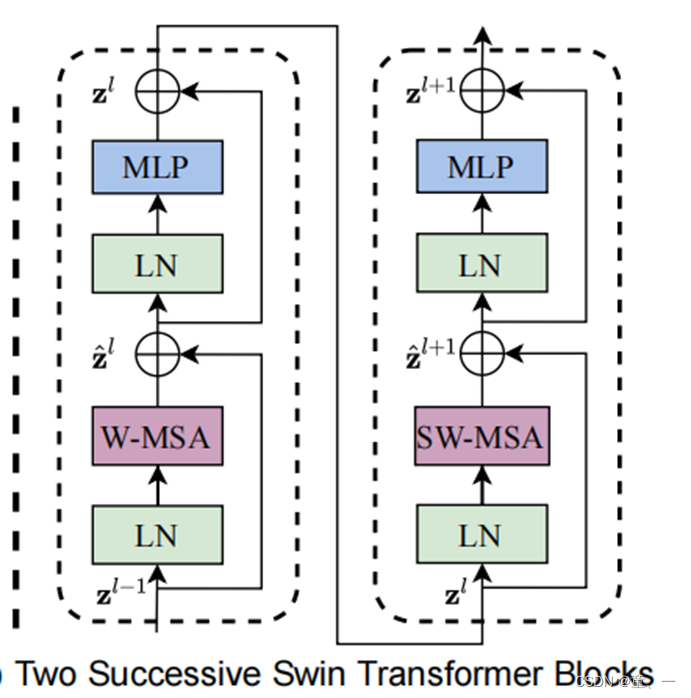

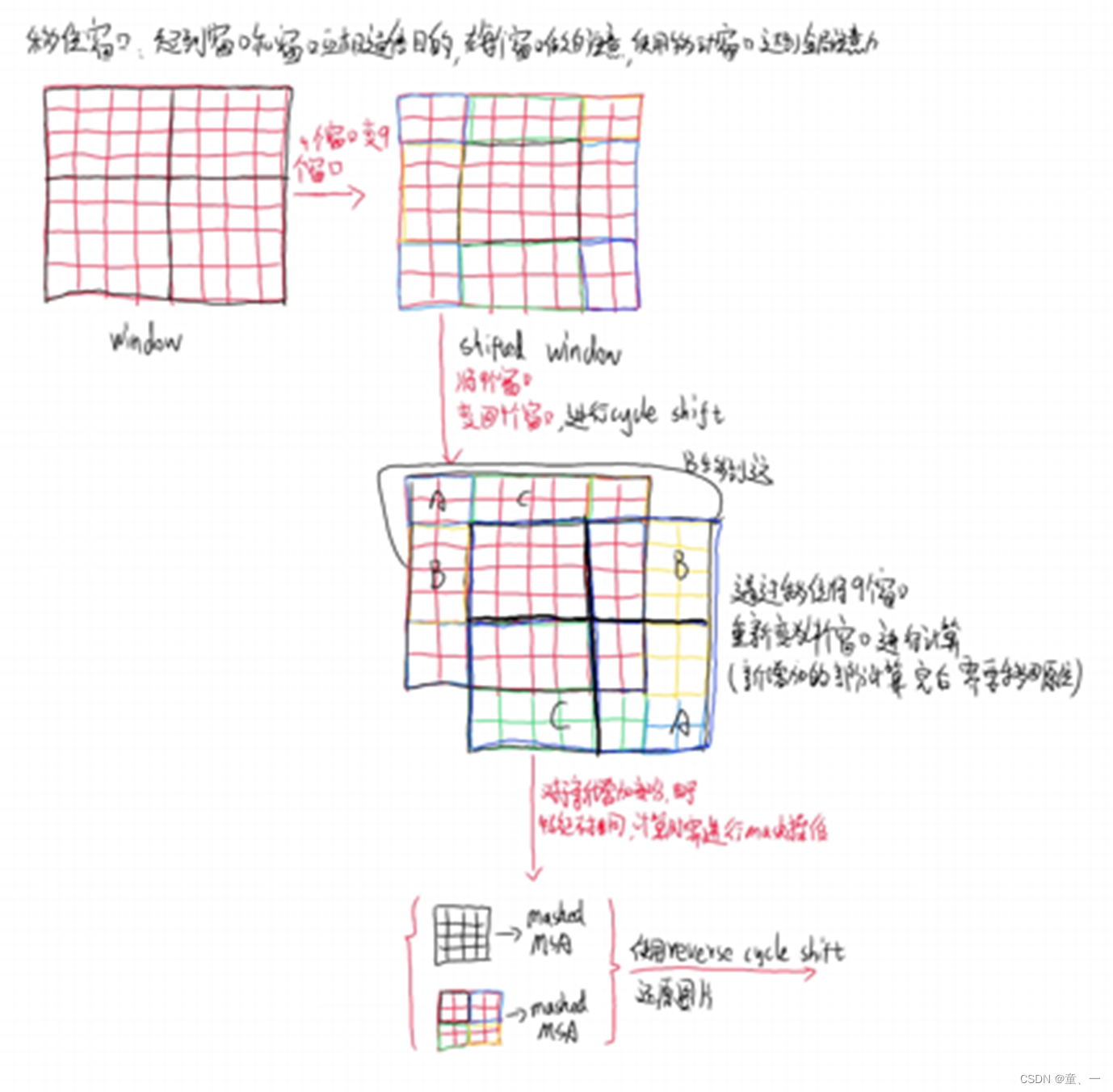

SwinTransformer

左边常规窗口注意力计算完后会送入右边的移位窗口进行注意力计算

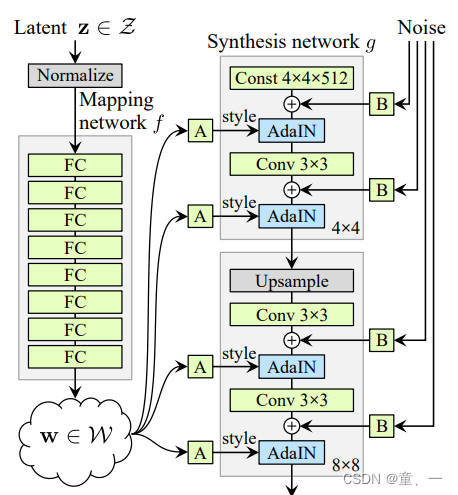

StyleGAN

简单了解了StyleGAN和StyleGAN2

StyleGAN:

1、加入了Mapping Network进行特征解耦

2、加入了样式模块AdaIN,将特征解耦后的中间向量𝑊′变换为样式控制向量,从而参与影响生成器的生成过程

3、删除传统输入:删除了最开始进入4*4的输入A,并用常量值代替

4、随机变化:在 AdaIN 模块之前向每个通道添加一个缩放过的噪声

深度学习

学习了优化算法、超参数调试和Batch正则化以及结构化机器学习

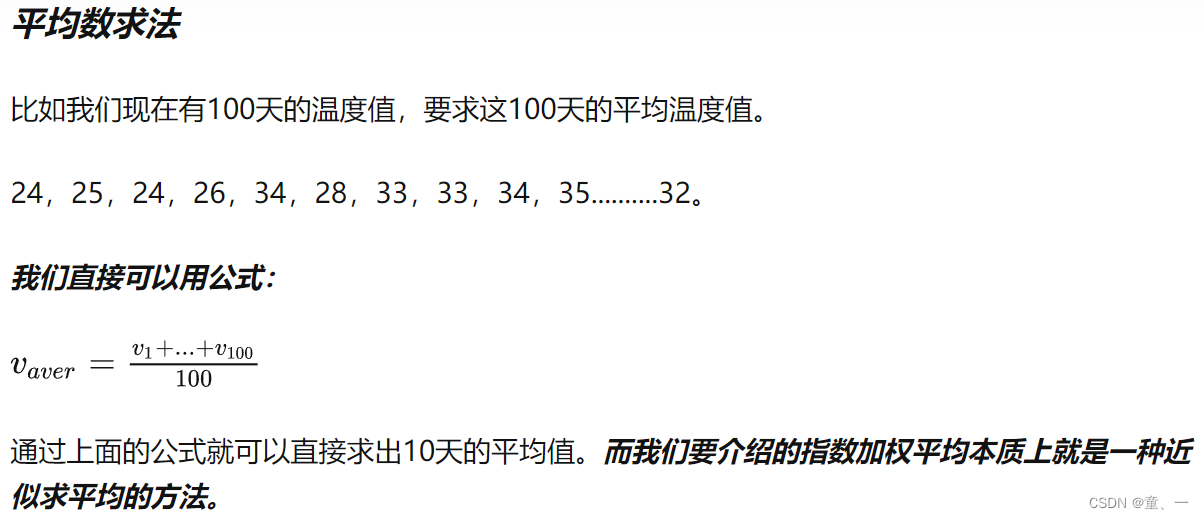

本质就是以指数式递减加权的移动平均。各数值的加权而随时间而指数式递减,越近期的数据加权越重,但较旧的数据也给予一定的加权。在指数加权平均的基础上引入动量梯度下降法。

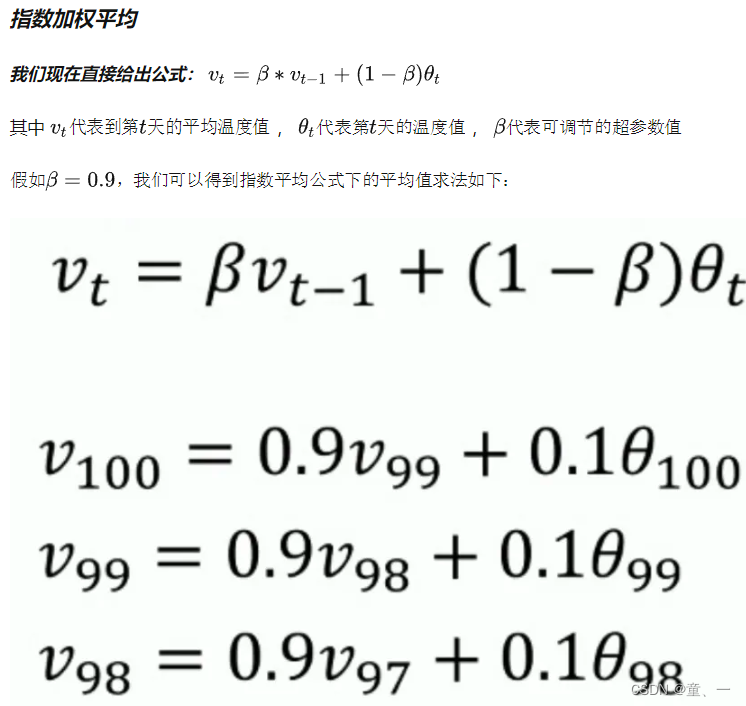

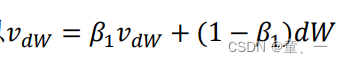

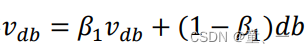

- 动量梯度下降法

使用梯度下降法进行迭代遇到的上下波动会减慢梯度下降法的速度,由此提出了动量梯度下降法减小上下波动并且加快移向最小值点的速度。

在mini-batch中计算:

𝑣𝑑𝑊 =𝛽𝑣𝑑𝑊 + (1 ? 𝛽)𝑑W

𝑣𝑑𝑏 = 𝛽𝑣𝑑𝑏 + (1 ? 𝛽)𝑑b

更新权重:

𝑊: = 𝑊 ?𝑎𝑣𝑑w

𝑏: = 𝑏 ? 𝑎𝑣𝑑b

有两个超参数,学习率𝑎以及参数𝛽,𝛽控制着指数加权平均数。𝛽常用的值是

0.9,当𝛽为0.9时就是平均了前十次迭代的梯度。 - RMSprop

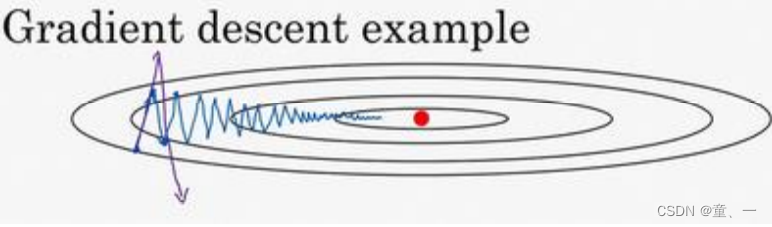

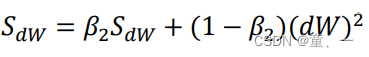

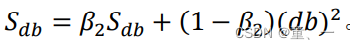

RMSprop 的算法,全称是 root mean square prop 算法,它也可以加速梯度下降。

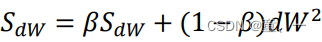

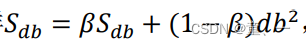

假设梯度下降的横轴代表参数W,纵轴代表参数b,为了加快梯度下降的速度需要减缓b而加快W,由此引入了指数加强平均的基础上的RMSprop算法

更新参数:

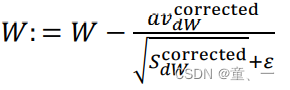

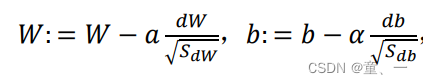

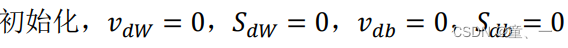

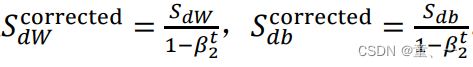

- Adam算法

Adam 优化算法基本上就是将 Momentum 和 RMSprop 结合在一起

用当前的 mini-batch 计算𝑑𝑊,𝑑b

计算 Momentum 指数加权平均数

用 RMSprop 进行更新

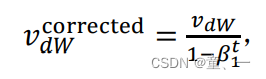

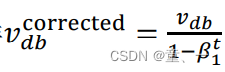

相当于 Momentum 更新了超参数𝛽1,RMSprop 更新了超参数𝛽2,然后计算偏差修正

更新W和b