概述

数字识别是计算机从纸质文档、照片或其他来源接收、理解并识别可读的数字的能力,目前比较受关注的是手写数字识别。手写数字识别是一个典型的图像分类问题,已经被广泛应用于汇款单号识别、手写邮政编码识别等领域,大大缩短了业务处理时间,提升了工作效率和质量。

在处理如 图1 所示的手写邮政编码的简单图像分类任务时,可以使用基于MNIST数据集的手写数字识别模型。MNIST是深度学习领域标准、易用的成熟数据集,包含50 000条训练样本和10 000条测试样本。

图1:手写数字识别任务示意图

- 任务输入:一系列手写数字图片,其中每张图片都是28x28的像素矩阵。

- 任务输出:经过了大小归一化和居中处理,输出对应的0~9的数字标签。

构建手写数字识别的神经网络模型

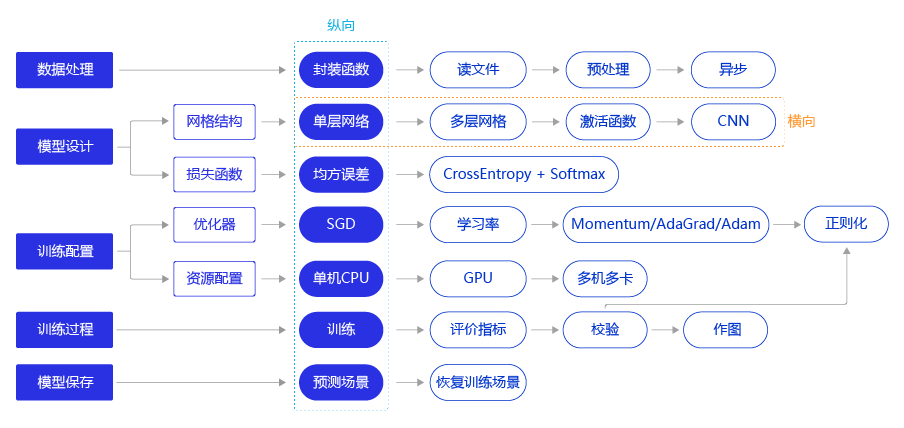

使用飞桨完成手写数字识别模型任务的代码结构如 图2 所示,与使用飞桨完成房价预测模型任务的流程一致,下面的我将详细介绍每个步骤的具体实现方法和优化思路。

图2:深度学习模型开发流程

读入数据并划分数据集

MNIST数据集是从NIST的Special Database 3(SD-3)和Special Database 1(SD-1)构建而来。Yann LeCun等人从SD-1和SD-3中各取一半数据作为MNIST训练集和测试集,其中训练集来自250位不同的标注员,且训练集和测试集的标注员完全不同。

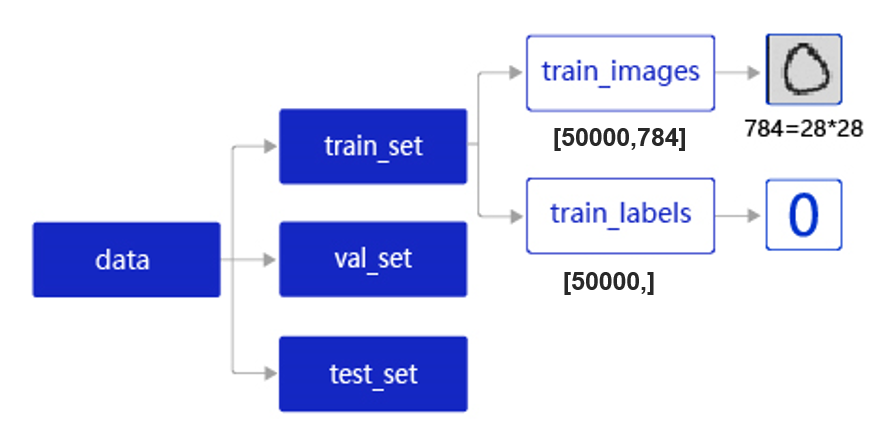

MNIST数据集以json格式存储在本地,其数据存储结构如 图3 所示。

图3:MNIST数据集的存储结构

data包含三个元素的列表:train_set、val_set、 test_set,包括50 000条训练样本、10 000条验证样本、10 000条测试样本。每个样本包含手写数字图片和对应的标签。

- train_set(训练集):用于确定模型参数。

- val_set(验证集):用于调节模型超参数(如多个网络结构、正则化权重的最优选择)。

- test_set(测试集):用于估计应用效果(没有在模型中应用过的数据,更贴近模型在真实场景应用的效果)。

train_set包含两个元素的列表:train_images、train_labels。

- train_images:[50 000, 784]的二维列表,包含50 000张图片。每张图片用一个长度为784的向量表示,内容是28*28尺寸的像素灰度值(黑白图片)。

- train_labels:[50 000, ]的列表,表示这些图片对应的分类标签,即0~9之间的一个数字。

在读取文件名称为mnist.json.gz的MNIST数据,并拆分成训练集、验证集和测试集,实现方法如下所示。

#数据处理部分之前的代码,加入部分数据处理的库

import paddle

from paddle.nn import Linear

import paddle.nn.functional as F

import os

import gzip

import json

import random

import numpy as np

# 声明数据集文件位置

datafile = './work/mnist.json.gz'

print('loading mnist dataset from {} ......'.format(datafile))

# 加载json数据文件

data = json.load(gzip.open(datafile))

print('mnist dataset load done')

# 读取到的数据区分训练集,验证集,测试集

train_set, val_set, eval_set = data

# 观察训练集数据

imgs, labels = train_set[0], train_set[1]

print("训练数据集数量: ", len(imgs))

# 观察验证集数量

imgs, labels = val_set[0], val_set[1]

print("验证数据集数量: ", len(imgs))

# 观察测试集数量

imgs, labels = val= eval_set[0], eval_set[1]

print("测试数据集数量: ", len(imgs))

# 打印

loading mnist dataset from ./work/mnist.json.gz ......

mnist dataset load done

训练数据集数量: 50000

验证数据集数量: 10000

测试数据集数量: 10000

训练样本乱序、生成批次数据

- 训练样本乱序: 先将样本按顺序进行编号,建立ID集合index_list。然后将index_list乱序,最后按乱序后的顺序读取数据。

说明:

通过大量实验发现,模型对最后出现的数据印象更加深刻。训练数据导入后,越接近模型训练结束,最后几个批次数据对模型参数的影响越大。为了避免模型记忆影响训练效果,需要进行样本乱序操作。

- 生成批次数据: 先设置合理的batch_size,再将数据转变成符合模型输入要求的np.array格式返回。同时,在返回数据时将Python生成器设置为

yield模式,以减少内存占用。

在执行如上两个操作之前,需要先将数据处理代码封装成load_data函数,方便后续调用。load_data有三种模型:train、valid、eval,分为对应返回的数据是训练集、验证集、测试集。

imgs, labels = train_set[0], train_set[1]

print("训练数据集数量: ", len(imgs))

# 获得数据集长度

imgs_length = len(imgs)

# 定义数据集每个数据的序号,根据序号读取数据

index_list = list(range(imgs_length))

# 读入数据时用到的批次大小

BATCHSIZE = 100

# 随机打乱训练数据的索引序号

random.shuffle(index_list)

# 定义数据生成器,返回批次数据

def data_generator():

imgs_list = []

labels_list = []

for i in index_list:

# 将数据处理成希望的类型

img = np.array(imgs[i]).astype('float32')

label = np.array(labels[i]).astype('float32')

imgs_list.append(img)

labels_list.append(label)

if len(imgs_list) == BATCHSIZE:

# 获得一个batchsize的数据,并返回

yield np.array(imgs_list), np.array(labels_list)

# 清空数据读取列表

imgs_list = []

labels_list = []

# 如果剩余数据的数目小于BATCHSIZE,

# 则剩余数据一起构成一个大小为len(imgs_list)的mini-batch

if len(imgs_list) > 0:

yield np.array(imgs_list), np.array(labels_list)

return data_generator

#打印

训练数据集数量: 50000

校验数据有效性

在实际应用中,原始数据可能存在标注不准确、数据杂乱或格式不统一等情况。因此在完成数据处理流程后,还需要进行数据校验,一般有两种方式:

- 机器校验:加入一些校验和清理数据的操作。

- 人工校验:先打印数据输出结果,观察是否是设置的格式。再从训练的结果验证数据处理和读取的有效性。

机器校验

如下代码所示,如果数据集中的图片数量和标签数量不等,说明数据逻辑存在问题,可使用assert语句校验图像数量和标签数据是否一致。

imgs_length = len(imgs)

assert len(imgs) == len(labels), \

"length of train_imgs({}) should be the same as train_labels({})".format(len(imgs), len(label))

封装数据读取与处理函数

上文,我们从读取数据、划分数据集、到打乱训练数据、构建数据读取器以及数据数据校验,完成了一整套一般性的数据处理流程,下面将这些步骤放在一个函数中实现,方便在神经网络训练时直接调用。

# 定义数据集读取器

# 定义数据集读取器

def load_data(mode='train'):

# 读取数据文件

datafile = './work/mnist.json.gz'

print('loading mnist dataset from {} ......'.format(datafile))

data = json.load(gzip.open(datafile))

# 读取数据集中的训练集,验证集和测试集

train_set, val_set, eval_set = data

# 数据集相关参数,图片高度IMG_ROWS, 图片宽度IMG_COLS

IMG_ROWS = 28

IMG_COLS = 28

# 根据输入mode参数决定使用训练集,验证集还是测试

if mode == 'train':

imgs = train_set[0]

labels = train_set[1]

elif mode == 'valid':

imgs = val_set[0]

labels = val_set[1]

elif mode == 'eval':

imgs = eval_set[0]

labels = eval_set[1]

# 获得所有图像的数量

imgs_length = len(imgs)

# 验证图像数量和标签数量是否一致

assert len(imgs) == len(labels), \

"length of train_imgs({}) should be the same as train_labels({})".format(

len(imgs), len(labels))

index_list = list(range(imgs_length))

# 读入数据时用到的batchsize

BATCHSIZE = 100

# 定义数据生成器

def data_generator():

# 训练模式下,打乱训练数据

if mode == 'train':

random.shuffle(index_list)

imgs_list = []

labels_list = []

# 按照索引读取数据

for i in index_list:

# 读取图像和标签,转换其尺寸和类型

img = np.reshape(imgs[i], [1, IMG_ROWS, IMG_COLS]).astype('float32')

label = np.reshape(labels[i], [1]).astype('int64')

imgs_list.append(img)

labels_list.append(label)

# 如果当前数据缓存达到了batch size,就返回一个批次数据

if len(imgs_list) == BATCHSIZE:

yield np.array(imgs_list), np.array(labels_list)

# 清空数据缓存列表

imgs_list = []

labels_list = []

# 如果剩余数据的数目小于BATCHSIZE,

# 则剩余数据一起构成一个大小为len(imgs_list)的mini-batch

if len(imgs_list) > 0:

yield np.array(imgs_list), np.array(labels_list)

return data_generator

设计卷积神经网络结构

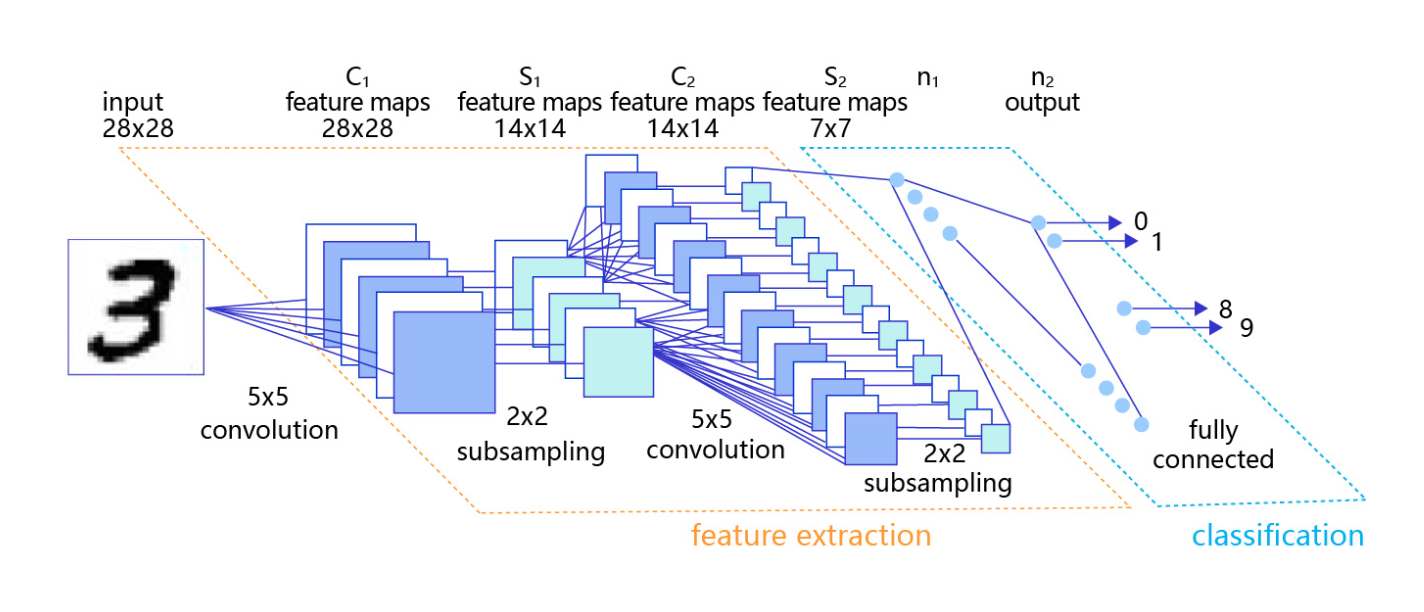

使用经典的全连接神经网络会导致输入数据丢失了图像像素间的空间信息,这影响了网络对图像内容的理解。对于计算机视觉问题,效果最好的模型仍然是卷积神经网络。卷积神经网络针对视觉问题的特点进行了网络结构优化,可以直接处理原始形式的图像数据,保留像素间的空间信息,因此更适合处理视觉问题。

卷积神经网络由多个卷积层和池化层组成,如 图4 所示。卷积层负责对输入进行扫描以生成更抽象的特征表示,池化层对这些特征表示进行过滤,保留最关键的特征信息。卷积层激活函数使用Relu,全连接层激活函数使用softmax。

图4:手写数字识别卷积神经网络

说明:

train_loader在每次迭代时的数据shape为[batch_size, 784],因此需要将该数据形式reshape为图像数据形式[batch_size, 1, 28, 28],其中第二维代表图像的通道数(在MNIST数据集中每张图片的通道数为1,传统RGB图片通道数为3)。

两层卷积和池化的神经网络实现如下所示。

# 定义模型结构

import paddle.nn.functional as F

from paddle.nn import Conv2D, MaxPool2D, Linear

# 多层卷积神经网络实现

class MNIST(paddle.nn.Layer):

def __init__(self):

super(MNIST, self).__init__()

# 定义卷积层,输出特征通道out_channels设置为20,卷积核的大小kernel_size为5,卷积步长stride=1,padding=2

self.conv1 = Conv2D(in_channels=1, out_channels=20, kernel_size=5, stride=1, padding=2)

# 定义池化层,池化核的大小kernel_size为2,池化步长为2

self.max_pool1 = MaxPool2D(kernel_size=2, stride=2)

# 定义卷积层,输出特征通道out_channels设置为20,卷积核的大小kernel_size为5,卷积步长stride=1,padding=2

self.conv2 = Conv2D(in_channels=20, out_channels=20, kernel_size=5, stride=1, padding=2)

# 定义池化层,池化核的大小kernel_size为2,池化步长为2

self.max_pool2 = MaxPool2D(kernel_size=2, stride=2)

# 定义一层全连接层,输出维度是10

self.fc = Linear(in_features=980, out_features=10)

# 定义网络前向计算过程,卷积后紧接着使用池化层,最后使用全连接层计算最终输出

# 卷积层激活函数使用Relu,全连接层激活函数使用softmax

def forward(self, inputs, label):

x = self.conv1(inputs)

x = F.relu(x)

x = self.max_pool1(x)

x = self.conv2(x)

x = F.relu(x)

x = self.max_pool2(x)

x = paddle.reshape(x, [x.shape[0], 980])

x = self.fc(x)

if label is not None:

acc = paddle.metric.accuracy(input=F.softmax(x), label=label)

return x, acc

else:

return x

分类任务的损失函数

在之前的方案中,我们复用了房价预测模型的损失函数-均方误差。从预测效果来看,虽然损失不断下降,模型的预测值逐渐逼近真实值,但模型的最终效果不够理想。究其根本,不同的深度学习任务需要有各自适宜的损失函数。我们以房价预测和手写数字识别两个任务为例,详细剖析其中的缘由如下:

- 房价预测是回归任务,而手写数字识别是分类任务,使用均方误差作为分类任务的损失函数存在逻辑和效果上的缺欠。

- 房价可以是大于0的任何浮点数,而手写数字识别的输出只可能是0~9之间的10个整数,相当于一种标签。

- 在房价预测的案例中,由于房价本身是一个连续的实数值,因此以模型输出的数值和真实房价差距作为损失函数(Loss)是符合道理的。但对于分类问题,真实结果是分类标签,而模型输出是实数值,导致以两者相减作为损失不具备物理含义。

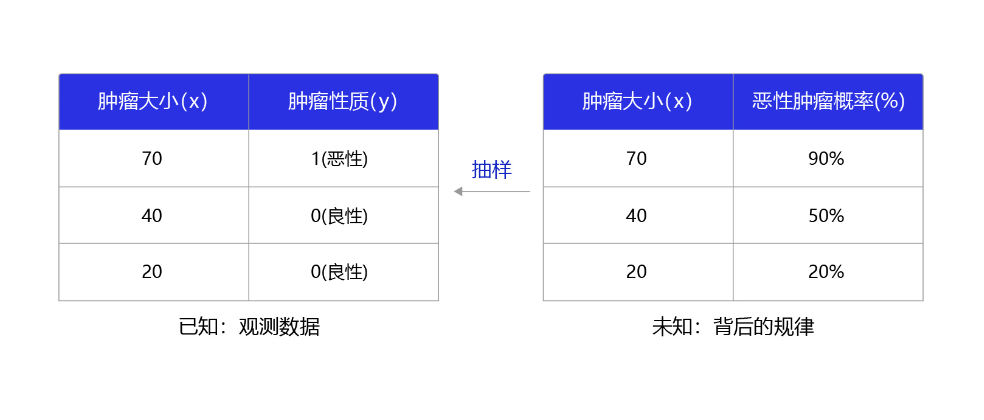

那么,什么是分类任务的合理输出呢?分类任务本质上是“某种特征组合下的分类概率”,下面以一个简单案例说明,如 图2 所示。

图2:观测数据和背后规律之间的关系

在本案例中,医生根据肿瘤大小 x x x作为肿瘤性质 y y y的参考判断(判断的因素有很多,肿瘤大小只是其中之一),那么我们观测到该模型判断的结果是 x x x和 y y y的标签(1为恶性,0为良性)。而这个数据背后的规律是不同大小的肿瘤,属于恶性肿瘤的概率。观测数据是真实规律抽样下的结果,分类模型应该拟合这个真实规律,输出属于该分类标签的概率。

交叉熵

在模型输出为分类标签的概率时,直接以标签和概率做比较也不够合理,人们更习惯使用交叉熵误差作为分类问题的损失衡量。

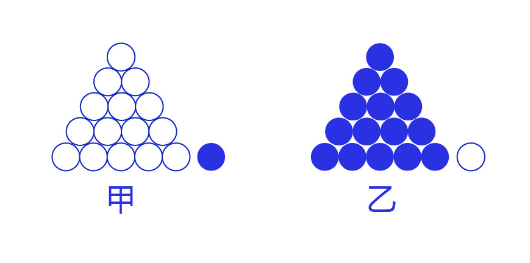

交叉熵损失函数的设计是基于最大似然思想:最大概率得到观察结果的假设是真的。如何理解呢?举个例子来说,如 图7 所示。有两个外形相同的盒子,甲盒中有99个白球,1个蓝球;乙盒中有99个蓝球,1个白球。一次试验取出了一个蓝球,请问这个球应该是从哪个盒子中取出的?

图7:体会最大似然的思想

相信大家简单思考后均会得出更可能是从乙盒中取出的,因为从乙盒中取出一个蓝球的概率更高 ( P ( D ∣ h ) ) (P(D|h)) (P(D∣h)),所以观察到一个蓝球更可能是从乙盒中取出的 ( P ( h ∣ D ) ) (P(h|D)) (P(h∣D))。 D D D是观测的数据,即蓝球白球; h h h是模型,即甲盒乙盒。这就是贝叶斯公式所表达的思想:

P ( h ∣ D ) ∝ P ( h ) ? P ( D ∣ h ) P(h|D) ∝ P(h) \cdot P(D|h) P(h∣D)∝P(h)?P(D∣h)

说明:

故意省略公式推导过程,减少大家看文章过程中的烦恼。

代码如下:

loss = F.cross_entropy(predicts, labels)

avg_loss = paddle.mean(loss)

设置学习率

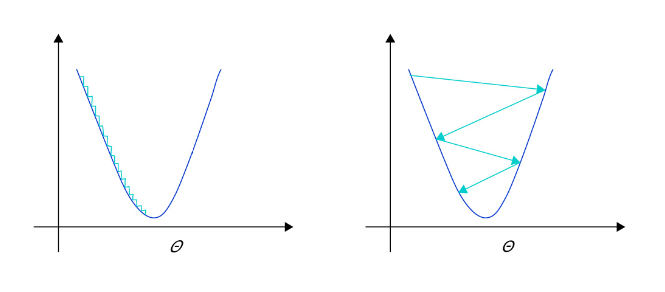

在深度学习神经网络模型中,通常使用标准的随机梯度下降算法更新参数,学习率代表参数更新幅度的大小,即步长。当学习率最优时,模型的有效容量最大,最终能达到的效果最好。学习率和深度学习任务类型有关,合适的学习率往往需要大量的实验和调参经验。探索学习率最优值时需要注意如下两点:

- 学习率不是越小越好。学习率越小,损失函数的变化速度越慢,意味着我们需要花费更长的时间进行收敛,如 图2 左图所示。

- 学习率不是越大越好。只根据总样本集中的一个批次计算梯度,抽样误差会导致计算出的梯度不是全局最优的方向,且存在波动。在接近最优解时,过大的学习率会导致参数在最优解附近震荡,损失难以收敛,如 图2 右图所示。

图2: 不同学习率(步长过大/过小)的示意图

在训练前,我们往往不清楚一个特定问题设置成怎样的学习率是合理的,因此在训练时可以尝试调小或调大,通过观察Loss下降的情况判断合理的学习率,设置学习率的代码如下所示。

学习率的主流优化算法

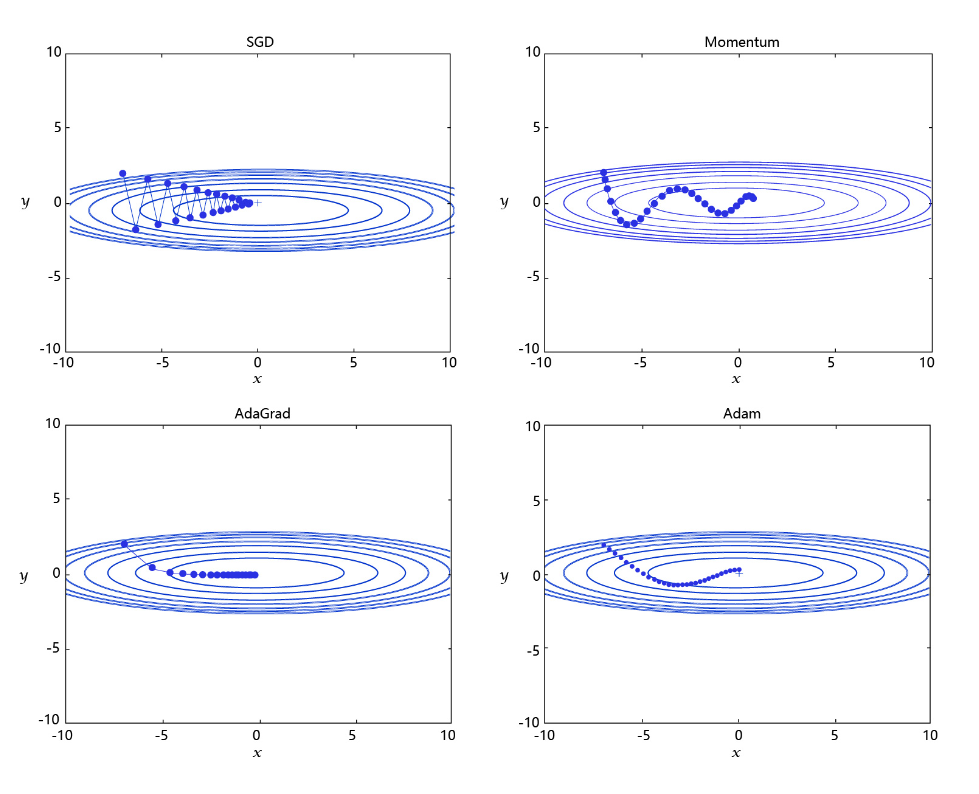

学习率是优化器的一个参数,调整学习率看似是一件非常麻烦的事情,需要不断的调整步长,观察训练时间和Loss的变化。经过研究员的不断的实验,当前已经形成了四种比较成熟的优化算法:SGD、Momentum、AdaGrad和Adam,效果如 图3 所示。

图3: 不同学习率算法效果示意图

每个批次的数据含有抽样误差,导致梯度更新的方向波动较大。如果我们引入物理动量的概念,给梯度下降的过程加入一定的“惯性”累积,就可以减少更新路径上的震荡,即每次更新的梯度由“历史多次梯度的累积方向”和“当次梯度”加权相加得到。历史多次梯度的累积方向往往是从全局视角更正确的方向,这与“惯性”的物理概念很像,也是为何其起名为“Momentum”的原因。类似不同品牌和材质的篮球有一定的重量差别,街头篮球队中的投手(擅长中远距离投篮)喜欢稍重篮球的比例较高。一个很重要的原因是,重的篮球惯性大,更不容易受到手势的小幅变形或风吹的影响。

- AdaGrad: 根据不同参数距离最优解的远近,动态调整学习率。学习率逐渐下降,依据各参数变化大小调整学习率。

通过调整学习率的实验可以发现:当某个参数的现值距离最优解较远时(表现为梯度的绝对值较大),我们期望参数更新的步长大一些,以便更快收敛到最优解。当某个参数的现值距离最优解较近时(表现为梯度的绝对值较小),我们期望参数的更新步长小一些,以便更精细的逼近最优解。类似于打高尔夫球,专业运动员第一杆开球时,通常会大力打一个远球,让球尽量落在洞口附近。当第二杆面对离洞口较近的球时,他会更轻柔而细致的推杆,避免将球打飞。与此类似,参数更新的步长应该随着优化过程逐渐减少,减少的程度与当前梯度的大小有关。根据这个思想编写的优化算法称为“AdaGrad”,Ada是Adaptive的缩写,表示“适应环境而变化”的意思。RMSProp是在AdaGrad基础上的改进,学习率随着梯度变化而适应,解决AdaGrad学习率急剧下降的问题。

- Adam: 由于动量和自适应学习率两个优化思路是正交的,因此可以将两个思路结合起来,这就是当前广泛应用的算法。

说明:

理论最合理的未必在具体案例中最有效,所以模型调参是很有必要的,最优的模型配置往往是在一定“理论”和“经验”的指导下实验出来的。

我们可以尝试选择不同的优化算法训练模型,观察训练时间和损失变化的情况,代码实现如下。

#四种优化算法的设置方案,可以逐一尝试效果

# opt = paddle.optimizer.SGD(learning_rate=0.01, parameters=model.parameters())

# opt = paddle.optimizer.Momentum(learning_rate=0.01, momentum=0.9, parameters=model.parameters())

# opt = paddle.optimizer.Adagrad(learning_rate=0.01, parameters=model.parameters())

opt = paddle.optimizer.Adam(learning_rate=0.01, parameters=model.parameters())

资源配置单GPU训练

通过paddle.device.set_device API,设置在GPU上训练还是CPU上训练。

paddle.device.set_device (device)

参数

device (str):此参数确定特定的运行设备,可以是cpu、 gpu:x或者是xpu:x。其中,x是GPU或XPU的编号。当device是cpu时, 程序在CPU上运行;当device是gpu:x时,程序在GPU上运行。

#在使用GPU机器时,可以将use_gpu变量设置成True

use_gpu = True

paddle.set_device('gpu:0') if use_gpu else paddle.set_device('cpu')

加入正则化项,避免模型过拟合

过拟合现象

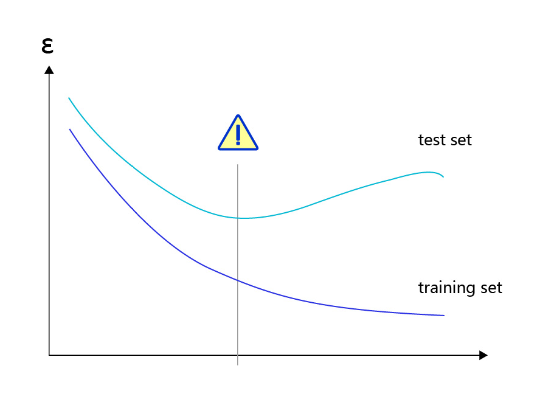

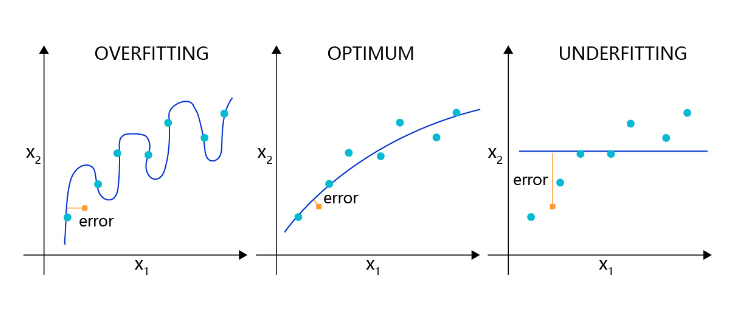

对于样本量有限、但需要使用强大模型的复杂任务,模型很容易出现过拟合的表现,即在训练集上的损失小,在验证集或测试集上的损失较大,如 图2 所示。

图2:过拟合现象,训练误差不断降低,但测试误差先降后增

反之,如果模型在训练集和测试集上均损失较大,则称为欠拟合。过拟合表示模型过于敏感,学习到了训练数据中的一些误差,而这些误差并不是真实的泛化规律(可推广到测试集上的规律)。欠拟合表示模型还不够强大,还没有很好的拟合已知的训练样本,更别提测试样本了。因为欠拟合情况容易观察和解决,只要训练loss不够好,就不断使用更强大的模型即可,因此实际中我们更需要处理好过拟合的问题。

导致过拟合原因

造成过拟合的原因是模型过于敏感,而训练数据量太少或其中的噪音太多。

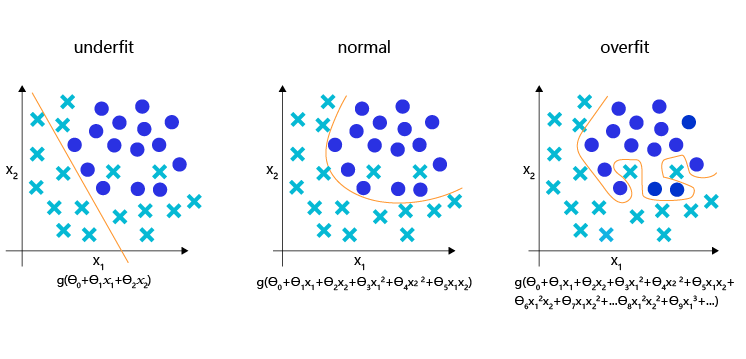

如图3 所示,理想的回归模型是一条坡度较缓的抛物线,欠拟合的模型只拟合出一条直线,显然没有捕捉到真实的规律,但过拟合的模型拟合出存在很多拐点的抛物线,显然是过于敏感,也没有正确表达真实规律。

图3:回归模型的过拟合,理想和欠拟合状态的表现

如图4 所示,理想的分类模型是一条半圆形的曲线,欠拟合用直线作为分类边界,显然没有捕捉到真实的边界,但过拟合的模型拟合出很扭曲的分类边界,虽然对所有的训练数据正确分类,但对一些较为个例的样本所做出的妥协,高概率不是真实的规律。

图4:分类模型的欠拟合,理想和过拟合状态的表现

正则化项

为了防止模型过拟合,在没有扩充样本量的可能下,只能降低模型的复杂度,可以通过限制参数的数量或可能取值(参数值尽量小)实现。

具体来说,在模型的优化目标(损失)中人为加入对参数规模的惩罚项。当参数越多或取值越大时,该惩罚项就越大。通过调整惩罚项的权重系数,可以使模型在“尽量减少训练损失”和“保持模型的泛化能力”之间取得平衡。泛化能力表示模型在没有见过的样本上依然有效。正则化项的存在,增加了模型在训练集上的损失。

飞桨支持为所有参数加上统一的正则化项,也支持为特定的参数添加正则化项。前者的实现如下代码所示,仅在优化器中设置weight_decay参数即可实现。使用参数coeff调节正则化项的权重,权重越大时,对模型复杂度的惩罚越高。

#各种优化算法均可以加入正则化项,避免过拟合,参数regularization_coeff调节正则化项的权重

opt = paddle.optimizer.Adam(learning_rate=0.01, weight_decay=paddle.regularizer.L2Decay(coeff=1e-5), parameters=model.parameters())

完整代码

def train(model):

model.train()

#各种优化算法均可以加入正则化项,避免过拟合,参数regularization_coeff调节正则化项的权重

opt = paddle.optimizer.Adam(learning_rate=0.01, weight_decay=paddle.regularizer.L2Decay(coeff=1e-5), parameters=model.parameters())

EPOCH_NUM = 5

for epoch_id in range(EPOCH_NUM):

for batch_id, data in enumerate(train_loader()):

#准备数据,变得更加简洁

images, labels = data

images = paddle.to_tensor(images)

labels = paddle.to_tensor(labels)

#前向计算的过程,同时拿到模型输出值和分类准确率

predicts, acc = model(images, labels)

#计算损失,取一个批次样本损失的平均值

loss = F.cross_entropy(predicts, labels)

avg_loss = paddle.mean(loss)

#每训练了100批次的数据,打印下当前Loss的情况

if batch_id % 200 == 0:

print("epoch: {}, batch: {}, loss is: {}, acc is {}".format(epoch_id, batch_id, avg_loss.numpy(), acc.numpy()))

#后向传播,更新参数的过程

avg_loss.backward()

opt.step()

opt.clear_grad()

#保存模型参数

paddle.save(model.state_dict(), 'mnist.pdparams')

model = MNIST()

train(model)

模型预测

# 读取一张本地的样例图片,转变成模型输入的格式

def load_image(img_path):

# 从img_path中读取图像,并转为灰度图

im = Image.open(img_path).convert('L')

im = im.resize((28, 28), Image.ANTIALIAS)

im = np.array(im).reshape(1, 1, 28, 28).astype(np.float32)

# 图像归一化

im = 1.0 - im / 255.

return im

# 定义预测过程

model = MNIST()

params_file_path = 'mnist.pdparams'

img_path = 'work/example_0.jpg'

# 加载模型参数

param_dict = paddle.load(params_file_path)

model.load_dict(param_dict)

# 灌入数据

model.eval()

tensor_img = load_image(img_path)

#模型反馈10个分类标签的对应概率

results = model(paddle.to_tensor(tensor_img))

#取概率最大的标签作为预测输出

lab = np.argsort(results.numpy())

print("本次预测的数字是: ", lab[0][-1])