原文链接:https://arxiv.org/pdf/2207.04802.pdf

相关博客:

【自然语言处理】【实体匹配】PromptEM:用于低资源广义实体匹配的Prompt-tuning

【自然语言处理】【知识图谱】利用属性、值、结构来实现实体对齐

【自然语言处理】【知识图谱】基于图匹配神经网络的跨语言知识图谱对齐

【自然语言处理】【知识图谱】使用属性嵌入实现知识图谱间的实体对齐

【自然语言处理】【知识图谱】用于实体对齐的多视角知识图谱嵌入

【自然语言处理】【知识图谱】MTransE:用于交叉知识对齐的多语言知识图谱嵌入

【自然语言处理】【知识图谱】SEU:无监督、非神经网络实体对齐超越有监督图神经网络?

一、简介

? 实体匹配

(Entity?Matching,EM)

\text{(Entity Matching,EM)}

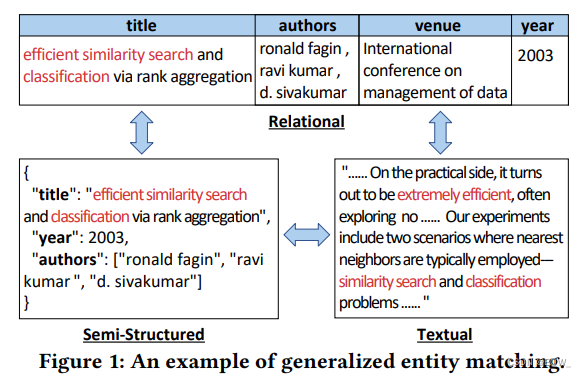

(Entity?Matching,EM)的目标是从两个结构化表中确定出两条记录是否指向相同的实体,该问题是数据管理中基础且重要的任务之一。现有的研究工作通常会假设两个表在schema上是同构的。然而,目前需要将实体匹配推广至更多的实际场景中。以上图的论文匹配为例,论文的元信息通常是存储在关系表或者半结构化的JSON对象中,而论文的描述信息则是文本类型。若要统一这两种类型数据的schema,需要在预处理的步骤中进行代价高昂的schema匹配。因此,传统的实体匹配并不能很好的支持论文匹配这样的实际场景。近期,

TDMatch

\text{TDMatch}

TDMatch试图匹配结构化数据和文本数据,但是该方法的可伸缩性非常差。为了支持更加实际的场景,本文研究了广义实体匹配

(Generalized?Entity?Matching,GEM)

\text{(Generalized Entity Matching,GEM)}

(Generalized?Entity?Matching,GEM),该匹配允许使用关系表、半结构化以及文本数据。

? 当前的 GEM \text{GEM} GEM方法都是有监督的,需要大量的标注数据,人力成本高昂。近期的研究使用预训练语言模型和微调范式实现了不错的效果,然后微调范式仍然需要一定量的高质量标注数据。 TDMatch \text{TDMatch} TDMatch通过创建图并使用随机游走来实现一种无监督的方法。然而,该方法的两个缺点限制了其在真实场景中的使用:(1) 缺乏标注数据,导致效果不稳定;(2) 随机游走不便于扩展至大规模数据集上,需要大量的执行时间和内存。因此,需要一个在低资源场景中,有效且高效的解决方案。

? 为了克服低资源的困境,半监督学习技术是一个很好的选择。自训练技术

(self-training)

\text{(self-training)}

(self-training)已经在序列生成和语言识别任务上取得了state-of-the-art。在自训练中,教师模型在标准数据上进行训练,然后在无标注数据上生成伪标签。原始的标注数据会使用伪标签进行增强,并用来训练学生模型。因此,大量的无标注数据可以被高效的利用,而且对于标注数据的需求也相应的减少。虽然自训练在需要应用上得到了非常好的效果,但是还没有在

GEM

\text{GEM}

GEM中应用。

? 基于上述的考虑,本文作者研究了如何在低资源 GEM \text{GEM} GEM上学习到高质量的模型。本文的目标是基于预训练语言模型开发一个有效且高效的低资源 GEM \text{GEM} GEM解决方案,其会通过自训练的方式来提高表现。该任务主要有三个挑战:

-

挑战一:对于 GEM \text{GEM} GEM来说如何调整预训练语言模型更好?

尽管微调范式在匹配问题上已经很成功,但是近期的研究发现,预训练目标的形式与微调目标的形式存在着较大的区别,这个区别限制了对语言模型中知识的利用。预训练将完型填空任务形式化为预测目标单词,而基于微调的方法会为不同的目标形式添加额外的层。对于 GEM \text{GEM} GEM,现有的方法将其作为分类任务,这阻碍了语言模型迁移。

-

挑战二:如何选择高质量的伪标签?

伪标签的质量决定了自训练是否能够改善效果。因此,伪标签选择策略非常的重要。一种常见的策略是使用置信度来选择伪标签。然而,这个策略有一些严重的缺点。一方面,在训练不好的模型中不正确的样本可能有非常高的分数。另一个方面,如果目标是教师模型的高置信度伪标签,那么学生模型的收益就非常少。

-

挑战三:如何避免昂贵的自训练?

传统的自训练代价高昂。具体来说,使用教师模型产生的伪标签来扩展标注数据,其能够带来好的表现,但是训练时间更长。直觉上,并不是所有的数据都能够提高学生模型的表现。然而,如何良好训练数据的重要性来避免昂贵的自训练仍然是一个挑战

? 为了解决上面的三个挑战,本文作者提出了低资源

GEM

\text{GEM}

GEM解决方案

PromptEM

\text{PromptEM}

PromptEM。

Prompt-tuning

\text{Prompt-tuning}

Prompt-tuning是自然语言处理中新的、有前景的范式,其能够解决预训练和微调目标函数间的区别。具体来说,本文设计了一种

GEM

\text{GEM}

GEM相关的prompt-tuning将

GEM

\text{GEM}

GEM转换为完型填空任务。因此,可以通过prompt-tuning来充分的利用语言模型中的知识。为了选择高质量的伪标签,本文还设计了一种轻量级的不确定性感知的自训练方法来改善效果。高质量的伪标签是改善自训练效果的前提。为了这个目的,作者利用近期的Bayesian深度学习来获得教师模型的不确定性估计,并改进自训练过程。为了避免自训练的昂贵,使用提出的

MC-EL2N

\text{MC-EL2N}

MC-EL2N来动态剪枝无用的训练数据。

? 总的来说,本文贡献如下:

- 低资源 GEM \text{GEM} GEM。这是第一个正式研究低资源 GEM \text{GEM} GEM的工作。作者在更实际场景中阐明了这个问题的重要性。

- 用于

GEM

\text{GEM}

GEM的

prompt-tuning。作者提出了 PromptEM \text{PromptEM} PromptEM,一个基于prompt-tuning的新 GEM \text{GEM} GEM解决方案,其将 GEM \text{GEM} GEM转换为完型填空任务。 - 通用的轻量级自训练。为了进一步改善低资源下的表现,作者开发了通用轻量级自训练方法,其使用不确定性来选择伪标签,并通过动态数据剪枝来使自训练更加的轻量级和有效。

- 大量的实验。在各种领域的8个真实数据集上进行了全面的实验。

二、用于 GEM \text{GEM} GEM的 Prompt?tuning \text{Prompt tuning} Prompt?tuning

1. Prompt模板

-

硬编码模板

对于硬编码模板的选择,这里不使用离散模板自动搜索方法,因为 GEM \text{GEM} GEM任务定义清晰并且

prompt比较容易确定。给定每个候选对 x = ( e , e ′ ) x=(e,e') x=(e,e′),会构造下面的模板:

T 1 ( x ) = serialize(e)?serialize ( e ′ ) ?They?are?[MASK] T_1(x)=\text{serialize(e) }\text{serialize}(e')\text{ They are [MASK]} T1?(x)=serialize(e)?serialize(e′)?They?are?[MASK]T 2 ( x ) = serialize(e)?is?[MASK]?to?serialize ( e ′ ) T_2(x)=\text{serialize(e)}\text{ is [MASK] to serialize}(e') T2?(x)=serialize(e)?is?[MASK]?to?serialize(e′)

-

连续模板

由于

prompt构造是寻找一个允许语言模型高效执行任务的方法,而不是用于人类使用,因此没有必要限制prompt为人类自然语言。所以,连续prompt被提出来在模型的嵌入层上直接执行prompting。本文作者利用 P-tuning \text{P-tuning} P-tuning,其在嵌入层中插入可训练变量来学习连续prompt tokens。 -

标签词袋

除了设计模板,另一个主要的组件是设计标签词袋。传统的 EM \text{EM} EM任务是寻找完全相同的实体对。然而, GEM \text{GEM} GEM可能需要找出满足一般二元关系的实体对。以论文匹配为例,目标是寻找元数据和摘要匹配的对。它们之间的关系是它们是否“相关”,要比“匹配”更一般的关系。考虑到一般的二元关系,将标签 y = y e s y=yes y=yes映射为集合 V y = { matched,similar,relevant } \mathcal{V}_y=\{\text{matched,similar,relevant}\} Vy?={matched,similar,relevant}。类似地,将标签 y = n o y=no y=no映射为集合 V y = { mismatched,different,irrelevant } \mathcal{V}_y=\{\text{mismatched,different,irrelevant}\} Vy?={mismatched,different,irrelevant}。

2. 训练和推断

? 通过prompt-tuning将分类问题转换为遮蔽语言建模问题。在遮蔽语言建模中,使用

V

y

\mathcal{V}_y

Vy?中所有单词的置信分数来构建特定类别

y

y

y的最终分数。给定一个候选对

x

x

x和其类别

y

y

y,条件概率的计算为:

p

(

y

∣

x

)

=

1

m

∑

j

m

P

(

[

M

A

S

K

]

=

w

j

∣

T

(

x

)

)

(1)

p(y|x)=\frac{1}{m}\sum_{j}^mP([MASK]=w_j|T(x)) \tag{1}

p(y∣x)=m1?j∑m?P([MASK]=wj?∣T(x))(1)

-

训练

连续

prompt tokens可以参数化为 ? \phi ?,并在训练时随着模型 M \mathcal{M} M优化。通过交叉熵损失函数 L = ? ∑ log ? P ( y ∣ x ; θ , ? ) \mathcal{L}=-\sum\log P(y|x;\theta,\phi) L=?∑logP(y∣x;θ,?)来优化带有额外prompt embeddings的预训练模型 M \mathcal{M} M。按如下步骤prompt-tune预训练语言模型:- 设计任务相关的

prompt模板和标签词集合; - 初始化带有连续

prompt tokens的预训练语言模型; - 在训练集上训练网络直至收敛;

- 设计任务相关的

-

推断

推断的目标是为输入分配一个标签,直接使用等式(1)来预测

[MASK]位置的单词,从而预测当前输入的类别。

三、轻量级自训练

1. 概览

? 令 D L = { ( x ( i ) , y ( i ) ) } i = 1 N L D_L=\{(x^{(i)},y^{(i)})\}_{i=1}^{N_L} DL?={(x(i),y(i))}i=1NL??和 D U = { x ( i ) } i = 1 N U D_U=\{x^{(i)}\}_{i=1}^{N_U} DU?={x(i)}i=1NU??分别是具有 N L N_L NL?个样本的标注数据集和 N U N_U NU?个样本的无标注数据集。本文的自训练目标是使用不确定性改善表现,并且通过动态数据剪枝实现比传统自训练更加的高效。下面的伪代码描述了轻量级自训练的过程。

算法1:轻量级自训练

输入:迭代数量 Iter \textbf{Iter} Iter、标注训练集 D L D_L DL?和无标注训练集 D U D_U DU?

输出:学生模型 M θ , ? \mathcal{M}_{\theta,\phi} Mθ,??

for i ← 1 i\leftarrow 1 i←1 to Iter do

??初始化新的教师模型 M t , θ , ? , i \mathcal{M}_{t,\theta,\phi,i} Mt,θ,?,i?

??for e p o c h ← 1 epoch\leftarrow 1 epoch←1 to 教师模型的epoch do

????使用训练集 D L D_L DL?训练模型 M t , θ , ? , i \mathcal{M}_{t,\theta,\phi,i} Mt,θ,?,i?

?? # 不确定性感知的伪标签选择

?? D p ← D_p\leftarrow Dp?←从 D U D_U DU?中选择的伪标签

?? D U ← D U ? D p D_U\leftarrow D_U-D_p DU?←DU??Dp?

?? D L ← D L ∪ D p D_L\leftarrow D_L\cup D_p DL?←DL?∪Dp?

??初始化新的学生模型 M s , θ , ? , i \mathcal{M}_{s,\theta,\phi,i} Ms,θ,?,i?

??for e p o c h ← 1 epoch\leftarrow 1 epoch←1 to 学习模型的epoch do

????使用训练集 D L D_L DL?训练模型 M s , θ , ? , i \mathcal{M}_{s,\theta,\phi,i} Ms,θ,?,i?

????# 动态数据剪枝

????if epoch mod 剪枝频率 = 0 then

?????? D D ← D_D\leftarrow DD?←从 D L D_L DL?中选择无用的样本

?????? D L ← D L ? D D D_L\leftarrow D_L-D_D DL?←DL??DD?

return 最优学生模型 M θ , ? \mathcal{M}_{\theta,\phi} Mθ,??

给定一个标注数据集

D

L

D_L

DL?,初始化教师模型

M

t

\mathcal{M}_t

Mt?并在

D

L

D_L

DL?上训练至收敛。然后教师模型

M

t

\mathcal{M}_t

Mt?在

D

U

D_U

DU?上产生伪标签。随后,作者引入了不确定性感知的伪标签选择策略来选择高质量伪标签

D

P

D_P

DP?。与此同时,

D

U

D_U

DU?和

D

L

D_L

DL?被更新。接下来,一个学生模型

M

s

\mathcal{M}_s

Ms?被初始化并在更新后的

D

L

D_L

DL?上训练。为了使自训练更加的轻量级和有效,这里使用一种动态数据剪枝策略,其能够在每个固定的epochs剪枝掉

D

L

D_L

DL?中无用的样本及其标签。最终返回在验证集上表现最好的学生模型。

2. 不确定性感知的伪标签选择

? 选择高质量的伪标签是改善自训练表示的前提条件。因此,本小节的目标是减少所选样本中的噪音来改善整体表现。选择伪标签最直接的方法是通过选择高置信度的样本。然而,不正确的预测在校准不良的网络中可能具有高的置信度。此外,如果教师模型预测的高置信度样本,那么这些样本对于学生模型来说收益很小。基于这些观察,预测的不确定性可以用来消除校准不良的影响,这里采用了一种不确定性感知的选择策略。正式来说,不确定性可以划分为epistemic uncertainty和aleatoric uncertainty。前者来说模型参数的不确定性,后者来自数据本身的不确定性。本文专注量epistemic uncertainty,使用

MC-Dropout

\text{MC-Dropout}

MC-Dropout来获得一个不确定性衡量,通过计算固定数量的随机正向传播的标准差。为了避免选择阈值,在计算

D

U

D_U

DU?的不确定性后,选择不确定性最小的样本:

D

P

=

{

(

x

(

i

)

,

y

~

(

i

)

)

}

i

=

1

N

P

=

Top-N

P

(

D

U

∣

?

u

(

i

)

)

(2)

D_P=\{(x^{(i)},\tilde{y}^{(i)})\}_{i=1}^{N_P}=\text{Top-N}_P(D_U|-u^{(i)}) \tag{2}

DP?={(x(i),y~?(i))}i=1NP??=Top-NP?(DU?∣?u(i))(2)

其中

N

P

=

N

U

?

u

r

N_P=N_U\cdot u_r

NP?=NU??ur?,

u

(

i

)

u^{(i)}

u(i)是样本的不确定性,

y

~

(

i

)

\tilde{y}^{(i)}

y~?(i)教师模型产生的伪标签,

u

r

u_r

ur?是伪标记样本的比例。不确定性估计的时间复杂度为

O

(

∣

N

P

∣

×

log

?

(

∣

N

U

∣

)

)

O(|N_P|\times\log(|N_U|))

O(∣NP?∣×log(∣NU?∣))。不确定性感知的伪标签选择使得自训练更加的高效。

3. 动态数据剪枝

? 随着训练集的增长会导致更长的训练时间,并使用自训练非常昂贵。近期,Paul et al.提出了

Error?L2-Norm(EL2N)

\text{Error L2-Norm(EL2N)}

Error?L2-Norm(EL2N)分数,其能够在训练的早期确定出重要的样本。换句话说,其能够在不牺牲测试准确率的情况下剪枝训练集中大量的无用样本。受

EL2N

\text{EL2N}

EL2N和

MC-Dropout

\text{MC-Dropout}

MC-Dropout的启发,本文合并这些方法提出了

MC-EL2N

\text{MC-EL2N}

MC-EL2N,其能够更加稳定的量化重要分数。正式来说,一个样本

(

x

,

y

)

(x,y)

(x,y)的

MC-EL2N

\text{MC-EL2N}

MC-EL2N分可以定义为

∑

i

=

1

n

∥

M

(

x

)

?

y

∥

2

n

\frac{\sum_{i=1}^n\parallel\mathcal{M}(x)-y\parallel_2}{n}

n∑i=1n?∥M(x)?y∥2??,其

n

n

n是随机前向传播的次数。类似的,为了避免选择阈值,在量化

D

L

D_L

DL?的重要性后,选择最小

MC-EL2N

\text{MC-EL2N}

MC-EL2N分数的

N

D

N_D

ND?个样本:

D

D

=

{

(

x

(

i

)

,

y

(

i

)

)

}

i

=

1

N

D

=

Top-N

D

(

D

L

∣

?

e

(

i

)

)

(3)

D_D=\{(x^{(i)},y^{(i)})\}_{i=1}^{N_D}=\text{Top-N}_D(D_L|-e^{(i)}) \tag{3}

DD?={(x(i),y(i))}i=1ND??=Top-ND?(DL?∣?e(i))(3)

其中

N

D

=

N

L

?

e

r

N_D=N_L\cdot e_r

ND?=NL??er?,

e

(

i

)

e^{(i)}

e(i)是样本的

MC-EL2N

\text{MC-EL2N}

MC-EL2N分数,

e

r

e_r

er?是标注样本的比例。类似于不确定性估计,这个过程的计算效率为

O

(

∣

N

D

∣

×

log

?

(

N

L

)

)

O(|N_D|\times\log (N_L))

O(∣ND?∣×log(NL?))。在每个固定的epochs使用动态数据剪枝来减掉无用的样本,使得自训练过程更加的轻量级和高效。

五、实验

1. 实验设置

1.1 数据集

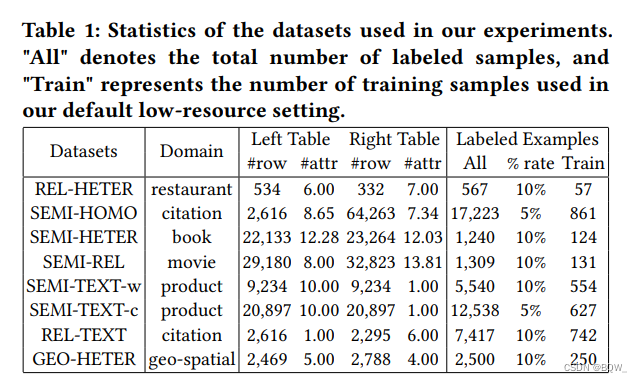

? 使用 Machamp \text{Machamp} Machamp中的7个真实世界的数据集和一个地理空间数据集 (GEO-HETER) \text{(GEO-HETER)} (GEO-HETER)。数据集的统计信息如上表。每个数据集由左、右两个表组成,这些数据集具有不同的格式。这里使用 r a t e % rate\% rate%的标注数据作为训练集,并使用同 Machamp \text{Machamp} Machamp相同的训练/验证/测试集划分。

1.2 Baselines

? 本文比较了 PromptEM \text{PromptEM} PromptEM和其余8个实体匹配方法,其中有三个方法 (Ditto,DADER,Rotom) \text{(Ditto,DADER,Rotom)} (Ditto,DADER,Rotom)在低资源实体匹配上有效, TDMatch \text{TDMatch} TDMatch是在结构化和文本数据上的无监督匹配方法。baselines包括:DeepMatcher、BERT、SentenceBERT、Ditto、DADER、Rotom、TDMatch。

1.3 实现细节

? 使用

Pytorch

\text{Pytorch}

Pytorch、

Transformers

\text{Transformers}

Transformers库和

OpenPrompt

\text{OpenPrompt}

OpenPrompt库来实现

PromptEM

\text{PromptEM}

PromptEM。使用

RoBERTa-base

\text{RoBERTa-base}

RoBERTa-base作为所有实验中模型的骨干。除非特别说明,所有实现都是在上表中的低资源设置下进行。使用半精度浮点

(fp16)

\text{(fp16)}

(fp16)优化来节约

GPU

\text{GPU}

GPU显存和运行时间。在所有的实验中,最大长度设置为512;学习率设置为2e-5;batch size设置为32;自训练的迭代次数设置为1;

MC-Dropout

\text{MC-Dropout}

MC-Dropout的传播次数设置为10。使用

AdamW

\text{AdamW}

AdamW作为训练的优化器,固定教师模型的训练epoch为20,学生模型的训练epoch为30。每8个epoch剪枝训练集。微调的超参数使用网格搜索并选择表现最好的一个。具体来说,连续模板从

{

T

1

(

?

)

,

T

2

(

?

)

}

\{T_1(\cdot),T_2(\cdot)\}

{T1?(?),T2?(?)}中选择,

u

r

u_r

ur?从

{

0.05

,

0.10

,

0.15

,

0.20

,

0.25

}

\{0.05,0.10,0.15,0.20,0.25\}

{0.05,0.10,0.15,0.20,0.25},

e

r

e_r

er?这从

{

0.1

,

0.2

,

0.3

,

0.4

,

0.5

}

\{0.1,0.2,0.3,0.4,0.5\}

{0.1,0.2,0.3,0.4,0.5}中选择。选择在验证集上

F1

\text{F1}

F1值最高的epoch,并报告其在测试集上的precision、recall和f1。所有的实验都是在一台机器:

Intel?Xeon?Silver?4216?CPU

\text{Intel Xeon Silver 4216 CPU}

Intel?Xeon?Silver?4216?CPU、

Nvidia?A100?GPU

\text{Nvidia A100 GPU}

Nvidia?A100?GPU和512G内存。使用相同的序列化方法实现每个baseline,并报告其在最优设置下的表现。

1.4 评估指标

? 评估指标使用precision(P)、recall(R)和F1(F)。

2. 主要结果

2.1 在默认低资源设置下的结果

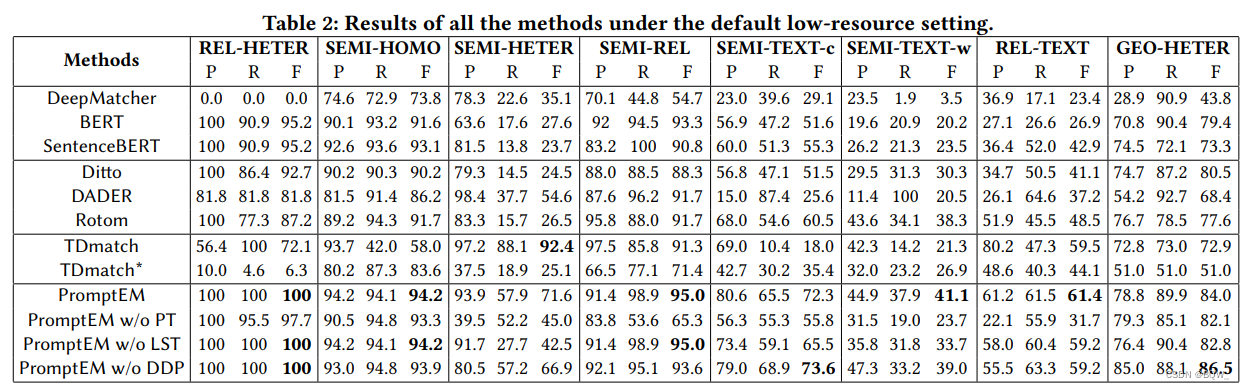

? 使用上面8个baseline来验证

PromptEM

\text{PromptEM}

PromptEM在低资源设置下的表现。所有方法在所有数据集上的结果如上表所示。DeepMatcher的效果最差,因为其不能利用近期的预训练语言模型。现有的低资源实体匹配方法Ditto、DADER和Rotom的效果相对较差,因为

GEM

\text{GEM}

GEM问题比传统实体匹配问题更加棘手。特别地,TDMatch由于缺乏标签指导,所以在不同数据集上不稳定,其在

SEMI-HETER

\text{SEMI-HETER}

SEMI-HETER取得了最高的F1值,但是在

SEMI-HETER-c

\text{SEMI-HETER-c}

SEMI-HETER-c上仅有18的F1值。

TDMatch

\text{TDMatch}

TDMatch在

SEMI-HETER

\text{SEMI-HETER}

SEMI-HETER上优于其他基于语言模型的方法。

SEMI-HETER

\text{SEMI-HETER}

SEMI-HETER有大量的数字属性,即53%的属性值是数值。众所周知,语言模型在数字上表现不好。此外,实验发现TDMatch极度的不稳定。

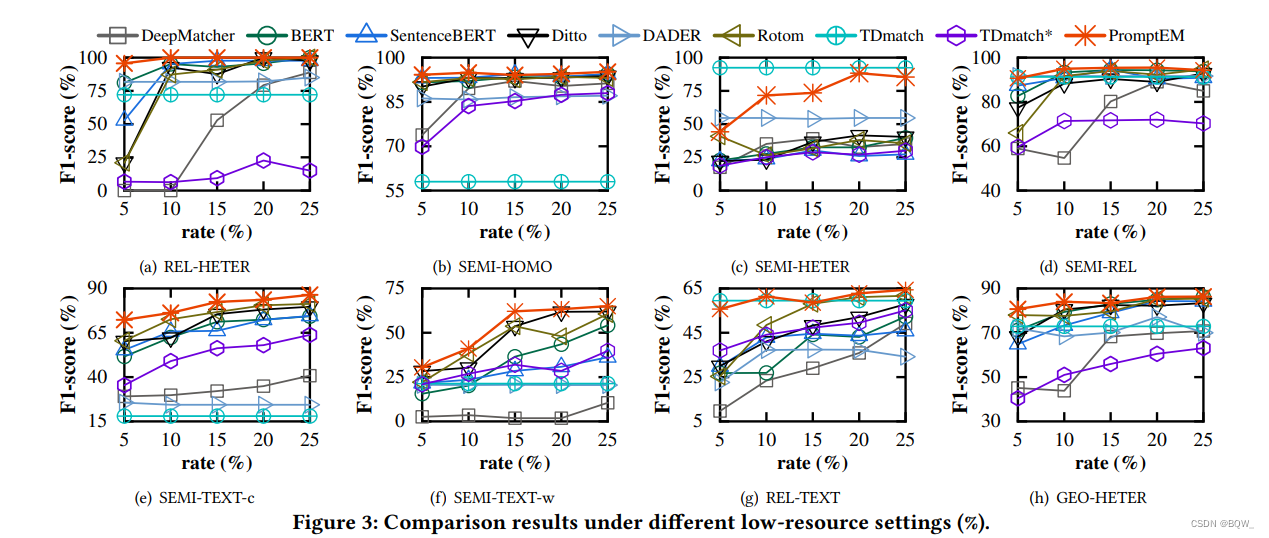

2.2 不同低资源设置的有效性

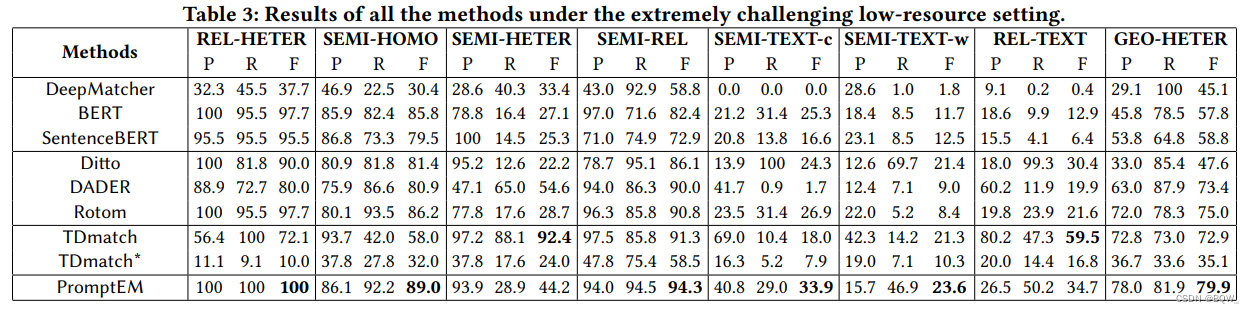

? 将训练集的比例从25%缩减至5%,从而观察不同低资源设置下的效果。实验结果如上图所示。可以发现 PromptEM \text{PromptEM} PromptEM在许多case中都实现了 SOTA \text{SOTA} SOTA,而 TDMatch \text{TDMatch} TDMatch和 DADER \text{DADER} DADER由于缺乏标注数据指导而不稳定。此外还评估了更具挑战性的设置,即在所有数据集上仅使用80个训练样本。这个设置对于监督方法极具挑战性,例如在 SEMI-HOMO \text{SEMI-HOMO} SEMI-HOMO中仅使用0.46%的标注样本。如下表所示, PromptEM \text{PromptEM} PromptEM在大多数数据集上实现了 SOTA \text{SOTA} SOTA,其表明了 PromptEM \text{PromptEM} PromptEM的成功。此外,这也显示了 PromptEM \text{PromptEM} PromptEM杰出的稳定性,其能够在少量标注数据下实现较好的表现。

? 总的来说,

PromptEM

\text{PromptEM}

PromptEM在各种低资源设置下几乎超过了所有的baselines。正如挑战一所示,预训练和微调的目标形式间存在显著区分。这个区别阻碍了语言模型中的知识迁移和适用,限制了语言模型中的知识利用。Prompt-tuning是自然语言处理中的新范式,其能够桥接预训练和微调。近期,prompt-tuning已经被应用在机器翻译、信息抽取、问答等大量任务。

3. 消融实验

? 接下来,作者研究了 PromptEM \text{PromptEM} PromptEM中每个模块的有效性。

3.1 Prompt-tuning实验

? 使用

PromptEM?w/o?PT

\text{PromptEM w/o PT}

PromptEM?w/o?PT表示微调模型,而不是使用prompt-tuning。可以看到使用prompt-tuning为提升表现贡献巨大。在低资源设置下平均F1值下降15.7%。可以确信prompt-tuning有助于利用语言模型中的丰富知识。

3.2 轻量级自训练实验

? 使用轻量级自训练来改善低资源下的表现,并使用 PromptEM?w/o?LST \text{PromptEM w/o LST} PromptEM?w/o?LST表示不使用轻量级自训练。可以看到轻量级自训练能够在大多数的cases中改善表现。例如,在 SEMI-TEXT-c \text{SEMI-TEXT-c} SEMI-TEXT-c上带来6.8%的表现。需要注意,轻量级自训练在一些数据集上的改善相对较小。这是因为数据集本身, PromptEM \text{PromptEM} PromptEM相对容易在数据集上实现非常高的效果。

3.3 动态数据剪枝实验

? 可以观察到,动态数据剪枝可以在不牺牲测试准确率的情况下删除无用的训练数据。值得注意的是,动态数据剪枝能够剪枝训练数据,并在一些数据集上改善测试准确率。这是因为动态数据剪枝使模型专注在重要且有用的训练数据。

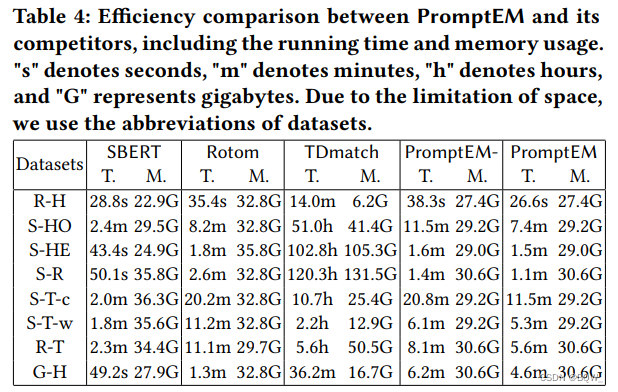

4. 效率分析

? 进一步在训练时间和内存使用上探索 PromptEM \text{PromptEM} PromptEM的有效性,结果如上表所示。因为使用类似策略来评估测试集上 GEM \text{GEM} GEM很常见,所以不报告每个评估方法的测试时间。 SBERT \text{SBERT} SBERT表示 SentenceBERT \text{SentenceBERT} SentenceBERT, PromptEM- \text{PromptEM-} PromptEM-表示不使用动态数据剪枝的 PromptEM \text{PromptEM} PromptEM。

4.1 PromptEM \text{PromptEM} PromptEM与最优baseline

? 由于篇幅所限,仅报告在 GEM \text{GEM} GEM中取得最优效果的其他方法与 PromptEM \text{PromptEM} PromptEM,即正常实体匹配方法 SBERT \text{SBERT} SBERT、低资源实体匹配方法 Rotom \text{Rotom} Rotom和无监督匹配方法 TDMatch \text{TDMatch} TDMatch。报告 GPU \text{GPU} GPU方法在 GPU \text{GPU} GPU上的显存, CPU \text{CPU} CPU方法在 CPU \text{CPU} CPU上的内存。可以看到, PromptEM \text{PromptEM} PromptEM需要比 SBERT \text{SBERT} SBERT更多的训练时间。这证明了 GEM \text{GEM} GEM问题在有效性和高效性间的权衡。总的来说,花费相对长的时间实现更好的匹配结果。 SBERT \text{SBERT} SBERT、 Rotom \text{Rotom} Rotom和 PromptEM \text{PromptEM} PromptEM需要相似的内存使用,因为都是基于语言模型的。需要强调的是, TDMatch \text{TDMatch} TDMatch需要更多的训练时间和内存使用,特别是在相对大的数据集。

4.2 PromptEM \text{PromptEM} PromptEM与 PromptEM- \text{PromptEM-} PromptEM-

? 本文也比较了 PromptEM \text{PromptEM} PromptEM和 PromptEM- \text{PromptEM-} PromptEM-来评估动态数据剪枝的有效性。可以观察到,动态数据剪枝非常有助于减少训练时间,即评估减少26.1%的训练时间。这是因为题材的 MC-EL2N \text{MC-EL2N} MC-EL2N能够量化训练数据中的无用样本。此外,动态数据剪枝不需要额外的内存使用,因为不需要任何新模型参数。动态数据剪枝不伤害效果。