目录

前言

机器学习模型要想能够很好的应用,必须要能够学会调整超参数,在训练中找到最适合的超参数,本文以前文曾讲过的线性回归为例,来进行学习超参数的调整与作图的实现,即可视化。

方法一:for循环观察超参数变化

首先训练一个线性回归模型,是一个很简单的关于员工工龄与对应薪水之间关系的预测,注意for循环中的两行代码,即输出w0,w1和loss的变化过程,那么便可通过观察三个参数的变化来动态调整这循环迭代次数times和学习率lrate。

# 线性回归的实现

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

# 样本数据 员工工龄x对应薪水y

x=np.array([0.5, 0.6, 0.8, 1.1, 1.4])

y=np.array([5.0, 5.5, 6.0, 6.8, 7.0])

# 基于梯度下降算法,不断更新w0和w1,从而找到最佳的模型参数

# 设定超参数

w0,w1,lrate=1,1,0.01 # lrate代表学习率

times=1000 # times表示迭代次数

# 循环求模型的参数

for i in range(times):

# 输出每一轮运算过程中,w0、w1、1oss的变化过程:

loss=((w0+w1*x-y)**2).sum()/2

print('{:4}, w0:{:.8f}, w1:{:.8f}, loss:{:.8f}'.format(i+1,w0,w1,loss))

# 计算w0和W1方向上的偏导数,代入模型参数的更新公式

d0=(w0+w1*x-y).sum()

d1=(x*(w0+w1*x-y)).sum()

# 更新w0和w1

w0=w0-lrate*d0

w1=w1-lrate*d1

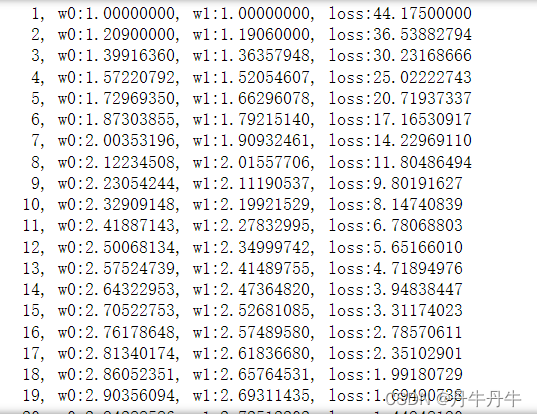

输出结果如下图,可观察到随着w0和w1的变化,损失值loss在变小,这说明目前的超参数设置是可以的,但我们还可以继续对循环迭代次数times和学习率lrate进行调整,比如观察到次数不需要很多就能达到理想效果便可以减少迭代次数,而感觉损失值还比较大,那也可以增加迭代次数看看是否能更进一步。

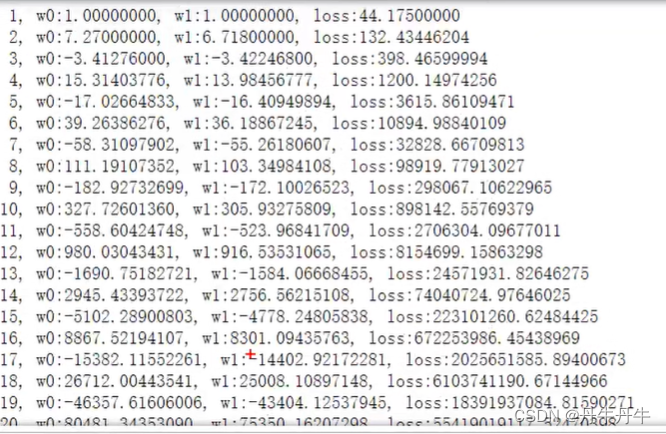

类似的可以对学习率也进行调整,学习率代表的是步长,学习率调大可能会加速损失值的下降,这利于减少迭代次数,但有可能步长设置过大导致损失值下降后反而又上升了,也就是迈过了最低点,就错过了极值点。?比如我们将学习率lrate调整至0.3,结果如下,代表着步长太大,loss值不降反而上升。

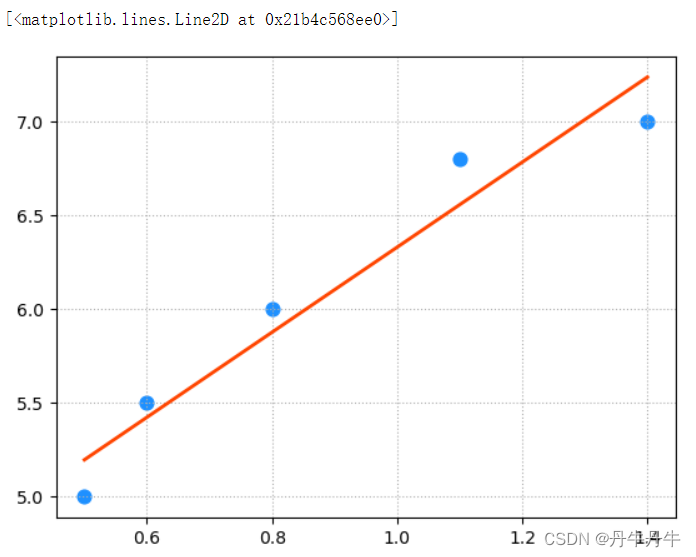

?当然也可以绘制出样本点回归线,通过图上观察大致的拟合效果,只是这样可能不太精确。

# 绘制样本点

plt.grid(linestyle=':')

plt.scatter(x,y,s=60,color='dodgerblue',label='Samples')

# 绘制回归线

pred_y=w0+w1*x

plt.plot(x,pred_y,color='orangered',linewidth=2,label='Regression Line')?输出结果如下图

方法二:超参数的可视化

在实际一个业务场景的应用中,要相对超参数进行设置,最好的方法是可视化。即x轴代表迭代次数,y轴代表随着迭代次数的变化,w0,w1和loss值都会怎么变化,我们希望看到怎样的变化趋势,就可以根据图像去调整超参数lrate和times。

# 超参数可视化

# 设定超参数

w0,w1,lrate=1,1,0.01 # lrate代表学习率

times=1000 # times表示迭代次数

# 设置四个list,epoches代表迭代轮数作为x轴,w0s,w1s,w2s作为y轴

w0s,w1s,losses,epoches=[],[],[],[]

# 循环求模型的参数

for i in range(times):

# 计算损失值

loss=((w0+w1*x-y)**2).sum()/2

# 把变量存入各个列表中

epoches.append(i+1)

w0s.append(w0)

w1s.append(w1)

losses.append(loss)

# 计算w0和W1方向上的偏导数,代入模型参数的更新公式

d0=(w0+w1*x-y).sum()

d1=(x*(w0+w1*x-y)).sum()

# 更新w0和w1

w0=w0-lrate*d0

w1=w1-lrate*d1

# 把三个参数变化画成一个子图

plt.subplot(3,1,1)

plt.grid(linestyle=':')

plt.ylabel('w0')

plt.plot(epoches,w0s,color='dodgerblue',label='w0')

plt.legend()

plt.subplot(3,1,2)

plt.grid(linestyle=':')

plt.ylabel('w1')

plt.plot(epoches,w1s,color='dodgerblue',label='w1')

plt.legend()

plt.subplot(3,1,3)

plt.grid(linestyle=':')

plt.ylabel('loss')

plt.plot(epoches,losses,color='orangered',label='loss')

plt.legend()输出的可视化结果如下图,可观察到在设定好学习率的情况下,损失值是逐渐下降的。

而如果我们将学习率lrate设置为0.5,再循环个100轮,便能发现损失值是后面在飞速上升,这就是典型的梯度爆炸,就不符合我们的预期,便需要对参数进行调整

?

?