PointSIFT:一个3D 点云语义分割的类 SIFT 网络模块

原文:PointSIFT: A SIFT-like Network Module for 3D Point Cloud Semantic Segmentation

摘要

近年来,3D语义理解研究为直接从点云中提取特征提供了新的思路1,2,这就需要对点云进行有效的形状模式描述。受出色的2D形状特征描述子SIFT的启发3,我们设计了一个名为PointSIFT的模块,该模块对不同方向的信息进行编码,并适应形状的比例。具体而言,设计了一个方向编码单元来描述八个关键方向,并通过堆叠多个方向编码单元来实现多尺度表示。PointSIFT模块可以集成到各种基于PointNet的体系结构中,以提高表示能力。大量实验表明,我们基于PointSIFT的框架在标准基准数据集上优于最先进的方法。代码和训练模型将与本文一起发布。

1. 引言

3D点云语义理解是一个长期存在的问题。典型任务包括3D目标分类4、3D目标检测5,6,7和3D语义分割1,2,8。在这些任务中,将语义标签分配给点的3D语义分割相对具有挑战性。首先,点云在三维空间中的稀疏性使得大多数空间算子效率低下。此外,由于点云的无序和非结构化特性,点与点之间的关系不明显且难以表示。回顾以往的工作,已经提出了几条解决方案来解决这个问题。在手工绘制的体素特征用于建模几何关系9,在2D中,从RGBD图像中提取CNN特征10。此外,2D卷积和3D卷积之间存在一个两难问题:2D卷卷积无法捕获三维几何信息,如法线和形状,而3D卷积需要大量计算。

最近,PointNet架构1直接在点云上运行,而不是3D体素网格或网格。它不仅加快了计算速度,而且显著提高了分割性能。在本文中,我们还研究了原始点云。我们从成功的特征检测算法——尺度不变特征变换(SIFT)3中得到了启发,该算法涉及两个关键特性:尺度感知和方向编码。相信这两个属性也会有利于3D形状描述,我们设计了一个新的模块,名为PointSIFT,用于3D语义理解,该模块具有这些属性。PointSIFT的主要思想如图 1 所示。与使用手工特征的SIFT算法不同,我们的PointSIFT是一个参数化深度学习模块,可以优化并适应点云分割。

PointSIFT模块的基本构建块是一个方向编码(OE)单元,它在8个方向上对最近点的特征进行卷积。与PointNet++2中K个邻居可能位于一个方向的K最近邻搜索算法相比,我们的OE单元能够捕获所有方向的信息。我们进一步将几个OE单元堆叠在一个PointSIFT模块中,以表示不同的尺度。为了使整个架构(architecture)能够尺度感知,我们通过shortcuts连接这些OE单元,并 jointly optimize 自适应尺度。我们的PointSIFT模块接收每个点具有n个特征的点云,并输出具有更好表示能力的n个特征点。PointSIFT是一个通用模块,可集成到各种基于PointNet的架构中,以改进3D形状表示。

我们进一步构建了一个层次结构,递归地应用PointSIFT模块作为局部特征描述子。与2D11和3D2中的传统分割框架类似,我们的两阶段网络首先对点云进行下采样以进行有效计算,然后进行上采样以获得密集预测。PointSIFT模块被用于整个框架的每一层,显著提高了网络的表示能力。

实验结果表明,基于PointSIFT模块的体系结构在S3DIS12(相对提高12%)和ScanNe13t数据集(相对提高8.4%的平均IoU)上优于最先进的方法。

2. 相关工作

3D数据的深度学习是一个正在不断发展的研究领域。我们研究了几种重要3D表示的分割方法。更详细地讨论了点云分割。之后,我们简要介绍了我们从中获得灵感的 SIFT 描述子。

2.1. 3D 表示

Volumetric Representation(体素表示) 在深度学习的首次尝试是通过体素表示法。许多工作试 14,15,4 图将3D点云或场景体素化为规则体素网格。然而,体素表示的主要挑战是数据稀疏性和3D卷积的计算开销。体素网格分辨率的实际选择可以是32×32×32,这远远不够准确地表示复杂形状或场景。此外,基于方便的数据格式(如点云)构建体积网格需要进行转换,这会导致截断误差和信息丢失。虽然最近的一些工作16,3,17提出了解决稀疏性问题的技术(例如,八叉树数据结构),但体素方法的性能仍然无法与基于点云15的方法媲美。

Polygonal Meshes(多边形网格) 一些文献18,19,20着重于使用拉普拉斯图处理网格。此外,功能图和循环一致性21,22有助于在形状之间建立对应关系。然而,这种方法仅限于流形网格。

Multi-view Representation(多视图表示)15,23,24努力在3D识别中利用2D CNN的强大能力。在这些工作中,为了使输入适合2D CNN,需要将3D形状投影到2D图像。通过组合从各个视点拍摄的2D图像来实现对目标(或场景)的3D级理解。然而,这种投影会导致丢失最关键和最具辨别力的几何细节。例如,计算法向量变得非常重要/困难,空间距离不被保留以及遮挡阻碍了对局部和全局结构的整体理解。不能包含这些几何细节,可能会大大限制形状补全和语义分割等任务的性能。

2.2. 点云上的深度学习

PointNet和后续工作 最近,一系列工作提出了几种直接处理点云的有效架构。其中,大部分工作是将PoinetNet1应用为无序的全局或局部描述子。PointNet1是一次开创性的尝试,通过全局最大池化进行逐点编码和聚合,将深度学习应用于无序点云。PointNet++2提出了一种分层神经网络来捕捉局部几何细节。PointCNN25使用X-Conv层而不是普通的mlp(多层感知机)层来利用点的某些规范排序。动态图CNN26(DGCNN)提出了一种替代PointNet++2中使用的球查询的分组方法:特征向量之间的KNNw.r.t. 欧氏距离。超点图27(SPG)首先将点云划分为多个超点,并将每个超点嵌入共享的PointNet。通过当前超点和空间相邻超点的PointNet嵌入来预测超点的语义标签。我们发觉分割算法能够取得领先的结果在一定程度上可能是得益于有序的算子。

旋转等变性和旋转不变性 另外一部分则聚焦于旋转等变性或不变性。GCNN28为了能够实现固定旋转的旋转不变性,设计了在特定旋转角度(比如,90度旋转)下闭合的filter。这种方法只能对一些特定角度的旋转实现精确的旋转不变性,同时还引入了巨大的计算开销。The time complexity is proportional to the cardinality of equivalence classes under the rotations one want to be equivariant of, making it impractical to consider rotation equivariance for large and general groups. 球形CNN2930将3D形状投影到球体上,并使用球形滤波器处理信号,以实现旋转等变表示。将球体转换为单个值的全局最大池进一步实现了旋转不变性。虽然球形CNN对旋转完全不变,但将形状投影到球体上会引入很大的误差,并且不适用于具有特定拓扑特性的对象或场景。此外,有助于实现旋转不变性的操作大大限制了模型容量,阻碍了其在分割任务中的使用。

2.3. 尺度不变特征变换(SIFT)

SIFT3是一种局部图像模式描述子,广泛应用于目标识别、3D建模、机器人和各种其他领域。SIFT及其变体31由两个实体组成,一个尺度不变检测器和一个旋转不变描述子。

我们从SIFT算法中的两个实体中获得灵感。在关键点检测阶段,SIFT算法通过多尺度表示实现了尺度不变性,我们也将其用于鲁棒处理各种尺度的对象。在特征描述阶段,SIFT检测旋转不变性的主要方向,并综合感知不同方向的图像模式。鉴于像SIFT的描述符或CNN的内核这样的有序描述符对2D图像产生了令人印象深刻的结果,我们猜想拥有这样的描述符也可能有利于点云的表示。SIFT算法的上述两个观察结果引导我们设计了一个尺度感知描述子,该描述子使用有序操作对来自不同方向的信息进行编码。

3. 问题陈述

我们首先制定了点云语义分割的任务。我们用

P

P

P 表示点云,

P

P

P 是一个包含

n

n

n 个点

p

1

,

p

2

,

.

.

.

,

p

n

∈

R

d

p_1,p_2,...,p_n \in \mathbb{R}^d

p1?,p2?,...,pn?∈Rd 的点集,其中

d

d

d 表示维度。每个点

p

i

p_i

pi? 的特征向量可以是其在三维空间中的坐标(

x

i

,

y

i

,

z

i

x_i,y_i,z_i

xi?,yi?,zi?)(或加上可选的特征通道,如RGB值、法线、中间步骤中的表示向量等)。语义标签集合用

L

L

L 表示。点云的语义分割是一个函数

Ψ

\Psi

Ψ,它将语义标签分配给点云中的每个点。即:

Ψ

:

P

?

L

n

(

1

)

\begin{equation}\Psi : P \mapsto L^n(1) \tag{1} \end{equation}

Ψ:P?Ln(1)?(1)?

分割算法的目标是找到给出准确语义标签的最佳函数。

点集 P P P 的几个性质已经在先前的工作1,[^^24]中进行了强调。 P P P 的密度可能不是在任何地方都是均匀的,并且 P P P 可以非常稀疏。此外, P P P 作为一个集合是无序和非结构化的,这将点云与常见的顺序或结构化数据(如图像或视频)区分开来。

4. 我们的方法

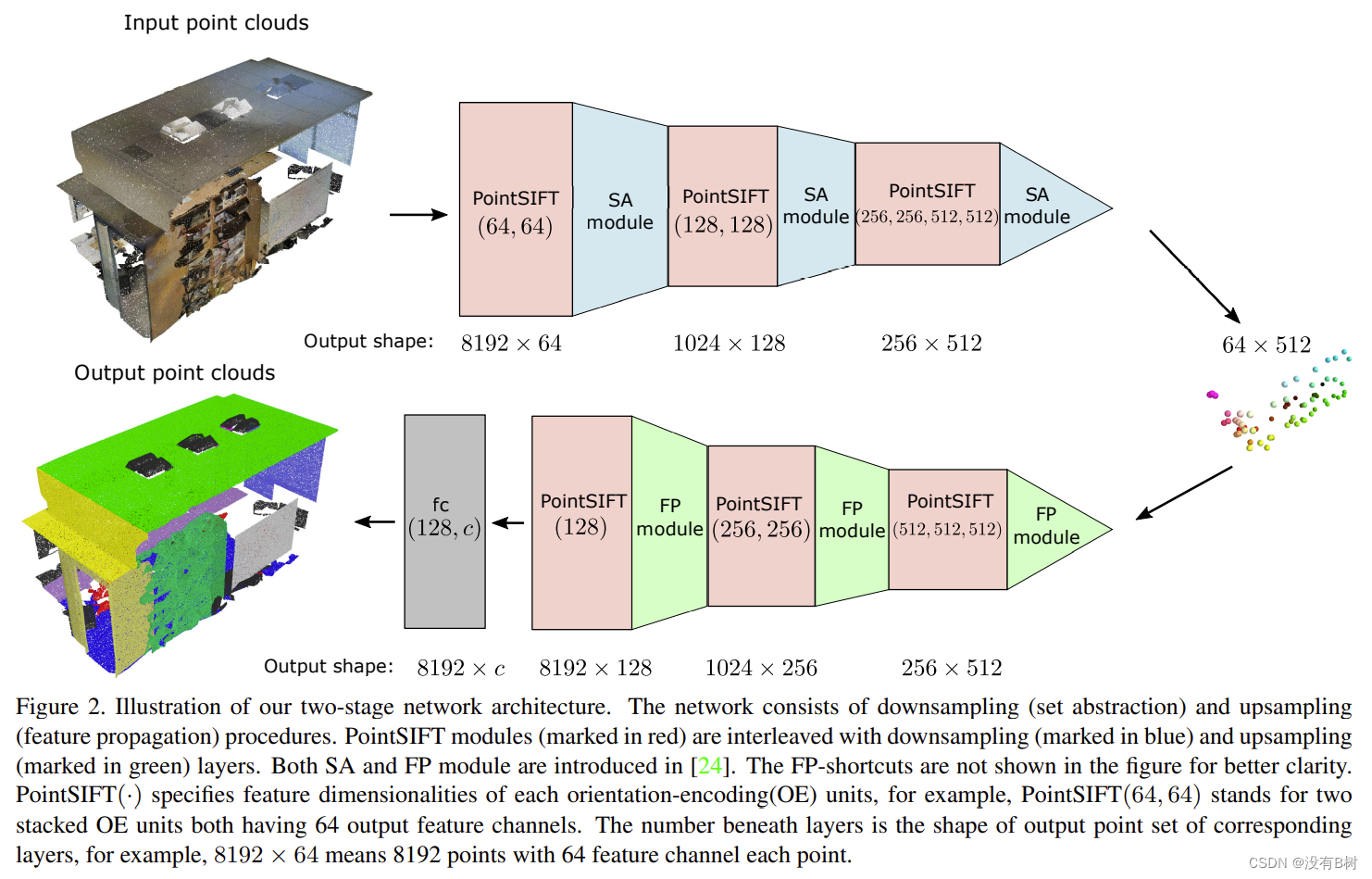

我们的网络遵循编码-解码(下采样-上采样)框架,类似于点云分割的一般语义分割网络32(如图 2 所示)。在下采样阶段,我们递归地应用我们提出的PointSIFT模块联合2中引入的集合抽象(SA)模块,用于分层特征嵌入。对于上采样阶段,通过有效地将特征传播(FP)模块2与PointSIFT模块交插来实现密集特征。我们的主要贡献和分割网络的核心组件之一是PointSIFT模块,该模块具有所需的方向编码和尺度感知特性。

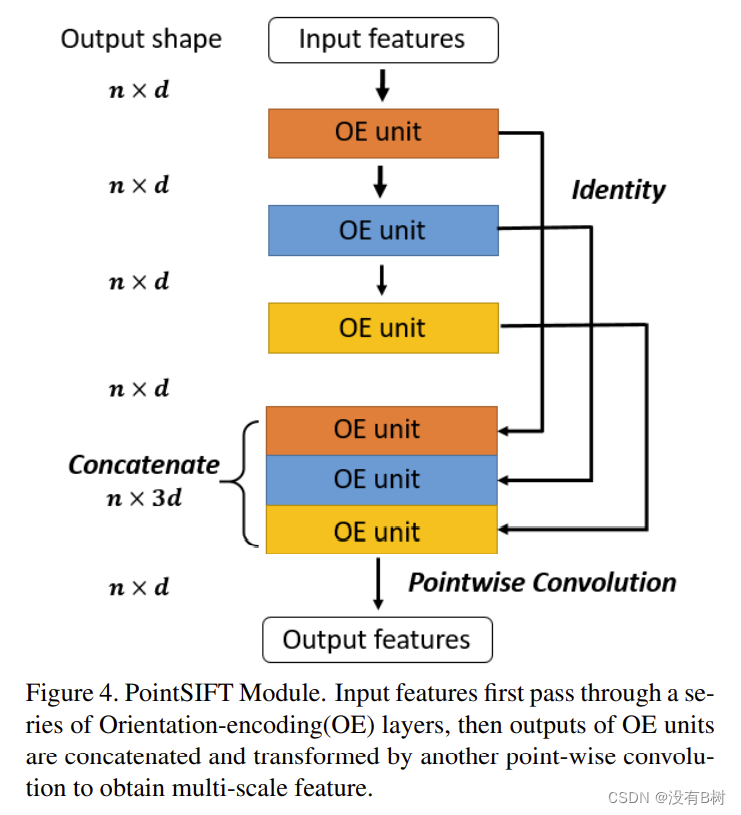

4.1. PointSIFT 模块

给定一个 n × d n \times d n×d 矩阵作为输入,该矩阵描述为大小为 n n n 的点集,每个点具有 d d d 维特征,PointSIFT模块输出一个 n × d n \times d n×d 矩阵,该矩阵为每个点分配一个新的 d d d 维特征。

受到广泛使用的SIFT描述子的启发,我们试图将PointSIFT模块设计为一种局部特征描述方法,该方法对各种方向进行建模,并且保持尺度不变。

4.1.1 方向编码

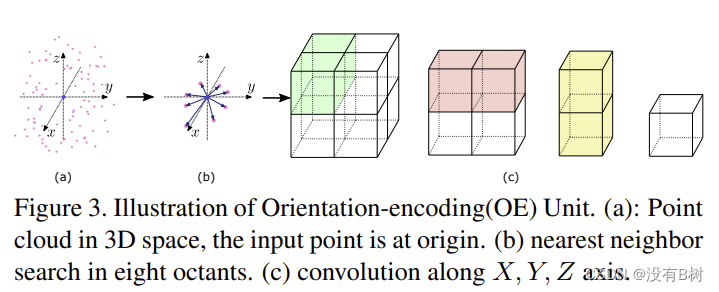

先前方法中的局部描述子通常是基于对点云无序和非结构化的观察应用无序操作(例如,最大池化2,26)。然而,使用有序运算可以提供更多信息(最大池化会丢弃除最大值之外的所有输入),同时仍保持输入点顺序的不变性。点云的一种自然排序是由三个坐标的排序引起的。这一观察引导我们设计了方向编码(OE)单元,它是一个逐点局部特征描述子,对八个方向的信息进行编码。

方向编码单元的输入是点 p 0 p_0 p0? 的 d d d 维的特征向量 f 0 ∈ R d f_0 \in \mathbb{R}^d f0?∈Rd。来自八个方向的信息通过两阶段方案集成以产生方向感知特征 f 0 f_0 f0?。方向编码单元如图 3 所示。

嵌入方向编码单元的第一阶段是堆叠8邻域(S8N)搜索,由三坐标排序划分的8个象限发现8个最近的相邻点。由于距离远的点为描述局部模式提供的信息很少,所以当在某个象限的搜索半径 r r r 内不存在点时,我们将 p 0 p_0 p0? 复制为其最近的相邻点。我们进一步处理位于 2 × 2 × 2 2 \times 2 \times 2 2×2×2 立方体中的那些相邻点的特征,来作为以 p 0 p_0 p0? 为中心的局部模式描述。许多以前的工作忽略了数据的结构,并沿 d d d 维对特征向量进行最大池化以获得新的特征。然而,我们相信卷积等有序算子可以更好地利用数据结构。因此,我们提出了方向编码卷积,它是一个三阶段算子,沿 X X X、 Y Y Y 和 Z Z Z 轴依次卷积 2 × 2 × 2 2 \times 2 \times 2 2×2×2 立方体。形式上,相邻点的特征是形状为 2 × 2 × 2 × d 2 \times 2 \times 2 \times d 2×2×2×d 的向量 V V V,其中前三个维度对应于三个轴。向量 M M M 的切片是特征向量,例如 M 1 , 1 , 1 M_{1,1,1} M1,1,1? 表示从右上角象限的特征。三阶段卷积公式如下:

V

x

=

g

(

C

o

n

v

(

W

x

,

V

)

)

∈

R

1

×

2

×

2

×

d

V_x = g(Conv(W_x,V)) \in \mathbb{R}_{1 \times 2 \times 2 \times d}

Vx?=g(Conv(Wx?,V))∈R1×2×2×d?

V

x

y

=

g

(

C

o

n

v

(

W

y

,

V

x

)

)

∈

R

1

×

1

×

2

×

d

V_{xy} = g(Conv(W_y,V_x)) \in \mathbb{R}_{1 \times 1 \times 2 \times d}

Vxy?=g(Conv(Wy?,Vx?))∈R1×1×2×d?

V

x

,

y

,

z

=

g

(

C

o

n

v

(

W

z

,

W

x

y

)

)

∈

R

1

×

1

×

1

×

d

V_{x,y,z} = g(Conv(W_z,W_{xy})) \in \mathbb{R}_{1 \times 1 \times 1 \times d}

Vx,y,z?=g(Conv(Wz?,Wxy?))∈R1×1×1×d?

其中 W x ∈ R 2 × 1 × 1 × d W_x \in \mathbb{R}_{2 \times 1 \times 1 \times d} Wx?∈R2×1×1×d?, W y ∈ R 1 × 2 × 1 × d W_y \in \mathbb{R}_{1 \times 2 \times 1 \times d} Wy?∈R1×2×1×d? 和 W z ∈ R 1 × 1 × 2 × d W_z \in \mathbb{R}_{1 \times 1 \times 2 \times d} Wz?∈R1×1×2×d? 是卷积算子的权重(为了清楚起见,省略了偏差)。在本文中,我们设置 g ( ? ) = R e L U ( ? ) g(\cdot) = ReLU(\cdot) g(?)=ReLU(?)。最后,方向编码卷积通过重塑 V x y z ∈ R 1 × 1 × 1 × d V_{xyz} \in \mathbb{R}_{1 \times 1 \times 1 \times d} Vxyz?∈R1×1×1×d? 输出一个 d d d 维特征。方向编码卷积(OEC)集成来自八个空间方向的信息,并获得对方向信息进行编码的表示。

4.1.2 尺度感知

为了使我们的PointSIFT模块具有尺度感知能力,我们遵循了长期以来的多尺度表示方法,将多个方向编码(OE)单元堆叠在PointSIFT模块中,如图 4 所示。高水平OE单位比低水平OE单元具有更大的感受野。通过构建OE单元的层次结构,我们获得了点云中局部区域的多尺度表示。然后,各种尺度的特征通过几个 identity shortcuts 连接起来,并通过另一个逐点卷积进行变换,该卷积输出一个 d d d 维多尺度特征。在联合优化特征提取和集成多尺度特征的逐点卷积的过程中,神经网络将学习选择或趋向于合适的尺度,以使我们的网络能够尺度感知。

我们的PointSIFT模块的输入和输出向量具有相同的形状,这使得我们的模块可以方便地集成到其他现有的点云分割架构中。我们期待着PointSIFT模块的未来应用,可能不局限于点云分割领域。

4.2. 总体架构

我们首先回顾了PointNet++中的集合抽象(SA)和特征传播(FP)模块,从而介绍了如何通过SA、FP和pointSIFT模块构建我们的模型。

4.2.1 回顾PointNet++中的SA和FP模块

在PointNet++2中提出了集合抽象(SA)和特征传播(FP)模块,分别对应于点云的下采样和上采样。我们在这里简要介绍了SA和FP模块。

集合抽象模块接收 N × d N \times d N×d 的输入,这个输入表示一个具有 N N N 个点且每个点具有 d d d 维特征的点云。输出为 N ′ × d ′ N^\prime \times d^\prime N′×d′,对应于 N ′ N^\prime N′ 个下采样点,每个下采样点具有 d ′ d^\prime d′ 维特征。下采样是通过用最远的点采样找到 N ′ N^\prime N′ 个质心,将点分配给质心,然后通过共享PointNet馈送指定点的特征来计算质心的嵌入来实现的。

特征传播模块使用按距离加权的线性插值对点云进行上采样。它接收大小为 N N N 的输入点集并输出大小为 N ′ N^\prime N′ 的上采样集,其中特征维数保持不变。上采样过程获取在下采样期间被丢弃的点,并基于未被丢弃的 k k k 最近邻点的特征在3D空间中通过欧式距离加权,将特征分配给它们。

4.2.2 架构详细信息

我们架构的输入是8192个点的3D坐标(或坐标与RGB值进行concat)。在下采样阶段,像2一样,使用多层感知机(MLP)将输入的3D(或6D)向量换为64维的特征。三个连续的下采样(集合抽象,SA)操作分别将点集的大小缩小到1024、256、64。对于上采样部分,我们使用 2 提出的特征传播(FP)模块进行密集特征和预测。通过三个FP层将点集分别提升到256、1024、8192个点,这三个FP层在下采样阶段与其对应层对齐。我们的PointSIFT模块插入所有相邻SA和FP层之间。最终,最后一个上采样层的点特征通过一个全连接层进行语义标签预测。

此外,我们不仅在下采样层之间插入FP模块,而是在编码阶段将FP模块从下采样层到其对应层均进行了插入。我们称这些链接为FP-shortcuts,因为它们类似于通过链接相应的下采样和上采样层并补充了在下采样过程中可能丢失的低级信息的shortcuts。FP-shortcuts 会导致更快的收敛,这已被许多使用这种 shortcut 进行 flavor connections 的先前工作25,2所证明。预测精度也提高了相当大的幅度,这在许多工作中也有报道,例如残差网络33中。

5. 实验

我们的实验由两部分组成:验证OE单元和PointSIFT模块的有效性(第5.1节)和介绍在语义分割基准数据集上的结果(第5.2节)。在下文中,SA和FP分别是 2 中提出的集合抽象和特征传播模块。

5.1. PointSIFT模块的有效性/效果

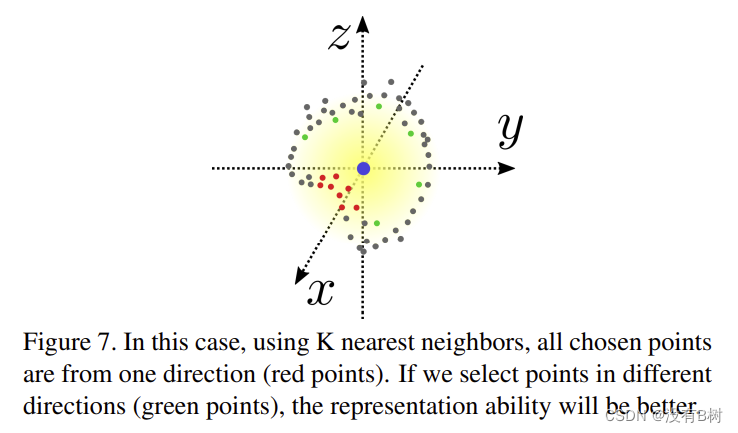

Orientation-encoding Convolution (OEC) 我们在OE单元中应用了堆叠的8邻域搜索,这与PointNet++2中提出的球查询搜索有根本不同。主要区别在于,S8N搜索是在8个象限中的每个象限中查找相邻点,而球查询则是全局中搜索最近的相邻点。如图 7 所示,全局最近邻搜索可能会导致产生的相邻点集是同类型的,所以其信息量小于在8个方向上搜索的结果。

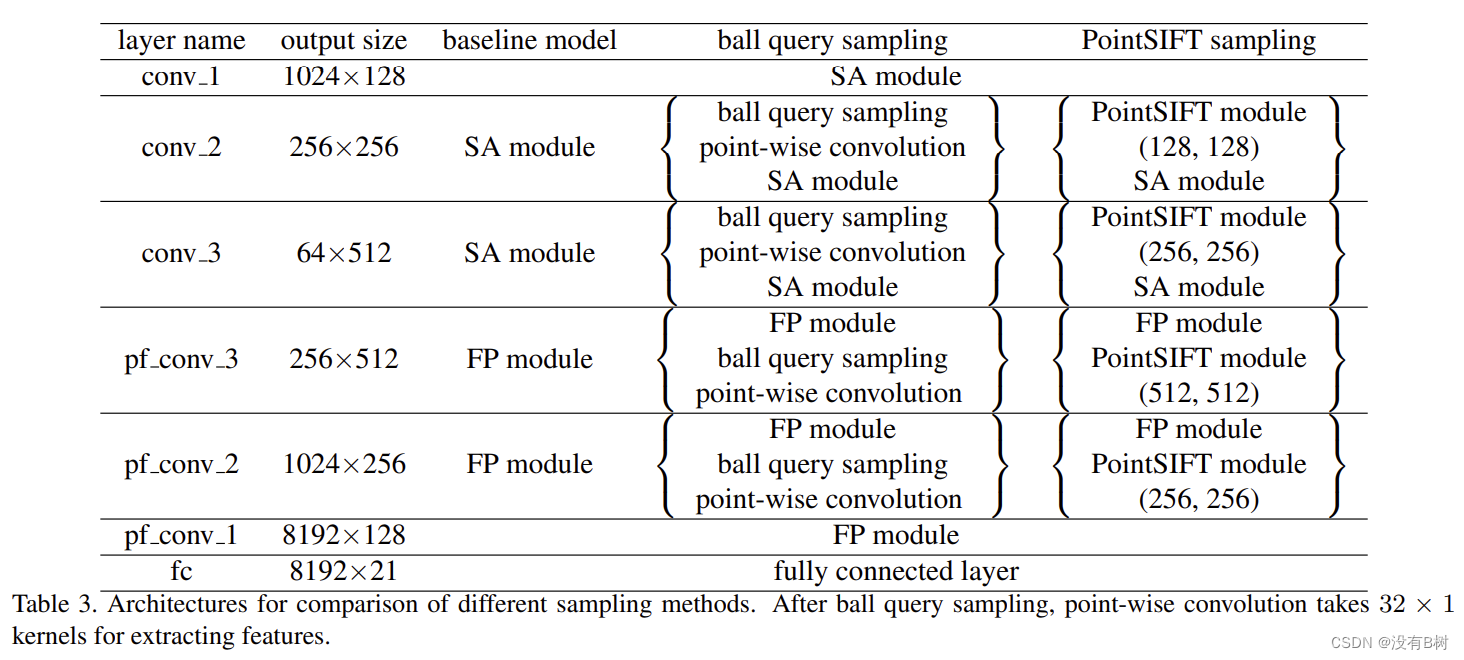

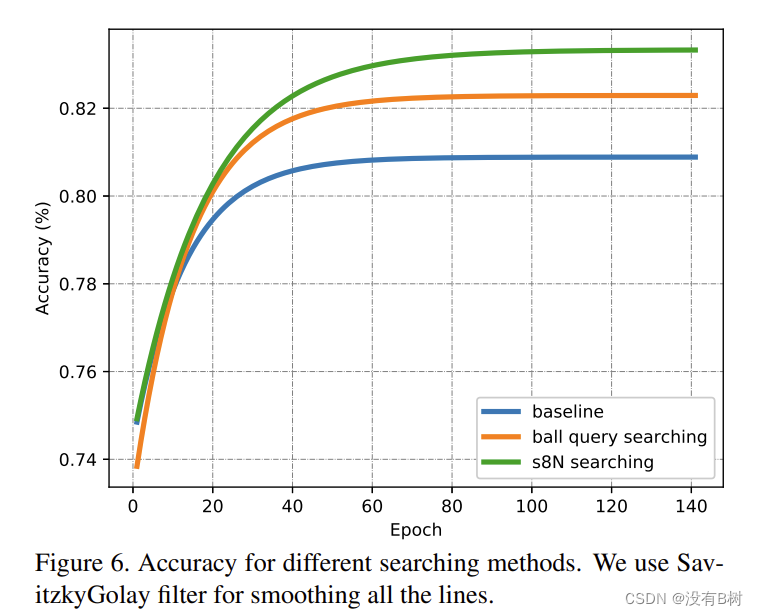

为了证明我们的S8N搜索的有效性,我们在轻量级版本的PointNet++中用S8N查询替换了球查询,并比较了性能。网络的详细架构如表 3 所示。为了公平起见,我们将两个相邻点邻搜索方法要查找的点的数量设置为相同。结果如图 6 所示,这证明了我们的S8N分组加OE卷积的有效性。

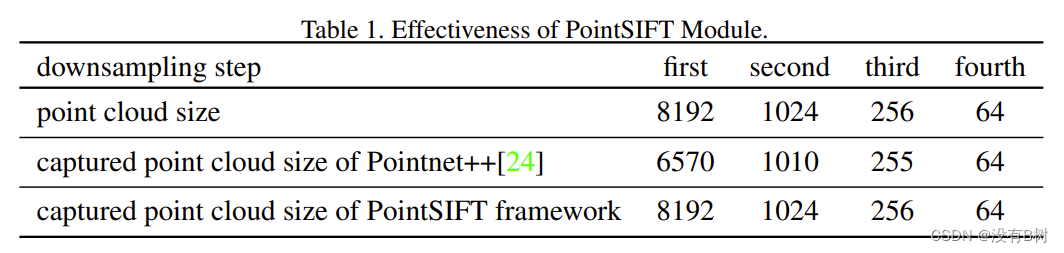

证明PointSIFT模块合理性的另一个观察结果是,来自单个输入点云的更多点有助于PointSIFT的最终表示。在PointNet++2中,分组层无法将点云中的某些点指定给任何质心,因此丢失了未指定点的信息。我们声称PointSIFT模块几乎可以避免下采样过程中的信息丢失,这有利于语义分割。为了证明这一点,我们在ScanNet13数据集上与PointNet++2进行了对比实验。给定大小为8192的输入,第一步是将8192点下采样到1024点。2的方法选择1024个质心,并将搜索半径内最近的32个点分组。

我们的结果表明,在PointNet++2中,8192个点中有平均1622个点没有被分组。也就是说,约20%点的信息未被整合到下采样表示中。相反,我们的PointSIFT模块通过在OE单元中执行多方向编码(OE)卷积,在计算中涉及更多点。通过在每个下采样层之前插入PointSIFT模块,我们的结果表明可以处理所有点,并有助于最终预测。结果见表 1。

5.1.1 尺度感知的有效性

我们设计了一个玩具实验来验证我们框架中尺度感知的有效性。实验设置是,我们生成10000个不同尺度的简单形状(例如球体、长方体),根据生成的数据训练我们的框架。然后,我们测试针对特定形状的不同层中的PointSIFT模块的 activation magnitude 是否与形状的尺度一致。如上所述,PointSIFT模块中的不同层对应于不同的尺度。因此,如果存在这种一致性,我们可以得出结论,网络是尺度感知的。结果表明,89%的时间,层次结构中 activation 最高的PointSIFT模块的位置与输入形状相对于最大和最小尺度的相对尺度一致。这个玩具实验表明,所提出的PointSIFT框架在某种意义上是尺度感知的。

5.2. 在语义分割基准数据集上的结果

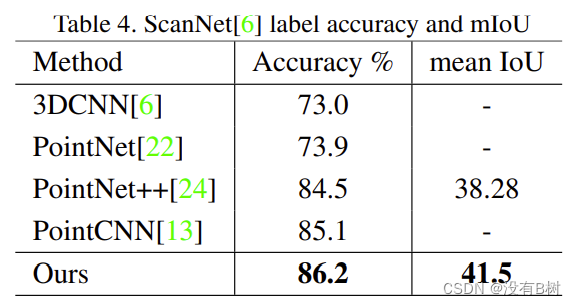

ScanNet ScanNet13是一项场景语义标记任务,共有1513个扫描场景。我们像 [24,13] 一样,使用1201个场景进行训练,并保留312个场景用于没有RGB信息的测试。结果见表 4。与其他方法相比,我们提出的PointSIFT方法在每体素精度方面达到了更好的性能。此外,尽管我们在SA模块中没有使用多尺度分组(MSG),我们的方法依然优于PointNet++(多尺度分组有助于解决采样密度不均匀的问题)。结果证明了我们的PointSIFT模块在点搜索和分组方面的优势。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-quGTmEMT-1667412934393)(assets/Pasted%20image%2020221103020948.png)]

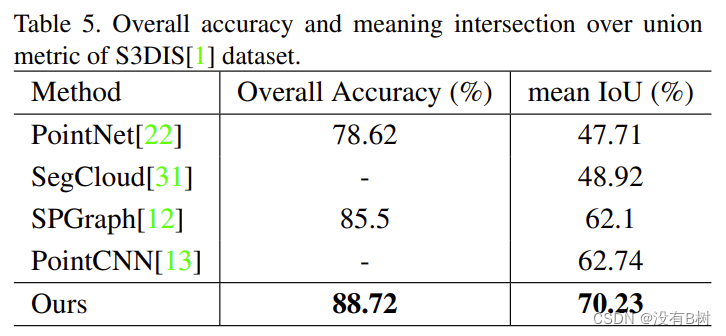

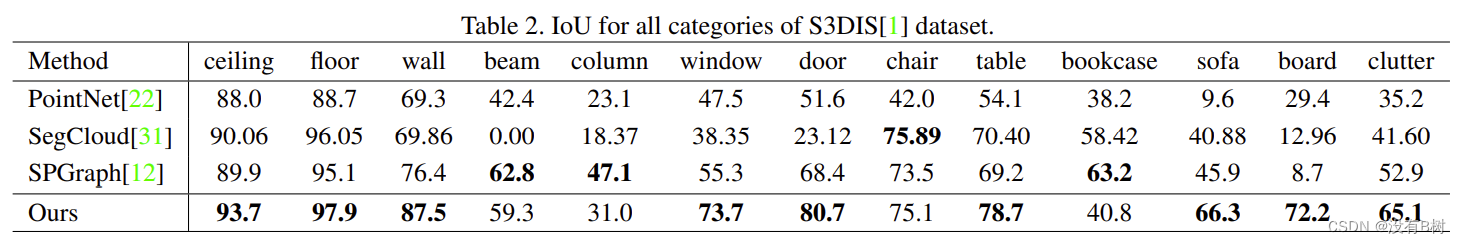

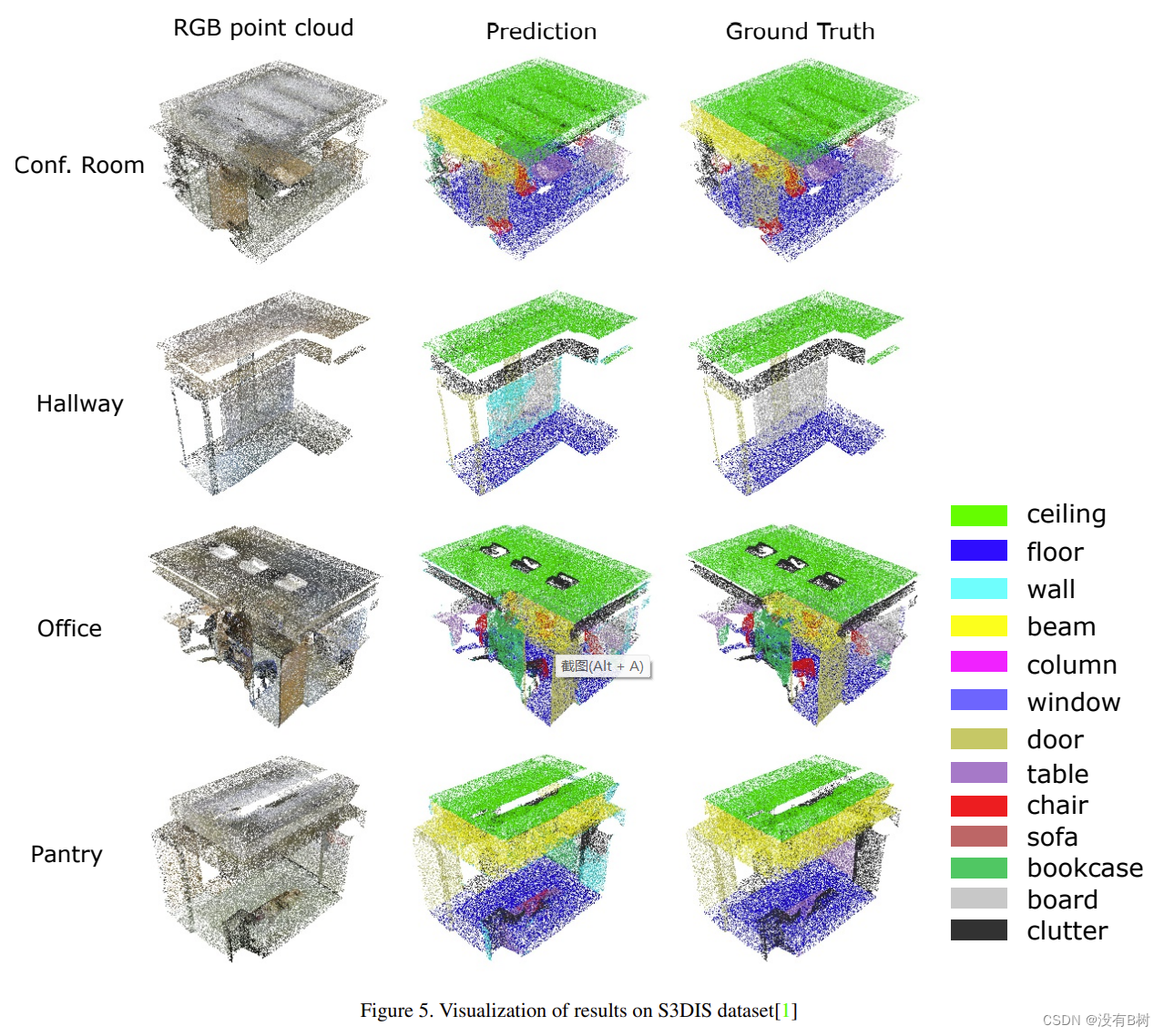

Stanford Large-Scale 3D Indoor Spaces S3DIS数据集包含三个不同的建筑物(共271个房间)的RGB-D点云数据,并分成六个文件夹。每个点都用来自13个类别的标签进行注释。我们按照 1 那样准备训练集:我们按房间和样本房间将点拆分为 1m×1m 的块。正如在 12,1 中所使用的,我们使用 k-fold 策略进行训练和测试。总精度和mIoU如表 5 所示。我们的PointSIFT体系结构优于其他方法。每个类别的IoU如表 2 所示,我们的方法显著改进了该数据集的语义分割任务的结果,并在大多数类别中获胜。我们的方法可以在一些其他方法表现不佳的困难类别中取得很好的结果,比如:沙发上的点 mIoU 为 11,board上的点 mIoU 为 42。一些结果如图 5 所示。

6. 结论

我们提出了一种新的PointSIFT模块,并证明了其在标准数据集上的语义分割任务方面的显著改进。所提出的模块具有两个关键特性:第一,方向编码单元捕获不同方向的信息。其次,PointSIFT模块的多尺度表示能够处理各种尺度的目标。此外,基于PointSIFT模块,提出了一种有效的端到端的点云语义分割架构。我们还进行了全面的实验,以证明所提出的PointSIFT模块的有效性。

参考文献

Charles R Qi, Hao Su, Kaichun Mo, and Leonidas J Guibas. Pointnet: Deep learning on point sets for 3d classification and segmentation. arXiv preprint arXiv:1612.00593, 2016. 1, 3, 7, 8 ?? ?? ?? ?? ?? ?? ?? ??

Charles R Qi, Li Yi, Hao Su, and Leonidas J Guibas. Pointnet++: Deep hierarchical feature learning on point sets in a metric space. arXiv preprint arXiv:1706.02413, 2017. 1, 2, 3, 4, 5, 6, 7, 8 ?? ?? ?? ?? ?? ?? ?? ?? ?? ?? ?? ?? ?? ?? ?? ?? ?? ?? ??

David G. Lowe. Distinctive image features from scale-invariant keypoints. Int. J. Comput. Vision, 60(2):91–110, November 2004. 1, 2, 3 ?? ?? ?? ??

Zhirong Wu, S. Song, A. Khosla, Fisher Yu, Linguang Zhang, Xiaoou Tang, and J. Xiao. 3d shapenets: A deep representation for volumetric shapes. In 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 1912–1920, June 2015. 1, 2 ?? ??

J. Lahoud and B. Ghanem. 2d-driven 3d object detection in rgb-d images. In 2017 IEEE International Conference on Computer Vision (ICCV), pages 4632–4640, Oct 2017. 1 ??

Charles R Qi, Wei Liu, Chenxia Wu, Hao Su, and Leonidas J Guibas. Frustum pointnets for 3d object detection from rgb-d data. arXiv preprint arXiv:1711.08488, 2017. 1 ??

Shuran Song and Jianxiong Xiao. Deep Sliding Shapes for amodal 3D object detection in RGB-D images. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016. 1 ??

Gernot Riegler, Ali Osman Ulusoy, and Andreas Geiger. Octnet: Learning deep 3d representations at high resolutions. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017. 1, 2 ??

J. Papon, A. Abramov, M. Schoeler, and F. Wrgtter. Voxel cloud connectivity segmentation - supervoxels for point clouds. In 2013 IEEE Conference on Computer Vision and Pattern Recognition, pages 2027–2034, June 2013. 1 ??

Trung Pham, Thanh-Toan Do, Niko Sunderhauf, and Ian D. ¨ Reid. Scenecut: Joint geometric and object segmentation for indoor scenes. CoRR, abs/1709.07158, 2017. 1 ??

Evan Shelhamer, Jonathan Long, and Trevor Darrell. Fully convolutional networks for semantic segmentation. PAMI, 2016. 2 ??

Iro Armeni, Ozan Sener, Amir R. Zamir, Helen Jiang, Ioannis Brilakis, Martin Fischer, and Silvio Savarese. 3d semantic parsing of large-scale indoor spaces. In Proceedings of the IEEE International Conference on Computer Vision and Pattern Recognition, 2016. 2, 7, 8 ?? ??

Angela Dai, Angel X. Chang, Manolis Savva, Maciej Halber, Thomas Funkhouser, and Matthias Nie?ner. Scannet: Richly-annotated 3d reconstructions of indoor scenes. In Proc. Computer Vision and Pattern Recognition (CVPR), IEEE, 2017. 2, 6, 7, 8 ?? ?? ??

D. Maturana and S. Scherer. VoxNet: A 3D Convolutional Neural Network for Real-Time Object Recognition. In IROS, 2015. 2 ??

Charles R Qi, Hao Su, Matthias Niessner, Angela Dai, Mengyuan Yan, and Leonidas J Guibas. Volumetric and multi-view cnns for object classification on 3d data. arXiv preprint arXiv:1604.03265, 2016. 2 ?? ?? ??

Yangyan Li, Soeren Pirk, Hao Su, Charles R Qi, and Leonidas J Guibas. Fpnn: Field probing neural networks for 3d data. arXiv preprint arXiv:1605.06240, 2016. 2 ??

M. Tatarchenko, A. Dosovitskiy, and T. Brox. Octree generating networks: Efficient convolutional architectures for high-resolution 3d outputs. In IEEE International Conference on Computer Vision (ICCV), 2017. 2 ??

Joan Bruna, Wojciech Zaremba, Arthur Szlam, and Yann LeCun. Spectral networks and locally connected networks on graphs. CoRR, abs/1312.6203, 2013. 2 ??

J. Masci, D. Boscaini, M. M. Bronstein, and P. Vandergheynst. Geodesic convolutional neural networks on riemannian manifolds. In 2015 IEEE International Conference on Computer Vision Workshop (ICCVW), pages 832–840, Dec 2015. 2 ??

Li Yi, Hao Su, Xingwen Guo, and Leonidas Guibas. Syncspeccnn: Synchronized spectral cnn for 3d shape segmentation. arXiv preprint arXiv:1612.00606, 2016. ??

Qi-Xing Huang and Leonidas J. Guibas. Consistent shape maps via semidefinite programming. Comput. Graph. Forum, 32(5):177–186, 2013. 2 ??

Qixing Huang, Fan Wang, and Leonidas J. Guibas. Functional map networks for analyzing and exploring large shape collections. ACM Trans. Graph., 33(4):36:1–36:11, 2014. 2 ??

Hang Su, Subhransu Maji, Evangelos Kalogerakis, and Erik Learned-Miller. Multi-view convolutional neural networks for 3d shape recognition. In The IEEE International Conference on Computer Vision (ICCV), December 2015. 2 ??

H. Su, F. Wang, E. Yi, and L. Guibas. 3d-assisted feature synthesis for novel views of an object. In 2015 IEEE International Conference on Computer Vision (ICCV), pages 2677–2685, Dec 2015. 2 ??

Y. Li, R. Bu, M. Sun, and B. Chen. PointCNN. ArXiv eprints, January 2018. 3, 6, 7, 8 ?? ??

Yue Wang, Yongbin Sun, Ziwei Liu, Sanjay E. Sarma, Michael M. Bronstein, and Justin M. Solomon. Dynamic graph CNN for learning on point clouds. CoRR, abs/1801.07829, 2018. 3, 4 ?? ??

Lo¨?c Landrieu and Martin Simonovsky. Large-scale point cloud semantic segmentation with superpoint graphs. CoRR, abs/1711.09869, 2017. 3, 7, 8 ??

Mahyar Najibi, Mohammad Rastegari, and Larry S. Davis. G-CNN: an iterative grid based object detector. CoRR, abs/1512.07729, 2015. 3 ??

Taco S. Cohen, Mario Geiger, Jonas Kohler, and Max ¨ Welling. Spherical cnns. CoRR, abs/1801.10130, 2018. 3 ??

Carlos Esteves, Christine Allen-Blanchette, Ameesh Makadia, and Kostas Daniilidis. 3d object classification and retrieval with spherical cnns. CoRR, abs/1711.06721, 2017. 3 ??

Herbert Bay, Tinne Tuytelaars, and Luc Van Gool. Surf: Speeded up robust features. In In ECCV, pages 404–417, 2006. 3 ??

Vijay Badrinarayanan, Alex Kendall, and Roberto Cipolla. Segnet: A deep convolutional encoder-decoder architecture for image segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017. 3 ??

Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. Deep residual learning for image recognition. arXiv preprint arXiv:1512.03385, 2015. 6 ??