飞桨生态之FastDeploy预编译库的使用方法

1 FastDeploy

为什么采用FastDeploy,由于之前使用PaddleOCR(paddlle_inference)框架的代码做推理,造成实际显存一直开辟,不释放我的问题,刚开始两个模型占用1190M,开一路离线视频最终占用5792M,除去我们解码占用的1280M,仅仅在一路有限的推理过程中增加内存为3412M,对此PaddleOCR官方的大佬们也并没有给出有效的方案,因此中issue的大侠们建议使用FastDeploy试试,那就试试就试试。

简介:是作为百度飞桨框架的开源版本的应用。

优点:大而全。

缺点:刚发布不久。

FastDeploy github仓库地址

2 下载FastDeploy编译demo方法

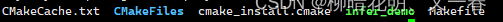

预编译库下面的cmake 是这样用的,如下图,我要是用PP-OCRv3下面的Demo,在fastdeploy-linux-x64-gpu-1.0.1目录下创建build,执行下面命令;

说明一下,官方的文档写的重要环节给省掉了,大家还是要看具体的CMake文件的构成。

cd fastdeploy-linux-x64-gpu-1.0.1

mkdir build

cd build

cmake ../examples/vision/ocr/PP-OCRv3/cpp/ -DFASTDEPLOY_INSTALL_DIR=/home/zs/package/fastdeploy-linux-x64-gpu-1.0.1 -DFASTDEPLOY_INCS=${FASTDEPLOY_INSTALL_DIR}/include -DFASTDEPLOY_LIBS=${FASTDEPLOY_INSTALL_DIR}/lib

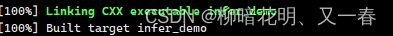

make -j10

执行完以上demo 将生成infer_demo

至于后面的推理,就按照官方的先跑通在加入自己训练的模型完成推理。

FastDeploy之PP-OCRv3推理