1. 池化层

在下面的代码中的pool2d函数,我们实现汇聚层的前向传播。 这类似于之前文章中的的corr2d函数。 然而,这里我们没有卷积核,输出为输入中每个区域的最大值或平均值。

from torch import nn

from d2l import torch as d2l

# X是输入,pool_size是窗口大小

def pool2d(X,pool_size,mode='max'):

p_h,p_w = pool_size #获得池化窗口的高和宽

# Y是输出,这里没设置padding 和 stride,并且是单通道

Y = torch.zeros((X.shape[0] - p_h +1,X.shape[1] - p_w + 1))

for i in range(Y.shape[0]): # 每行迭代

for j in range(Y.shape[1]): # 每列迭代

if mode == 'max':

Y[i,j] = X[i:i+p_h,j:j+p_w].max()

elif mode == 'avg':

Y[i,j] = X[i:i+p_h,j:j+p_w].mean()

return Y

我们可以构建 图中的输入张量X,验证二维最大汇聚层的输出。

X = torch.tensor([[0.0, 1.0, 2.0], [3.0, 4.0, 5.0], [6.0, 7.0, 8.0]])

pool2d(X, (2, 2))

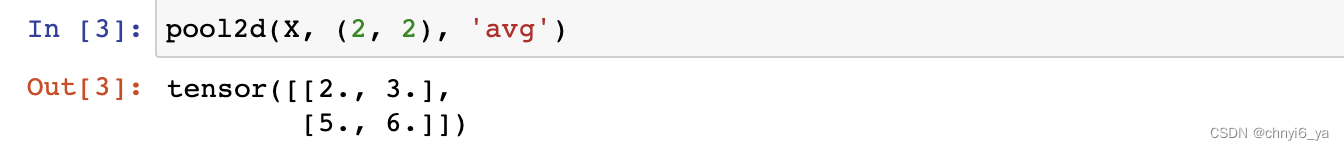

此外,我们还可以验证平均汇聚层。

2. 填充和步幅

下面用深度学习框架中内置的二维最大汇聚层,来演示汇聚层中填充和步幅的使用。

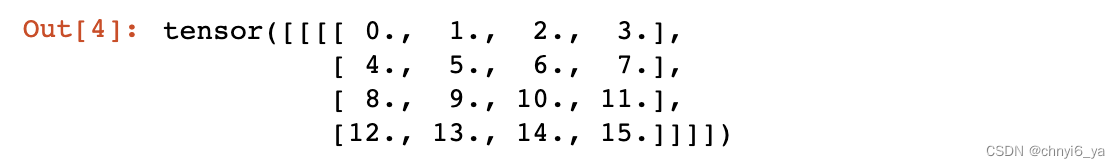

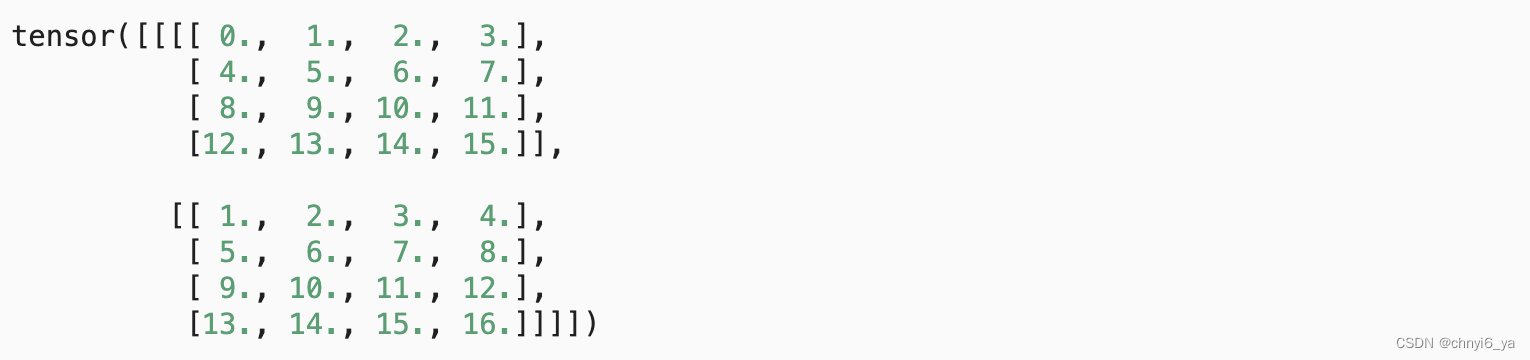

我们首先构造了一个输入张量X,它有四个维度,其中样本数和通道数都是1。

X = torch.arange(16, dtype=torch.float32).reshape((1, 1, 4, 4))

X

默认情况下,深度学习框架中的步幅与汇聚窗口的大小相同,这样的话,其实就意味着,每个窗口都不会重叠 。因此,如果我们使用形状为(3, 3)的汇聚窗口,那么默认情况下,我们得到的步幅形状为(3, 3)。

pool2d = nn.MaxPool2d(3)

pool2d(X)

运行结果:

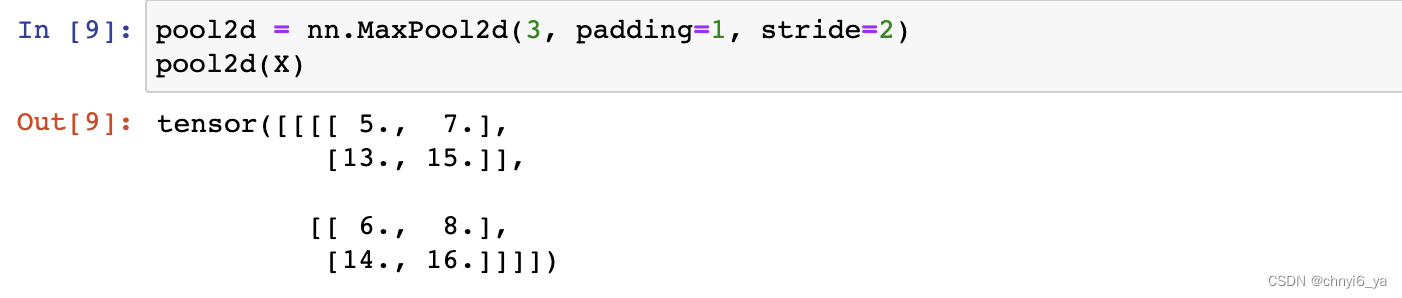

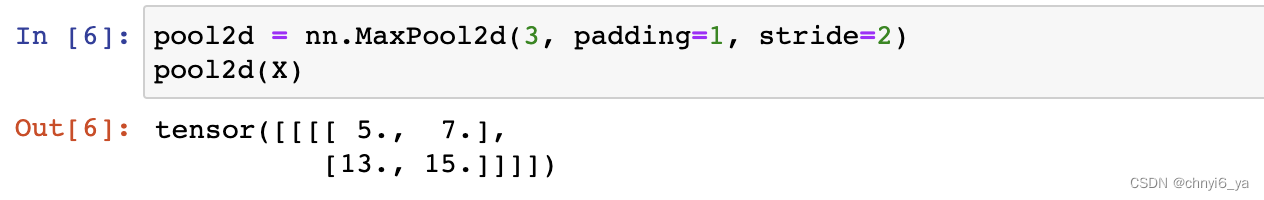

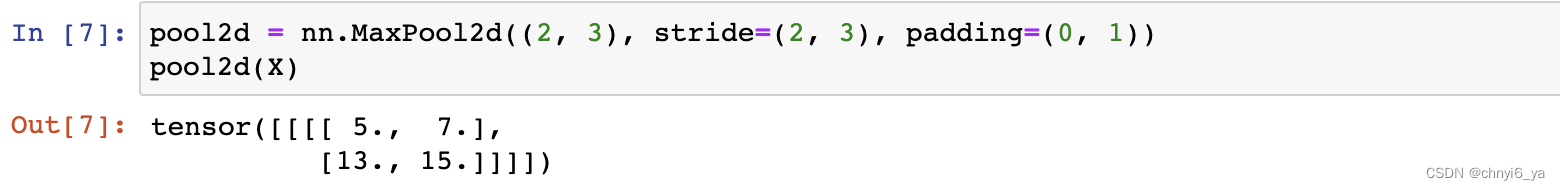

填充和步幅可以手动设定。

当然,我们可以设定一个任意大小的矩形汇聚窗口,并分别设定填充和步幅的高度和宽度。

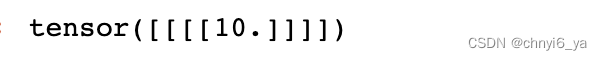

3. 多个通道

在处理多通道输入数据时,汇聚层在每个输入通道上单独运算,而不是像卷积层一样在通道上对输入进行汇总。 这意味着汇聚层的输出通道数与输入通道数相同。

下面,我们将在通道维度上连结张量X和X + 1,以构建具有2个通道的输入。

# X(1,1,4,4),第2个维度(通道),放置两个矩阵

# stack和cat的区别:stack会增加一个新轴,cat只会在某个特定的轴上对元素进行拼接

# 这里X已经包含了batch_size 和 通道两个轴,在通道这个轴上进行拼接,cat的参数为1

X = torch.cat((X, X + 1), 1)

X

如下所示,汇聚后输出通道的数量仍然是2。