3 Hadoop运行环境搭建(开发重点)

3.1 虚拟机环境准备

-(1)克隆虚拟机,虚拟机配置要求如下:

(1)单台虚拟机:内存4G,硬盘50G,安装必要环境(最小化安装)

sudo yum install -y epel-release

sudo yum install -y psmisc nc net-tools rsync vim lrzsz ntp libzstd openssl-static tree iotop

(2)修改克隆虚拟机的静态IP(按照自己机器的网络设置进行修改)

ifconfig #查看下自己的网卡

locate ifcfg-ens32

sudo vim /etc/sysconfig/network-scripts/ifcfg-ens32

改成

IPADDR=192.168.56.101

PREFIX=24

GATEWAY=192.168.56.2

DNS1=192.168.56.2

当前的ip与网关需要查看虚拟网络编辑器中的NAT设置

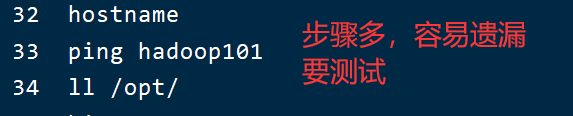

-(2)修改主机名

(1)修改主机名称

locate hostname | grep etc

sudo vim /etc/hostname

(2)配置主机名称映射,打开/etc/hosts

sudo vim /etc/hosts

添加如下内容

192.168.1.100 hadoop100

192.168.1.101 hadoop101

192.168.1.102 hadoop102

192.168.1.103 hadoop103

192.168.1.104 hadoop104

192.168.1.105 hadoop105

192.168.1.106 hadoop106

192.168.1.107 hadoop107

192.168.1.108 hadoop108

需要根据虚拟网络编辑器的NAT数据进行变更

比如 192.168.1换成你自己的

(3)修改window7的主机映射文件(hosts文件)

(a)进入C:\Windows\System32\drivers\etc路径

(b)打开hosts文件并添加如下内容

192.168.1.100 hadoop100

192.168.1.101 hadoop101

192.168.1.102 hadoop102

192.168.1.103 hadoop103

192.168.1.104 hadoop104

192.168.1.105 hadoop105

192.168.1.106 hadoop106

192.168.1.107 hadoop107

192.168.1.108 hadoop108

(4)修改window10的主机映射文件(hosts文件)

(a)进入C:\Windows\System32\drivers\etc路径

(b)拷贝hosts文件到桌面

(c)打开桌面hosts文件并添加如下内容

192.168.1.100 hadoop100

192.168.1.101 hadoop101

192.168.1.102 hadoop102

192.168.1.103 hadoop103

192.168.1.104 hadoop104

192.168.1.105 hadoop105

192.168.1.106 hadoop106

192.168.1.107 hadoop107

192.168.1.108 hadoop108

(d)将桌面hosts文件覆盖C:\Windows\System32\drivers\etc路径hosts文件

-(3)关闭防火墙

sudo systemctl stop firewalld

sudo systemctl disable firewalld

-(4)创建dev1用户

sudo useradd dev1

sudo passwd dev1

-(5)配置dev1用户具有root权限

sudo vim /etc/sudoers

修改/etc/sudoers文件,找到下面一行(91行),在root下面添加一行,如下所示:

## Allow root to run any commands anywhere

root ALL=(ALL) ALL

dev1 ALL=(ALL) NOPASSWD:ALL

-(6)在/opt目录下创建文件夹

(1)在/opt目录下创建module、software文件夹

sudo mkdir module

sudo mkdir software

(2)修改module、software文件夹的所有者

sudo mkdir /opt/module /opt/software

sudo chown -R dev1:dev1 /opt/module /opt/software

3.2 安装JDK

- (1)将JDK安装包上传到Linux

/opt/software目录下 - (2)解压JDK到/opt/module目录下

tar -zxvf jdk-8u212-linux-x64.tar.gz -C /opt/module/

- (3)配置JDK环境变量,两种方式:

第一种:

(1)新建/etc/profile.d/my_env.sh文件

sudo vim /etc/profile.d/my_env.sh

添加如下内容

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_212

export PATH=$PATH:$JAVA_HOME/bin

(2)保存后退出

:wq

(3)重启FinalShell窗口,让环境变量生效

第二种:

(1)直接将环境变量配置到 /etc/profile 文件中,在/etc/profile文件的末尾追加如下内容:

JAVA_HOME=/opt/module/jdk1.8.0_212

PATH=$PATH:$JAVA_HOME/bin

export PATH JAVA_HOME

(2)保存退出,然后执行如下命令

source /etc/profile

- (4). 测试JDK是否安装成功

java -version

如果能看到以下结果、则Java正常安装

java version

“1.8.0_212”

注意:

如果出现openJDK的提示 如下

[dev1@hadoop101 software]$ java -version

openjdk version "1.8.0_161"

OpenJDK Runtime Environment (build 1.8.0_161-b14)

OpenJDK 64-Bit Server VM (build 25.161-b14, mixed mode)

则需要卸载openJDK

》1:搜索openjdk安装文件

[dev1@hadoop101 software]$ rpm -qa | grep openjdk

java-1.8.0-openjdk-headless-1.8.0.161-2.b14.el7.x86_64

java-1.7.0-openjdk-1.7.0.171-2.6.13.2.el7.x86_64

java-1.8.0-openjdk-1.8.0.161-2.b14.el7.x86_64

java-1.7.0-openjdk-headless-1.7.0.171-2.6.13.2.el7.x86_64

》2:逐个卸载并测试

[dev1@hadoop101 software]$ sudo rpm -e --nodeps java-1.8.0-openjdk-headless-1.8.0.161-2.b14.el7.x86_64

[dev1@hadoop101 software]$ sudo rpm -e --nodeps java-1.7.0-openjdk-1.7.0.171-2.6.13.2.el7.x86_64

[dev1@hadoop101 software]$ sudo rpm -e --nodeps java-1.8.0-openjdk-1.8.0.161-2.b14.el7.x86_64

[dev1@hadoop101 software]$ sudo rpm -e --nodeps java-1.7.0-openjdk-headless-1.7.0.171-2.6.13.2.el7.x86_64

[dev1@hadoop101 software]$ source /etc/profile

[dev1@hadoop101 software]$ java -version

3.3 安装Hadoop

Hadoop下载地址:

https://archive.apache.org/dist/hadoop/common/hadoop-3.1.3/

- (1)将hadoop安装包上传到/opt/software目录下

- (2)解压安装文件到/opt/module下面

[dev1@hadoop101 software]$ tar -zxvf hadoop-3.1.3.tar.gz -C /opt/module/

- (3)查看是否解压成功

[dev1@hadoop101 software]$ ls /opt/module/

hadoop-3.1.3

- (4)将Hadoop添加到环境变量

(1)获取Hadoop安装路径

[dev1@hadoop101 hadoop-3.1.3]$ pwd

/opt/module/hadoop-3.1.3

(2)打开/etc/profile文件

sudo vim /etc/profile

在profile文件末尾添加:(shitf+g)

HADOOP_HOME=/opt/module/hadoop-3.1.3

PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export PATH HADOOP_HOME

(3)保存后退出

:wq

(4)让修改后的文件生效

[dev1@ hadoop101 hadoop-3.1.3]$ source /etc/profile

- (5) 测试是否安装成功

[dev1@hadoop101 hadoop-3.1.3]$ hadoop version

Hadoop 3.1.3

3.4 Hadoop目录结构

1、查看Hadoop目录结构

[dev1@hadoop101 hadoop-3.1.3]$ ll

2、重要目录

- (1)bin目录:存放对Hadoop相关服务(HDFS,YARN)

进行操作的脚本 - (2)etc目录:Hadoop的配置文件目录,存放Hadoop的

配置文件 - (3)lib目录:存放Hadoop的

本地库(对数据进行压缩解压缩功能) - (4)sbin目录:存放

启动或停止Hadoop相关服务的脚本 - (5)share目录:存放Hadoop的依赖

jar包、文档、和官方案例