我看了很多网上的一些帖子,都是说linux环境下spark为什么出现错误,我在这里就写一下,windows环境出现no mudule named 'py4j’应该怎么处理

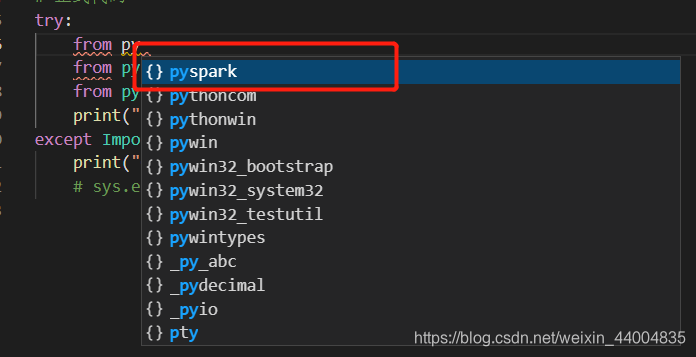

一开始,在写代码的时候,软件是会出现pyspark的提示框。(如果在写代码的时候,就没有提示pyspark,那么说明你还没有引入pyspark包)

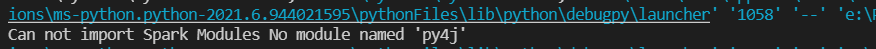

但是,运行出来,确实显示no mudule named ‘py4j’。

后来发现,由于我装的spark是3.2版本的(注意,3.0版本以后就有可能出现以下情况),只有一个pyspark的文件夹

我把pyspark复制到python安装目录下面后,pyspark可以正常运行,但是他依赖的py4j没有放到python安装目录下,所以运行不成功。

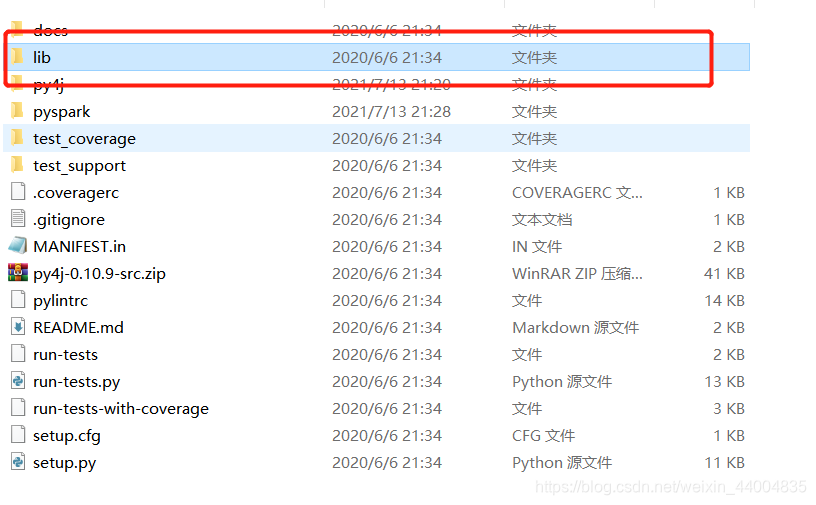

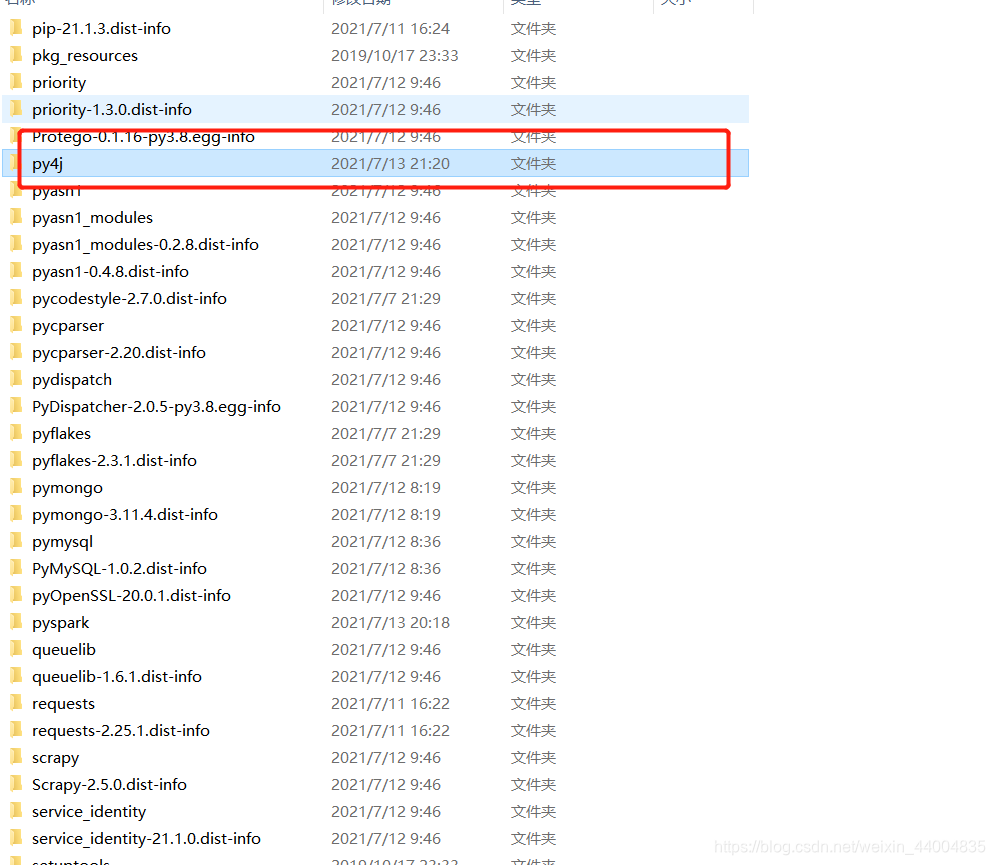

那么,去哪里找py4j呢?别着急,其实都隐藏在这里。

第一步,点击lib

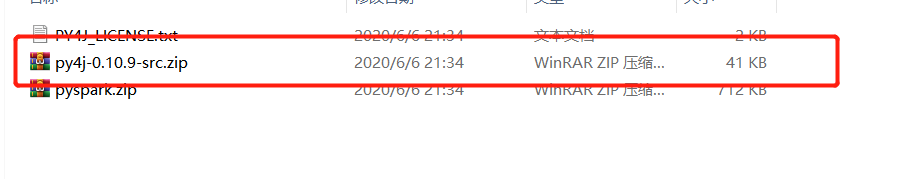

第二步,将该文件解压。(不同版本可能会有不一样的压缩包)

解压以后,得到一个文件夹,将该文件夹放入到python安装目录中的site-packages文件夹中。

然后,到写代码的软件中,输入以下代码尝试一下是否正常。

import os

import sys

try:

from py

from pyspark import SparkConf

from pyspark import SparkContext

print("Successfully imported Spark Modules")

except ImportError as e:

print("Can not import Spark Modules", e)

正常情况下,会输出Successfully imported Spark Modules。