Hadoop1.x和Hadoop2.x的区别

Hadoop1.x主要组成部分是MapReduce 和 HDFS,HDFS负责数据存储,Mapreduce不仅负责分布式计算,而且负责资源的调度;

但是在Hadoop2.x中,HDFS依旧负责数据存储,

MapReduce只负责分布式计算,资源调度由Yarn负责,这样就减轻了MapReduce的负担。

Hadoop运行模式

- 本地模式:单机运行,生产环境下不用。

- 伪分布式:也是单机运行,但是具备Hadoop集群所有功能,一台服务器模拟一个分布式的环境。

- 完全分布式:多台服务器组成的分布式环境。

Hadoop完全分布式搭建

搭建过程总览

一、 运行环境搭建

- 模板虚拟机环境准备

- 克隆三台虚拟机

- 安装Xshell和Xftp

- 安装JDK

- 安装hadoop

二、配置分布式集群

- 配置SSH无密登录

- 编写集群分发脚本

- 集群配置

- 启动集群

- 写集群启停脚本

模板虚拟机环境准备

-

安装VMware 和 CentOS(也可以用Ubantu,看个人对哪个更熟悉,笔者使用的是CentOS);

-

新建虚拟机硬件设置

IP地址:192.168.10.100

主机名称:hadoop100

内存:1G

硬盘:50G如果计算机内存足够,可以设为2G或者4G。由于后期需要同时启动三个节点,且笔者内存不够,故选择1G

硬件环境设置好后启动虚拟机,可以ping通外网即可。 -

安装epel-release(类似于一个软件仓库)

yum install -y epel-release -

关闭防火墙

systemctl stop firewalld systemctl disable firewalld.service -

创建用户并修改密码

出于安全考虑,尽量使用自己创建的新用户,少用root用户;密码尽量简单容易记住。useradd yss //创建用户 passwd yss //设置密码 -

配置用户使其具有root权限

vim /etc/sudoers在%wheel这一行下添加:用户名 ALL=(ALL) NOPASSWD:ALL

-

卸载虚拟机自带的JDK

rpm -qa | grep -i java | xargs -n1 rpm -e --nodeps解释: % rpm -qa:查询所安装的所有 rpm 软件包 % grep -i:忽略大小写 % xargs -n1:表示每次只传递一个参数 % rpm -e –nodeps:强制卸载软件 -

重启虚拟机

reboot

克隆三台虚拟机(以hadoop102为例)

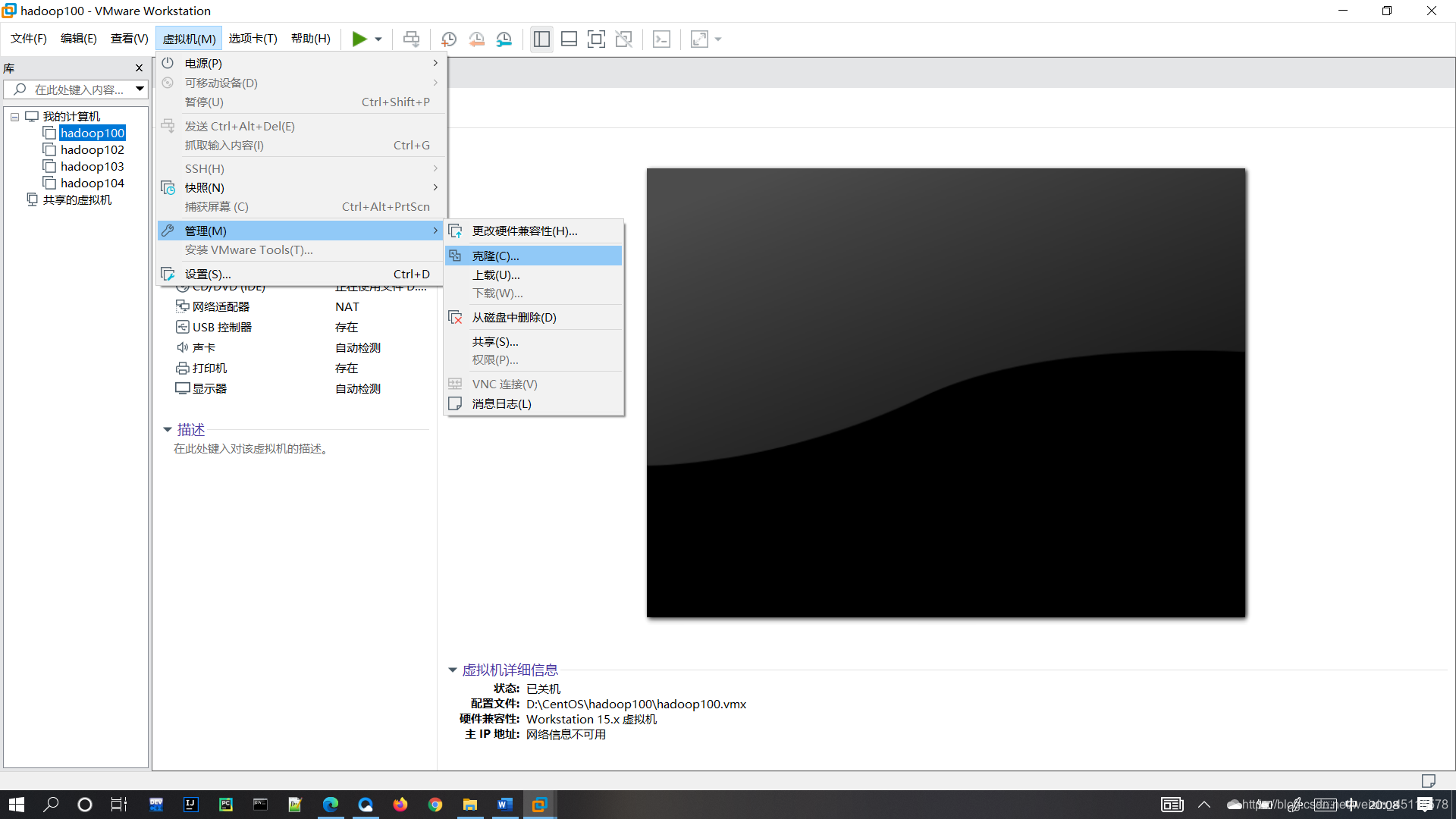

1.在VMware中选择 虚拟机——>管理——>克隆 (克隆虚拟机时要关闭hadoop100 )

- 修改克隆虚拟机的IP地址

修改部分:vim /etc/sysconfig/network-scripts/ifcfg-ens33

BOOTPROTO=static

IPADDR=192.168.10.102

GATEWAY=192.168.10.2

DNS1=192.168.10.2 - 修改克隆虚拟机的主机名称

vim /etc/hostname %hadoop102 - 配置Linux克隆主机名映射hosts文件

vim /etc/hosts添加:主机IP 主机名 - 重启hadoop102

reboot - 修改windows的主机映射文件hosts

路径:C:\Windows\System32\drivers\etc

如果修改不成功,可以将文件拷贝到桌面,用Notepad++或者Pycharm或者IDEA修改(不要用记事本),然后拷贝回去替换重名文件就可以了。

安装Xshell 和Xftp

Xshell :终端模拟器

Xftp:文件传输工具,用于在Windows和Linux间传输文件

安装JDK

- 使用 XShell 和 Xftp 将 windows 中的 JDK 导入 Linux 中的 /opt /software 下

- 解压JDK到/opt/module目录下

tar -zxvf jdk-8u212-linux-x64.tar.gz -C /opt/module/ - 配置JDK环境变量

环境变量配置如下:sudo vim /etc/profile.d/my_env.sh

- 使JDK生效

source /etc/profile - 测试

命令行输入 java ,不报错即可。

安装Hadoop

- 使用 XShell 和 Xftp 将 windows 中的 hadoop 导入 Linux 中 /opt/software 下

- 解压JDK到/opt/module目录下

tar -zxvf hadoop-3.1.3.tar.gz -C /opt/module/ - 将hadoop添加到环境变量

sudo vim /etc/profile.d/my_env.sh

- 使其生效:

source /etc/profile - 测试

hadoop version

配置SSH无密登录

- 生成公钥和私钥

ssh-keygen -t rsa - 将公钥拷贝到其他主机

ssh-copy-id hadoop102 ssh-copy-id hadoop103 ssh-copy-id hadoop104

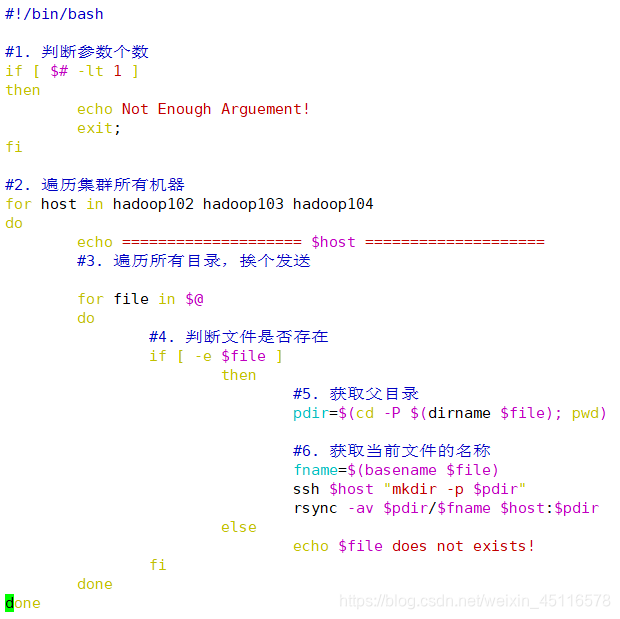

编写集群分发脚本xsync

scp 可以实现服务器与服务器之间的数据拷贝。

rsync 主要用于备份和镜像。具有速度快、避免复制相同内容和支持符号链接的优点。

- 在/home/atguigu/bin 目录下创建 xsync 文件

mkdir bin cd bin vim xsync

-

修改脚本权限

chmod 777 xsync -

将脚本复制到/bin 中,以便全局调用

sudo cp xsync /bin/ -

同步环境变量配置(root 所有者)

sudo ./bin/xsync/etc/profile.d/my_env.sh source /etc/profile -

将JDK和hadoop分发给hadoop103和hadoop104

xsync /opt/module

集群配置

为了防止虚拟机卡顿,将NameNode、SecondaryNameNode和ResourceManger安装在不同主机,后续编写一个脚本同时启动hdfs和yarn

配置文件core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml和workers

(hadoop3.x:workers hadoop2.x:slaves)

***!!! 配置文件要仔细!!!***

- core-site.xml

<?xml version="1.0" encoding="UTF-8"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration> <!-- 指定 NameNode 的地址 --> <property> <name>fs.defaultFS</name> <value>hdfs://hadoop102:8020</value> </property> <!-- 指定 hadoop 数据的存储目录 --> <property> <name>hadoop.tmp.dir</name> <value>/opt/module/hadoop-3.1.3/data</value> </property> <!-- 配置 HDFS 网页登录使用的静态用户为 atguigu --> <property> <name>hadoop.http.staticuser.user</name> <value>atguigu</value> </property> </configuration> - hdfs-site.xml

<?xml version="1.0" encoding="UTF-8"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration> <!-- nn web 端访问地址--> <property> <name>dfs.namenode.http-address</name> <value>hadoop102:9870</value> </property> <!-- 2nn web 端访问地址--> <property> <name>dfs.namenode.secondary.http-address</name> <value>hadoop104:9868</value> </property> </configuration> - yarn-site.xml

<?xml version="1.0" encoding="UTF-8"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration> <!-- 指定 MapReduce 程序运行在 Yarn 上 --> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <!-- 历史服务器端地址 --> <property> <name>mapreduce.jobhistory.address</name> <value>hadoop102:10020</value> </property> <!-- 历史服务器 web 端地址 --> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>hadoop102:19888</value> </property> </configuration> - mapred-site.xml

<?xml version="1.0" encoding="UTF-8"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration> <!-- 指定 MR 走 shuffle --> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <!-- 指定 ResourceManager 的地址--> <property> <name>yarn.resourcemanager.hostname</name> <value>hadoop103</value> </property> <!-- 环境变量的继承 --> <property> <name>yarn.nodemanager.env-whitelist</name> <value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CO NF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAP RED_HOME</value> </property> <!-- 开启日志聚集功能 --> <property> <name>yarn.log-aggregation-enable</name> <value>true</value> </property> <!-- 设置日志聚集服务器地址 --> <property> <name>yarn.log.server.url</name> <value>http://hadoop102:19888/jobhistory/logs</value> </property> <!-- 设置日志保留时间为 7 天 --> <property> <name>yarn.log-aggregation.retain-seconds</name> <value>604800</value> </property> </configuration> - workers

hadoop102 hadoop103 hadoop104 - 在集群上分发配置好的配置文件

xsync /opt/module/hadoop-3.1.3/etc/hadoop/

启动集群

第一次启动:格式化NameNode

hdfs namenode -format

启动HDFS

sbin/start-dfs.sh

web端:http://hadoop102:9870

启动YARN

sbin/start-yarn.sh

web端:http://hadoop103:8088

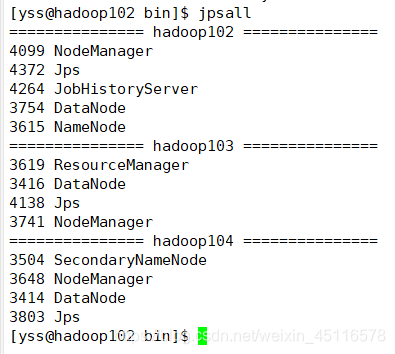

验证启动成功

jps

如果显示NameNode、DataNode、SencondaryNameNode、NodeManger、ResourceManger都启动了,即为成功。

如果集群出现崩溃,可以停用集群,删除DataNode中的信息(可以在hdfs-site.xml中找到目录,默认为\tmp),然后格式化,重新启动集群

写集群启停脚本

编写启停脚本:

cd bin/

vim myhadoop.sh

chmod 777 myhadoop.sh

编写jps查看脚本

cd bin/

vim jpsall

chomd 777 jpsall

集群分发

xsync bin/

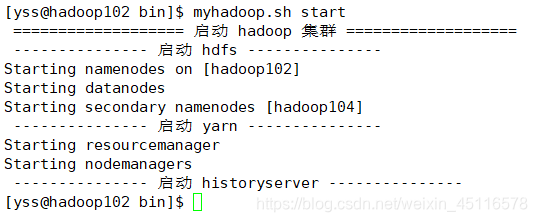

启动集群:myhadoop.sh start

查看jps:jpsall

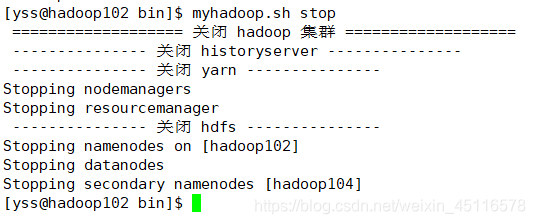

停用集群:myhadoop.sh stop