虚拟机上安装

1、将spark-3.1.2-bin-hadoop3.2.zip安装包传到download

2、解压 tar -zxvf spark-3.1.2-bin-hadoop3.2.zip -C /opt/software/

3、改名:mv spark-3.1.2-bin-hadoop3.2 spark312

4、进入:cd conf

5、改名:mv spark-env.sh.template spark-env.sh

6、vim spark-env.sh

7、增加:

export SPARK_MASTER_HOST=你的用户名

export SPARK_MASTER_PORT=7077

8、进入:vim /etc/profile.d/myenv.sh

9、增加:

export HADOOP_CONF_DIR=/opt/software/hadoop313/etc/hadoop

export SPARK_HOME=/opt/software/spark312

export PATH=$SPARK_HOME/bin:$SPARK_HOME/sbin:$PATH

10、激活环境变量:source /etc/profile

检查是否完成

//客户端访问

spark-shell 本地模式

//启动集群测试

start-master.sh

start-worker.sh spark://你的用户名:7077

本地系统变量配置

HADOOP_HOME D:\software\hadoop313

HADOOP_USER_NAME root

JAVA_HOME C:\Program Files\Java\jdk1.8.0_231

JRE_HOME C:\Program Files\Java\jre1.8.0_231

SCALA_HOME C:\Program Files (x86)\scala

Path %JAVA_HOME%\bin;%JRE_HOME%\bin;%SCALA_HOME%\bin;%HADOOP_HOME%\bin;...

CLASSPATH %JAVA_HOME%\lib\dt.jar;%JAVA_HOME%\lib\tools.jar

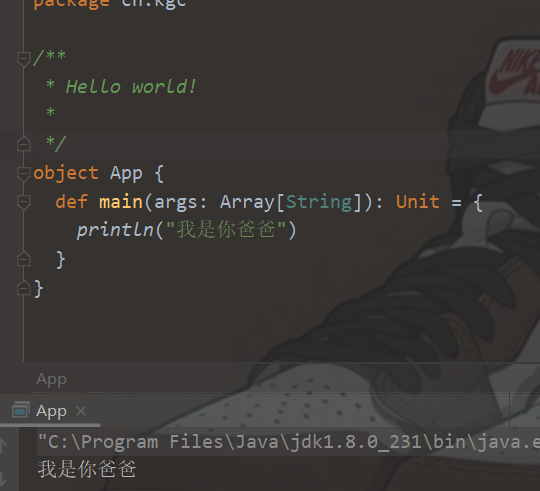

创建maven工程

选择这个创建,在pom文件里设置scala版本为2.12.10