完全分布式Hadoop搭建可参考一下网址

https://blog.csdn.net/weixin_44168245/article/details/118941000

搭建spark集群

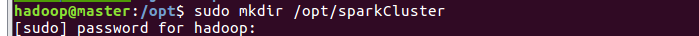

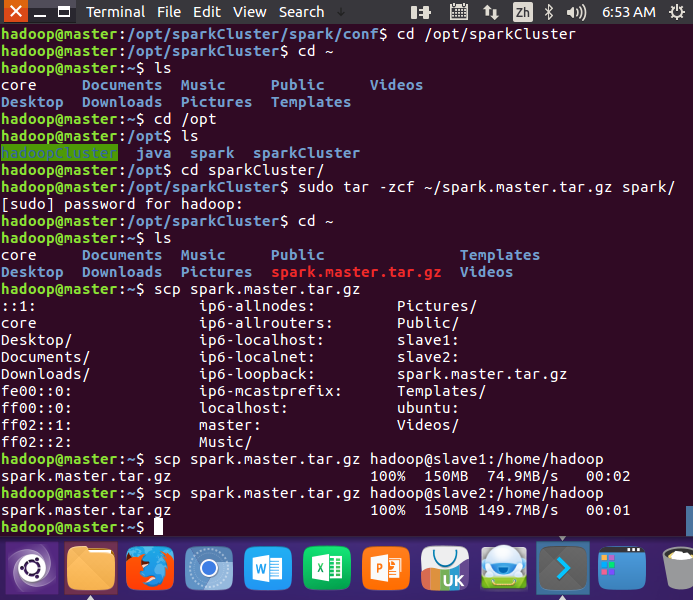

先创建一个sparkCluster文件夹

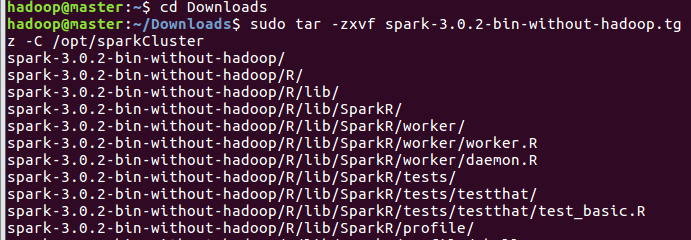

将spark包解压至sparkCluster中

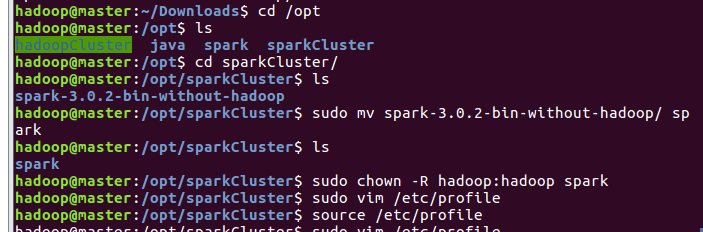

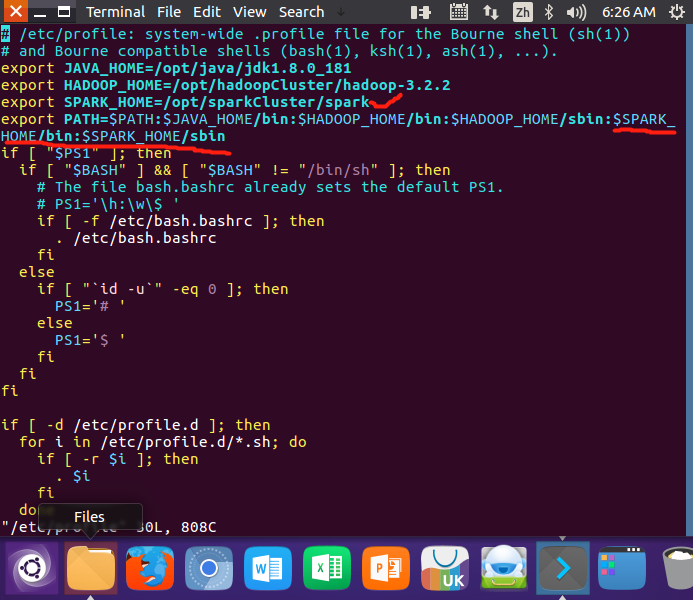

将解压后的文件名重命名为spark,同时把spark文件夹的权限赋给hadoop用户和hadoop组,最后配置环境变量

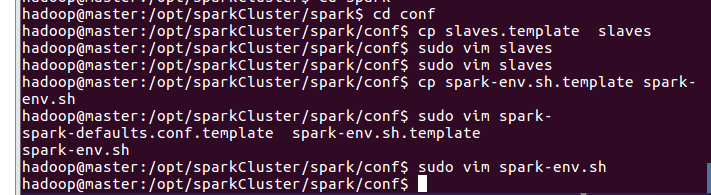

配置slaves文件和spark-env.sh文件(slaves文件设置Worker节点)

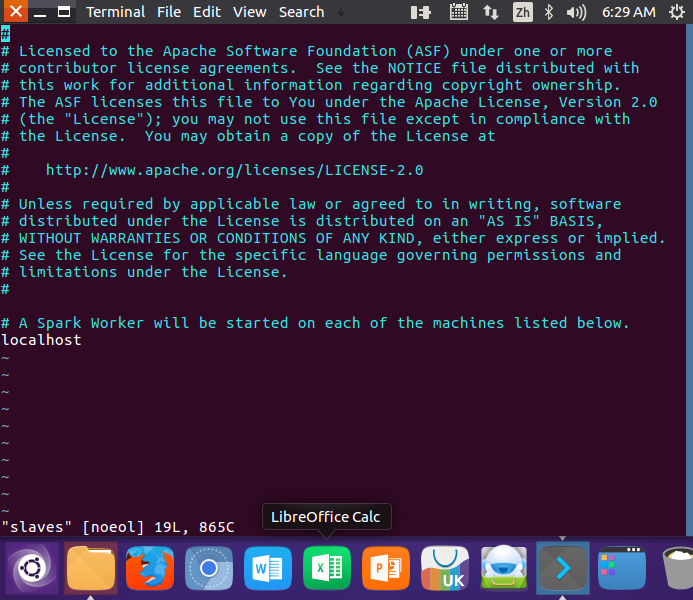

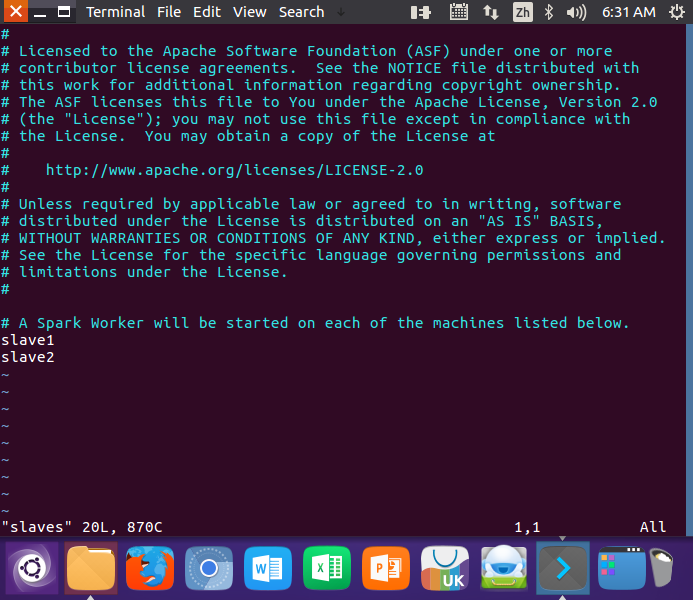

将 slaves.template 拷贝到 slaves,编辑slaves内容,把默认内容localhost替换成slave1,slave2

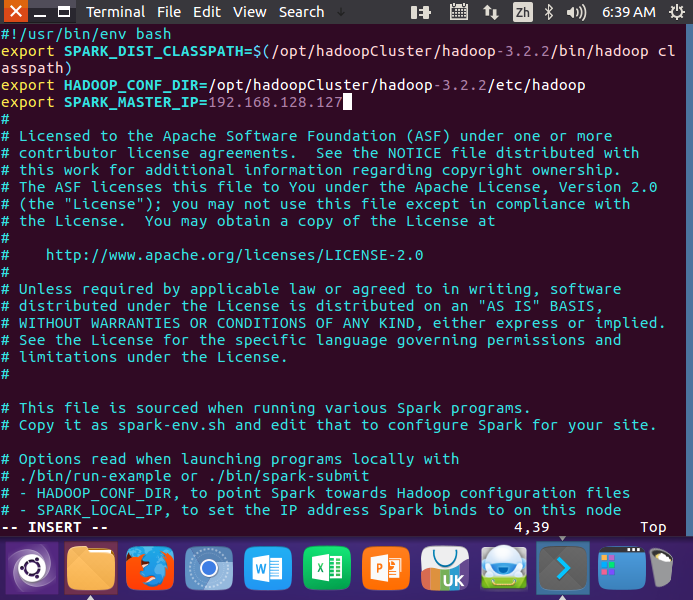

将 spark-env.sh.template 拷贝到 spark-env.sh,编辑spark-env.sh

slaves文件修改

spark-env.sh文件修改

配置好后,将Master主机上的/usr/local/spark文件夹复制到各个节点上

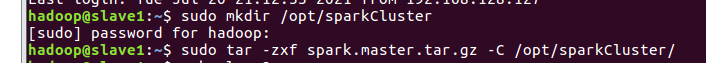

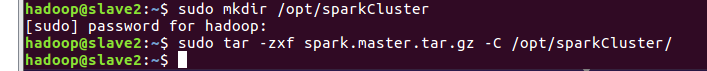

在slave01,slave02节点上将master复制过来的spark.master.tar.gz进行解压至指定文件夹

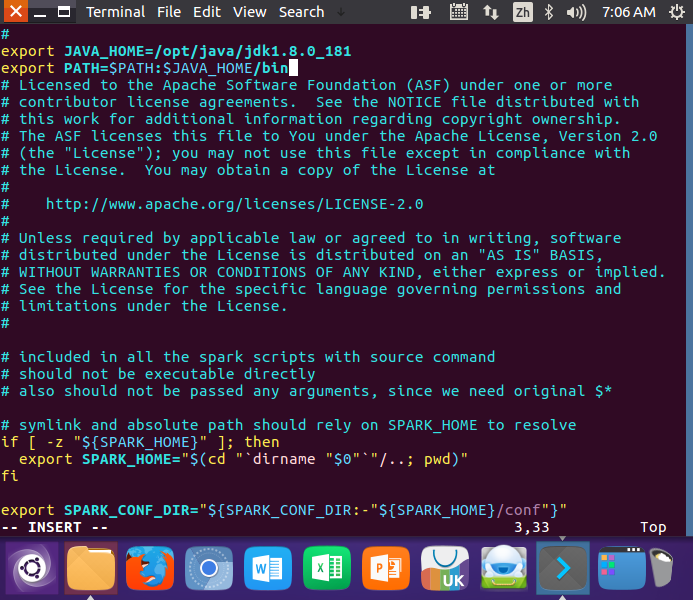

在slave1,slave2说修改spark-config.sh(不然启动集群会提示错误:JAVA_HOME is not set)

启动spark集群

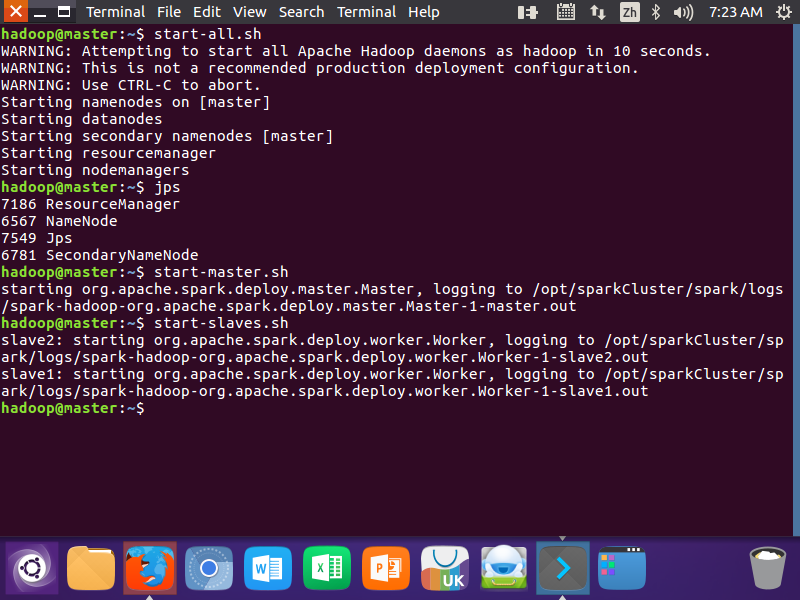

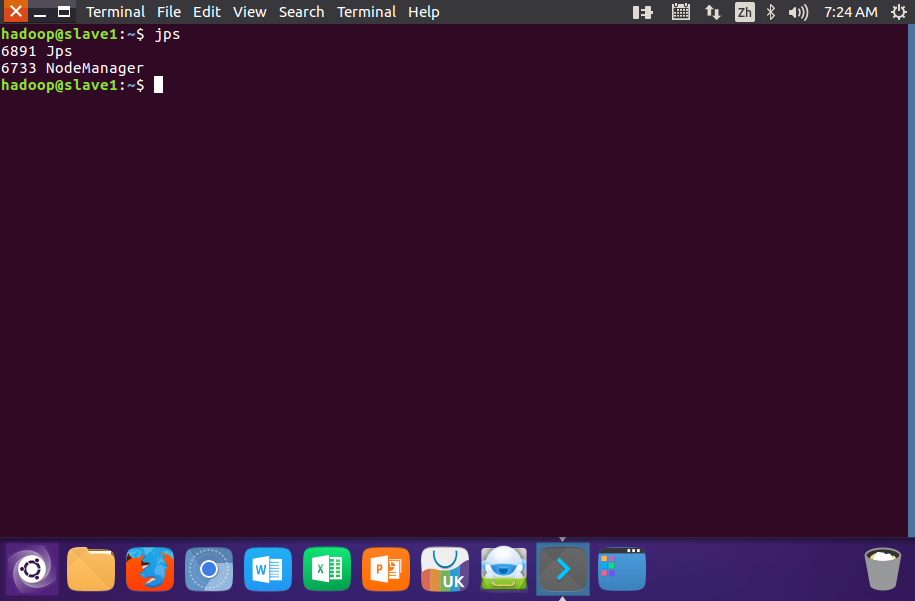

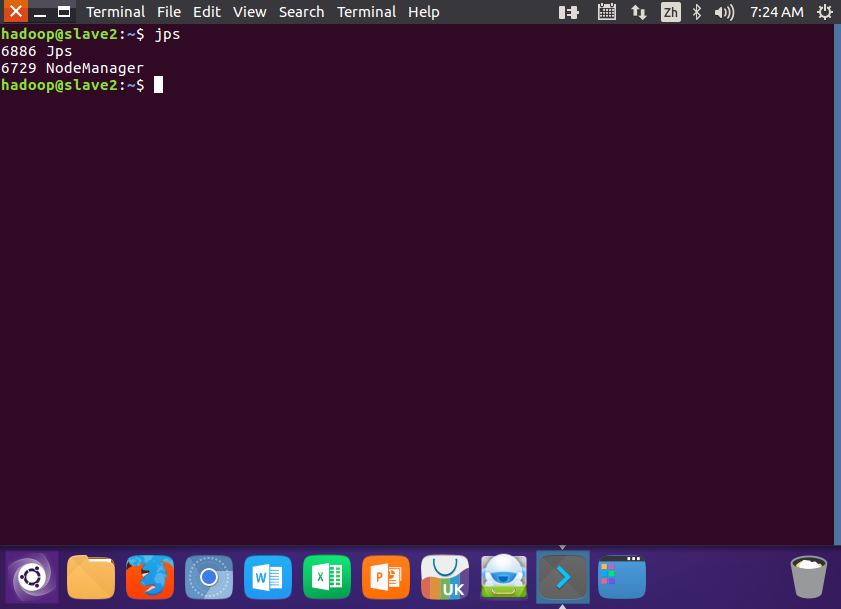

先启动Hadoop,再启动spark

- start-all.sh

- start-master.sh

- start-slaves.sh

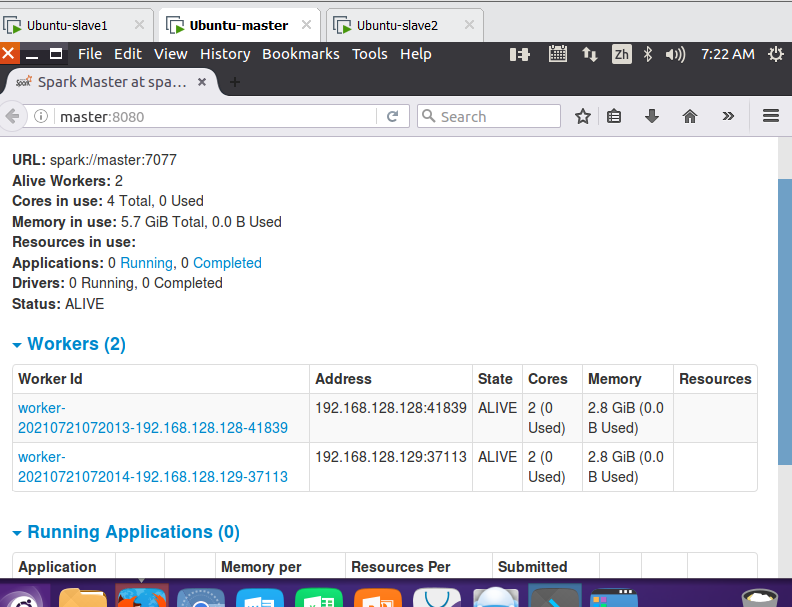

在浏览器上查看Spark独立集群管理器的集群信息

关闭Spark集群

- 关闭Master节点

stop-master.sh - 关闭Worker节点

stop-slaves.sh - 关闭Hadoop集群

stop-all.sh

运行

使用独立集群管理器

向独立集群管理器提交应用,需要把spark://master:7077作为主节点参数递给spark-submit

使用用Hadoop-Yarn集群管理器

向Hadoop YARN集群管理器提交应用,需要把yarn-client或yarn-cluster作为主节点参数递给spark-submit