1.spark环境搭建

1.1准备工作

1.JDK(linux安装)

2.ScalaSDK 本机安装wins上安装

3.Spark安装包

spark官网下载地址(官网下载地址)

传送门:阿里云下载

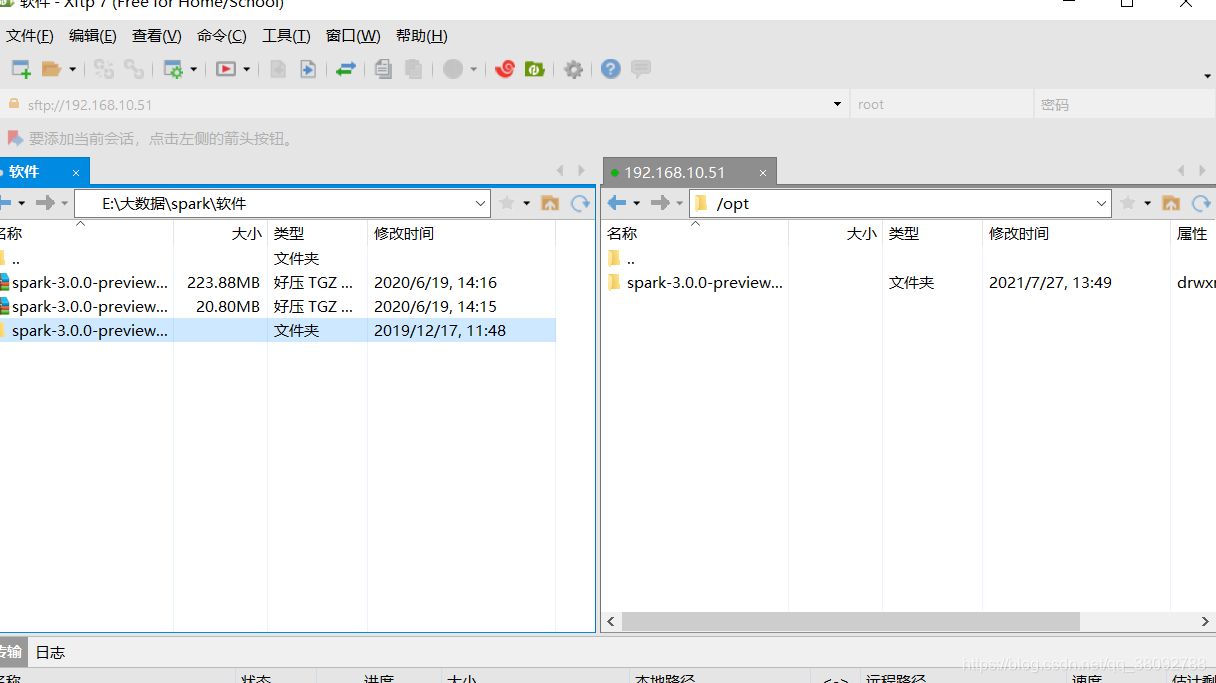

这是我下载好的spark-3.0.0-preview2-bin-hadoop2.7.tgz

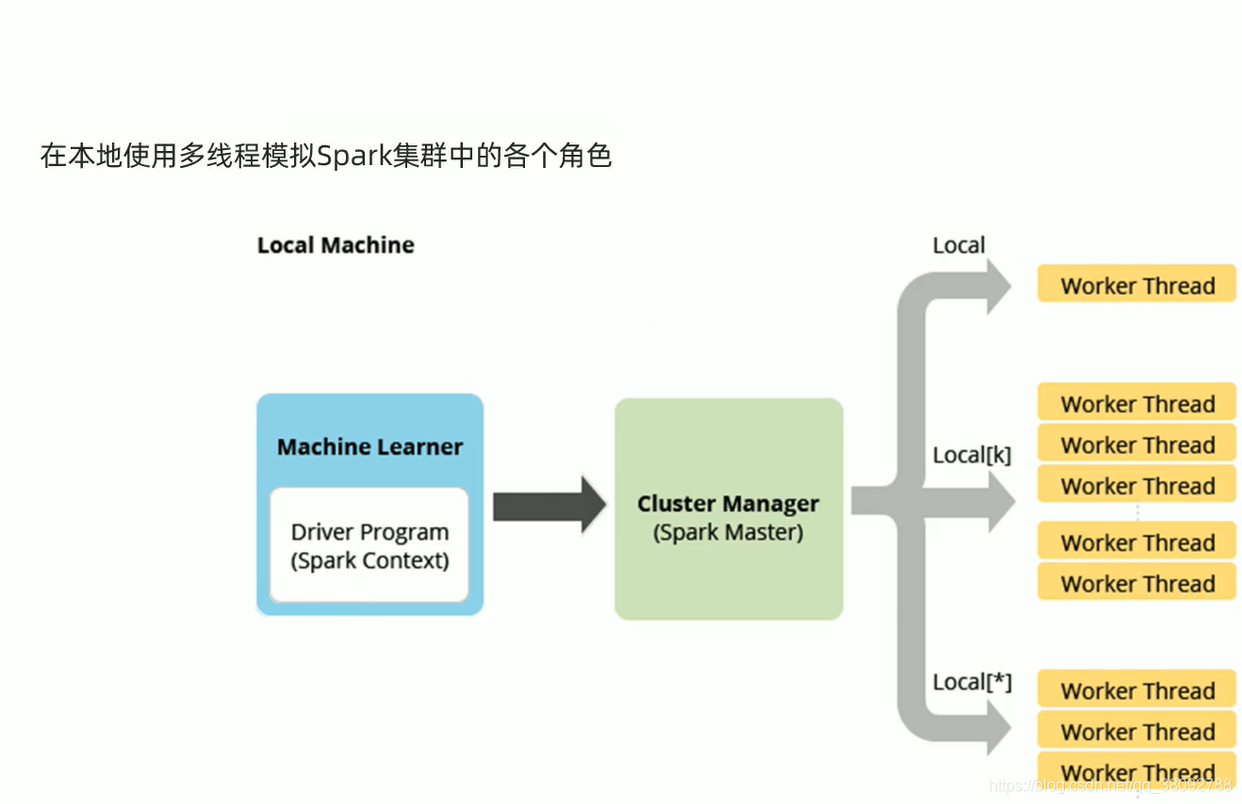

1.2原理

1.3操作

1.把文件上传到到服务器上spark-3.0.0-preview2-bin-hadoop2.7.tgb

2.解压tar -zxvf spark-3.0.0-preview2-bin-hadoop2.7.tgb

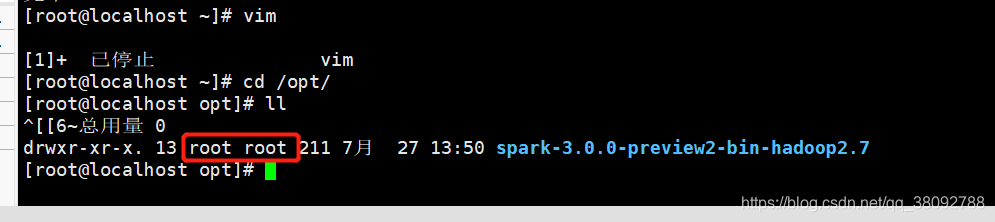

2.更改权限,如果你不是用的root上传的 需要更改权限

chown -R root /opt/spark-3.0.0-preview2-bin-hadoop2.7

-3.0.0-preview2-bin-hadoop2.7

看下这里权限显示root

名字太长了把名字改成spark

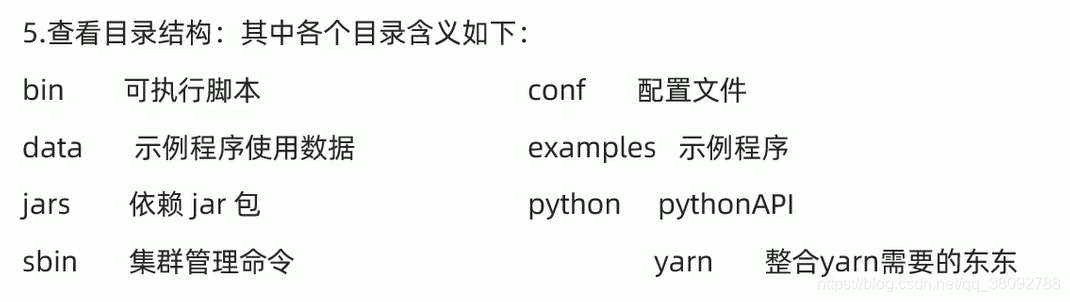

这些是目录下面的一些详解

1.4 测试

1.启动spark

/spark/bin/spark-shell

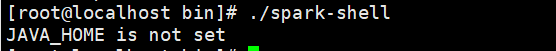

这个是没有java 环境配置jdk

安装jdk

yum -y list java*

yum install -y java-1.8.0-openjdk-devel.x86_64

java -version

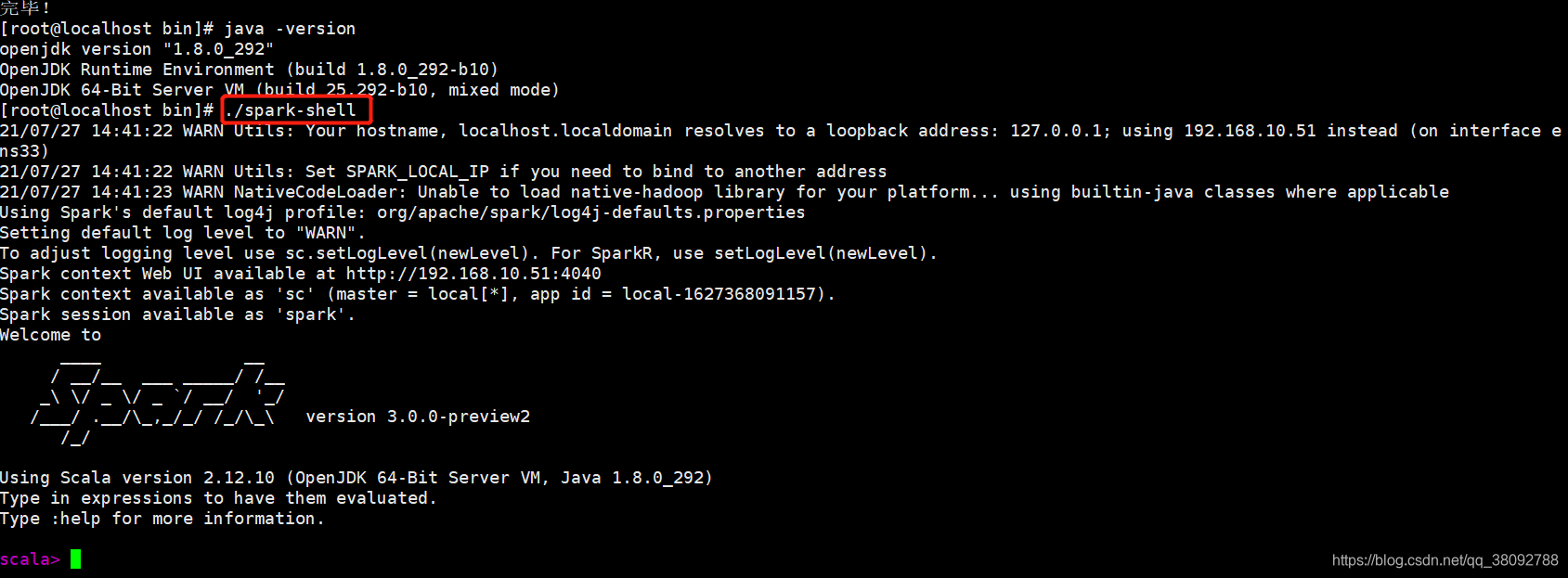

然后继续运行

/spark/bin/spark-shell

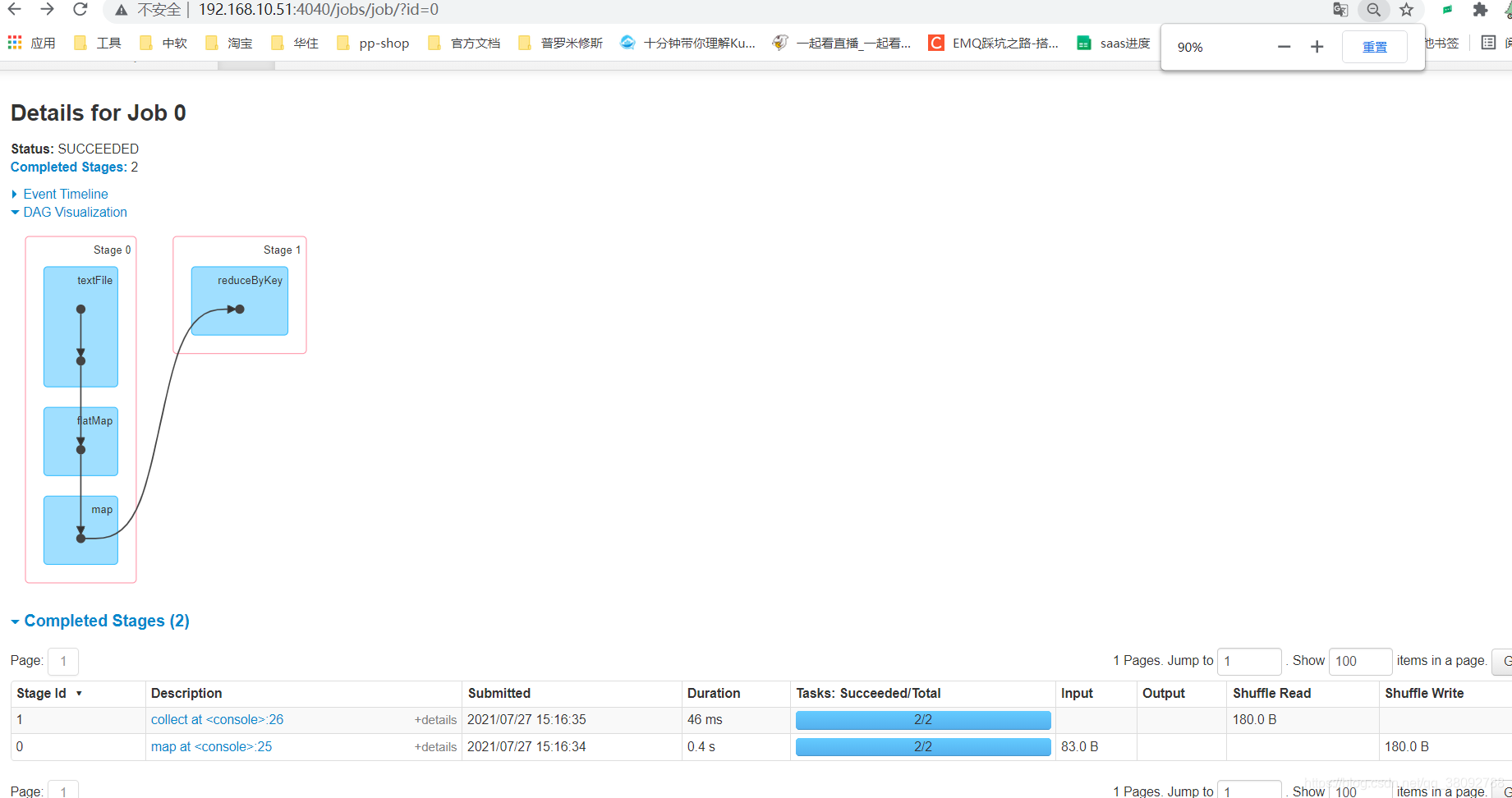

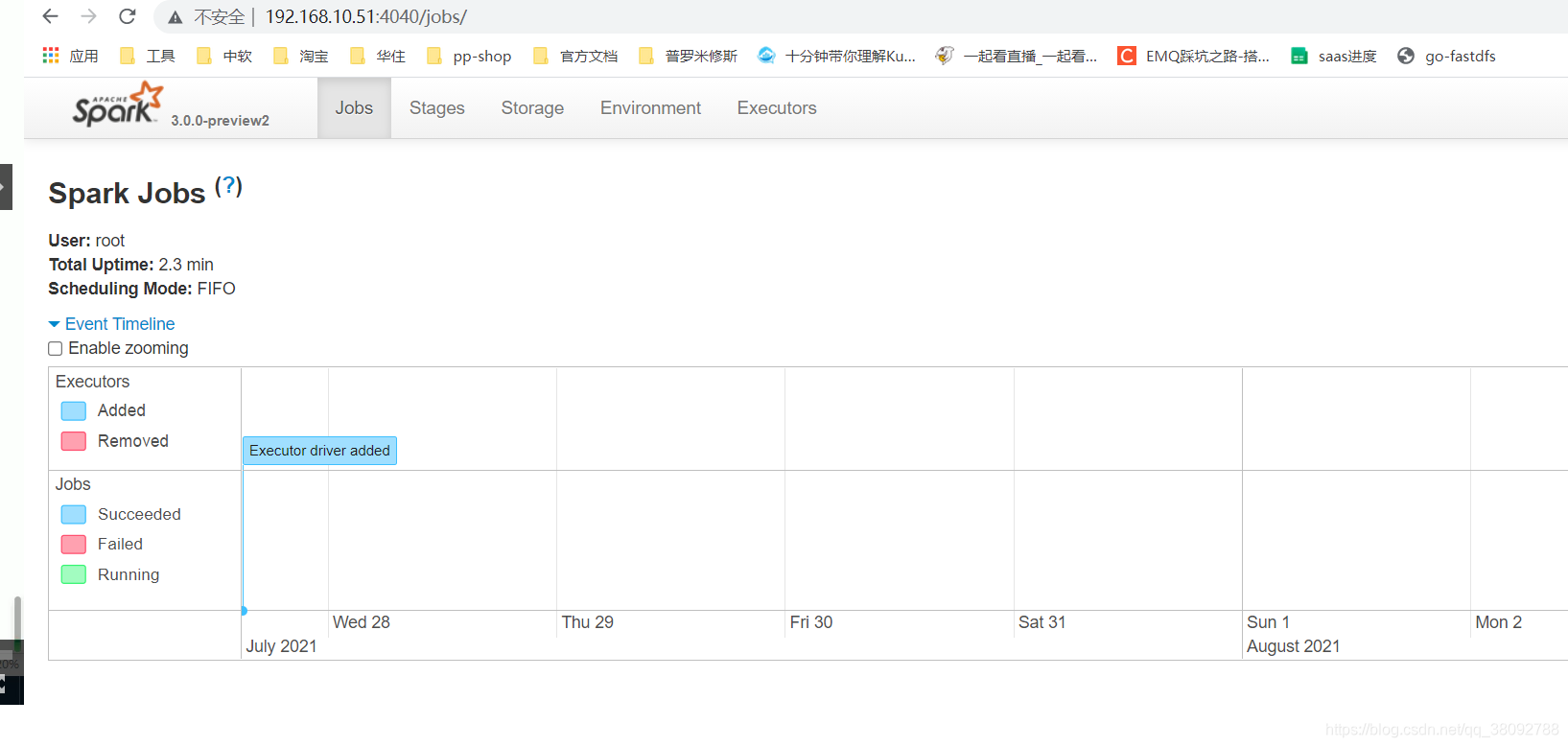

2.访问里面的那个4040端口的那个

http://192.168.10.51:4040

如果发现访问不到可能是防火墙开着的我们把防火墙给关掉

启动防火墙

systemctl start firewalld

关闭防火墙

systemctl stop firewalld

查看防火墙状态

systemctl status firewalld

部署完成

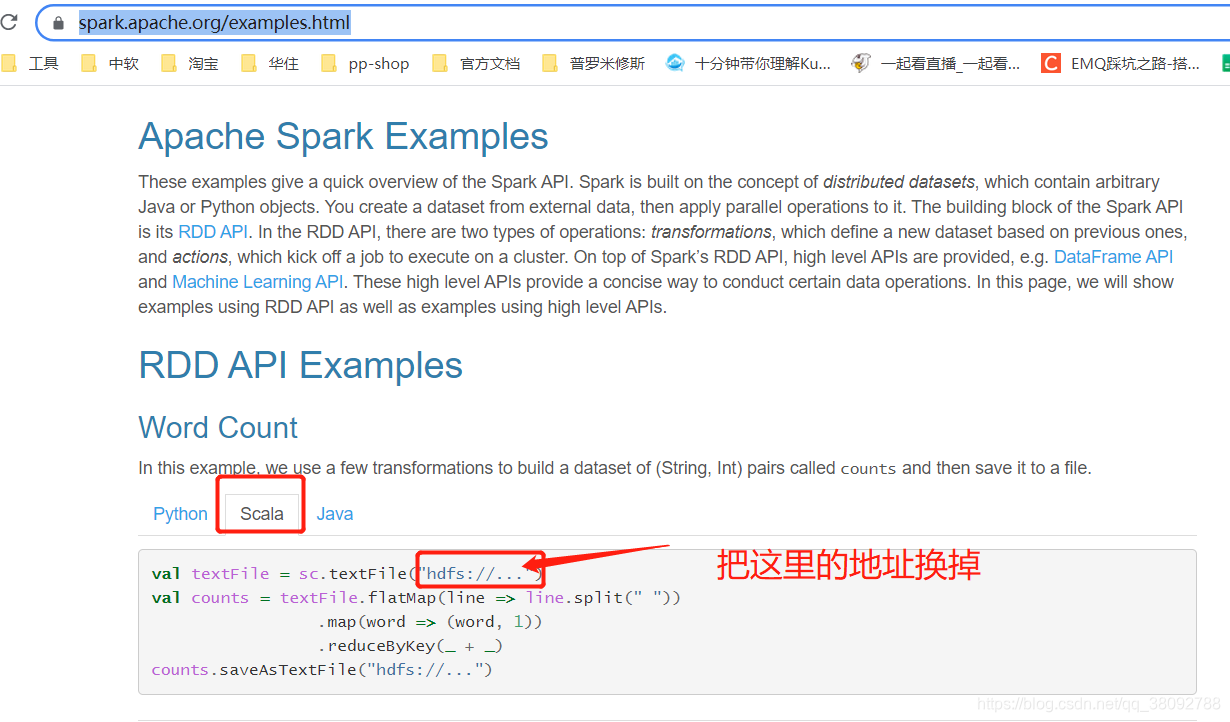

3.执行运行案例去官网里面拿一个案例,把路径换掉

https://spark.apache.org/examples.html

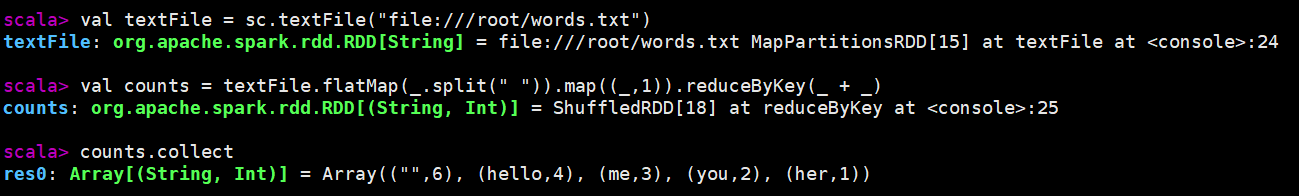

val textFile = sc.textFile("file:///root/words.txt")

val counts = textFile.flatMap(_.split(" ")).map((_, 1)).reduceByKey(_ + _)

counts.collect

回到我们刚刚那个网站刷新可以看到任务的流程图