linux安装ik分词器

- 下载

2.解压

在elasticsearch中的plugins目录下建一个ik目录

将压缩包放在ik目录下

unzip 压缩包名

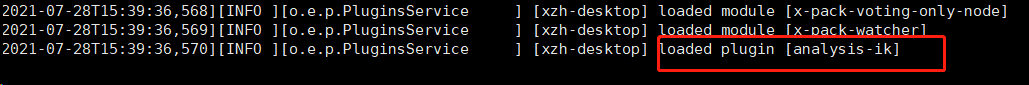

3.重启es

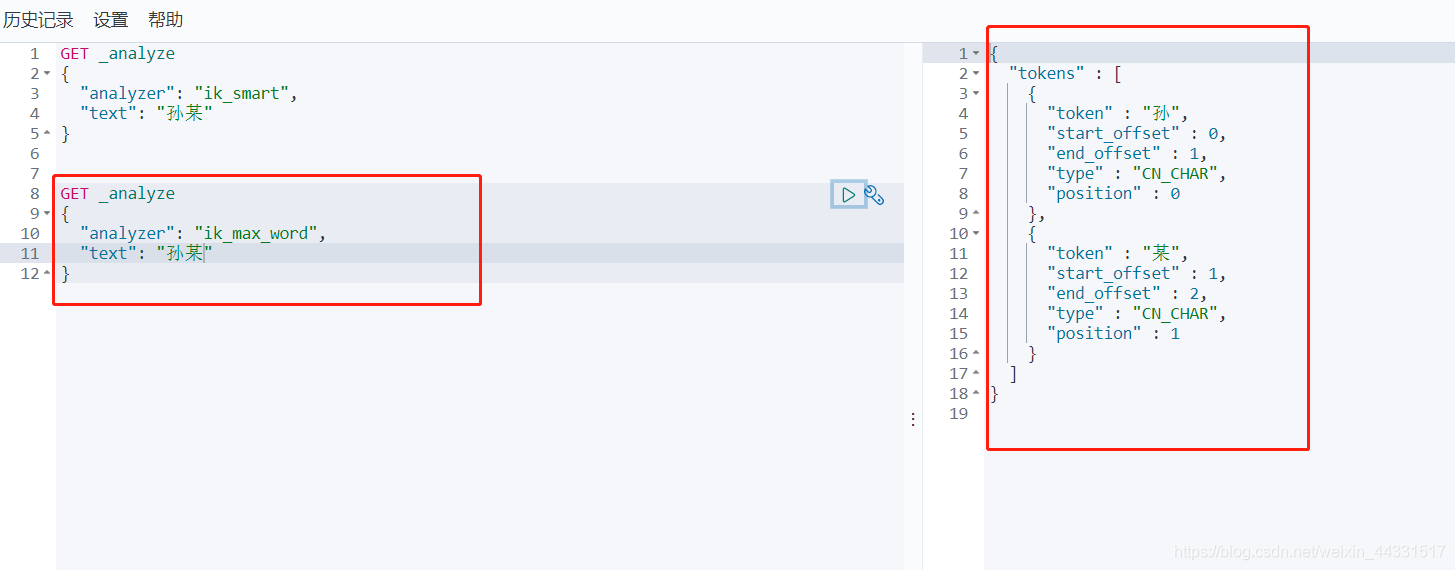

成功启动后,可以使用kibana验证下分词器的效果

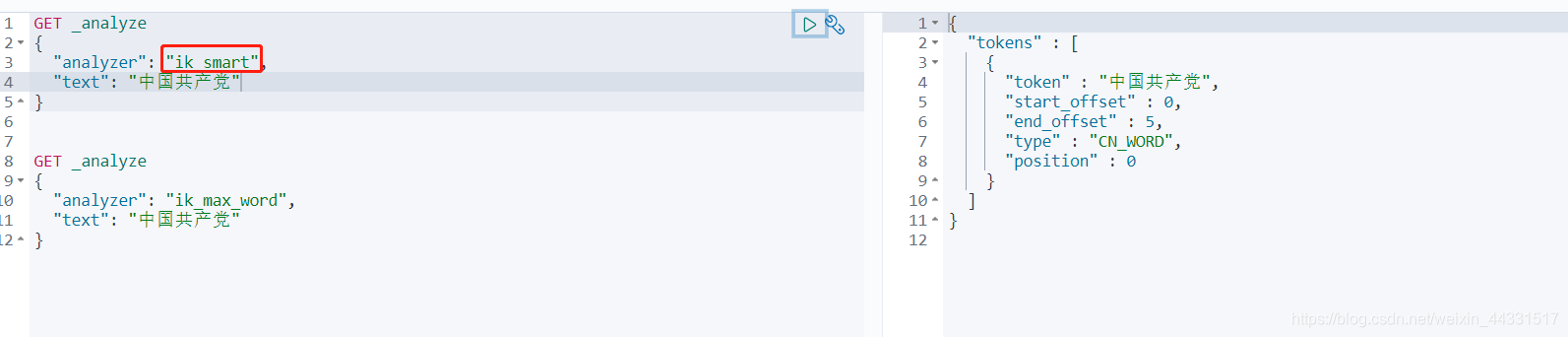

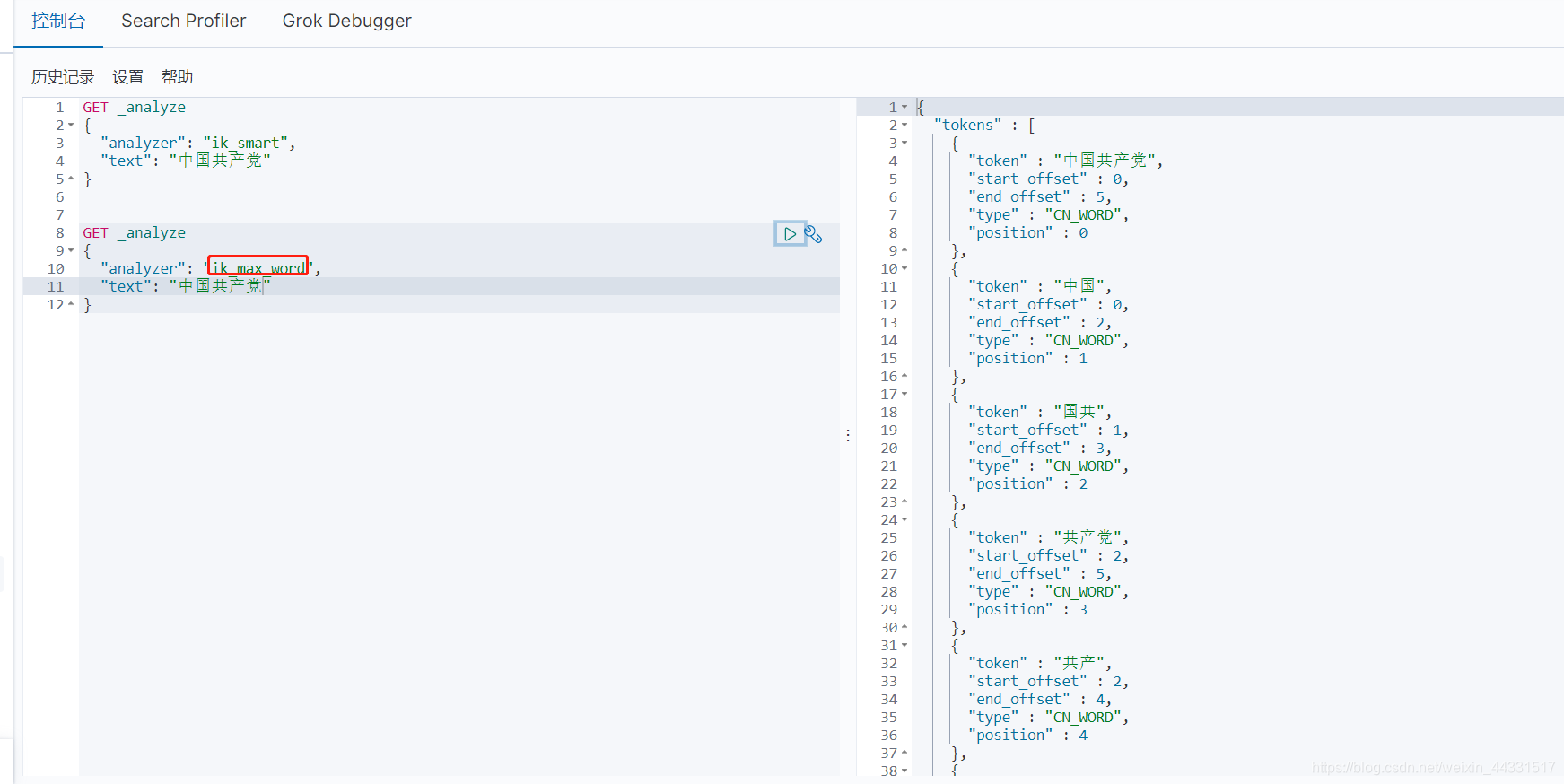

Ik分词器提供两个分词算法 ik_smart(最少切分)和ik_max_word(最细粒度划分)

IK分词器配置自定义词汇

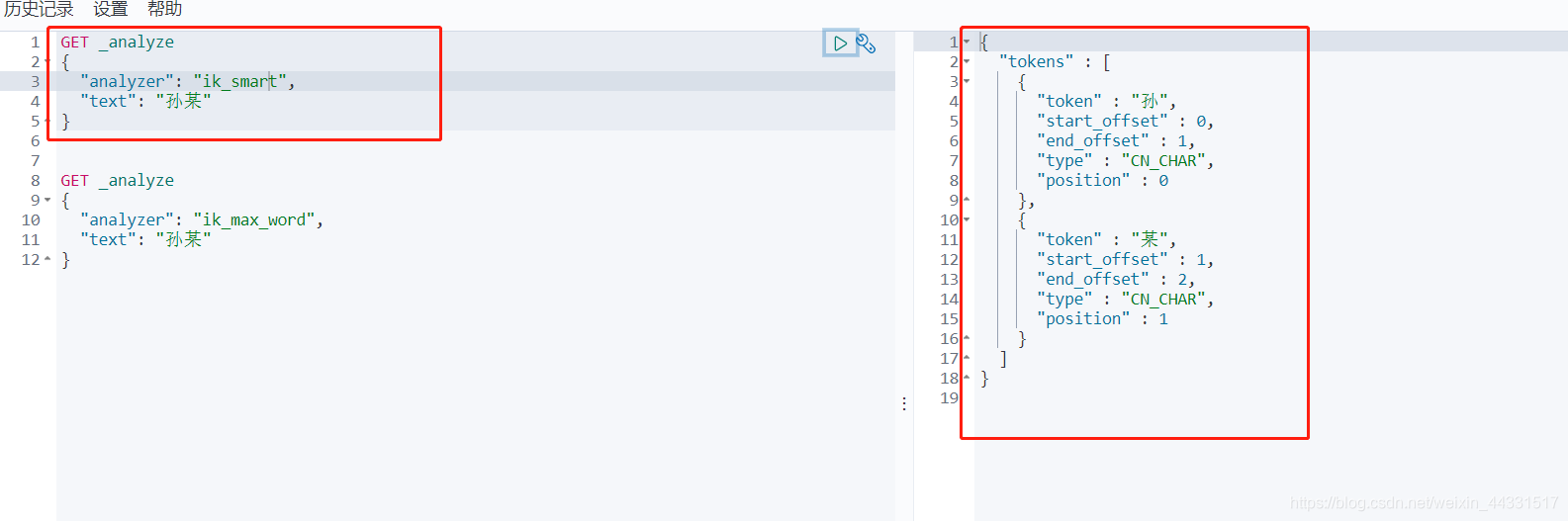

从上面两种分词算法中发现,不管哪种算法 孙某都被分成两个词,而我们想要孙某作为一个词被搜索,就需要在ik分词器中配置我们自定义的词汇

创建自己的词汇文件 *.dic文件

vim ./config/my_dic.dic

此时打开了一个新的文件

在第一行插入 孙某

并使用:wq保存退出

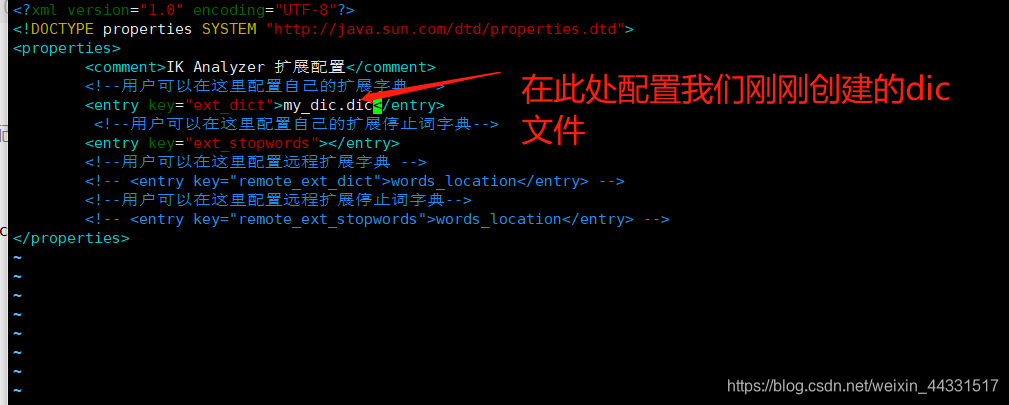

将我们自己创建的dic文件配置到配置中

vim ./config/IKAnalyzer.cfg.xml

保存退出

重启es

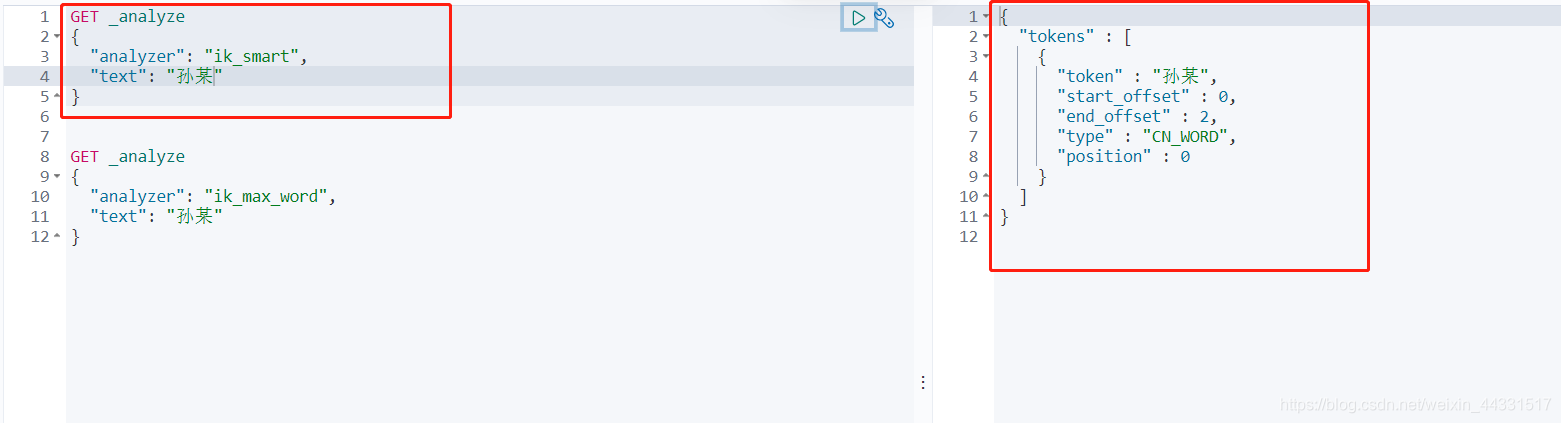

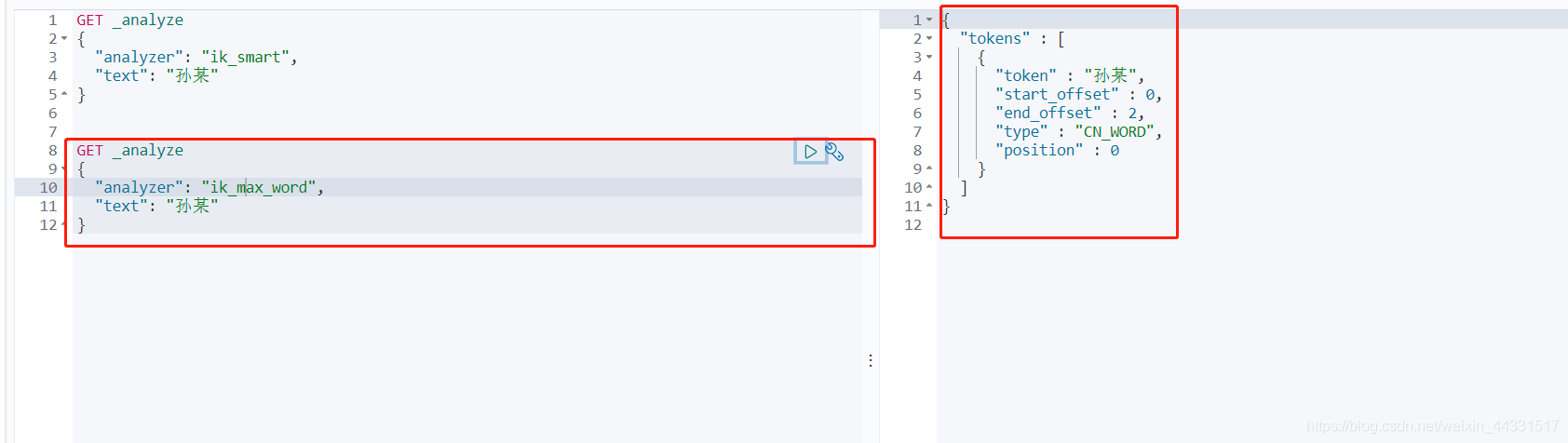

然后我们再用kibana测试以下

此时孙某在分词时已经被作为一个词