win10安装spark及其环境配置

所需安装包

- JDK + 环境配置

- Hadoop + 环境配置

- Spark + 环境配置

- Scala + 环境配置

1. JDK

jdk官网下载:根据自己电脑环境来选择版本安装,博主自己安装的是jdk13(以前就装好的)

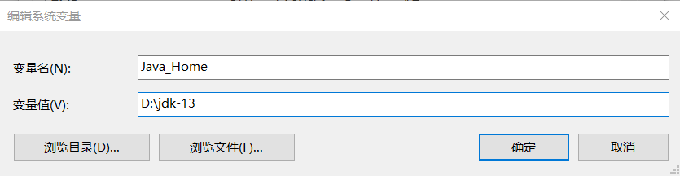

然后在环境变量中添加路径:

- 新增

变量名:JAVA_HOME

变量值: jdk安装路径

- 变量名: CLASSPATH

变量值:%JAVA_HOME%\lib

- Path 中添加:%JAVA_HOME%\bin

2. Hadoop

Hadoop官网下载:根据自己需求下载对应版本

解压Hadoop安装包需要用管理员权限来解压

在环境变量中

新增 变量名:HADOOP_HOME

变量值: Hadoop安装路径

在Path 中添加:%HADOOP_HOME%\bin

3. Spark & Scala

spark官网下载

scala官方下载

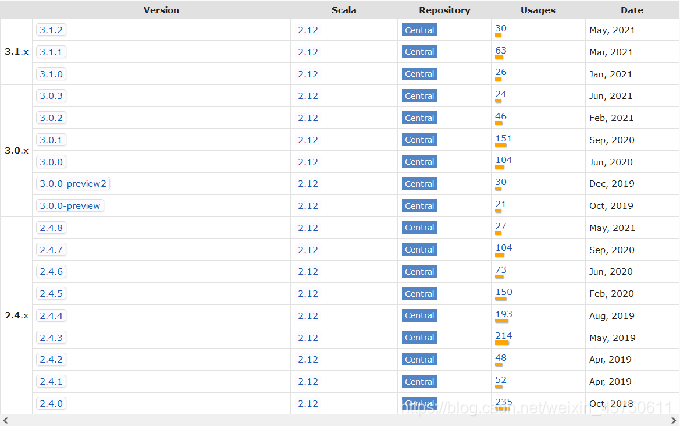

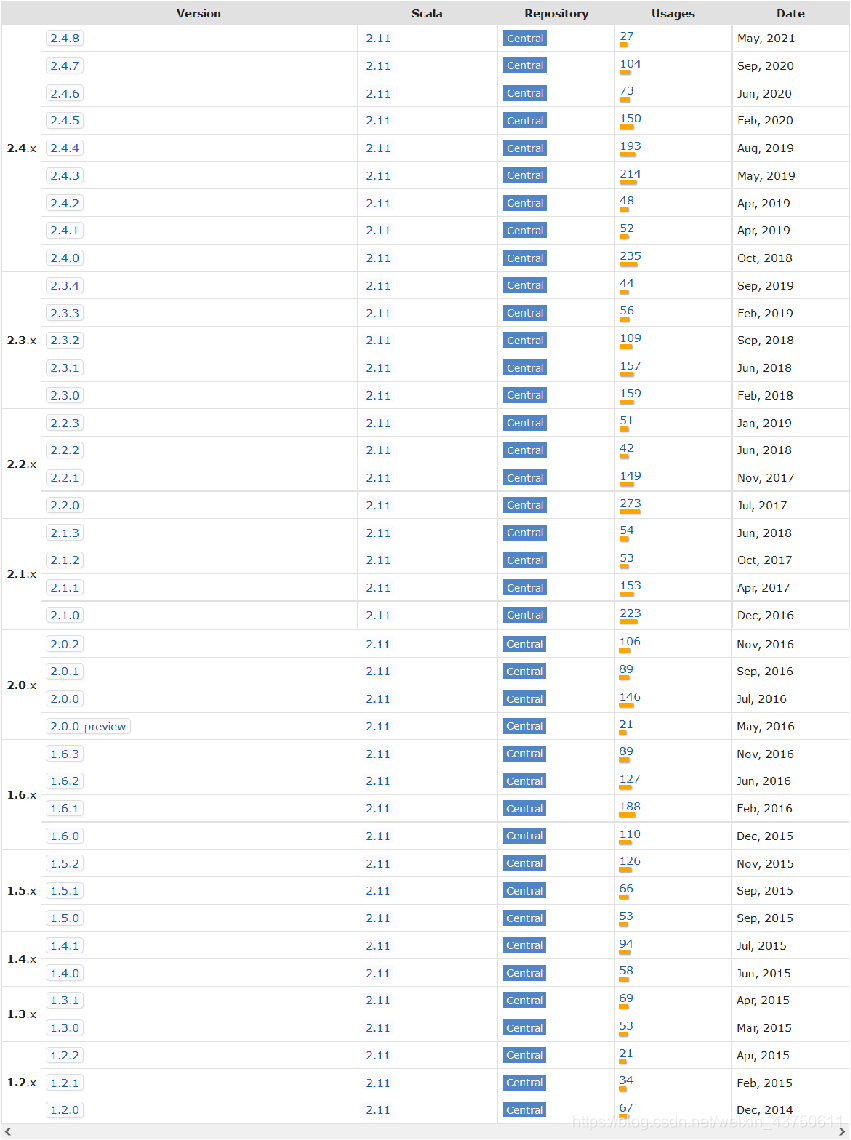

由于spark不同版本有自己对应的scala的版本,在下载spark和scala时需要找好对应一致的版本下载

在环境变量中

新增 变量名:SPARK_HOME

变量值: spark安装路径

在Path 中添加:%SPARK_HOME%\bin

%SPARK_HOME%\sbin

(spark和scala 版本对应关系)

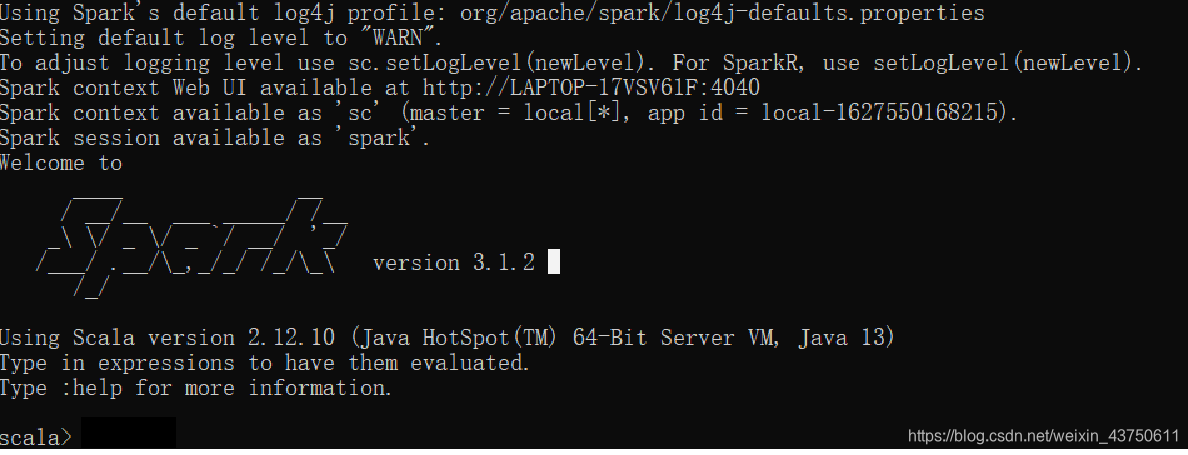

验证是否成功

在cmd中输入命令:spark-shell

可以看到spark安装成功: