1.安装kafka(CentOS安装Kafka2.7.0)

安装前确保JAVA环境是正常的

1.1 更新系统

#sudo yum install epel-release -y

#sudo yum update -y

1.2 安装Kafka

从kafka官网上下载kafka的二进制安装包,下载地址是:https://mirrors.tuna.tsinghua.edu.cn/apache/kafka/2.7.0/kafka_2.13-2.7.0.tgz,下载下来之后进行解压。

解压:#sudo tar -zvxf kafka_2.12-2.4.0.tgz -C? /opt/

解压文件成功之后,接着创建一个文件的软连接,这样可以方便进行kafka的升级。

#sudo ln -s /opt/kafka_2.12-2.4.0 /opt/kafka

?

?

?接下来,进入到kafka目录下,启动kafka,启动kafka之前得先启动zookeeper。

# cd /opt/kafka/bin

# sudo ./zookeeper-server-start.sh ../config/zookeeper.properties

?启动成功之后重开一个xshell窗口进行启动Kafka

# cd /opt/kafka/bin

# sudo ./kafka-server-start.sh ../config/server.properties

注意:启动时可能会因为centos的内存问题造成启动失败,可以修改kafka配置文件配置内存大小

# vim /opt/kafka/bin/kafka-server.start.sh

找到:export KAFKA_HEAP_OPTS="-Xmx1G -Xms1G"

修改成:?export KAFKA_HEAP_OPTS="-Xmx512M -Xms265M"

?2.安装成功之后就可以开始测试了

先通过kafka创建一个topic。进入到kafka目录下,接着通过下面命令创建一个kafka topic。

# cd /opt/kafka

#?bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic testTopic

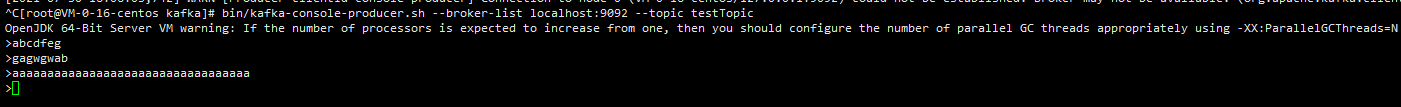

接下来通过生产者进行发送消息。

# bin/kafka-console-producer.sh --broker-list localhost:9092 --topic testTopic?

?

?

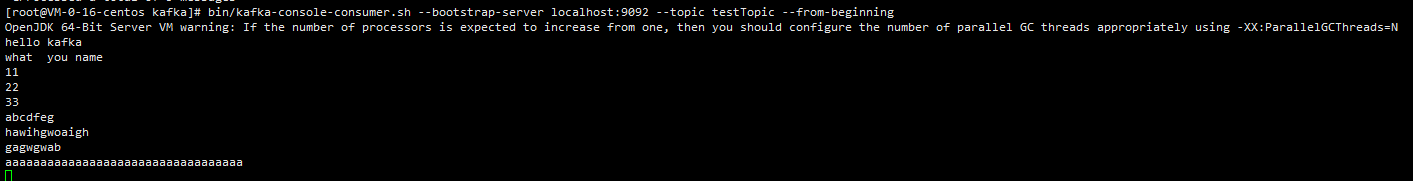

?接着新开一个xshell窗口创建一个消费者来进行接收消息。

# cd /opt/kafka

#?

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic testTopic --from-beginning

?到处我们的Kafka就安装成功了。

3.Springboot集成Kafka

先在pom.xml中添加kafka依赖

<!-- kafka -->

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

</dependency>

然后在application.yml中添加kafka配置

spring: kafka: # IP和端口 bootstrap-servers: 106.55.150.62:9092 producer: # 发生错误后,消息重发的次数。 retries: 0 #当有多个消息需要被发送到同一个分区时,生产者会把它们放在同一个批次里。该参数指定了一个批次可以使用的内存大小,按照字节数计算。 batch-size: 16384 # 设置生产者内存缓冲区的大小。 buffer-memory: 33554432 # 键的序列化方式 key-serializer: org.apache.kafka.common.serialization.StringSerializer # 值的序列化方式 value-serializer: org.apache.kafka.common.serialization.StringSerializer # acks=0 : 生产者在成功写入消息之前不会等待任何来自服务器的响应。 # acks=1 : 只要集群的首领节点收到消息,生产者就会收到一个来自服务器成功响应。 # acks=all :只有当所有参与复制的节点全部收到消息时,生产者才会收到一个来自服务器的成功响应。 acks: 1 consumer: # 自动提交的时间间隔 在spring boot 2.X 版本中这里采用的是值的类型为Duration 需要符合特定的格式,如1S,1M,2H,5D auto-commit-interval: 1S # 该属性指定了消费者在读取一个没有偏移量的分区或者偏移量无效的情况下该作何处理: # latest(默认值)在偏移量无效的情况下,消费者将从最新的记录开始读取数据(在消费者启动之后生成的记录) # earliest :在偏移量无效的情况下,消费者将从起始位置读取分区的记录 auto-offset-reset: earliest # 是否自动提交偏移量,默认值是true,为了避免出现重复数据和数据丢失,可以把它设置为false,然后手动提交偏移量 enable-auto-commit: false # 键的反序列化方式 key-deserializer: org.apache.kafka.common.serialization.StringDeserializer # 值的反序列化方式 value-deserializer: org.apache.kafka.common.serialization.StringDeserializer listener: # 在侦听器容器中运行的线程数。 concurrency: 5 #listner负责ack,每调用一次,就立即commit ack-mode: manual_immediate missing-topics-fatal: false?

创建消息生产者

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.kafka.support.SendResult;

import org.springframework.stereotype.Component;

import org.springframework.util.concurrent.ListenableFuture;

import org.springframework.util.concurrent.ListenableFutureCallback;

@Component

public class KafkaProducer {

@Autowired

private KafkaTemplate<String, Object> kafkaTemplate;

//自定义topic

public static final String TOPIC_TEST = "testTopic";

public static final String TOPIC_GROUP1 = "topic.group1";

public static final String TOPIC_GROUP2 = "topic.group2";

public void send(Object obj) {

//发送消息

ListenableFuture<SendResult<String, Object>> future = kafkaTemplate.send(TOPIC_TEST, obj);

future.addCallback(new ListenableFutureCallback<SendResult<String, Object>>() {

@Override

public void onFailure(Throwable throwable) {

//发送失败的处理

System.out.println(TOPIC_TEST + " - 生产者 发送消息失败:" + throwable.getMessage());

}

@Override

public void onSuccess(SendResult<String, Object> stringObjectSendResult) {

//成功的处理

System.out.println(TOPIC_TEST + " - 生产者 发送消息成功:" + stringObjectSendResult.toString());

}

});

}

}

?创建消息消费者

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.springframework.kafka.annotation.KafkaListener;

import org.springframework.kafka.support.Acknowledgment;

import org.springframework.kafka.support.KafkaHeaders;

import org.springframework.messaging.handler.annotation.Header;

import org.springframework.stereotype.Component;

import java.util.Optional;

@Component

public class KafkaConsumer {

@KafkaListener(topics = KafkaProducer.TOPIC_TEST, groupId = KafkaProducer.TOPIC_GROUP1)

public void topic_test(ConsumerRecord<?, ?> record, Acknowledgment ack, @Header(KafkaHeaders.RECEIVED_TOPIC) String topic) {

Optional message = Optional.ofNullable(record.value());

if (message.isPresent()) {

Object msg = message.get();

System.out.println("topic_test 消费了: Topic:" + topic + ",Message:" + msg);

ack.acknowledge();

}

}

}新建一个接口测试发送消息

import com.euraka.es.elasticsearch.mq.kafka.KafkaProducer;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RestController;

@RestController

public class MessageController {

@Autowired

private KafkaProducer kafkaProducer;

@GetMapping("/kafka/{message}")

public String send(@PathVariable String message) {

kafkaProducer.send(message);

return "OK";

}

}测试接口,可以看到消息发送成功,并且成功消费

?到此我们的kafka入门就已完成。

我也是刚学习Kafka,记录一下学习经过。文章是通过别人的博客学习加上自己的总结。

借鉴博客:https://www.cnblogs.com/Hackerman/p/12595246.html,https://blog.csdn.net/zhou_fan_xi/article/details/105241273