文章目录

实时数仓搭建

一、实时数仓介绍

普通实时计算和实时数仓比较

普通的实时计算优先考虑时效性,所以从数据源采集经过实时计算直接得到结果。如此做时效性更好,但是

弊端是由于计算过程中的中间结果没有沉淀下来,所以当面对大量实时需求的时候,计算的复用性较差,开发成本随着需求增加直线上升。

实时数仓基于一定的数据仓库理念,对数据处理流程进行规划、分层,目的是提高数据的复用性。

实时数仓的分层

ODS(Kafka)

原始数据,日志和业务数据

DWD(Kafka)

? 根据数据对象为单位进行分流,比如订单、页面访问等等

DIM(Hbase)

? 维度数据

DWM(Kafka)

? 对于部分数据对象进行进一步加工,比如独立访问、跳出行为,也可以和维度进行关联,形成宽表,依旧是明细数据。

DWS(Hbase)

? 根据某个主题将多个事实数据轻度聚合,形成主题宽表。

ADS

? 把Clickhouse中的数据根据可视化需要进行筛选聚合

二、实时需求概览

离线计算与实时计算的比较

离线计算:就是在计算开始前已知所有输入数据,输入数据不会产生变化,一般计算量级较大,计算时间也较长。例如今天早上一点,把昨天累积的日志,计算出所需结果。最经典的就是Hadoop的MapReduce方式;

一般是根据前一日的数据生成报表,虽然统计指标、报表繁多,但是对时效性不敏感。从技术操作的角度,这部分属于批处理的操作。即根据确定范围的数据一次性计算。

实时计算:输入数据是可以以序列化的方式一个个输入并进行处理的,也就是说在开始的时候并不需要知道所有的输入数据。与离线计算相比,运行时间短,计算量级相对较小。强调计算过程的时间要短,即所查当下给出结果。

主要侧重于对当日数据的实时监控,通常业务逻辑相对离线需求简单一下,统计指标也少一些,但是更注重数据的时效性,以及用户的交互性。从技术操作的角度,这部分属于流处理的操作。根据数据源源不断地到达进行实时的运算。

实时需求种类

日常统计报表或分析图中需要包含当日部分

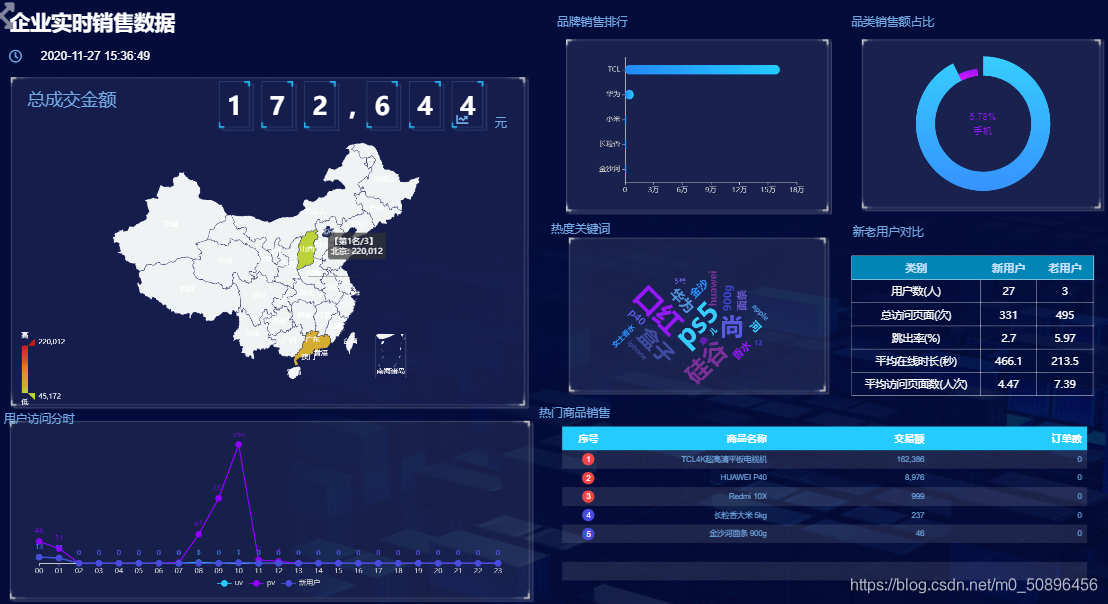

实时数据大屏监控

数据预警或提示

经过大数据实时计算得到的一些风控预警、营销信息提示,能够快速让风控或营销部分得到信息,以便采取各种应对。

实时推荐系统

实时推荐就是根据用户的自身属性结合当前的访问行为,经过实时的推荐算法计算,从而将用户可能喜欢的商品、新闻、视频等推送给用户。

三、日志数据模拟

模拟日志生成器的使用

(1)在**/opt/module目录下创建gmall-flink**目录

(2)在gmall-flink中创建rt_applog目录

(3)将gmall2020-mock-log-2020-12-18.jar和application.yml

拷贝到**/opt/module/gmall-flink/rt_applog**中

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-AO9CgIcM-1627787033360)(D:\实时数仓\捕获7.PNG)]

(4)运行jar包

java -jar gmall2020-mock-log-2020-12-18.jar

目前没有地址接受日志,所以会运行错误

日志采集模块-本地测试

Springboot简介

Spring Boot 是由 Pivotal 团队提供的全新框架,其设计目的是用来简化新 Spring 应用的初始搭建以及开发过程。 该框架使用了特定的方式来进行配置,从而使开发人员不再需要定义样板化的配置。

快速搭建Springboot程序gmall2021-logger,采集模拟生成的日志数据

(1)在IDEA中安装lombok插件

安装后重启IDEA即可

(2)创建空的maven工程com.atguigu,用于管理后续所有的模块module

(3)在pom文件下添加依赖

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.atguigu.gmall</groupId>

<artifactId>gmall2021-logger</artifactId>

<version>0.0.1-SNAPSHOT</version>

<name>gmall2021-logger</name>

<description>Demo project for Spring Boot</description>

<properties>

<java.version>1.8</java.version>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<project.reporting.outputEncoding>UTF-8</project.reporting.outputEncoding>

<spring-boot.version>2.4.1</spring-boot.version>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>

<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-dependencies</artifactId>

<version>${spring-boot.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>3.8.1</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

<encoding>UTF-8</encoding>

</configuration>

</plugin>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

<version>2.4.1</version>

<configuration>

<mainClass>com.atguigu.gmall.GmallLoggerApplication</mainClass>

</configuration>

<executions>

<execution>

<id>repackage</id>

<goals>

<goal>repackage</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

</project>

(4)修改SpringBoot核心配置文件application.propeties

# 应用名称

spring.application.name=gmall-logger

# 应用服务 WEB 访问端口

server.port=8081

#============== kafka ===================

# 指定kafka 代理地址,可以多个

spring.kafka.bootstrap-servers=hadoop103:9092

# 指定消息key和消息体的编解码方式

spring.kafka.producer.key-serializer=org.apache.kafka.common.serialization.StringSerializer

spring.kafka.producer.value-serializer=org.apache.kafka.common.serialization.StringSerializer

创建logback.xml文件,添加

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<property name="LOG_HOME" value="/opt/module/gmall-flink/rt_applog/logs" />

<appender name="console" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>%msg%n</pattern>

</encoder>

</appender>

<appender name="rollingFile" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${LOG_HOME}/app.log</file>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<fileNamePattern>${LOG_HOME}/app.%d{yyyy-MM-dd}.log</fileNamePattern>

</rollingPolicy>

<encoder>

<pattern>%msg%n</pattern>

</encoder>

</appender>

<!-- 将某一个包下日志单独打印日志 -->

<logger name="com.atguigu.gmalllogger.controller.LoggerController"

level="INFO" additivity="false">

<appender-ref ref="rollingFile" />

<appender-ref ref="console" />

</logger>

<root level="error" additivity="false">

<appender-ref ref="console" />

</root>

</configuration>

创建LoggerController类

package com.atguigu.gmalllogger.controller;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

//@RestController = @ResponseBody + @Controller

@RestController//表示返回普通对象而不是页面

@Slf4j

public class LoggerController {

@Autowired

private KafkaTemplate<String,String> kafkaTemplate;

@RequestMapping("test1")

public String test1(){

System.out.println("11111111");

return "success";

}

@RequestMapping("test2")

public String test2(@RequestParam("name") String name,

@RequestParam("age") int age){

System.out.println(name+":"+age);

return "success";

}

@RequestMapping("applog")

public String getLogger(@RequestParam("param") String jsonStr){

//落盘

log.info(jsonStr);

//写入kafka

kafkaTemplate.send("ods_base_log",jsonStr);

return "success";

}

}

开始测试

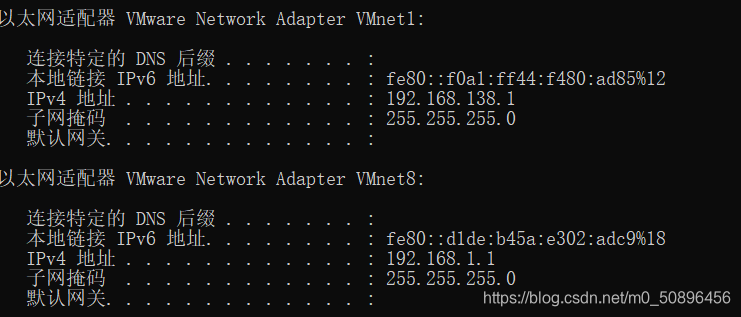

(1)在window电脑上打开cmd

输入ipconfig

将IPv4的地址复制(2个都行)

2)进入虚拟机中

修改application.yml文件

将刚才复制的地址输入

3)在IDEA上执行程序

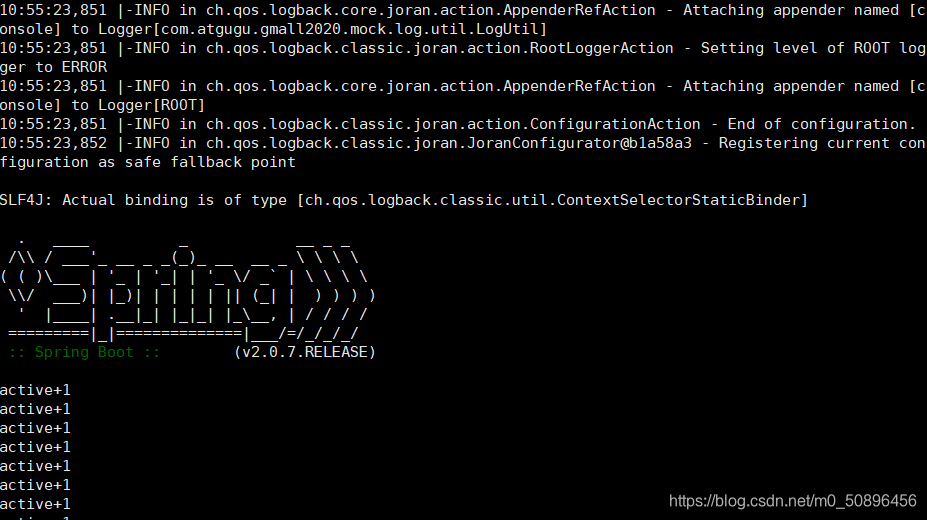

之后在虚拟机中执行jar包

此时如果IDEA控制台上有数据输出:

则成功