一、简述

Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统

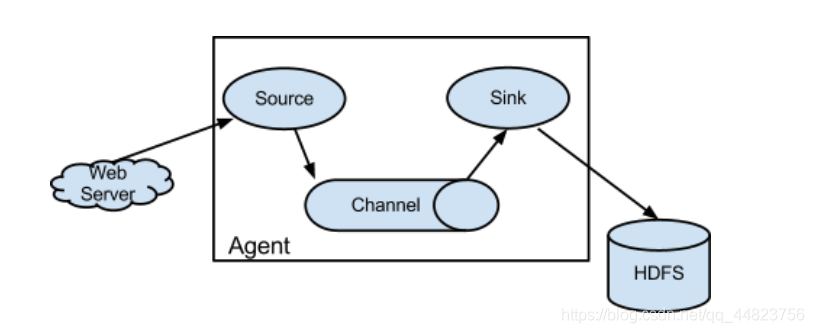

Flume系统中核心的角色是agent,agent本身是一个Java进程,一般运行在日志收集节点。

每一个agent相当于一个数据传递员,内部有三个组件:

Source:采集源,用于跟数据源对接,以获取数据;

Channel:agent内部的数据传输通道,用于从source将数据传递到sink;

Sink:下沉地,采集数据的传送目的,用于往下一级agent传递数据或者往最终存储系统传递数据;

在整个数据的传输的过程中,流动的是event,它是Flume内部数据传输的最基本单元。

event将传输的数据进行封装。如果是文本文件,通常是一行记录,event也是事务的基本单位。event从source,流向channel,再到sink,本身为一个字节数组,并可携带headers(头信息)信息。event代表着一个数据的最小完整单元,从外部数据源来,向外部的目的地去。

二、流动方式

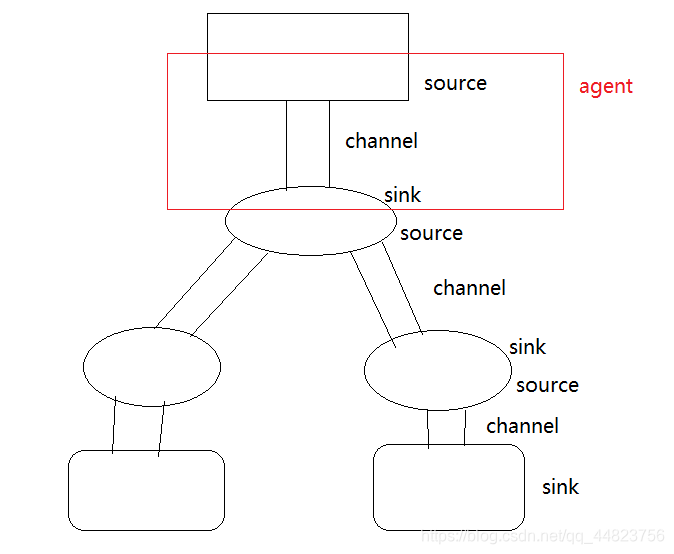

扇入流动

多个source对应一个sink

扇出流动

一个source对应多个sink

三、flume中几种常用的source

(1)netcat

数据的形式是通过TCP请求接受或者发送,接受的只是字符串形式的数据

文件编写

在flume文件下的data目录中新建一个basic文件

vim basic.conf

#绑定数据来源为r1

a1.sources=r1

#绑定source与sink之间的通道channel

a1.channels=c1

#绑定数据流向的最终目的地

a1.sinks=s1

#配置Source

#这里的source是netcat,通过NC发出TCP请求获取数据

a1.sources.r1.type=netcat

#端口所在的地址,表示从本地获取数据

a1.sources.r1.bind=0.0.0.0

#绑定端口号,配置监听的端口

a1.sources.r1.port=8090

#配置Channel -表示内存通道,临时把数据存储到内存中

a1.channels.c1.type=memory

#最多存储1000条数据 - 对应1000个event事件

a1.channels.c1.capacity=1000

#每次提供100条数据发送给sink

a1.channels.c1.transactionCapacity=100

#配置sink -表示以日志的形式输出在控制台

a1.sinks.s1.type=logger

实战操作

在linux系统中下载安装flume,进入flume安装路径的bin目录中

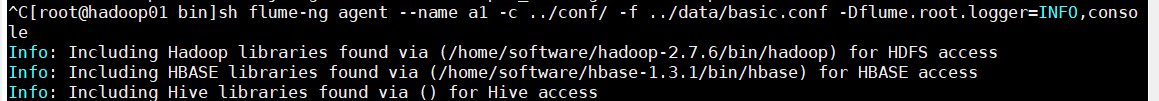

接着开启flume

sh flume-ng agent --name a1 -c …/conf/ -f …/data/basic.conf -Dflume.root.logger=INFO,console

接着在同一台虚拟机内,打开一个新的终端

解压安装nc

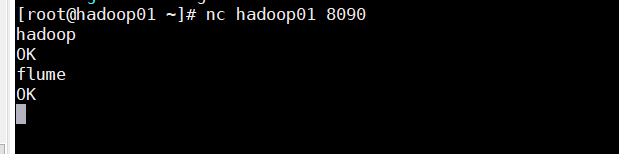

在新终端输入 nc hadoop01 8090

hadoop01是本台虚拟机的名称,8090是之前设定的端口

在里面随意的输入几个单词

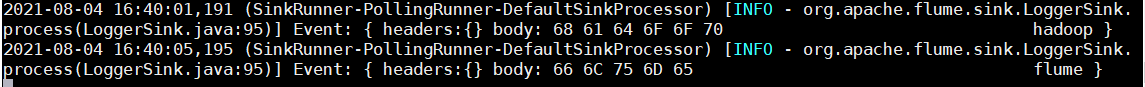

这时再回到原先的终端窗口

会发现flume已经监听到输入的这两个单词了

(2)avro

数据的形式是通过TCP请求接受或者发送,接受的只是字符串形式的数据

文件编写

相比于netcat,只需要修改a1.sources.r1.type=avro即可

a1.sources=r1

a1.channels=c1

a1.sinks=s1

#配置Source

#这里的source是avro,通过NC发出TCP请求获取数据

a1.sources.r1.type=avro

a1.sources.r1.bind=0.0.0.0

a1.sources.r1.port=8090

a1.channels.c1.type=memory

a1.channels.c1.capacity=1000

a1.channels.c1.transactionCapacity=100

a1.sinks.s1.type=logger

通过指令 sh flume-ng

可以查询到相关的指令提示

打开一个新的终端

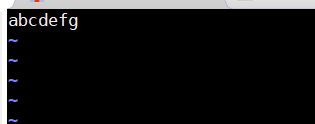

vim a.txt 新建一个文件,并且向其中填写数据

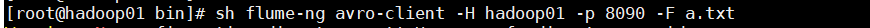

在新终端输入sh flume-ng avro-client -H hadoop01 -p 8090 -F a.txt

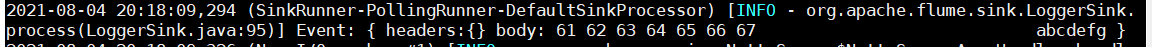

之后就可以在原先的终端中看到

a.txt中的数据已经被传输到了

数据通过avro的形式流动