@Author : Spinach | GHB

@Link : http://blog.csdn.net/bocai8058

前言

Spark是专为大规模数据处理而设计的快速通用的计算引擎,具有速度快、支持多语言、移植性高的特点。而移植性高的体现就在于Spark的部署方式有多种模式,如:本地local、Standalone、Apache Mesos、Hadoop YARN等等。

值得说的是,不管你Spark跑在什么上面,它的代码都是一样的,区别在于在提交jar时候,–master后面指定的参数不一样,例如:

# 使用spark-submit提交一个任务到普通的Spark Standalone集群:

./bin/spark-submit

–class org.apache.spark.examples.mainTest

–master spark://hadoop01:7070

–executor-memory 512m

–total-executor-cores 1

~/jars/spark-examples_2.11-2.3.1.jar

# 使用spark-submit提交一个任务到高可用的YARN集群,使用client模式:

./bin/spark-submit

–class org.apache.spark.examples.mainTest

–master yarn

–deploy-mode client

–executor-memory 512m

–total-executor-cores 1

~/jars/spark-examples.jar

# 使用spark-submit提交一个任务到高可用的YARN集群,使用cluster模式:

./bin/spark-submit

–class org.apache.spark.examples.mainTest

–master yarn

–deploy-mode cluster

–executor-memory 512m

–total-executor-cores 1

~/jars/spark-examples.jar

其中,Spark on YARN是工作中或生产中用的比较多的一种运行模式,今天主要对Spark on Yarn这种方式作详细图解。

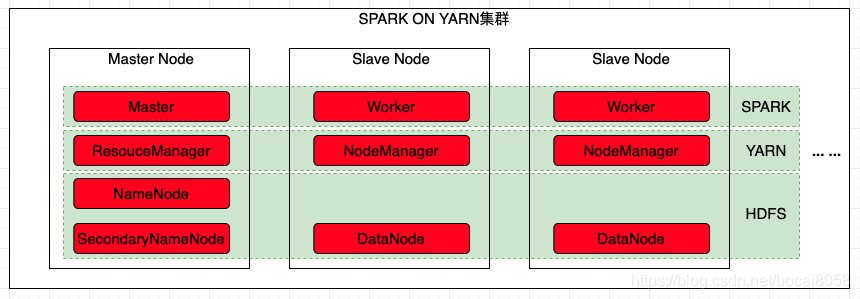

SparkOnYarn集群节点分布

SparkOnYarn集群,以HDFS为文件存储系统,以YARN为资源管理和资源分配建立Spark集群,总体集群有3个节点,其中1个master节点、2个slave节点。

Spark运行模式流程

Spark运行模型流程分两种模式:1.Yarn-Cluster模式; 2.Yarn-Client模式。

在讲解Spark运行模型流程之前,先熟悉一下Spark原理中的基本概念及关系吧,参考《Spark Master\Worker、Driver\Executor、Job\Stage\Task等概念与关系》。

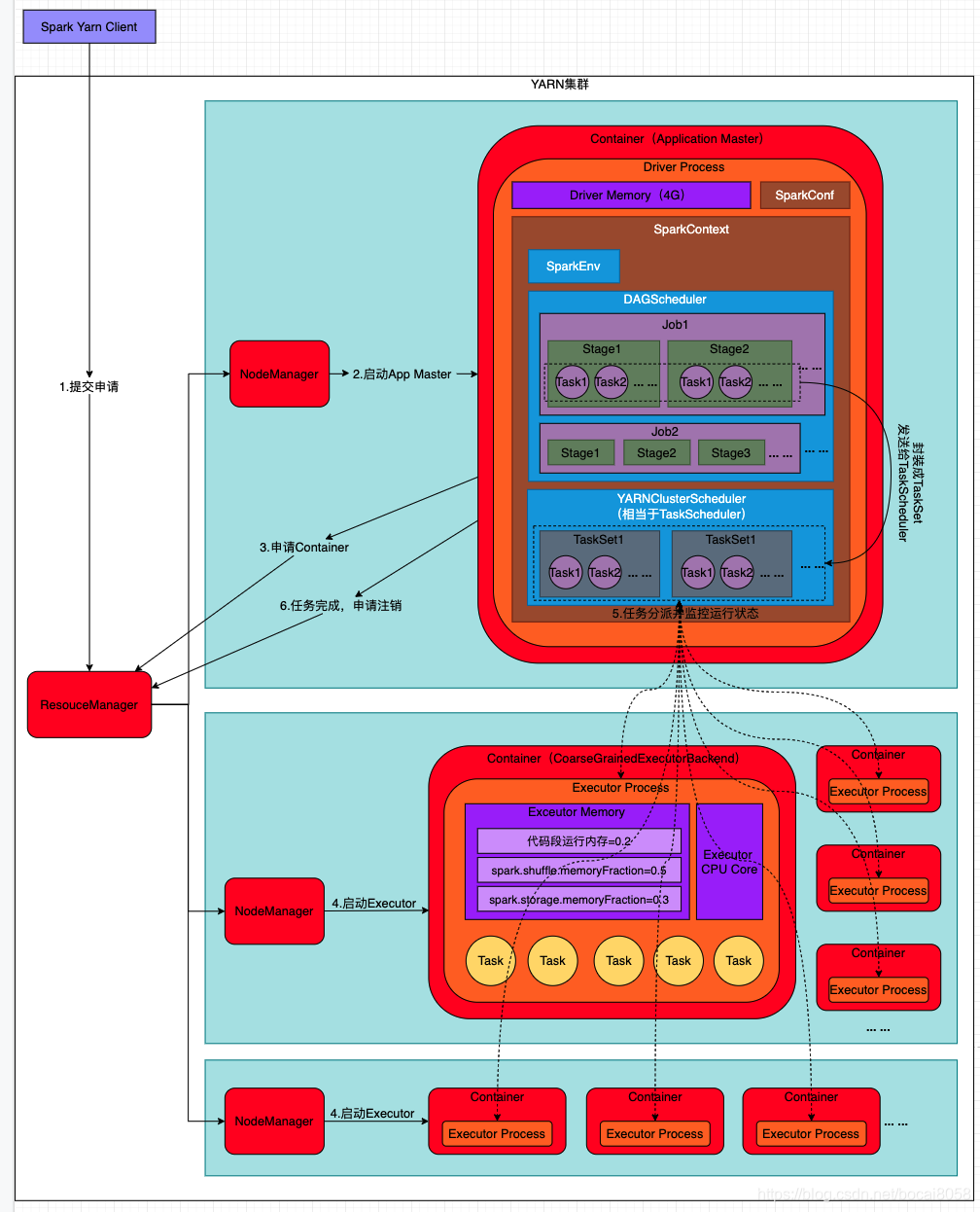

Yarn-Cluster模式下

在YARN-Cluster模式中,当用户向YARN中提交一个应用程序后,YARN将分两个阶段运行该应用程序:

第一个阶段是把Spark的Driver作为一个ApplicationMaster在YARN集群中先启动;

第二个阶段是由ApplicationMaster创建应用程序,然后为它向ResourceManager申请资源,并启动Executor来运行Task,同时监控它的整个运行过程,直到运行完成

流程说明如下:

- Spark Yarn Client向YARN中提交应用程序,包括ApplicationMaster程序、启动ApplicationMaster的命令、需要在Executor中运行的程序等;

- ResourceManager收到请求后,在集群中选择一个NodeManager,为该应用程序分配第一个Container,要求它在这个Container中启动应用程序的ApplicationMaster,其中ApplicationMaster进行SparkContext等的初始化;

- ApplicationMaster向ResourceManager注册,这样用户可以直接通过ResourceManage查看应用程序的运行状态,然后它将采用轮询的方式通过RPC协议为各个任务申请资源,并监控它们的运行状态直到运行结束;

- 一旦ApplicationMaster申请到资源(也就是Container)后,便与对应的NodeManager通信,要求它在获得的Container中启动CoarseGrainedExecutorBackend,CoarseGrainedExecutorBackend启动后会向ApplicationMaster中的SparkContext注册并申请Task。这一点和Standalone模式一样,只不过SparkContext在Spark Application中初始化时,使用CoarseGrainedSchedulerBackend配合YarnClusterScheduler进行任务的调度,其中YarnClusterScheduler只是对TaskSchedulerImpl的一个简单包装,增加了对Executor的等待逻辑等;

- ApplicationMaster中的SparkContext分配Task给CoarseGrainedExecutorBackend执行,CoarseGrainedExecutorBackend运行Task并向ApplicationMaster汇报运行的状态和进度,以让ApplicationMaster随时掌握各个任务的运行状态,从而可以在任务失败时重新启动任务;

- 应用程序运行完成后,ApplicationMaster向ResourceManager申请注销并关闭自己;

集群提交命令如下:

# 使用spark-submit提交一个任务到高可用的YARN集群,使用cluster模式:

./bin/spark-submit

–class org.apache.spark.examples.mainTest

–master yarn

–deploy-mode cluster

–executor-memory 512m

–total-executor-cores 1

~/jars/spark-examples.jar

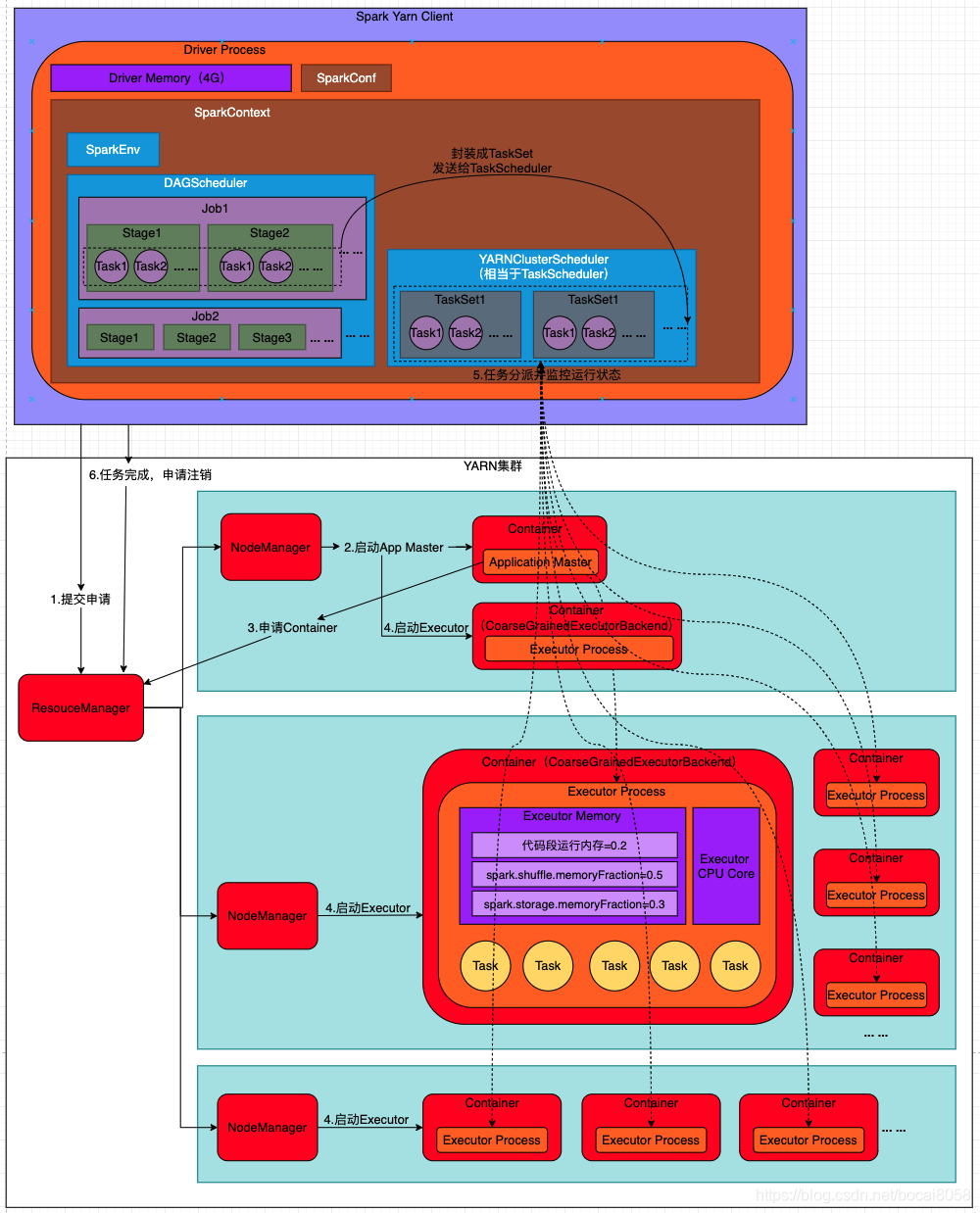

Yarn-Client模式下

流程说明如下:

- Spark Yarn Client向YARN的ResourceManager申请启动Application Master。同时在SparkContent初始化中将创建DAGScheduler和TASKScheduler、SparkEnv对象等,由于选择的是Yarn-Client模式,程序会选择YarnClientClusterScheduler和YarnClientSchedulerBackend;

- ResourceManager收到请求后,在集群中选择一个NodeManager,为该应用程序分配第一个Container,要求它在这个Container中启动应用程序的ApplicationMaster,与YARN-Cluster区别的是在该ApplicationMaster不运行SparkContext,只与SparkContext进行联系进行资源的分派;

- Client中的SparkContext初始化完毕后,与ApplicationMaster建立通讯,向ResourceManager注册,根据任务信息向ResourceManager申请资源(Container);

- 一旦ApplicationMaster申请到资源(也就是Container)后,便与对应的NodeManager通信,要求它在获得的Container中启动CoarseGrainedExecutorBackend,CoarseGrainedExecutorBackend启动后会向Client中的SparkContext注册并申请Task;

- Client中的SparkContext分配Task给CoarseGrainedExecutorBackend执行,CoarseGrainedExecutorBackend运行Task并向Driver汇报运行的状态和进度,以让Client随时掌握各个任务的运行状态,从而可以在任务失败时重新启动任务;

- 应用程序运行完成后,Client的SparkContext向ResourceManager申请注销并关闭自己;

集群提交命令如下:

# 使用spark-submit提交一个任务到高可用的YARN集群,使用client模式:

./bin/spark-submit

–class org.apache.spark.examples.mainTest

–master yarn

–deploy-mode client

–executor-memory 512m

–total-executor-cores 1

~/jars/spark-examples.jar

Yarn-Cluster模式与Yarn-Client模式区别

在YARN中,每个Application实例都有一个ApplicationMaster进程,它是Application启动的第一个容器。它负责和ResourceManager打交道并请求资源,获取资源之后告诉NodeManager为其启动Container。

| 比较项 | YARN-Client模式 | YARN-Cluster模式 |

|---|---|---|

| Application Master | Application Master仅仅向YARN请求Executor,Client会和请求的Container通信来调度他们工作 | Driver运行在AM(Application Master)中,它负责向YARN申请资源,并监督作业的运行状况。当用户提交了作业之后,就可以关掉Client,作业会继续在YARN上运行 |

| Driver | 运行在Client中 | 运行在AM(Application Master)中 |

| client关闭 | 关闭client,任务就直接结束 | 提交任务后可以直接关闭client,不影响集群程序的运行 |

| 使用场景 | 适合交互和调试环境 | 适合生产环境 |

| 监控日志 | 直接查看 | yarn logs -applicationId xxxxxx |

| 优点 | 便于调试和查看监控日志 | 可以直接关闭client,不影响集群程序的运行 |

| 缺点 | 1.由于存在大量数据在Driver和集群中进行交互,会在运行过程中产生大量的网络数据传输,网络开销加大;2.client断了,任务就挂了 | 不便于交互和查看监控日志 |

引用:

https://www.cnblogs.com/yy3b2007com/p/10934090.html

https://blog.csdn.net/github_28583061/article/details/106385707

https://blog.csdn.net/qq_37332702/article/details/87944361

https://blog.csdn.net/u012137473/article/details/84965567

https://blog.csdn.net/weixin_35602748/article/details/78724195