1、HBase版本为1.4.13的下载地址

https://mirrors.tuna.tsinghua.edu.cn/apache/hbase/1.4.13/hbase-1.4.13-bin.tar.gz

2、上传tar包

hbase-1.4.13-bin.tar.gz

3、解压tar包

sudo tar -zxvf hbase-1.4.13-bin.tar.gz -C /usr/local/

4、将解压后的hbase-1.4.13目录重命名为hbase

cd /usr/local

sudo mv hbase-1.4.13/ hbase

5、授权当前用户hadoop拥有hbase目录的所有者权限

sudo chown -R hadoop:hadoop hbase

6、复制hadoop中的core-site.xml和hdfs-site.xml文件到hbase目录下的conf 目录中

//一定要是自己hadoop配置文件的路径

cp /usr/local/hadoop/etc/hadoop/core-site.xml /usr/local/hbase/conf/

cp /usr/local/hadoop/etc/hadoop/hdfs-site.xml /usr/local/hbase/conf/

7、进入hbase目录下的conf目录

cd /usr/local/hbase/conf/

8、编辑hbase-env.sh文件

a. 修改27行为:

export JAVA_HOME=/usr/local/lib/jdk1.8.0_212 # 设置jdk位置

b. 修改128行为:

export HBASE_MANAGES_ZK=false # 使用独立的Zookeeper

9、编辑hbase-site.xml文件,增加以下内容

<!-- 设置 hbase 数据在 hdfs 上的存储位置 -->

<property>

<name>hbase.rootdir</name>

<value>hdfs://ns/hbase</value>

</property>

<!-- 是否采用分布式模式 -->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

#<!--独立安装的 ZooKeeper 位置-->

<property>

<name>hbase.zookeeper.quorum</name>

<value>master:2181,slave1:2181,slave2:2181</value>

</property>

10、编辑regionservers文件,删除localhost,添加以下内容

master

slave1

slave2

11、创建backup-masters文件,填入slave1,设置slave1为备用HMaster

sudo vim backup-masters

#填入

slave1

12、编辑环境变量文件

vim /home/hadoop/.bashrc

13、在环境变量文件最后添加以下内容:

export HBASE_HOME=/usr/local/hbase

export PATH=$PATH:$HBASE_HOME/bin

14、刷新环境变量

source /home/hadoop/.bashrc

15、在slave1和slave2上创建/usr/local/hbase目录,并授权hadoop用户拥有hbase目录的所有者权限,在slave1和slave2使用以下命令:

sudo mkdir /usr/local/hbase

sudo chown -R hadoop /usr/local/hbase/

16、发送master的HBase给slave1和slave2,在master使用以下命令:

scp -r /usr/local/hbase/* hadoop@slave1:/usr/local/hbase

scp -r /usr/local/hbase/* hadoop@slave2:/usr/local/hbase

17、发送master的环境变量给slave1和slave2,在master使用以下命令:

scp /home/hadoop/.bashrc hadoop@slave1:/home/hadoop

scp /home/hadoop/.bashrc hadoop@slave2:/home/hadoop

18、刷新slave1和slave2的环境变量,在slave1和slave2执行以下命令:

source /home/hadoop/.bashrc

启动hbase

1、启动三个节点上的Zookeeper

zkServer.sh start

查看状态

zkServer.sh status

2、启动Hadoop

start-dfs.sh

start-yarn.sh

3、启动HBase,在master执行以下命令

start-hbase.sh

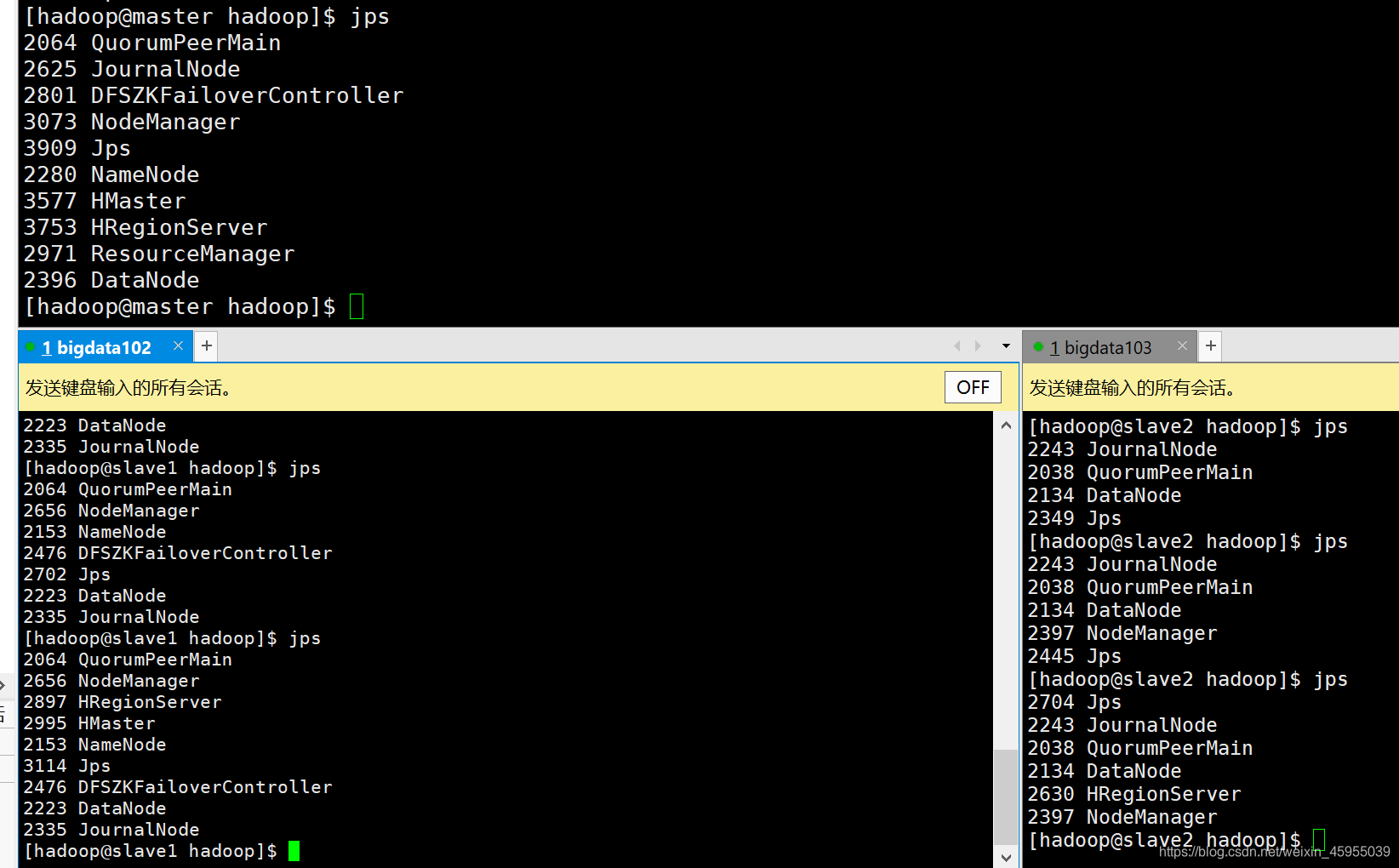

4、查看进程

jps

5、启动客户端

hbase shell