Spark3.1.2 快速入门

一、特别说明

1.1 Spark3.1.2编程抽象Dataset

在Spark 2.0之前,Spark的主要编程接口是RDD。在Spark2.0之后,RDD被Dataset所取代,Dataset像RDD一样是强类型的,但在底层有更丰富的优化。RDD接口仍然受到支持,您可以在RDD编程指南中获得更详细的参考。但是,我们强烈建议您改用Dataset,它的性能比RDD更好,请参阅SQL编程指南以获得关于Dataset的更多信息。

1.2 Spark3.1.2安全性说明

Spark中的安全默认为“OFF”。这可能意味着默认情况下您很容易受到攻击。运行Spark前请参见《Spark安全》。

1.3 环境说明

- Scala版本:2.12.14

- Spark版本:3.1.2

- Spark安装环境:Spark Standalone

二、Spark Shell 交互式操作

Spark的shell提供了一种简单的方法来学习API,以及一个强大的工具来交互分析数据。它可以在Scala(运行在Java VM上,因此是使用现有Java库的好方法)或Python中使用。

- 启动spark-shell,如以配置了环境变量则可在任意路径下执行如下命令,否则可以在Spark安装目录下得bin目录下运行如下命令启动:

spark-shell

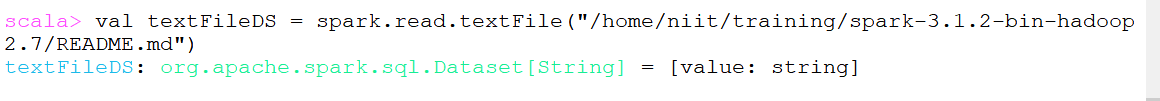

Spark的主要抽象是一个称为Dataset的分布式项集合。数据集可以从Hadoop InputFormats(如HDFS文件)或通过转换其他数据集创建。让我们从Spark源目录的README文件的文本创建一个新的Dataset:

-

创建Dataset代码:

val textFile = spark.read.textFile("/home/niit/training/spark-3.1.2-bin-hadoop2.7/README.md")如下图所示:

三、Spark Shell 实现Wordcount

-

读取文件

val textFile = spark.read.textFile("/home/niit/training/spark-3.1.2-bin-hadoop2.7/README.md") -

分词统计

val wordCounts = textFile.flatMap(line => line.split(" ")).groupByKey(identity).count() -

验证结果

wordCounts.collect()结果如截图所示: