之前使用logstash导入到该index下一百多万条数据有问题,删除该节点后,又重新创建该节点;

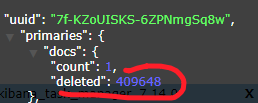

再次导入原先删除的数据,docs下“count”的数据一直保持为1,只有“deleted”的数量在不停增长。

尝试了:

- 重新安装eslasticsearch;替换版本后导入;

- 建立不同名称的index后导入;

- 删除temp文件夹下的eslasticsearch文件后导入;

- forcemerge清空删除状态的数据后导入;

以上操作均无效,数据导入后增长的只有 “deleted”的数量,且每次“count”的数据一直保持为1。

参考Elasticsearch 中为什么会有大量文档插入后变成 deleted?

删除文档的本质 删除文档本质:逻辑删除而非物理删除。

在执行删除文档后,待删除文档不会立即将文档从磁盘中删除,而是将文档标记为已删除状态(版本号 _version + 1, "result"标记为:“deleted”,)

可知删除数据只是将其标记为将文档标记为已删除状态

。。

首先forcemerge清空删除状态的数据:

再删除剩下的一条数据,curl --silent --location --request DELETE 'http://ip:9200/eswisdom/fdm_query_e_baseinfo/%25%7Bid%7D'

这里的%25%7Bid%7D表示%{id},参考get请求url参数中有+、空格、=、%、&、#等特殊符号的问题解决

请求删除index=eswisdom,type=fdm_query_e_baseinfo,id=%{id}的数据

postman上的请求写法为

再次导入成功