一、简介

Producer 拦截器(interceptor)是在 Kafka 0.10 版本被引入的,主要用于实现 clients 端的定制化控制逻辑。对于 producer 而言,interceptor 使得用户在消息发送前以及 producer 回调逻辑前有机会对消息做一些定制化需求,比如修改消息等。同时,producer 允许用户指定多个interceptor

按序作用于同一条消息从而形成一个拦截链(interceptor chain)。

(1)configure(configs)

获取配置信息和初始化数据时调用。

(2)onSend(ProducerRecord):

该方法封装进 KafkaProducer.send 方法中,即它运行在用户主线程中。Producer 确保在消息被序列化以及计算分区前调用该方法。用户可以在该方法中对消息做任何操作,但最好保证不要修改消息所属的 topic 和分区,否则会影响目标分区的计算。

(3)onAcknowledgement(RecordMetadata, Exception):

该方法会在消息从 RecordAccumulator 成功发送到 Kafka Broker 之后,或者在发送过程中失败时调用。并且通常都是在 producer 回调逻辑触发之前。onAcknowledgement 运行在producer 的 IO 线程中,因此不要在该方法中放入很重的逻辑,否则会拖慢 producer 的消息发送效率。

(4)close:

关闭 interceptor,主要用于执行一些资源清理工作,如前所述,interceptor 可能被运行在多个线程中,因此在具体实现时用户需要自行确保线程安全。另外倘若指定了多个 interceptor,则 producer 将按照指定顺序调用它们,并仅仅是捕获每个 interceptor 可能抛出的异常记录到错误日志中而非在向上传递。这在使用过程中要特别留意。

二、案例小Demo

现在我有这样的需求:在发送的每个消息前加上时间戳前缀,并在消息发送消费结束后,打印消费成功和失败的个数:

1、需要书写两个拦截器形成拦截器链

1.加上时间戳是在发消息前的,所以将该逻辑写在onSend方法里面。

import org.apache.kafka.clients.producer.ProducerInterceptor;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.clients.producer.RecordMetadata;

import java.util.Map;

public class TimeInteceptor implements ProducerInterceptor<String,String> {

@Override

public ProducerRecord<String, String> onSend(ProducerRecord<String, String> producerRecord) {

//取出数据

String value = producerRecord.value();

//创建一个新的对象

return new ProducerRecord( producerRecord.topic(), producerRecord.partition(),

producerRecord.key(), System.currentTimeMillis() + "," + producerRecord.value());

}

//其他的方法可以不管....

}

2.统计成功次数的逻辑写进onAcknowledgement方法中,最后统计的结果放在close方法中。

import org.apache.kafka.clients.producer.ProducerInterceptor;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.clients.producer.RecordMetadata;

import java.util.Map;

public class CounterInteceptor implements ProducerInterceptor<String,String> {

int success;

int error;

@Override

public ProducerRecord<String, String> onSend(ProducerRecord<String, String> producerRecord) {

return producerRecord;

}

@Override

public void onAcknowledgement(RecordMetadata recordMetadata, Exception e) {

if (recordMetadata != null) {

success++;

}else {

error++;

}

}

@Override

public void close() {

System.out.println("success:"+success);

System.out.println("error:"+error);

}

@Override

public void configure(Map<String, ?> map) {

}

}

2.将上面的两个拦截器加入到生产者中

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerConfig;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.ArrayList;

import java.util.Properties;

public class InterceptorProducer {

public static void main(String[] args) {

Properties properties = new Properties();

properties.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

properties.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

//添加拦截器!!!!!!!

ArrayList<String> interceptors = new ArrayList<>();

interceptors.add("com.maoyan.kafka.interceptor.TimeInteceptor");

interceptors.add("com.maoyan.kafka.interceptor.CounterInteceptor");

properties.put(ProducerConfig.INTERCEPTOR_CLASSES_CONFIG,interceptors);

//创建生产者对象

KafkaProducer<String, String> producer = new KafkaProducer<>(properties);

//发送数据

for (int i=0;i<10;i++){

producer.send(new ProducerRecord<String,String>("study","luzelong"+i));

}

//关闭资源

producer.close();

}

}

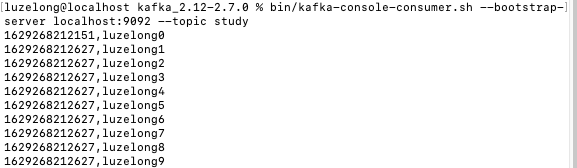

发现kafka收到的消息前都加上了时间戳

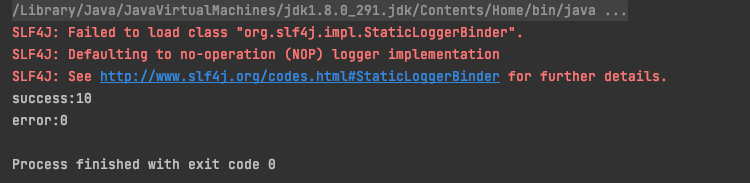

控制台上也打印了成功和失败的记录