购买云主机Hadoop2

?环境初始化(hadoop2)

安装Java1.8.0-openjdk

配置/etc/hosts

配置ssh免密 /etc/ssh/ssh_config

hadoop1 上执行

[root@hadoop1 ~]# vim /etc/hosts

192.168.1.50 ? ?hadoop1

192.168.1.56 ? ?hadoop2

192.168.1.51 ? ?node-0001

192.168.1.52 ? ?node-0002

192.168.1.53 ? ?node-0003

[root@hadoop1 ~]# rsync -aXSH --delete /root/.ssh hadoop2:/root/

[root@hadoop1 ~]# for i in hadoop2 node-{0001..0003};do

? ? ? ? ? ? ? ? ? ? ? rsync -av /etc/hosts ${i}:/etc/

? ? ? ? ? ? ? ? ? done

hadoop2 上执行

[root@hadoop2 ~]# yum install -y java-1.8.0-openjdk-devel

[root@hadoop2 ~]# vim /etc/ssh/ssh_config

# 60行新添加

?? ?StrictHostKeyChecking no

集群配置文件 6个在Hadoop1上配置

1、hadoop.env.sh

2、节点配置slaves

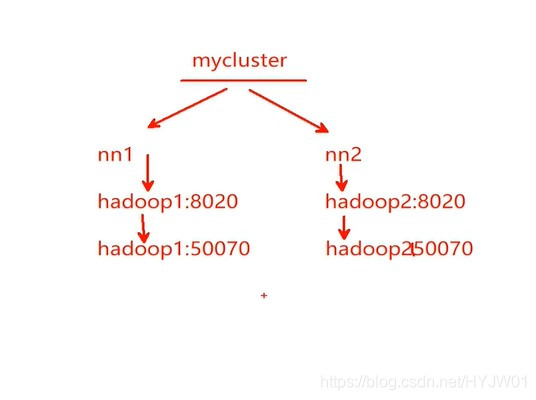

3、核心配置core-site.xml

? ? ? ? ?zookeepeer服务器地址,同时配置多个防止单点故障

? ? ? ? ?hdfs://mycluster

4、hdfs-site.xml

? ? dfs.nameservers 服务名

? ? dfs.ha.namenodes? ? 服务名:定义服务中的角色

?角色1 的 rpc地址及端口号----Hadoop1--Namenode1地址及端口号

角色2? 的? rpc地址及端口号---Hadoop2--Namenode2地址及端口号

? ? journalnode 地址及端口号

? ? ? ? ? ? ? ? ? ? ? ? ?数据存放地址

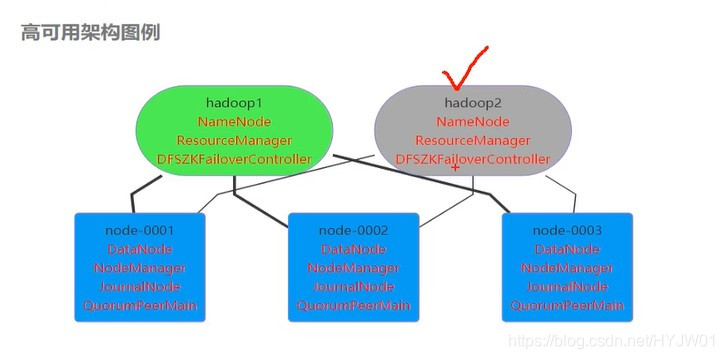

?Failover类服务名

远程管理方式 ssh 密钥位置,私钥位置

打开自动故障切换

5、mapred-site.xml

6、yarn-site.xml

? ? ? 激活HA配置

? ? ? 管理节点状态自动恢复

? ? ? ? ? 数据状态保持介质

? ? ? ? ?zookkeeper 地址

? ? ? ? ? ? ? 集群ID

? ? ? ? ? ? ? ? 定义两个resouercemanger角色

? ? ? ? ? ? ?角色1 对应主机地址

? ? ? ? ? ? 角色2 对应主机地址

? ? ? ? ?