前言

接Hadoop基础搭建博文。

在搭建完基础环境之后,接下来就可以安装Hadoop集群了,这里就不在搭建伪分布式Hadoop了。

安装完全分布式Hadoop集群

1、创建Hadoop工作路径,并进入到该文件夹,并下载或上传Hadoop 的安装包

mkdir /usr/hadoop/

2、这里使用从本地上传,完毕后解压安装包

tar -zxvf 安装包文件名

3、配置环境变量(三台机子都要操作)

#HADOOP

export HADOOP_HOME=/usr/hadoop/hadoop-2.7.3

export PATH=${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:${PATH}

4、进入Hadoop存放配置文件的地方

cd $HADOOP_HOME/etc/hadoop

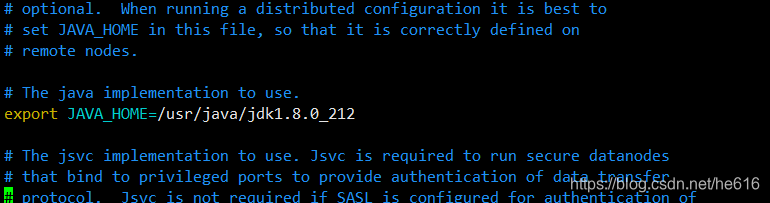

- 配置hadoop-env.sh的jdk环境变量,添加以下内容

export JAVA_HOME=/usr/java/jdk1.8.0_212

- 配置core-site.xml文件

vim core-site.xml

添加以下内容(在<configuration里面添加)

<!-- 指定HDFS中NameNode的地址 -->

<property>

<name>fs.default.name</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/hadoop/hadoop-2.7.3/hdfs/tmp</value>

<description>A base for other temporary directories.</description>

</property>

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

<property>

<name>fs.checkpoint.period</name>

<value>60</value>

</property>

<property>

<name>fs.checkpoint.size</name>

<value>67108864</value>

</property>

- 配置hdfs-site.xml文件

vim hdfs-site.xml

添加以下内容

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/hadoop/hadoop-2.7.3/hdfs/name</value>

<final>true</final>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/hadoop/hadoop-2.7.3/hdfs/data</value>

<final>true</final>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>master:9001</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

- 配置yarn-site.xml文件

vim yarn-site.xml

添加以下内容

<!-- 指定ResourceManager的地址-->

<property>

<name>yarn.resourcemanager.address</name>

<value>master:18040</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:18030</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:18088</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:18025</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>master:18141</value>

</property>

<!-- 指定reducer获取数据的方式-->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

- 配置mapred-site.xml

vim mapred-site.xml

添加以下内容

<configuration>

<!-- 指定MR运行在Yarn上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

- 配置slaves文件(此文件不能有空格和空行)

vim slaves

master

slave1

slave2

5、配置完成后发送到各节点

scp -r /usr/hadoop/ slave1:/usr/

scp -r /usr/hadoop/ slave2:/usr/

记得生效环境变量

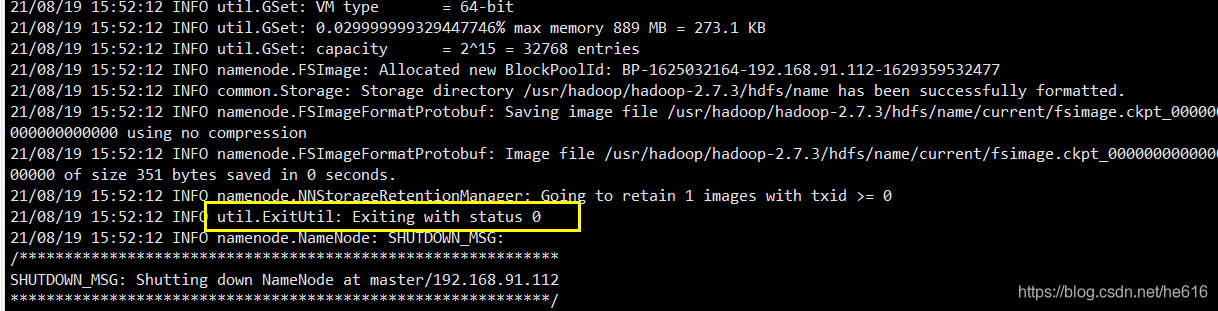

6、格式化集群(在master上执行)

hadoop namenode -format

结果如下则为成功

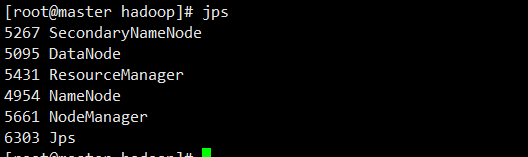

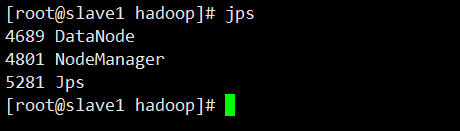

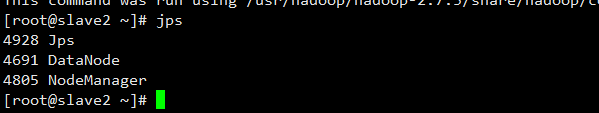

7、最后启动集群

start-all.sh

至此,完全分布式集群搭建完毕。