大数据概述

一、6v

1.数据体量大

2.数据种类样式多

3.数据的增长速度越来越快

4.数据的价值密度

5.数据的真实性

6.数据的联通性

7.数据的动态性、可视化以及合法性

二、分类

大数据的相关岗位:

数据的存储

数据的采集

数据清洗-ETL

数据分析 离线批处理 实时流处理

数据挖掘

数据可视化

Hadoop简介

一、概述

1.Hadoop是apache提供的一套开源的,可靠的,可扩展的,进行分布式存储和计算的框架。

2.Hadoop的版本很混乱

二、发展历程

1.创始人: Doug Cutting和Mike Caferalla

2.在2002年,这两个人设计一套搜索引擎Nutch,爬取了全网的10亿个网页的数据

3.在2003年,谷歌公司发表了一篇论文《The Google File System》(GFS)分布式存储的原理,但是谷歌并没有公布这个框架,Doug根据这篇论文设计实现了NDFS(Nutch Distributed File System)

4.在2004年,谷歌发表了一篇论文《The Google MapReduce》阐述了分布式计算的原理,Doug根据这篇论文设计了MapReduce

5.在Nutch0.8版本的时候,将NDFS和MapReduce从Nutch中分离出来了Hadoop,将NDHS更名为HDFS

6.在2007年,Doug携带Hadoop入职了Yahoo

7.Doug在雅虎工作期间,主持了HBase、Pig等框架。

8.Yahoop将Hadoop等框架贡献给了apache,雅虎之后谢幕

三、模块

1.Hadoop Common:基本模块,用于支持其它模块

2.Hadoop distributed Filesystem:分布式存储框架

3.Hadoop Yarn:任务调度和集群资源管理

4.Hadoop Mapeduce: 分布式计算

5.Hadoop Ozone:对象存储

6.Hadoop submarine:机器学习引擎

四、版本

1.Hadoop1.0:Common,HDFS、MapReduce

2.Hadoop2.0:Common,HDFS、MapReduce、yarn

注意:hadoop1.0和hadoop2.0不兼容

3.Hadoop3.0:Common,HDFS、MapReduce、yarn、Ozone,最新的版本中包含Submarine

伪分布式Hadoop

1.关闭防火墙chkconfig iptables off

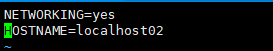

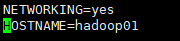

2.需要修改主机名,要求主机名中没有没有_和-

vim /etc/sysconfig/network

修改了名字

重新生效

source /etc/sysconfig/network

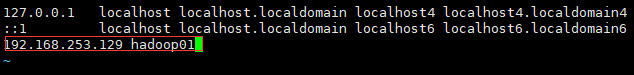

将ip和主机名进行映射

vim /etc/hosts

添加ip和主机名,如下图

重启

reboot

配置Linux免密互通

产生密钥

ssh-keygen

免密互通

ssh-copy-id root@hadoop01

输入密码(服务器密码)

测试(中间不用输入密码)

[root@hadoop01 ~]# ssh hadoop01

Last login: Sat Aug 21 15:32:50 2021 from 192.168.253.6

[root@hadoop01 ~]# logout

Connection to hadoop01 closed.

安装jdk

下载Hadoop和解压

地址

https://hadoop.apache.org/release/2.7.1.html

tar -xvf hadoop-2.7.1.tar.gz

进入hadoop安装的目录的etc/hadoop目录下

[root@hadoop01 hadoop]# pwd

/home/presoftware/hadoop-2.7.1/etc/hadoop

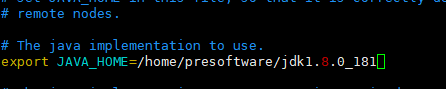

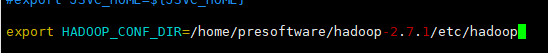

修改hadoop-env.sh

[root@hadoop01 hadoop]# vim hadoop-env.sh

export JAVA_HOME=/home/presoftware/jdk1.8.0_181

export HADOOP_CONF_DIR=/home/presoftware/hadoop-2.7.1/etc/hadoop

保存退出,重新生效

source hadoop-env.sh

编辑core-site.xml

vim core-site.xml

添加

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop01:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/presoftware/hadoop-2.7.1/tmp</value>

</property>

保存退出

编辑hdfs-site.xml

vim hdfs-site.xml

添加

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

复制mapred-site.xml.template文件

cp mapred-site.xml.template mapred-site.xml

编辑mapred-site.xml

添加

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

编辑yarn-site.xml

vim yarn-site.xml

添加

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop01</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

编辑slaves文件

vim slaves

添加主机名

hadoop01

配置环境变量

vim /etc/profile

添加

export HADOOP_HOME=/home/presoftware/hadoop-2.7.1

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

保存退出,重新生效

source /etc/profile

hadoop第一次启动之前需要格式化

hadoop namenode -format

启动Hadoop

start-all.sh

关闭

stop-all.sh

如果启动成功,则通过jsp命令,能查到5个进程

[root@hadoop01 hadoop]# jps

2533 NameNode

2808 SecondaryNameNode

3256 Jps

3048 NodeManager

2953 ResourceManager

2636 DataNode

注意:1.如果少了XXXNode,那么修改core,hdfs,删除hadoop-2.7.1/tmp 然后重新格式化重新启动

2.如果XXXManageer,那么修改mapred,yarn,重新启动

3.命令找不见,hadoop-env.sh配置错误,profile配置错了

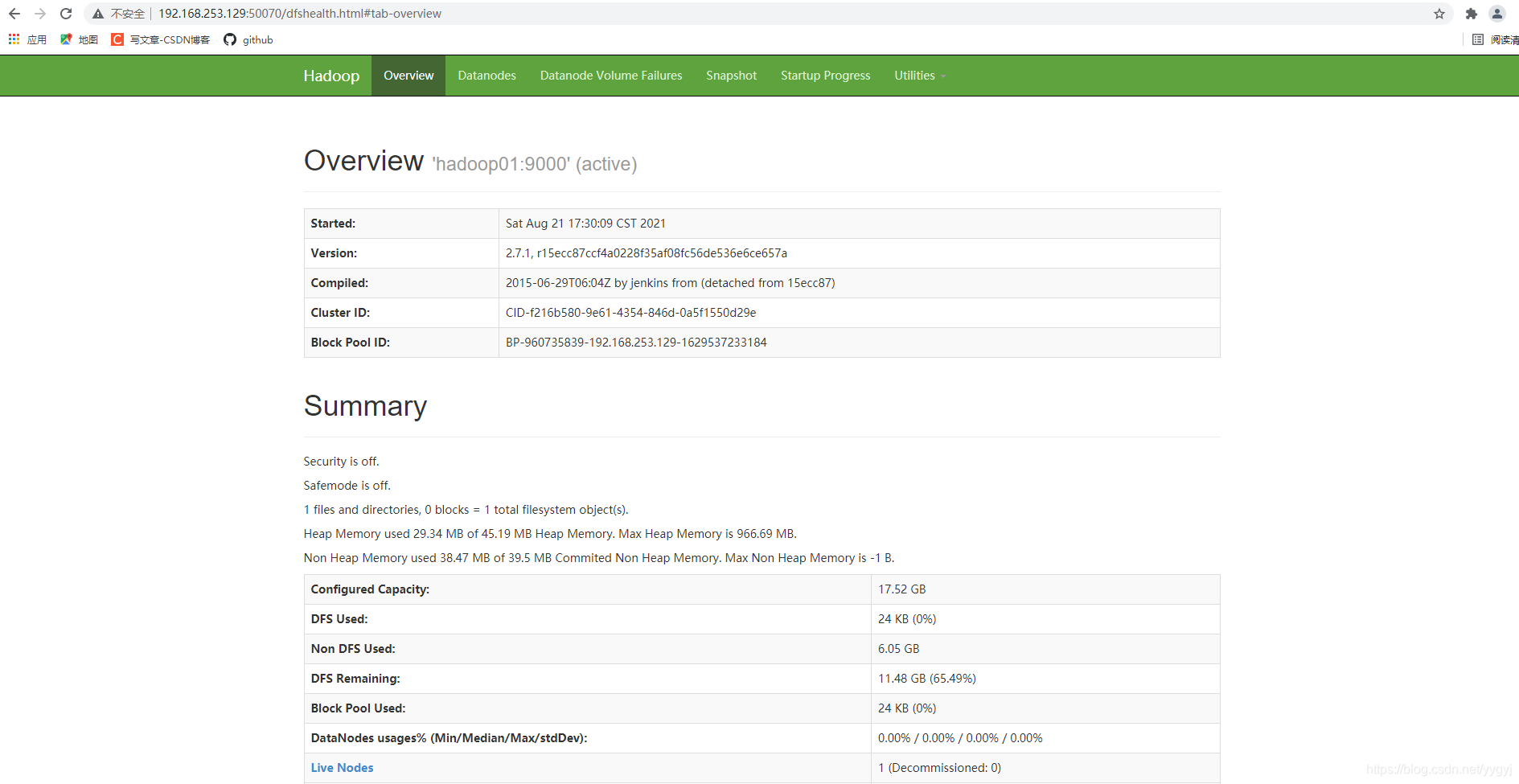

两个地址

192.168.253.129:50070

192.168.253.129:8088

启动路径(此处已经配置了环境变量,在哪里都可以启动)

[root@hadoop01 hadoop]# pwd

/home/presoftware/hadoop-2.7.1/etc/hadoop