hadoop3.2.2完整集群搭建

准备工作

1.搭建虚拟机集群

请参考

centos7虚拟机集群搭建

2.安装zookeeper集群

请参考

zookeeper集群搭建

3.下载或编译hadoop3.2.2安装包

请参考

hadoop3.2.2源码包编译

安装阶段

1.创建安装目录并解压安装包

在node1服务器上执行

#解压文件

tar -zxvf hadoop-3.2.2.tar.gz -C /home/

2.修改配置文件

2.1 修改 core-site.xml

cd /home/hadoop-3.2.2/etc/hadoop

vi /core-site.xml

<configuration>

<!-- 指定NameNode的HA高可用的zk地址 -->

<property>

<name>ha.zookeeper.quorum</name>

<value>node1:2181,node2:2181,node3:2181</value>

</property>

<!-- 指定HDFS访问的域名地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://ns</value>

</property>

<!-- 临时文件存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop-3.2.2/data/tmp</value>

</property>

<!-- 开启hdfs垃圾箱机制,指定垃圾箱中的文件七天之后就彻底删掉

单位为分钟

-->

<property>

<name>fs.trash.interval</name>

<value>10080</value>

</property>

</configuration>

2.2 修改hdfs-site.xml

cd /home/hadoop-3.2.2/etc/hadoop

vi /hdfs-site.xml

<configuration>

<!-- 指定命名空间 -->

<property>

<name>dfs.nameservices</name>

<value>ns</value>

</property>

<!-- 指定该命名空间下的两个机器作为我们的NameNode -->

<property>

<name>dfs.ha.namenodes.ns</name>

<value>nn1,nn2</value>

</property>

<!-- 配置第一台服务器的namenode通信地址 -->

<property>

<name>dfs.namenode.rpc-address.ns.nn1</name>

<value>node1:8020</value>

</property>

<!-- 配置第二台服务器的namenode通信地址 -->

<property>

<name>dfs.namenode.rpc-address.ns.nn2</name>

<value>node2:8020</value>

</property>

<!-- 所有从节点之间相互通信端口地址 -->

<property>

<name>dfs.namenode.servicerpc-address.ns.nn1</name>

<value>node1:8022</value>

</property>

<!-- 所有从节点之间相互通信端口地址 -->

<property>

<name>dfs.namenode.servicerpc-address.ns.nn2</name>

<value>node2:8022</value>

</property>

<!-- 第一台服务器namenode的web访问地址 -->

<property>

<name>dfs.namenode.http-address.ns.nn1</name>

<value>node1:50070</value>

</property>

<!-- 第二台服务器namenode的web访问地址 -->

<property>

<name>dfs.namenode.http-address.ns.nn2</name>

<value>node2:50070</value>

</property>

<!-- journalNode的访问地址,注意这个地址一定要配置 -->

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://node1:8485;node2:8485;node3:8485/ns1</value>

</property>

<!-- 指定故障自动恢复使用的哪个java类 -->

<property>

<name>dfs.client.failover.proxy.provider.ns</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

<!-- 故障转移使用的哪种通信机制 -->

<property>

<name>dfs.ha.fencing.methods</name>

<value>sshfence</value>

</property>

<!-- 指定通信使用的公钥 -->

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/root/.ssh/id_rsa</value>

</property>

<!-- journalNode数据存放地址 -->

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/home/hadoop-3.2.2/data/dfs/jn</value>

</property>

<!-- 启用自动故障恢复功能 -->

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

<!-- namenode产生的文件存放路径 -->

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///home/hadoop-3.2.2/data/dfs/nn/name</value>

</property>

<!-- edits产生的文件存放路径 -->

<property>

<name>dfs.namenode.edits.dir</name>

<value>file:home/hadoop-3.2.2/data/dfs/nn/edits</value>

</property>

<!-- dataNode文件存放路径 -->

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///home/hadoop-3.2.2/data/dfs/dn</value>

</property>

<!-- 关闭hdfs的文件权限 -->

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

<!-- 指定block文件块的大小 -->

<property>

<name>dfs.blocksize</name>

<value>134217728</value>

</property>

</configuration>

3.修改修改yarn-site.xml

cd /home/hadoop-3.2.2/etc/hadoop

vi /yarn-site.xml

<configuration>

<!--指定运行mapreduce的环境是yarn -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- MapReduce JobHistory Server IPC host:port -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>node3:10020</value>

</property>

<!-- MapReduce JobHistory Server Web UI host:port -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>node3:19888</value>

</property>

<!-- The directory where MapReduce stores control files.默认 ${hadoop.tmp.dir}/mapred/system -->

<property>

<name>mapreduce.jobtracker.system.dir</name>

<value>/home/hadoop-3.2.2/data/system/jobtracker</value>

</property>

<!-- The amount of memory to request from the scheduler for each map task. 默认 1024-->

<property>

<name>mapreduce.map.memory.mb</name>

<value>1024</value>

</property>

<!-- <property>

<name>mapreduce.map.java.opts</name>

<value>-Xmx1024m</value>

</property> -->

<!-- The amount of memory to request from the scheduler for each reduce task. 默认 1024-->

<property>

<name>mapreduce.reduce.memory.mb</name>

<value>1024</value>

</property>

<!-- <property>

<name>mapreduce.reduce.java.opts</name>

<value>-Xmx2048m</value>

</property> -->

<!-- 用于存储文件的缓存内存的总数量,以兆字节为单位。默认情况下,分配给每个合并流1MB,给个合并流应该寻求最小化。默认值100-->

<property>

<name>mapreduce.task.io.sort.mb</name>

<value>100</value>

</property>

<!-- <property>

<name>mapreduce.jobtracker.handler.count</name>

<value>25</value>

</property>-->

<!-- 整理文件时用于合并的流的数量。这决定了打开的文件句柄的数量。默认值10-->

<property>

<name>mapreduce.task.io.sort.factor</name>

<value>10</value>

</property>

<!-- 默认的并行传输量由reduce在copy(shuffle)阶段。默认值5-->

<property>

<name>mapreduce.reduce.shuffle.parallelcopies</name>

<value>25</value>

</property>

<property>

<name>yarn.app.mapreduce.am.command-opts</name>

<value>-Xmx1024m</value>

</property>

<!-- MR AppMaster所需的内存总量。默认值1536-->

<property>

<name>yarn.app.mapreduce.am.resource.mb</name>

<value>1536</value>

</property>

<!-- MapReduce存储中间数据文件的本地目录。目录不存在则被忽略。默认值${hadoop.tmp.dir}/mapred/local-->

<property>

<name>mapreduce.cluster.local.dir</name>

<value>/home/hadoop-3.2.2/data/system/local</value>

</property>

</configuration>

4.修改workers文件

(老版本叫slave文件)

cd /home/hadoop-3.2.2/etc/hadoop

vi workers

加入要工作的服务器列表

node1

node2

node3

5.修改hadoop-env.sh

cd /home/hadoop-3.2.2/etc/hadoop

vi hadoop-env.sh

添加本机jdk配置

export JAVA_HOME=/usr/local/jdk1.8.0_271

集群部署阶段

1.同步hadoop到其他节点

cd /home

scp -r hadoop-3.2.2/ node2:$PWD

2.三台机器同时创建目录

mkdir -p /home/hadoop-3.2.2/data/dfs/nn/name

mkdir -p /home/hadoop-3.2.2/data/dfs/nn/edits

mkdir -p /home/hadoop-3.2.2/data/dfs/nn/name

mkdir -p /home/hadoop-3.2.2/data/dfs/nn/edits

3.更改node2的rm2

cd /home/hadoop-3.2.2/etc/hadoop

vi yarn-site.xml

rm1修改rm2

<property>

<name>yarn.resourcemanager.ha.id</name>

<value>rm2</value>

<description>If we want to launch more than one RM in single node, we need this configuration</description>

</property>

启动阶段

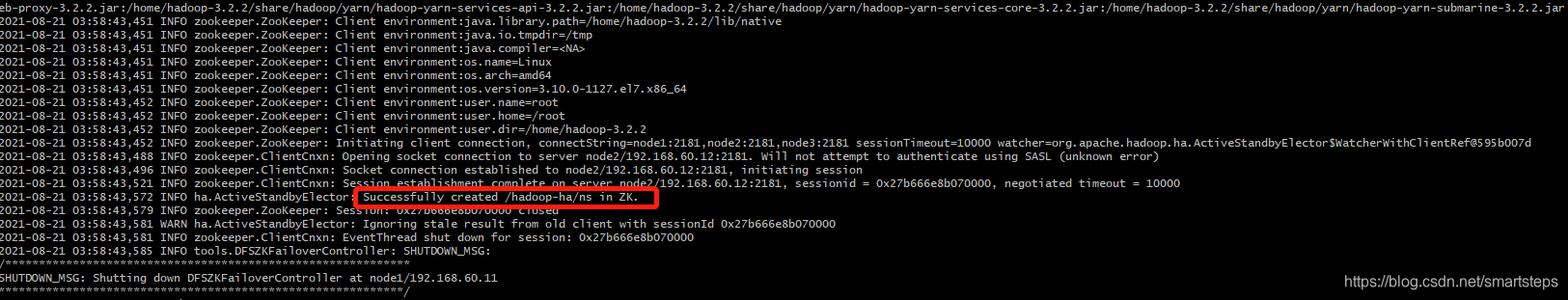

初始化zk

cd /home/hadoop-3.2.2

bin/hdfs zkfc -formatZK

#启动 journalnode

sbin/hadoop-daemons.sh start journalnode

#格式化 namenode

bin/hdfs namenode -format

bin/hdfs namenode -initializeSharedEdits -force

#启动hdfs

sbin/start-dfs.sh

启动成功

jps查看进程 可以看到服务已经启动

node1

node2

node3

时间原因今天先到这里。