- 新建三台虚拟机(三台虚拟机都要执行):

一、关闭防火墙

使用root用户登录,打开命令行终端:点击左上角-》应用程序-》收藏-》终端

查看防火墙状态:

systemctl status firewalld关闭防火墙:

systemctl ?stop firewalld关闭防火墙的自动运行:

systemctl disable firewalld重新查看状态:应该为inactive(dead)

永久修改主机名:

hostnamectl set-hostname ?主机名二、配置网卡:

打开网卡文件:

vim /etc/sysconfig/network-scripts/ifcfg-ens33修改:

BOOTPROTO=static

ONBOOT=yes添加:

IPADDR=192.168.##.** ??(##与VM一致,**为自己设置,且每台虚拟机的**是唯一的)

PREFIX=24

GATEWAY=192.168.##.2

ETMASK=255.255.255.0

(注:若打开文件后已有语句的=后有“”那么添加文件时,=后也要加“”,与已有文件输入格式,保持一致)重启网卡:

service network restart修改 /etc/hosts

- vi ?/etc/hosts

- 添加:192.168.##.** ??主节点主机名

? ? ? ? ? ? ? ? ? ? 192.168.##.** ??从节点1主机名

? ? ? ? ? ? ? ? ? ? 192.168.##.** ??从节点2主机名

? ? ? ? ? ? ? ? ? ?(注:三台虚拟机都要配置)

三、配置SSH免密登录(三台虚拟机都要执行)

产生密钥(3)

ssh-keygen –t rsa然后一直回车即可

创建公钥(3)

cp ~/.ssh/id_rsa.pub ?~/.ssh/authorized_keys(注:下面两步每执行一条命令就需要你输入一次密码)

将slave1、slave2节点公钥copy到username

ssh-copy-id ?-i??主机名将master的authorized_keys拷贝到其他节点

scp /root/.ssh/authorized_keys ??slave1:/root/.ssh

scp /root/.ssh/authorized_keys ??slave2:/root/.ssh测试:ssh 主机名

四、配置Hadoop文件:

安装hadoop以及jdk

准备工作:

- 在windows下安装winscp,打开安装后的winscp工具,在连接对话框中分别输入:linux系统的IP地址、用户名root、密码,点击登录进行连接。通过winscp连接linux系统后,将hadoop-2.7.3.tar.gz、jdk-8u151-linux-x64.tar.gz安装包传输到linux的/usr/local目录下。

- 解压安装包:

cd???/usr/local

tar??zxvf ?hadoop-2.7.3.tar.gz

tar ?zxvf ?jdk-8u151-linux-x64.tar.gz??????????解压后,生成hadoop-2.7.3目录以及jdk1.8.151目录。

- 给解压后的安装包换一个短名,方便使用

mv??hadoop-2.7.3 ?hadoop

mv ?jdk1.8.151 ???java全局变量配置文件

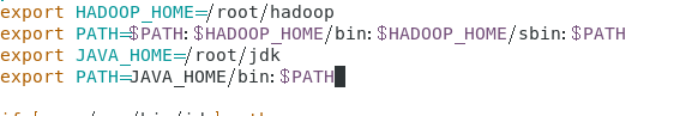

vim /etc/profile配置hadoop?

export HADOOP_HOME=hdoop路径

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin配置jdk

export JAVA_HOME=jdk路径

export PATH=$JAVA_HOME/bin:$PATH

:wq保存退出

使环境生效

source?/etc/profileSource在当前bash环境下读取并执行FileName中的命令。

?

五、配置hadoop文件

进文件目录:?cd /root/hadoop/etc/hadoop

- vim hadoop-env.sh

export JAVA_HOME=/usr/local/jdk- vim core-site.xml

<configuration>

<property>

<name>fs.defaultFS </name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>(tmp目录)

<value>/usr/local/hadoop/tmp</value>

</property>

</configuration>- vim hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

?<value>1</value>

</property>

</configuration>- vim mapred-site.xml ??(cp mapred-site.xml.template mapred-site.xml)??#改名

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>- vim yarn-site.xml

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>master:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:8035</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>master:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:8088</value>

</property>

</configuration>?

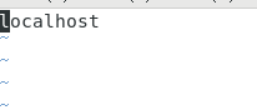

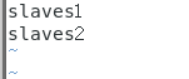

编写slaves文件 ?(也只需在主机进行)

vim?slaves

?

里面的localhost删掉

添加上两台丛机的主机名 (每个主机名独占一行)

六、分发全局变量配置文件

scp –r空格/etc/profile root@slaves1:/etc

scp –r空格/etc/profile root@slaves2:/etc切换从机输入source?/etc/profile使环境生效

????????分发HADOOP和JDK ?(主机进行)

scp –r空格/usr/local/hadoop root@slaves1:/usr/local/hadoop

scp –r空格/usr/local/hadoop root@slaves2:/usr/local/hadoop

scp –r空格/usr/local/jdk root@slaves1:/usr/local/jdk

scp –r空格/usr/local/jdk root@slaves2:/usr/local/jdk? ????????分发salves文件

scp –r空格/usr/local/hadoop/etc/hadoop/slaves root@slaves1:/usr/local/hadoop/etc/hadoop

scp –r空格/usr/local/hadoop/etc/hadoop/slaves root@slaves2:/usr/local/hadoop/etc/hadoop? ? ? ? 分发/etc/Hadoop里的文件

scp –r空格/usr/local/hadoop/etc/hadoop root@slaves2:/usr/local/hadoop/etc/最好是做完一步分发一步,不然容易搞混

七、格式化Hadoop

master:

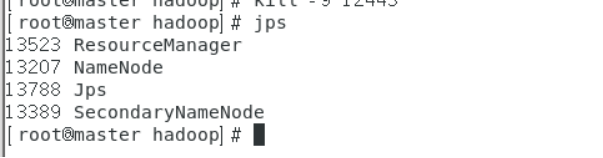

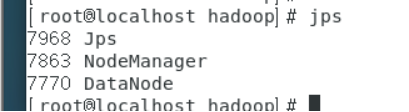

hadoop namenode –format八、开启集群

start-all.shMaster进程:namenode ??resorcemanager ??secondaryNameNode

?

Slave进程:datanode ????nodemanager ?

进程起不来,检查HADOOP和JDK配置文件

例:NameNode无法启动

vim /root/hadoop/etc/hadoop/core-site.xml

配置文件是否有书写错误

<configuration>

<property>

<name>fs.defaultFS </name>

<value>hdfs://master:9000</value>(主机名:9000)

</property>

<property>

<name>hadoop.tmp.dir</name>(tmp目录)

<value>/usr/local/hadoop/tmp</value>

</property>

</configuration>

单独启动nodemanager yarn-daemon.sh start nodemanager