hadoop学习_1

hadoop入门及介绍

目标:

1 hadoop的入门

2 hadoopHDFS

3 hadoop的MapReduce

4 hadoop的Yarn

5 hadoop的优化

6 hadoop的HA

7 常见的错误和解决方案

1.1大数据概述

大数据主要解决海量数据的存储和分析的问题

1.1.1大数据概念

大数据主要解决海量数据的存储和分析的问题

1.1.2大数据特点

1 大量

2 高速

3 多样

4 低价值密度

1.1.3大数据应用场景

1 物流仓储

2 零售

3 旅游

4 商品广告推荐

5 保险

6 金融 防范风险,风控

7 房地产

8 人工智能

1.1.4大数据发展前景

国家重点发展,前途不可限量

1.1.5大数据业务流程

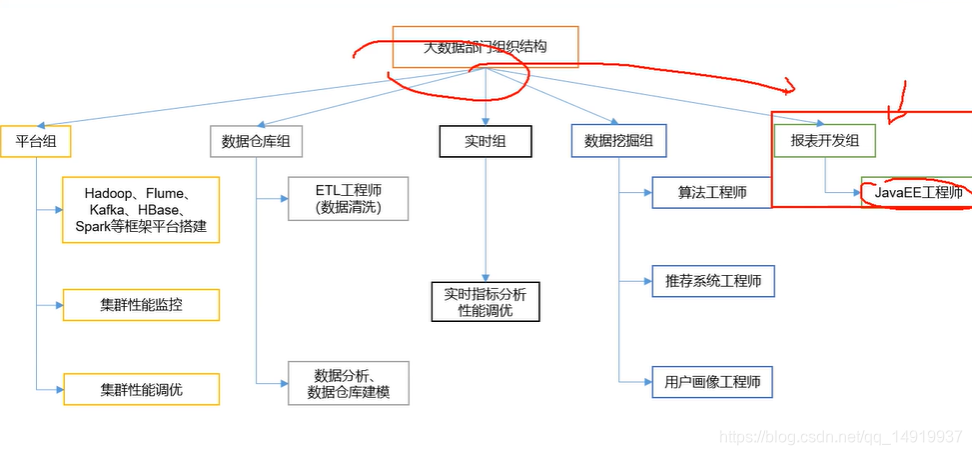

1.1.6大数据部门组织架构

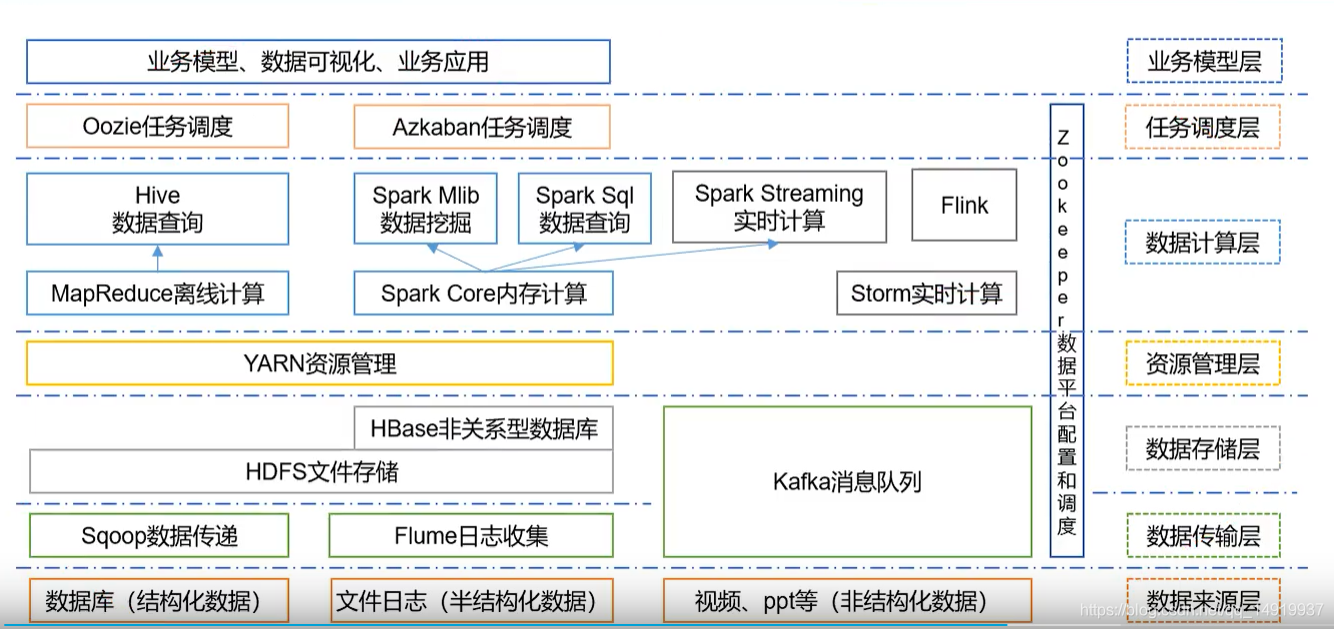

2.1hadoop生态

2.1.1hadoop的发展历史及版本

2.1.2hadoop的优势

1 高可靠性

2 高扩展

3 高容错

4 高效性

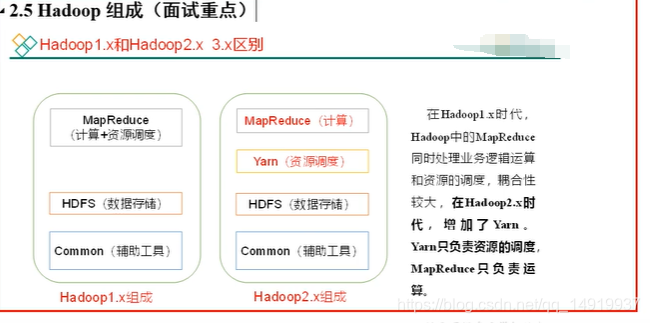

2.1.3hadoop的组成

2.1.4HDFS的架构

1 NameNode(nn):是HDFS的大哥,管理所有存储的真实数据的元数据信息(文件名,文件大小,创建时间等)

2 DataNode(nn):是HDFS的小弟,存储真实的数据,以块为单位,默认128M,比如一个200M的文件,会存2块 ,一块128M,一块72M

3 SecondaryNameNode(2nn):是NameNode的秘书,辅助NameNode干活,分担NameNode的工作,减少NameNode的压力

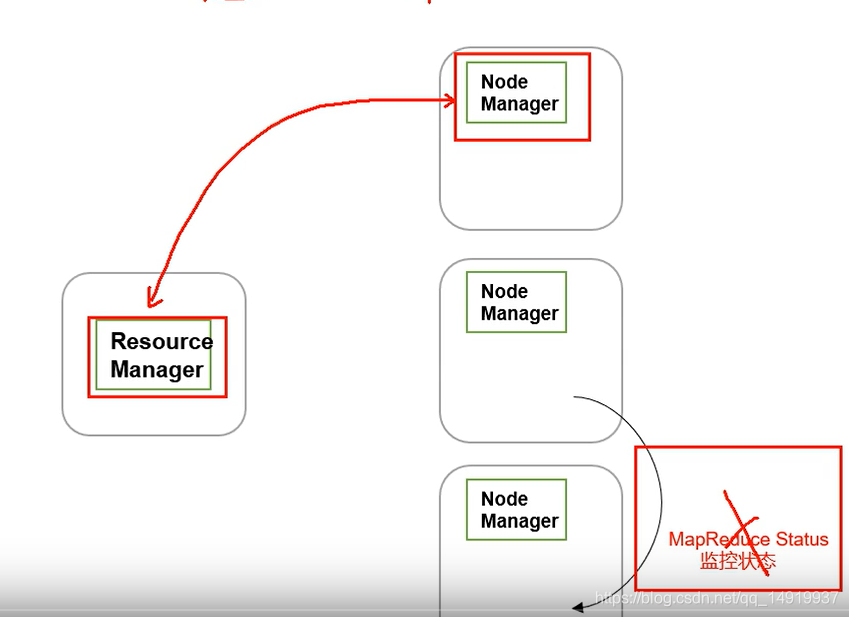

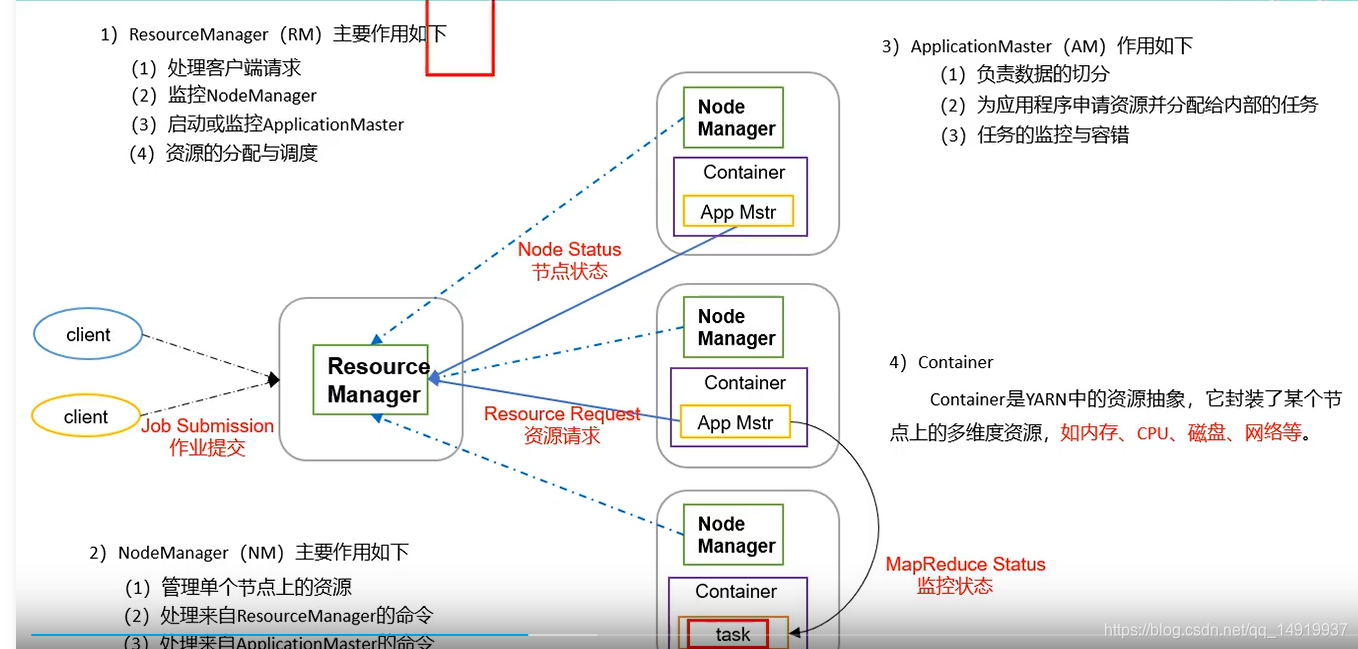

2.1.5Yarn的架构

1 Resource Manager(rm):是Yarn的大哥,管理和分配集群中所有的资源(来自每个机器的资源)

2 Node Manager(nm):是Yarn的小弟,管理所在机器的资源

3 Application Master(am):每个Job对应一个Application Master,主要负责Job的执行过程(资源申请,监控,容错等)

4 container:对资源的抽象封装,防止资源被侵占

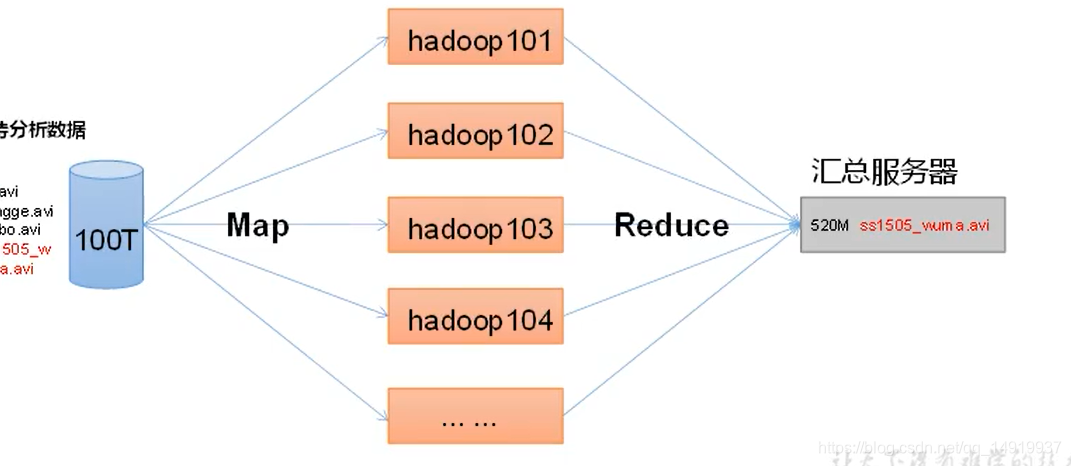

2.1.6MapReduce的思想

思想:先分再合,分:map,合:reduce

3.1 hadoop的生态体系

3.1.1搭建开发环境

1 单台 配置: 内存2G 后续可能要4G,磁盘大小50G

2 准备一台模板虚拟机,后续克隆就好

3 准备初始化安装

1)sudo yum install -y epel-release

2)sudo yum install -y psmisc nc net-tools rsync vim lrzsz ntp libzstd openssl-static tree iotop

3) 关闭防火墙

查看防火墙:systemctl status firewalld

关闭:systemctl disable firewalld

再次查看:systemctl is-enabled firewalld 显示disabled 表明关闭成功

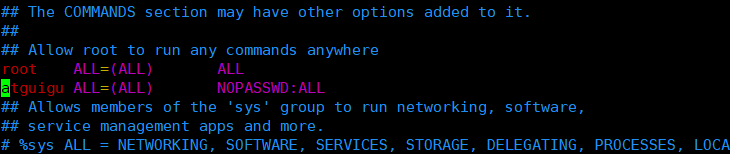

4 将atguigu这个账号配置临时root权限

1)vim /etc/sudoers

2) 配置atguigu 用户的临时权限

2、在/opt目录下创建文件夹

(1)在/opt目录下创建module、software文件夹

sudo mkdir module

sudo mkdir software

(2)修改module、software文件夹的所有者

sudo chown caron:caron /opt/module /opt/software

3、安装JDK

将JDK安装包上传到Linux /opt/software目录下

解压JDK到/opt/module目录下

tar -zxvf jdk-8u212-linux-x64.tar.gz -C /opt/module/

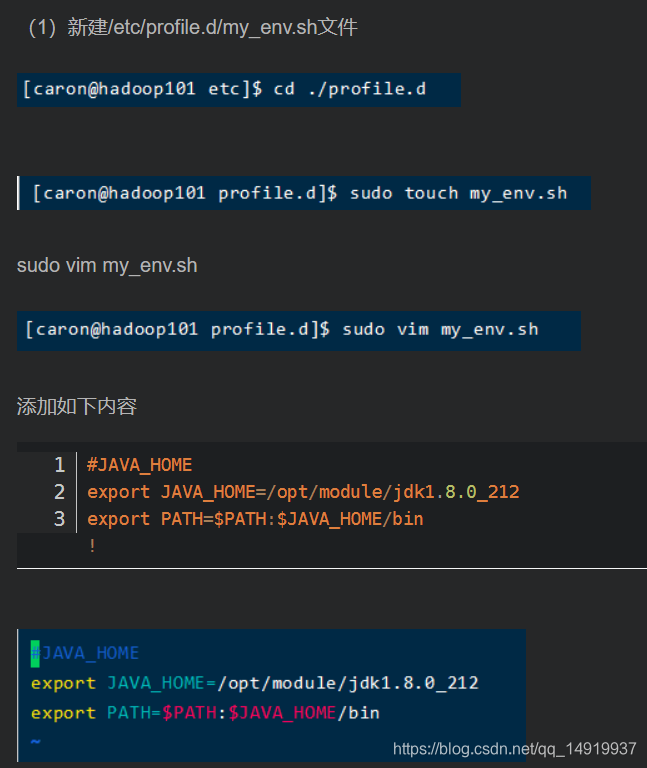

配置JDK环境变量,两种方式:

第一种:

(2)保存后退出 :wq

(3)重启xshell窗口,让环境变量生效

测试JDK是否安装成功

java -version

如果能看到以下结果、则Java正常安装

java version “1.8.0_212”

注意:重启(如果java -version可以用就不用重启)

sudo reboot

4、安装Hadoop

Hadoop下载地址:https://archive.apache.org/dist/hadoop/common/hadoop-3.1.3/

将hadoop安装包上传到/opt/software目录下

解压安装文件到/opt/module下面

tar -zxvf hadoop-3.1.3.tar.gz -C /opt/module/

查看是否解压成功

ls /opt/module/

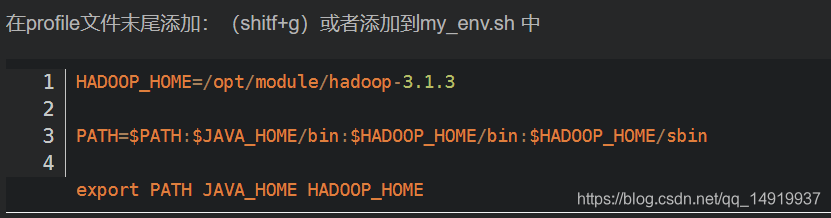

将Hadoop添加到环境变量

(1)获取Hadoop安装路径 pwd

(2)打开/etc/profile文件 ./profile.d

sudo vim /etc/profile

在profile文件末尾添加:(shitf+g)或者添加到my_env.sh 中

保存后退出:wq

(4)让修改后的文件生效

source /etc/profile

(5) 测试是否安装成功

hadoop version

(6) 重启(如果Hadoop命令不能用再重启)

sync

或者

sudo reboot

5、Hadoop重要目录

(1)bin目录:存放对Hadoop相关服务(HDFS,YARN)进行操作的脚本

(2)etc目录:Hadoop的配置文件目录,存放Hadoop的配置文件

(3)lib目录:存放Hadoop的本地库(对数据进行压缩解压缩功能)

(4)sbin目录:存放启动或停止Hadoop相关服务的脚本

(5)share目录:存放Hadoop的依赖jar包、文档、和官方案例