Hadoop大数据技术 伪分布式集群搭建快速入门教程Centos7

安装VMware

创建虚拟机

修改虚拟机IP

vim /etc/sysconfig/network-scripts/ifcfg-eth0

TYPE=Ethernet

PROXY_METHOD=none

BROWSER_ONLY=no

##将IP修改为静态IP

BOOTPROTO=static

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME="System ens33"

#UUID=1008581b-d7b1-498e-b96b-e59217a7dd1c

DEVICE=ens33

##modify yes

ONBOOT=yes

##设置虚拟机IP地址

IPADDR=192.168.37.130

NETMASK=255.255.255.0

GATEWAY=192.168.37.2 根据虚拟机的网段设置

DNS1=192.168.37.2

DNS2=114.114.114.114

修改主机名

vim /etc/sysconfig/network

# Created by anaconda

NETWORKING=yes

HOSTNAME=master #设置自己的主机名称

关闭防火墙

查看防火墙住状态

[root@master ~]# firewall-cmd –state

显示runing则执行第三条命令

临时关闭防火墙(重启虚拟机后,防火墙会自动启动)

[root@master ~]# systemctl unmask firewall.service

永久关闭防火墙(重启虚拟机后,防火墙不会开启)

[root@master ~]# systemctl disable firewalld.service

创建安装包目录和软件安装目录

##切换到opt目录下

[root@master ~]# cd /opt/

##创建software 和 apps 目录,分别用于存放安装装包和应用程序

[root@master opt]# mkdir /software

[root@master opt]# mkdir /apps

安装JDK

###切换到software目录下

[root@master opt]# cd /software

##使用wget命令下载JDK

[root@master software]# wget --no-cookies --no-check-certificate --header "Cookie:gpw_e24=http%3A%2F%2Fwww.oracle.com%2F; oraclelicense=accept-securebackup-cookie" http://download.oracle.com/otn-pub/java/jdk/8u141-b15/336fa29ff2bb4ef291e347e091f7f4a7/jdk-8u141-linux-x64.tar.gz

##使用tar命令解压到/opt/apps目录下

[root@master software]# tar -zxvf jdk-8u141-linux-x64.tar.gz -C /opt/apps/

##重命名

[root@master software]# mv /opt/apps/jdk1.8.0_141/ /opt/apps/java8

##配置JAVA_HOME和PATH

[root@master software]#vim /etc/profile.d/java_env.sh

##将一下内容写入,退出并保存

export JAVA_HOME=/opt/apps/java8

export PATH=$PATH:$JAVA_HOME/bin

##重新加载配置文件

[root@master software]# source /etc/profile

##检查配置是否成功

[root@master software]# java –version

安装Hadoop

###切换到software目录下

[root@master opt]# cd /software

##使用wget命令下载Hadoop

[root@master software]# wget https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-2.10.1/hadoop-2.10.1.tar.gz

##使用tar命令解压到/opt/apps目录下

[root@master software]#tar -zxvf hadoop-2.10.1.tar.gz -C /opt/apps/

##重命名

[root@master software]#mv /opt/apps/ hadoop-2.10.1/ /opt/apps/hadoop

##配置HADDOP_HOME和PATH

[root@master software]#vim /etc/profile.d/java_env.sh

##将一下内容写入,退出并保存

export HADOOP_HOME=/opt/apps/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export CLASSPATH=$($HADOOP_HOME/bin/hadoop classpath):$CLASSPATH

##重新加载配置文件

[root@master software]# source /etc/profile

##检查配置是否成功

[root@master software]# hadoop version

更改Hadoop配置文件

这些配置文件都在 /opt/apps/hadoop/etc/hadoop/

修改core-site.xml

vim /opt/apps/hadoop/etc/hadoop/core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/opt/apps/hadoop/data/tmp</value>#dfs文件目录

<description>location to store temporary files</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.37.230:9000</value>#填写自己的IP

</property>

</configuration>

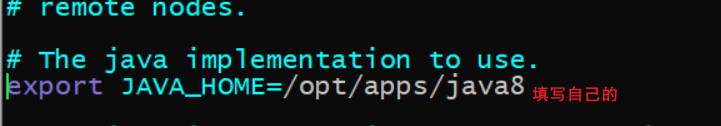

修改hadoop-env.sh

vim /opt/apps/hadoop/etc/hadoop/hadoop-env.sh

修改hdfs-site.sh

vim /opt/apps/hadoop/etc/hadoop/hdfs-site.sh

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>##配置副本数量,单节点设置成一个就好

</property>

</configuration>

修改yarn-site.sh

vim /opt/apps/hadoop/etc/hadoop/yarn-site.sh

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master</value> ##配置resourcemanager的主机名称,

</property>

</configuration>

修改yarn-env.sh

vim /opt/apps/hadoop/etc/hadoop/yarn-env.sh

修改mapred-env.sh

vim /opt/apps/hadoop/etc/hadoop/mapred-env.sh

配置免密登录

##在命令行中输入 cd ~/.ssh,切换到.ssh目录下

生成密钥

[root@master .ssh]#ssh-keygen –t rsa

[root@master .ssh]#ssh-copy-id 主机IP

启动/关闭集群

[root@master ~]#start-all.sh

[root@master ~]#stop-all.sh

查看进程

[root@master ~]#jps

10209 NodeManager

9604 NameNode

10084 ResourceManager

10516 Jps

9751 DataNode

9931 SecondaryNameNode

网页查看

再查看之前一定要确保关闭了防火墙

http://192.168.37.230:8088 hdfs

http://192.168.37.230:50070 yarn