hadoop安装

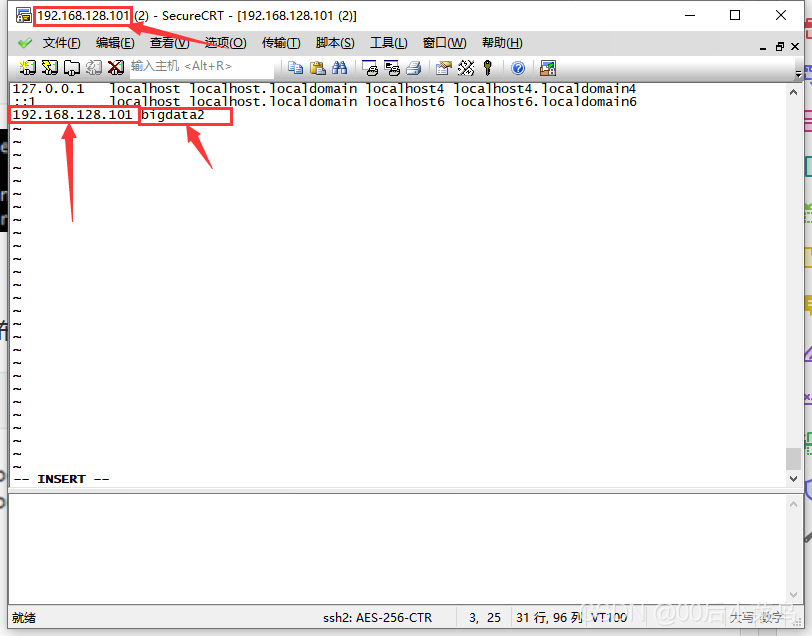

配置Hosts

伪分布式时,只需配置master即可;完全分布式时,配置master和slaves节点。

vi /etc/hosts

Hadoop安装

拷贝至/opt/software,并解压至/opt/

# 解压Hadoop

tar –zxvf hadoop-2.9.2.tar.gz -C /opt/

配置环境变量

# 编辑环境变量文件

vi /etc/profile

export HADOOP_HOME=/opt/hadoop-2.9.2

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin

# 生效环境变量

source /etc/profile

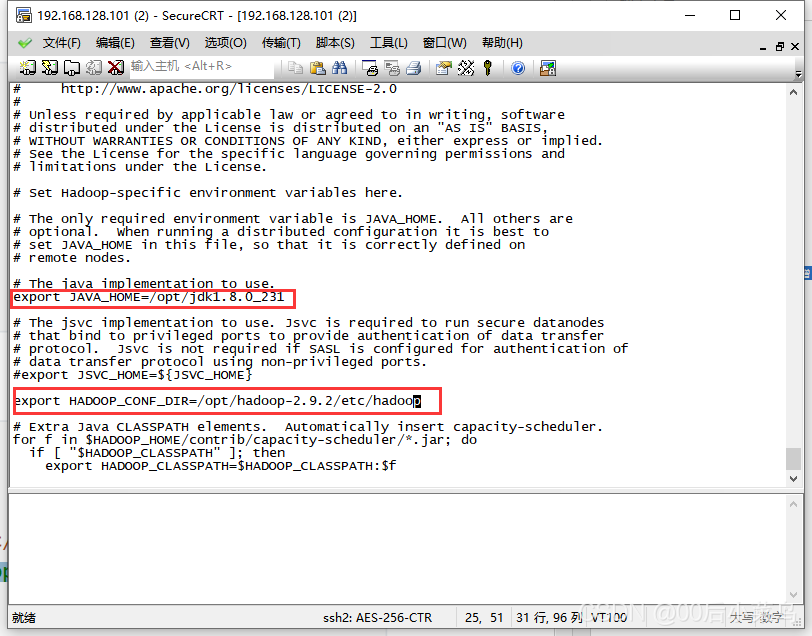

配置hadoop-env.sh

首先要转到hadoop的目录下

cd etc

cd hadoop

修改该配置文件

export JAVA_HOME=/opt/jdk1.8.0_231

# 可不修改,如报错,无法识别路径可修改

# Error: Cannot find configuration directory: /etc/hadoop

export HADOOP_CONF_DIR=/opt/hadoop-2.9.2/etc/hadoop

# 生效变量

source hadoop-env.sh

修改完成后不要忘记刷新一下资源

# 生效变量

source hadoop-env.sh

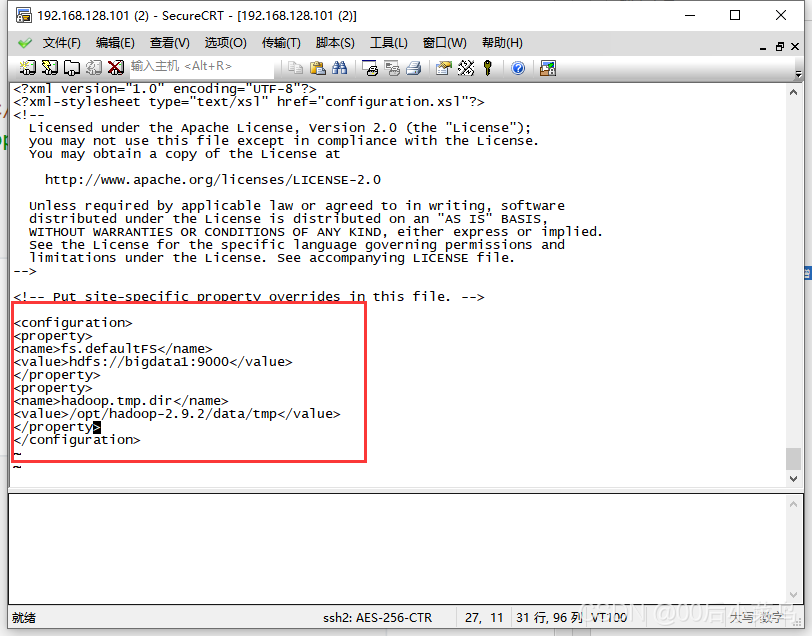

配置core-site.xml

fs.defaultFS:指定HDFS中NameNode的地址

hadoop.tmp.dir:指定Hadoop运行时产生文件的存储目录

<property>

<name>fs.defaultFS</name>

<value>hdfs://bigdata1:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop-2.9.2/data/tmp</value>

</property>

配置hdfs-site.xml

dfs.replication:设置副本数

dfs.permissions:关闭HDFS权限

dfs.namenode.name.dir:设置namenode文件路径

dfs.datanode.data.dir:设置datanode文件路径

dfs.namenode.secondary.http-address:指定secondaryNN服务,伪分布式可省略

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/opt/hadoop-2.9.2/data/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/opt/hadoop-2.9.2/data/dfs/data</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>bigdata1:50090</value>

</property>

配置mapred-site.xml

#首先复制一份文件对其进行改动

cp mapred-site.xml.template mapred-site.xml

采用cp指令copy文件mapred-site.xml.template,从而构建mapred-site.xml文件。

mapreduce.framework.name:用于执行MapReduce作业的运行时框架,默认是local

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

配置yarn-site.xml

yarn.resourcemanager.hostname:RM的主机名

yarn.nodemanager.aux-services:Reducer获取数据的方式

<property>

<name>yarn.resourcemanager.hostname</name>

<value>bigdata1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

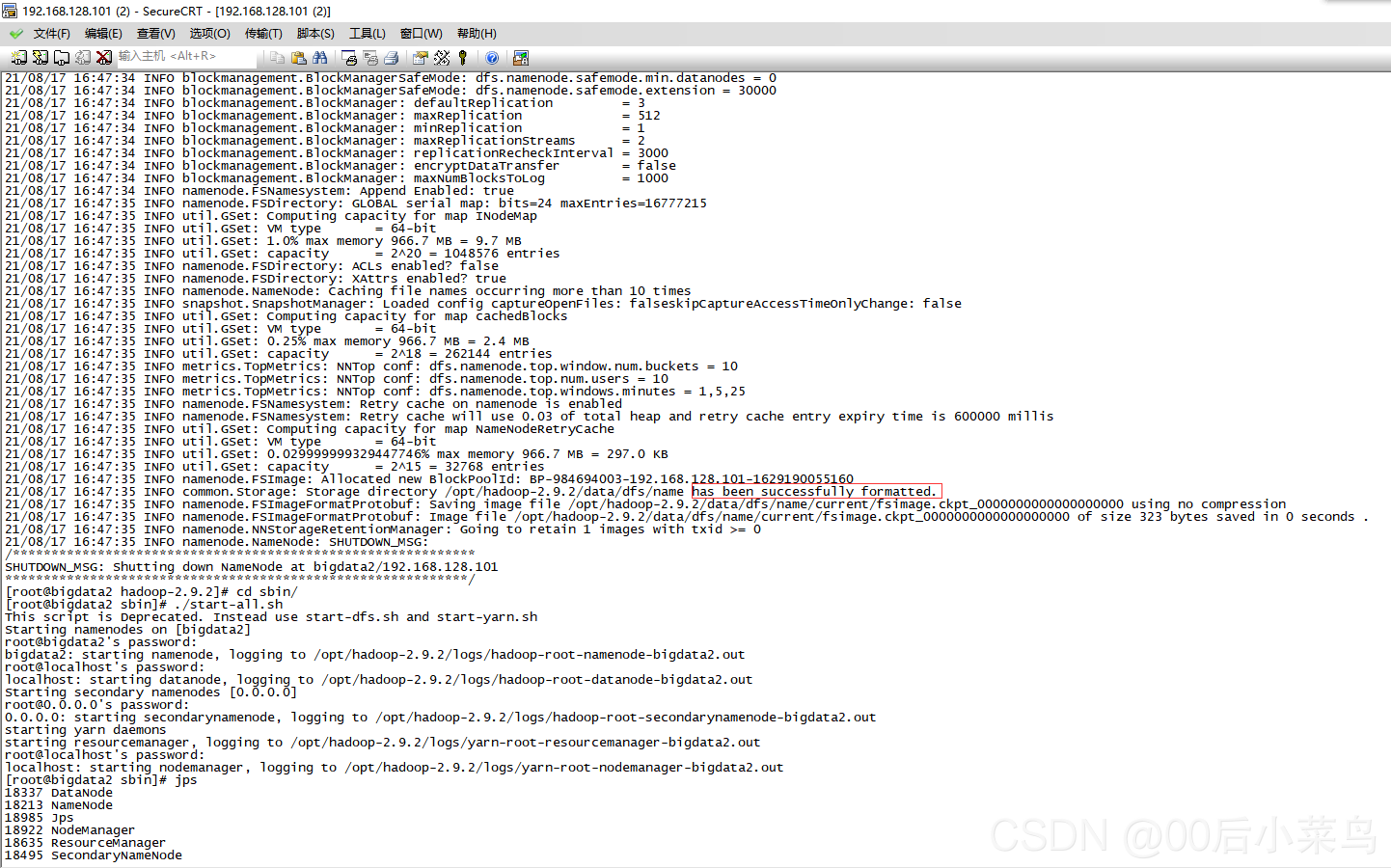

格式化namenode

hdfs namenode –format

一定要出现红色方框中的字样

若没有红框中字样就 进行常规解决问题通用手段

不可进行多次刷新,只可进行一次

启动Hadoop

进入到hadoop/sbin目录

cd ../../sbin

# 整体启动/停止HDFS和YARN

./start-all.sh

./stop-all.sh

# 整体启动/停止HDFS

./start-dfs.sh

./stop-dfs.sh

#整体启动/停止YARN

./start-yarn.sh ./stop-yarn.sh

# 分别启动

./hadoop-daemon.sh start|stop namenode/datanode/secondarynamenode

./yarn-daemon.sh start|stop namenodemanager/resourcemanager

检查是否启动成功:

jps

看显示的是否是6个进程

是6个进程就启动成功,如果不是就没有启动成功

常规解决问题通用手段

-

停止hadoop相关进程

./stop-all.sh -

删除hadoop的data内容

rm -rf data/ -

删除hadoop的log文件夹

rm -rf logs/ -

如果是集群,可同步时间

-

重新进行namenode格式化

hdfs namenode -format -

重新启动Hadoop

./start-all.sh