文章目录

1 DDL 数据定义

1.1 创建数据库

CREATE DATABASE [IF NOT EXISTS] database_name

[COMMENT database_comment]

[LOCATION hdfs_path]

[WITH DBPROPERTIES (property_name=property_value, ...)];

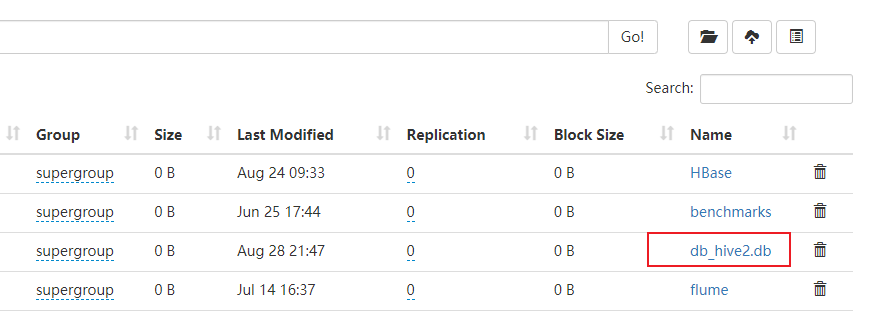

(1)创建一个数据库,数据库在HDFS上的默认存储路径是/user/hive/warehouse/*.db。

hive (default)> create database db_hive;

OK

Time taken: 0.12 seconds

(2)避免要创建的数据库已经存在错误,增加if not exists判断。(标准写法)

hive (default)> create database db_hive;

FAILED: Execution Error, return code 1 from org.apache.hadoop.hive.ql.exec.DDLTask. Database db_hive already exists

hive (default)> create database if not exists db_hive;

OK

Time taken: 0.044 seconds

(3)创建一个数据库,指定数据库在HDFS上存放的位置

hive (default)> create database db_hive2 location '/db_hive2.db';

OK

Time taken: 0.07 seconds

1.2 查询数据库

1. 显示数据库

(1)显示数据库

hive (default)> show databases;

OK

database_name

db_hive

db_hive2

default

Time taken: 0.054 seconds, Fetched: 3 row(s)

(2)过滤显示查询的数据库

hive (default)> show databases like 'db_hive*';

OK

database_name

db_hive

db_hive2

Time taken: 0.036 seconds, Fetched: 2 row(s)

2. 查看数据库详情

(1)显示数据库信息

hive (default)> desc database db_hive;

OK

db_name comment location owner_name owner_type parameters

db_hive hdfs://hadoop102:8020/user/hive/warehouse/db_hive.db Tom USER

Time taken: 0.057 seconds, Fetched: 1 row(s)

(2)显示数据库详细信息,extended

hive (default)> desc database extended db_hive;

OK

db_name comment location owner_name owner_type parameters

db_hive hdfs://hadoop102:8020/user/hive/warehouse/db_hive.db Tom USER

Time taken: 0.074 seconds, Fetched: 1 row(s)

3. 切换当前数据库

hive (default)> use db_hive;

OK

Time taken: 0.057 seconds

hive (db_hive)>

1.3 修改数据库

用户可以使用 ALTER DATABASE命令为某个数据库的 DBPROPERTIES 设置键 -值对属性值来描述这个数据库的属性信息。

hive (db_hive)> alter database db_hive

> set dbproperties('createtime'='20210828');

OK

Time taken: 0.101 seconds

在hive中查看修改结果

hive (db_hive)> desc database extended db_hive;

OK

db_name comment location owner_name owner_type parameters

db_hive hdfs://hadoop102:8020/user/hive/warehouse/db_hive.db Tom USER {createtime=20210828}

Time taken: 0.072 seconds, Fetched: 1 row(s)

1.4 删除数据库

(1)删除空数据库

hive (db_hive)> drop database db_hive2;

OK

Time taken: 0.095 seconds

(2)如果删除的数据库不存在,最好采用 if exists判断数据库是否存在

hive (db_hive)> drop database db_hive2;

FAILED: SemanticException [Error 10072]: Database does not exist: db_hive2

hive (db_hive)> drop database if exists db_hive2;

OK

Time taken: 0.025 seconds

(3)如果数据库不为空,可以采用 cascade 命令,强制删除

hive (db_hive)> drop database db_hive;

FAILED: Execution Error, return code 1 from org.apache.hadoop.hive.ql.exec.DDLTask. InvalidOperationException(message:Database db_hive is not empty. One or more tables exist.)

hive (db_hive)> drop database db_hive cascade;

OK

Time taken: 0.364 seconds

1.5 创建表

1. 建表语法

CREATE [EXTERNAL] TABLE [IF NOT EXISTS] table_name

[(col_name data_type [COMMENT col_comment], ...)]

[COMMENT table_comment]

[PARTITIONED BY (col_name data_type [COMMENT col_comment], ...)]

[CLUSTERED BY (col_name, col_name, ...)

[SORTED BY (col_name [ASC|DESC], ...)] INTO num_buckets BUCKETS]

[ROW FORMAT row_format]

[STORED AS file_format]

[LOCATION hdfs_path]

[TBLPROPERTIES (property_name=property_value, ...)]

[AS select_statement]

2. 字段解释说明

(1)CREATE TABLE:创建一个指定名字的表。如果相同名字的表已经存在,则抛出异常,用户可以用 IF NOT EXISTS 选项来忽略这个异常。

(2) EXTERNAL 关键字:可以让用户创建一个外部表,在建表的同时,可以指定一个指向实际数据的路径( LOCATION ),在删除表的时候,内部表的元数据和数据会被一起删除,而外部表只删除元数据,不删除数据。

(3)COMMENT :为表和列添加注释。

(4)PARTITIONED BY:创建分区表。

(5)CLUSTERED BY:创建分桶表。

(6)SORTED BY:不常用,对桶中的一个或多个列另外排序。

(7)ROW FORMAT

DELIMITED [FIELDS TERMINATED BY char] [COLLECTION ITEMS TERMINATED BY char]

[MAP KEYS TERMINATED BY char] [LINES TERMINATED BY char]

| SERDE serde_name [WITH SERDEPROPERTIES (property_name=property_value, property_name=property_value, …)]

用户在建表的时候可以自定义SerDe 或者使用自带的 SerDe 。如果没有指定 ROW FORMAT 或者 ROW FORMAT DELIMITED ,将会使用自带的 SerDe 。在建表的时候,用户还需要为表指定列,用户在指定表的列的同时也会指定自定义的 SerDe,Hive 通过 SerDe 确定表的具体的列的数据。

SerDe 是 Serialize/Deserilize 的简称, hive 使用 Serde 进行行对象的序列与反序列化。

(8)STORED AS:指定存储文件类型

常用的存储文件类型:SEQUENCEFILE (二进制序列文件)、 TEXTFILE (文本)、 RCFILE (列

式存储格式文件)

如果文件数据是纯文本,可以使用STORED AS TEXTFILE 。如果数据需要压缩,使用 STORED

AS SEQUENCEFILE 。

(9)LOCATION :指定表在 HDFS 上的存储位置。

(10)AS :后跟查询语句 根据查询结果创建表 。

(11)LIKE:允许用户复制现有的表结构,但是不复制数据。

1.5.1 管理表

1. 理论

默认创建的表都是所谓的管理表,有时也被称为内部表。因为这种表,Hive 会(或多或少地)控制着数据的生命周期。 Hive 默认情况下会将这些表的数据存储在由配置hive.metastore.warehouse.dir(例如,/user/hive/warehouse) 所定义的目录的子目录下。

当我们删除一个管理表时,Hive 也会删除这个表中数据。 管理表不适合和其他工具共享数据。

2. 案例实操

由于 Hive 是针对数据仓库应用设计的,而数据仓库的内容是读多写少的。 因此, Hive 中不建议对数据的改写,所有的数据都是在加载的时候确定好的。 而数据库中的数据通常是需要经常进行修改的,因此可以使用 INSERT INTO … VALUES 添加数据,使用 UPDATE … SET 修改数据。

(1)普通创建表

hive (default)> create table if not exists student(

> id int, name string

> )

> row format delimited fields terminated by '\t'

> stored as textfile

> location '/user/hive/warehouse/student';

OK

Time taken: 0.397 seconds

(2)根据查询结果创建表(查询的结果会添加到新创建的表中)

hive (default)> create table if not exists student2 as select id, name from student;

(3)根据已经存在的表结构创建表

hive (default)> create table if not exists student3 like student;

OK

Time taken: 0.145 seconds

(4)查询表的类型

hive (default)> desc formatted student2;

Table Type: MANAGED_TABLE

1.5.2 外部表

1. 理论

因为表是外部表,所以 Hive并非认为其完全拥有这份数据。删除该表并不会删除掉这份数据,不过描述表的元数据信息会被删除掉。

2. 管理表和外部表的使用场景

每天将收集到的网站日志定期流入HDFS 文本文件。在外部表(原始日志表)的基础上做大量的统计分析,用到的中间表、结果表使用内部表存储,数据通过 SELECT+INSERT 进入内部表。

3. 案例实操

创建学生表

student:

1001 ss1

1002 ss2

1003 ss3

1004 ss4

1005 ss5

1006 ss6

1007 ss7

1008 ss8

1009 ss9

1010 ss10

1011 ss1

1012 ss12

1013 ss13

1014 ss14

1015 ss15

1016 ss16

(1)上传数据到HDFS

hive (default)> dfs -mkdir /student;

hive (default)> dfs -put /opt/module/hive-3.1.2/data/student.txt /student;

(2)创建表并载入数据

hive (default)> create external table if not exists student(

> id int,

> name string

> )

> row format delimited fields terminated by '\t';

OK

Time taken: 0.091 seconds

hive (default)> load data inpath '/student/student.txt' into table default.student;

Loading data to table default.student

OK

Time taken: 0.419 seconds

(3)查看表的类型

hive (default)> desc formatted student;

Table Type: EXTERNAL_TABLE

(4)删除外部表

hive (default)> drop table student;

OK

Time taken: 0.168 seconds

外部表删除后,hdfs中的数据还在,但是 metadata中 dept的元数据已被删除。

1.5.3 管理表与外部表的互相转换

(1)查询表的类型

hive (default)> desc formatted student2;

Table Type: MANAGED_TABLE

(2)修改内部表 student2为外部表

hive (default)> alter table student2 set tblproperties('EXTERNAL'='TRUE');

OK

Time taken: 0.174 seconds

(3)查询表的类型

Table Type: EXTERNAL_TABLE

(4)修改外部表 student2为内部表

hive (default)> alter table student2 set tblproperties('EXTERNAL'='FALSE');

OK

Time taken: 0.153 seconds

(5)查询表的类型

Table Type: MANAGED_TABLE

注意:(‘EXTERNAL’=‘TRUE’)和 (‘EXTERNAL’=‘FALSE’)为固定写法,区分大小写

1.6 修改表

1. 重命名表

(1)语法

ALTER TABLE table_name RENAME TO new_table_name

(2)实操案例

hive (default)> alter table student2 rename to student4;

OK

Time taken: 0.258 seconds

2. 增加/修改/替换列信息

更新列

ALTER TABLE table_name CHANGE [COLUMN] col_old_name col_new_name

column_type [COMMENT col_comment] [FIRST|AFTER column_name]

增加和替换列

ALTER TABLE table_name ADD|REPLACE COLUMNS (col_name data_type [COMMENT

col_comment], ...)

ADD是代表新增一字段,字段位置在所有列后面(partition列前),REPLACE则是表示替换表中所有字段。

(1)查询表结构

hive (default)> desc dept;

OK

col_name data_type comment

deptno int

dname string

loc int

Time taken: 0.099 seconds, Fetched: 3 row(s)

(2)添加列

hive (default)> alter table dept add columns(deptdesc string);

OK

Time taken: 0.138 seconds

(3)查询表结构

hive (default)> desc dept;

OK

col_name data_type comment

deptno int

dname string

loc int

deptdesc string

Time taken: 0.056 seconds, Fetched: 4 row(s)

(3)更新列

hive (default)> alter table dept change column deptdesc desc string;

OK

Time taken: 0.192 seconds

(3)查询表结构

hive (default)> desc dept;

OK

col_name data_type comment

deptno int

dname string

loc int

desc string

Time taken: 0.064 seconds, Fetched: 4 row(s)

(3)替换列

hive (default)> alter table dept replace columns(deptno string, dname string, loc string);

OK

Time taken: 0.149 seconds

(3)查询表结构

hive (default)> desc dept;

OK

col_name data_type comment

deptno string

dname string

loc string

Time taken: 0.064 seconds, Fetched: 3 row(s)

1.7 删除表

hive (default)> drop table dept;

OK

Time taken: 1.901 seconds

2 DML 数据操作

2.1 数据导入

1. 向表中装载数据(load)

hive> load data [local] inpath ' 数据的 path ' overwrite into table

student [partition (partcol1=val1,…)];

(1)load data:表示加载数据

(2)local:表示从本地加载数据到 hive表,否则从 HDFS加载数据到 hive表

(3)inpath: 表示加载数据的路径

(4)overwrite: 表示覆盖表中已有数据,否则表示追加

(5)into table: 表示加载到哪张表

(6)student:表示具体的表

(7)partition:表示上传到指定分区

2. 实操案例

(1)创建一张表

hive (default)> create table student(id string, name string)

> row format delimited fields terminated by '\t';

OK

Time taken: 0.878 seconds

(2)加载本地文件到 hive

hive (default)> load data local inpath '/opt/module/hive-3.1.2/data/student.txt' into table student;

Loading data to table default.student

OK

Time taken: 2.725 seconds

(3)加载 HDFS文件到 hive中

hive (default)> dfs -put /opt/module/hive-3.1.2/data/student.txt /student;

hive (default)> load data inpath '/student' into table student;

Loading data to table default.student

OK

Time taken: 0.712 seconds

(4)加载数据覆盖表中已有的数据

hive (default)> dfs -put /opt/module/hive-3.1.2/data/student.txt /student;

hive (default)> load data inpath '/student/student.txt' overwrite into table student;

Loading data to table default.student

OK

Time taken: 0.501 seconds

3. 通过查询语句向表中插入数据(Insert)

(1)创建一张表

hive (default)> create table student_par(id int, name string)

> row format delimited fields terminated by '\t';

OK

Time taken: 0.225 seconds

(2)基本插入数据

hive (default)> insert into table student_par

> values(1, 'liubai'), (2, 'junmo');

(3)基本模式插入(根据单张表查询结果)

hive (default)> insert overwrite table student_par

> select id, name from student where month='201609';

insert into::以追加数据的方式插入到表或分区,原有数据不会删除

insert overwrite:会覆盖表中已存在的数据

注意:insert不支持插入部分字段

(4)多表(多分区)插入模式(根据多张表查询结果)

hive (default)> from student

> insert overwrite table student partition(month='201707')

> select id, name where month='201709'

> insert overwrite table student partition(month='201706')

> select id, name where month='201709';

4. 查询语句中创建表并加载数据( As Select)

根据查询结果创建表(查询的结果会添加到新创建的表中)

hive (default)> create table if not exists student3

> as select id, name from student;

5. 创建表时通过 Location指定加载数据路径

(1)上传数据到 hdfs 上

hive (default)> dfs -put /opt/module/hive-3.1.2/data/student.txt /student;

(2)创建表,并指定在 hdfs 上的位置

hive (default)> create external table if not exists student5(

> id int, name string

> )

> row format delimited fields terminated by '\t'

> location '/student';

Time taken: 0.111 seconds

(3)查询数据

hive (default)> select * from student5;

OK

student5.id student5.name

1001 ss1

1002 ss2

1003 ss3

1004 ss4

1005 ss5

1006 ss6

1007 ss7

1008 ss8

1009 ss9

1010 ss10

1011 ss11

1012 ss12

1013 ss13

1014 ss14

1015 ss15

1016 ss16

Time taken: 0.275 seconds, Fetched: 16 row(s)

6. Import数据到指定 Hive表中

注意: 先用 export导出后,再将数据导入。

hive (default)> import table student2 from

> '/student';

Copying data from hdfs://hadoop102:8020/student/data

Copying file: hdfs://hadoop102:8020/student/data/student.txt

Loading data to table default.student2

OK

Time taken: 1.234 seconds

2.2 数据导出

1. Insert 导出

(1)将查询的结果导出到本地

hive (default)> insert overwrite local directory '/opt/module/hive-3.1.2/data/student'

> select * from student;

(2)将查询的结果格式化导出到本地

hive (default)> insert overwrite local directory

> '/opt/module/hive-3.1.2/data/student'

> row format delimited fields terminated by '\t'

> select * from student;

(3)将查询的结果导出到 HDFS上 (没有 local)

hive (default)> insert overwrite directory '/student'

> row format delimited fields terminated by '\t'

> select * from student;

2. Hadoop 命令导出到本地

hive (default)> dfs -get /user/hive/warehouse/student/student.txt /opt/module/hive-3.1.2/data/student;

3. Hive Shell 命令导出

基本语法:hive -f/-e 执行语句或者脚本 > file

[Tom@hadoop102 hive-3.1.2]$ bin/hive -e 'select * from default.student;' > /opt/module/hive-3.1.2/data/student/student2.txt;

4. Export导出到 HDFS上

export和 import主要用于 两个 Hadoop平台集群之间 Hive表迁移。

hive (default)> export table default.student to

> '/student';

OK

Time taken: 1.434 seconds

5. 清除表中数据(truncate)

注意:Truncate只能删除管理表,不能删除外部表中数据

hive (default)> truncate table student;

OK

Time taken: 0.353 seconds

参考:

https://www.bilibili.com/video/BV1EZ4y1G7iL?spm_id_from=333.788.b_636f6d6d656e74.11