本文目录如下:

第1章 Spark Streaming概述

Spark Streaming 使得构建可扩展的容错流应用程序变得更加容易。

1.1 Spark Streaming 是什么

Spark Streaming用于流式数据的处理。Spark Streaming支持的数据输入源很多,例如:Kafka、Flume、Twitter、ZeroMQ和简单的TCP套接字等等。数据输入后可以用Spark的高度抽象原语如:map、reduce、join、window等进行运算。而结果也能保存在很多地方,如HDFS,数据库等。- 和 Spark 基于 RDD 的概念很相似,

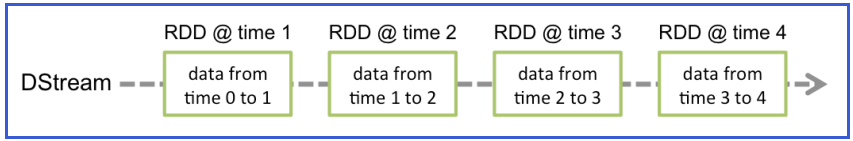

Spark Streaming使用离散化流(discretized stream)作为抽象表示,叫作DStream。DStream是随时间推移而收到的数据的序列。在内部,每个时间区间收到的数据都作为RDD存在,而DStream是由这些RDD所组成的序列(因此得名“离散化”)。所以简单来将,DStream就是对RDD在实时数据处理场景的一种封装。

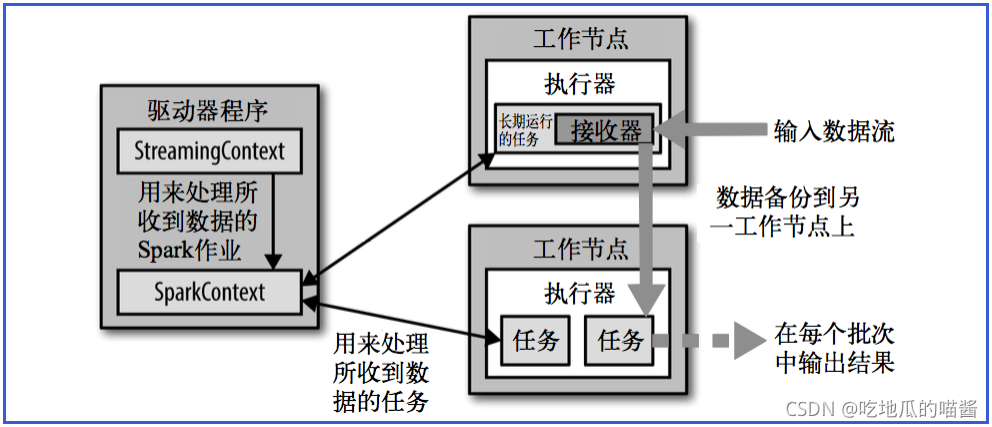

1.2 Spark Streaming架构

1.2.1 架构图

Spark Streaming架构图:

1.2.2 背压机制

Spark Streaming可以动态控制数据接收速率来适配集群数据处理能力。背压机制(即 Spark Streaming Backpressure): 根据JobScheduler反馈作业的执行信息来动态调整Receiver数据接收率。- 通过属性“

spark.streaming.backpressure.enabled”来控制是否启用backpressure机制,默认值false,即不启用。

第2章 Dstream 入门

2.1 WordCount 案例实操

- 需求:使用

netcat工具向9999端口不断的发送数据,通过SparkStreaming读取端口数据并统计不同单词出现的次数。

2.1.1 添加依赖

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming_2.12</artifactId>

<version>3.0.0</version>

</dependency>

2.1.2 编写代码

import org.apache.spark.SparkConf

import org.apache.spark.streaming.dstream.{DStream, ReceiverInputDStream}

import org.apache.spark.streaming.{Seconds, StreamingContext}

object SparkStreaming01_WordCount {

def main(args: Array[String]): Unit = {

// TODO 创建环境对象

// StreamingContext创建时, 需要传递两个参数第一个参数表示环境配置

val sparkConf = new SparkConf().setMaster("local[*]").setAppName ("SparkStreaming")

// 第二个参数表示批量处理的周期(采集周期)

val ssc = new StreamingContext(sparkConf, Seconds(3))

// TODO 逻辑处理

// 获取端口数排

val lines: ReceiverInputDStream[String] = ssc.socketTextStream("localhost", 9999)

val words = lines.flatMap(_.split(" "))

val wordToOne = words.map((_, 1))

val wordToCount: DStream[(String, Int)] = wordToOne.reduceByKey(_+_)

wordToCount.print()

// TODO 关闭环境

// 由于SparkStreaming采集器是长期执行的任务, 所以不能直接关闭

// 如果main方法执行完毕, 应用程序也会自动结束。所以不能让main执行完毕

// ssc.stop()

//1.后动采货鹦

ssc.start()

// 2.等待采集器的关闭

ssc.awaitTermination()

}

}

2.1.3 启动程序并通过 netcat 发送数据

- 启动程序之前,要先在

Windows命令行工具上输入下列命令:

nc -lp 9999

# 启动程序后输入下面的字符串

hello spark

注:执行之前首先需要在 Windows主机 上安装 netcat,详情可参考: Windows环境下安装netcat。

2.2 WordCount 解析

-

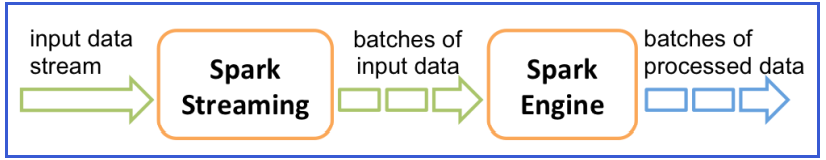

Discretized Stream是Spark Streaming的基础抽象,代表持续性的数据流和经过各种Spark原语操作后的结果数据流。在内部实现上,DStream是一系列连续的RDD来表示。每个RDD含有一段时间间隔内的数据。

-

对数据的操作也是按照

RDD为单位来进行的。

-

计算过程由

Spark Engine来完成。

声明:本文是学习时记录的笔记,如有侵权请告知删除!

原视频地址:https://www.bilibili.com/video/BV11A411L7CK