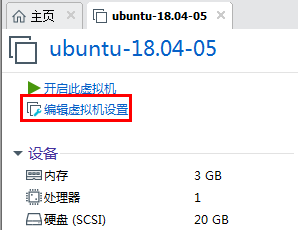

??首先调大虚拟机内存为6G左右:

一、安装atlas

mvn clean -DskipTests package -Pdist,external-hbase-solr -Denforcer.skip=true

# 由于atlas只提供源码,所以需要我们先将源码编译后,再将压缩包上传到服务器

tar -zxvf apache-atlas-2.1.0-server.tar.gz

1.集成 Hbase:

root@ubuntu:/opt/bigdata-packages/atlas# vim apache-atlas-2.1.0/conf/atlas-application.properties

# 修改 atlas 存储数据主机

atlas.graph.storage.hostname=127.0.0.1:2181

root@ubuntu:/opt/bigdata-packages/atlas# ln -s /opt/bigdata-packages/hbase/hbase-2.0.6/conf/ /opt/bigdata-packages/atlas/apache-atlas-2.1.0/conf/hbase/

root@ubuntu:/opt/bigdata-packages/atlas# vim apache-atlas-2.1.0/conf/atlas-env.sh

#添加HBase配置文件路径

export HBASE_CONF_DIR=/opt/bigdata-packages/hbase/hbase-2.0.6/conf

2.集成 Solr:

root@ubuntu:/opt/bigdata-packages/atlas# vim apache-atlas-2.1.0/conf/atlas-application.properties

# 修改配置为

atlas.graph.index.search.solr.zookeeper-url=atlas.graph.index.search.solr.zookeeper-url=127.0.0.1:2181

# 将 Atlas 自带的 Solr 文件夹拷贝到外部 Solr 集群的各个节点。

root@ubuntu:/opt/bigdata-packages/atlas# cp -r apache-atlas-2.1.0/conf/solr/ /opt/bigdata-packages/solr/solr-8.9.0

# 修改拷贝过来的配置文件名称为atlas_conf

root@ubuntu:/opt/bigdata-packages/solr/solr-8.9.0# mv solr atlas_conf

# 在Cloud模式下,启动Solr(需要提前启动Zookeeper集群),并创建collection

root@ubuntu:/opt/bigdata-packages/solr/solr-8.9.0# bin/solr create -c vertex_index -d atlas_conf -shards 3 -replicationFactor 2 -force

root@ubuntu:/opt/bigdata-packages/solr/solr-8.9.0# bin/solr create -c edge_index -d atlas_conf -shards 3 -replicationFactor 2 -force

root@ubuntu:/opt/bigdata-packages/solr/solr-8.9.0# bin/solr create -c fulltext_index -d atlas_conf -shards 3 -replicationFactor 2 -force

注:如果需要删除vertex_index、edge_index、fulltext_index等collection可以执行如下命令:bin/solr delete -c ${collection_name}

验证创建collection成功:访问 http://192.168.223.128:8983/solr/#/~cloud 看到如下图显示:

遇到的问题:创建collection的时候会报错:Unable to read additional data from server sessionid 0x17c831dd49f0009, likely server has closed socket。

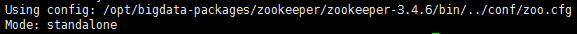

可能的原因:我这里zookeeper装的是单节点的,zookeeper有个选举算法,当整个集群超过半数机器宕机,zookeeper会认为集群处于不可用状态。一般至少需要三个zk才可以,一般是2n+1的数量部署。目前来看collection都已近创建成功了,不知道zookeeper单节点有没有问题,先往后走吧,不行的话再改成三个节点的吧。

3.集成 Kafka:

root@ubuntu:/opt/bigdata-packages/atlas# vim apache-atlas-2.1.0/conf/atlas-application.properties

# 修改配置为

atlas.notification.embedded=false

atlas.kafka.data=/opt/bigdata-packages/atlas/apache-atlas-2.1.0/data/kafka

atlas.kafka.zookeeper.connect=localhost:2181

atlas.kafka.bootstrap.servers=localhost:9092

atlas.kafka.zookeeper.session.timeout.ms=4000

atlas.kafka.zookeeper.connection.timeout.ms=2000

atlas.kafka.enable.auto.commit=true