安装Spark和Scala

上篇完成后操作此篇

解压到安装目录

tar zxvf /h3cu/spark-2.1.1-bin-hadoop2.7.tgz -C /usr/local/src/

创建软链快捷键

ln -s /usr/local/src/spark-2.1.1-bin-hadoop2.7 /usr/local/src/spark

查看软链快捷键

ls -il

删除软链快捷键

rm -rf symbolic_name 注意不是rm -rf symbolic_name/

修改配置文件

cd /usr/local/src/spark/conf/

spark-env.sh

将spark-env.sh.template重命名为spark-env.sh

mv spark-env.sh.template spark-env.sh

修改文件

mv spark-env.sh.template spark-env.sh

vim /conf/spark-env.sh

export JAVA_HOME=/usr/local/src/jdk1.8.0_311

export HADOOP_HOME=/usr/local/src/hadoop-2.7.7

SPARK_MASTER_IP=Master 电脑IP地址每台节点对应没个自己的主机名

SPARK_LOCAL_DIRS=/usr/local/src/spark

SPARK_DRIVER_MEMORY=512M

将slaves.template重命名为slaves

mv slaves.template slaves

添加主机名

vim slaves

master2

slave3

slave4

配置环境变量

vim /root/.bash_profile

export SPARK_HOME=/usr/local/src/spark

export PATH=$PATH:/usr/local/src/spark/bin:/usr/local/bigdata/spark/sbin

修改sbin目录下的spark-config.sh,添加jdk的环境变量(如果不添加,启动spark的时候会报“JAVA_HOME not set” 异常)

[root@Master2 spark]# cd sbin

vim spark-config.sh

export JAVA_HOME=/usr/local/src/jdk1.8.0_311

运行Spark

先启动hadoop

cd $HADOOP_HOME/sbin/

./start-dfs.sh

./start-yarn.sh

#./start-history-server.sh

在启动sapark

cd $SPARK_HOME/sbin/

./start-all.sh

./start-history-server.sh

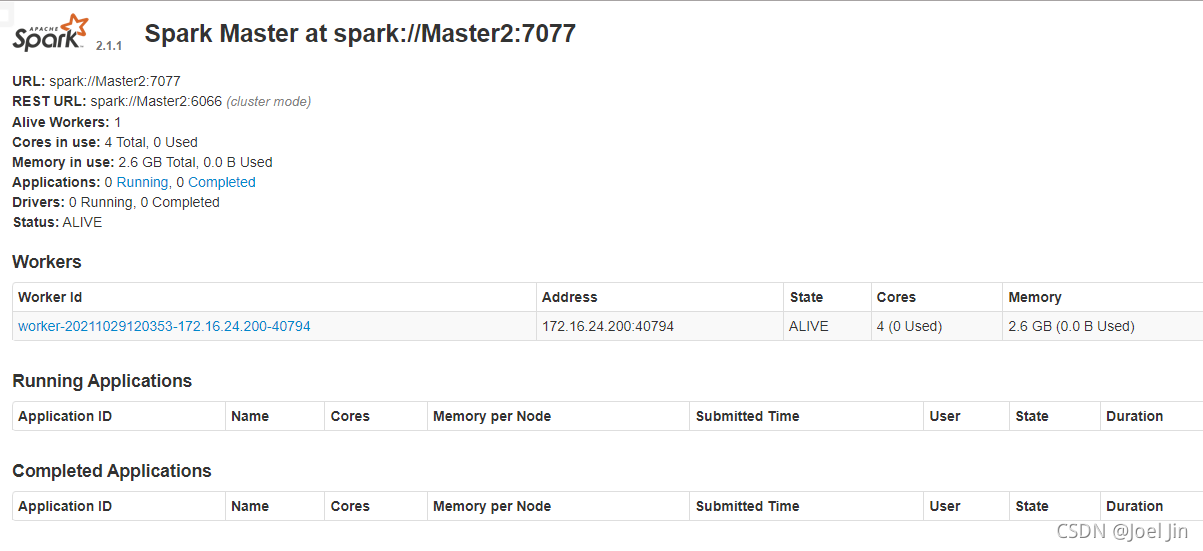

spark启动成功后,可以在浏览器中查看相关资源情况

http://172.16.24.200:8080/

完成实例图

配置Scala环境

spark既可以使用Scala作为开发语言,也可以使用python作为开发语言。

安装Scala

tar zxvf /h3cu/scala-2.12.5.tgz -C /usr/local/src/

创建软链

ln -s /usr/local/src/scala-2.11.0 /usr/local/src/Scala

两个选一个就可以

然后在/etc/profile文件中添加如下内容,并执行.bash_profile命令使其生效

vim /etc/profile

#jdk

export JAVA_HOME=/usr/local/src/jdk

export PATH=$JAVA_HOME/bin:$PATH

#hadoop

export HADOOP_HOME=/usr/local/src/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

#Scala

export SCALA_HOME=/usr/local/src/scala

export PATH=/usr/local/src/scala-2.12.5/bin:$PATH

vim .bash_profile

vim /root/.bash_profile

#jdk

export JAVA_HOME=/usr/local/src/jdk

#hadoop

export HADOOP_HOME=/usr/local/src/hadoop

#Scala

export SCALA_HOME=/usr/local/src/scala

PATH=.:$JAVA_HOME:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH:$HOME/bin

环境变量重启

source /etc/profile

source /root/.bash_profile

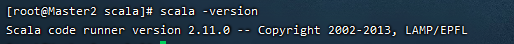

测试是否安装成功

scala -version

成功实例图

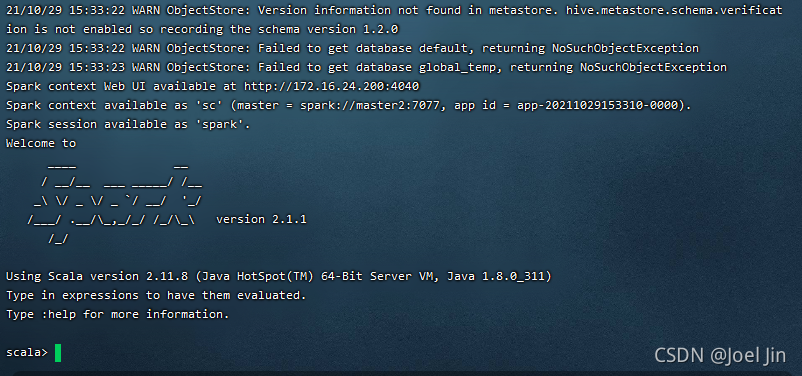

启动Spark shell界面

执行spark-shell --master spark://master2:7077命令,启动spark shell

spark-shell --master spark://master2:7077

成功实列图