1.解压 hadoop-3.1.3.tar.gz 至 /usr/local/

sudo tar -zxf hadoop-3.1.3.tar.gz -C /usr/local/

cd /usr/local/

sudo mv ./hadoop-3.1.3/ ./hadoop #修改文件名

sudo chown -R hadoop ./hadoop # 修改文件权限

2.测试hadoop是否安装成功

cd /usr/local/hadoop/bin

hadoop version

3.Hadoop 默认模式为非分布式模式(本地模式),无需进行其他配置即可运行。非分布式即单 Java 进程,方便进行调试。

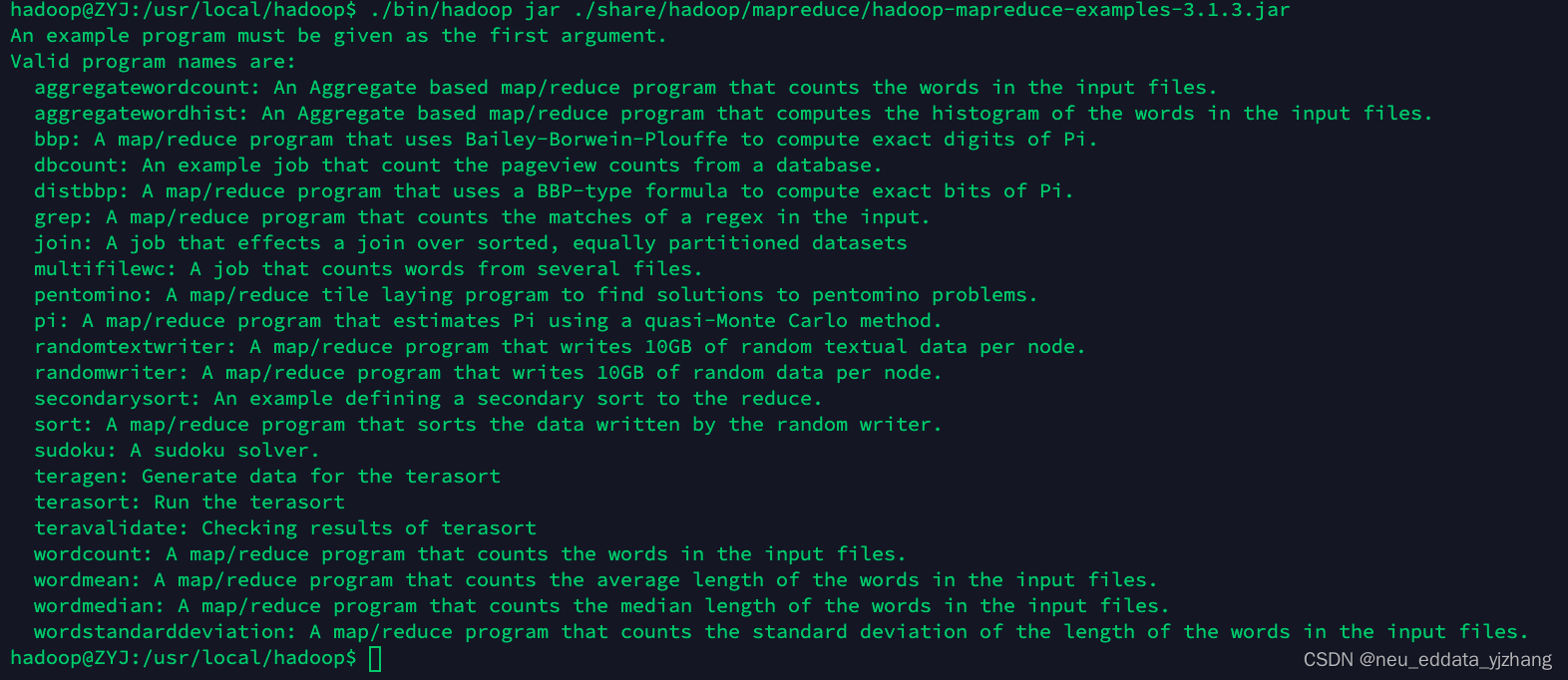

现在我们可以执行例子来感受下 Hadoop 的运行。Hadoop 附带了丰富的例子,运行下述语句后就可以看到其包括 wordcount、terasort、join、grep 等。

./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar

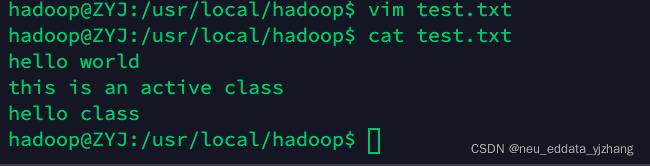

4.试运行 wordcount 程序

?

bin/hadoop??jar??share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.0.jar ? ? ?wordcount???test.txt????output?

5. 配置伪分布式集群

Hadoop 的配置文件位于 /usr/local/hadoop/etc/hadoop/ 中,伪分布式需要修改2个配置文件?core-site.xml?和?hdfs-site.xml?。Hadoop的配置文件是 xml 格式,每个配置以声明 property 的 name 和 value 的方式来实现。

# 两个文件修改之前 configuration 部分的内容

<configuration>

</configuration>

#core-site.xml 修改后 configuration 部分的内容

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

#hdfs-site.xml 修改后 configuration 部分的内容

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>配置完成后,执行 NameNode 的格式化:

?cd /usr/local/hadoop

./bin/hdfs namenode -format

成功的话,会看到 “successfully formatted” 的提示,具体返回信息类似如下:

2020-01-08 15:31:31,560 INFO namenode.NameNode: STARTUP_MSG:

/************************************************************

STARTUP_MSG: Starting NameNode

STARTUP_MSG: host = hadoop/127.0.1.1

STARTUP_MSG: args = [-format]

STARTUP_MSG: version = 3.1.3

*************************************************************/

......

2020-01-08 15:31:35,677 INFO common.Storage: Storage directory /usr/local/hadoop/tmp/dfs/name **has been successfully formatted**.

2020-01-08 15:31:35,700 INFO namenode.FSImageFormatProtobuf: Saving image file /usr/local/hadoop/tmp/dfs/name/current/fsimage.ckpt_0000000000000000000 using no compression

2020-01-08 15:31:35,770 INFO namenode.FSImageFormatProtobuf: Image file /usr/local/hadoop/tmp/dfs/name/current/fsimage.ckpt_0000000000000000000 of size 393 bytes saved in 0 seconds .

2020-01-08 15:31:35,810 INFO namenode.NNStorageRetentionManager: Going to retain 1 images with txid >= 0

2020-01-08 15:31:35,816 INFO namenode.FSImage: FSImageSaver clean checkpoint: txid = 0 when meet shutdown.

2020-01-08 15:31:35,816 INFO namenode.NameNode: SHUTDOWN_MSG:

/************************************************************

SHUTDOWN_MSG: Shutting down NameNode at hadoop/127.0.1.1

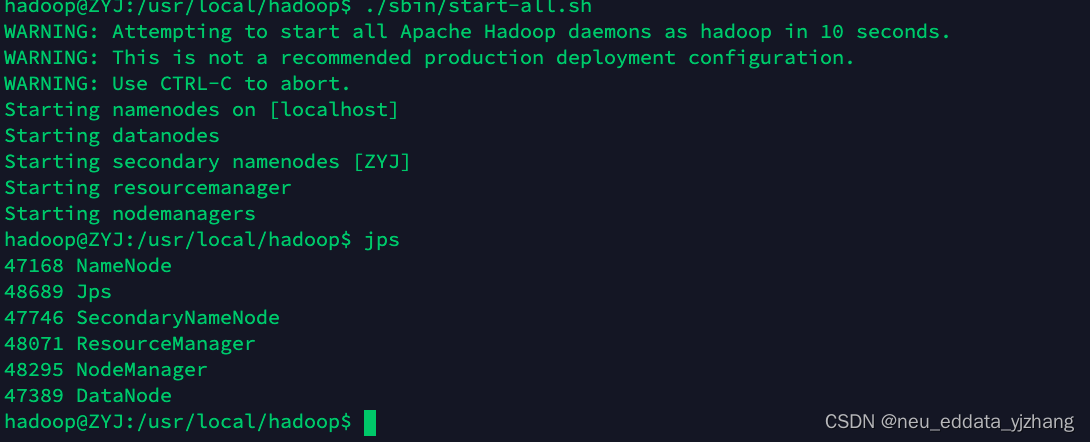

*************************************************************/接着开启 NameNode 和 DataNode 守护进程,并使用 jps 命令查看结果。

cd /usr/local/hadoop

./sbin/start-dfs.sh

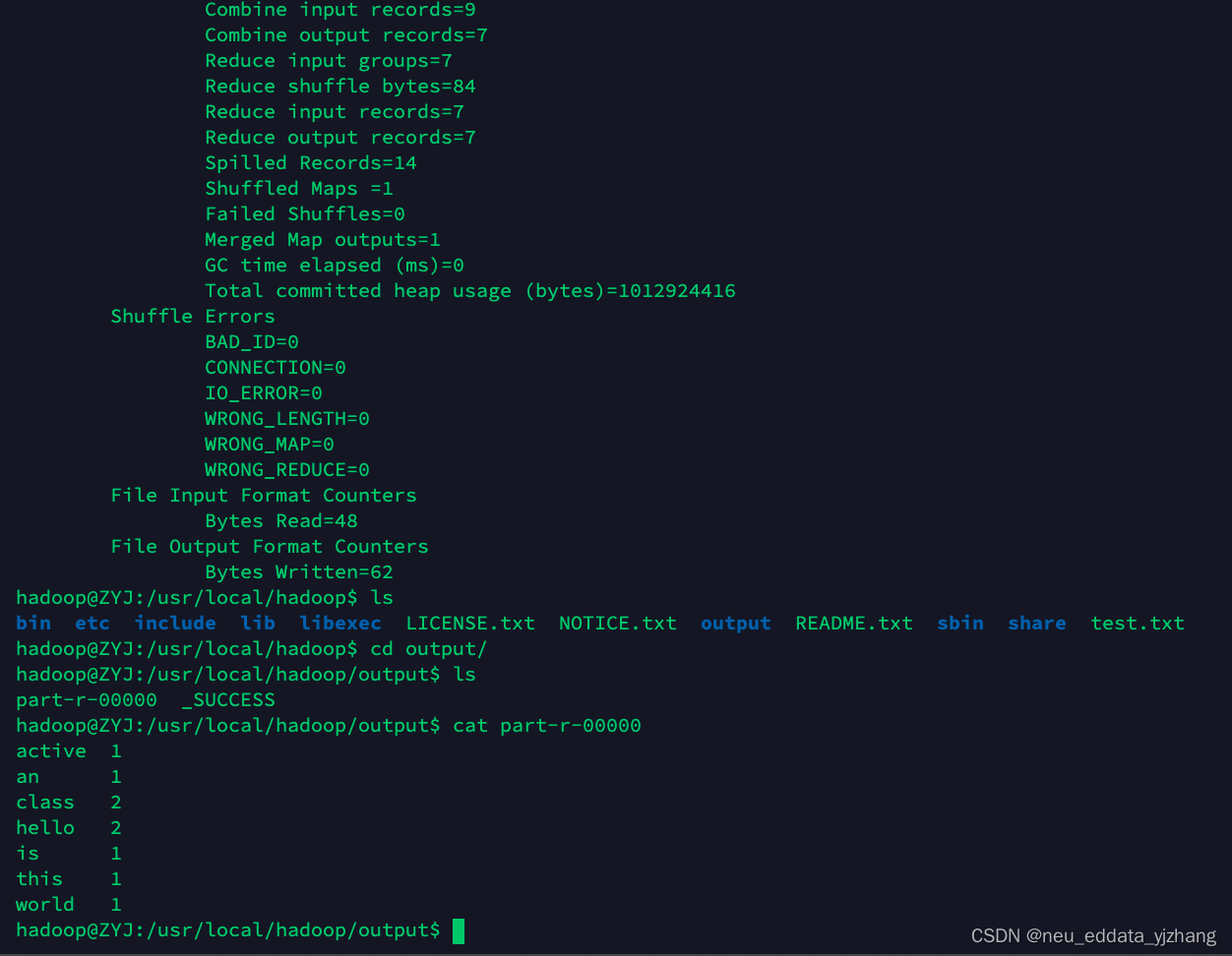

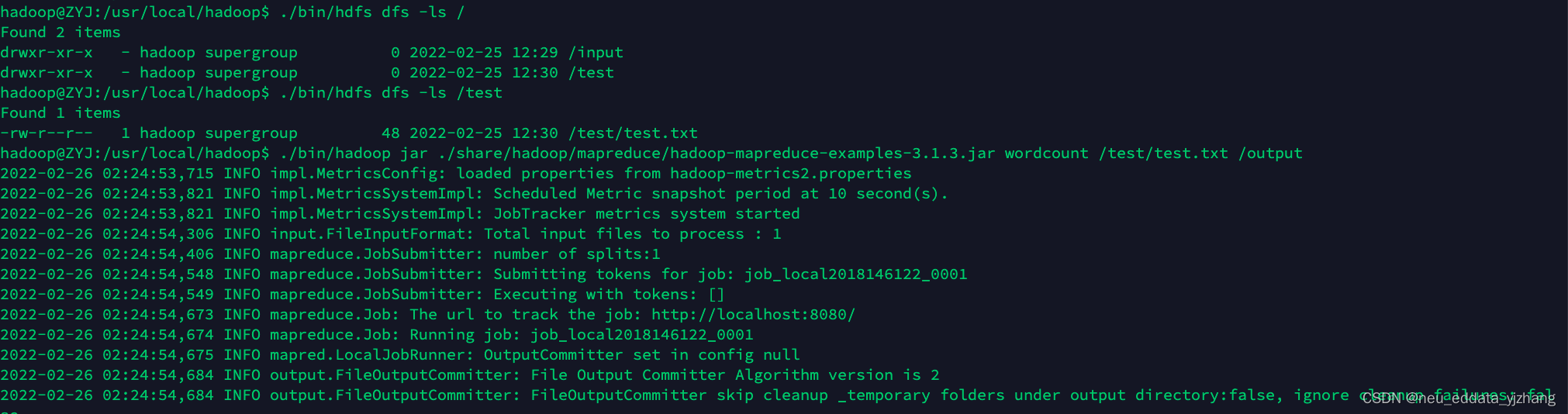

6.伪分布式运行结果测试

??

??

7.HBase安装

7.1?解压安装包hbase-2.2.2-bin.tar.gz至路径 /usr/local,并命名为hbase

sudo tar -zxf hbase-2.2.2-bin.tar.gz -C /usr/local

cd /usr/local

sudo mv ./hbase-2.2.2 ./hbase

sudo chown -R hadoop ./hbase

7.2 修改环境变量

vim ~/.bashrc

export PATH=$PATH:/usr/local/hbase/bin #在文件的最后加上这句话

source ~/.bashrc

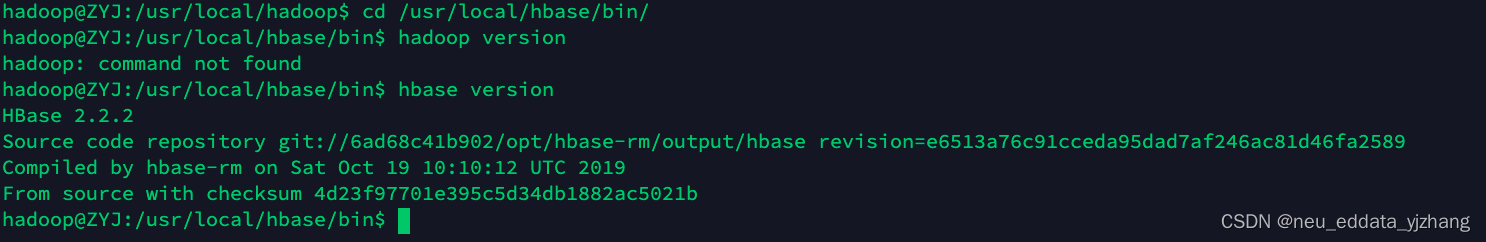

7.3 查看HBase版本

7.4 配置HBase

使用vim命令配置/usr/local/hbase/conf/hbase-env.sh,在文件的最后加入下面的语句

export JAVA_HOME=/usr/local/jdk1.8 #你自己jdk的安装位置

export HBASE_CLASSPATH=/usr/local/hbase/conf

export HBASE_MANAGES_ZK=true使用vim命令配置/usr/local/hbase/conf/hbase-site.xml

#和之前一样,将 configuration部分改成如下即可

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://localhost:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.unsafe.stream.capability.enforce</name>

<value>false</value>

</property>

</configuration>接下来启动hadoop和hdfs,启动以后输入jps 查看。

cd /usr/local/hadoop

./sbin/start-dfs.sh

cd ../hbase

./bin/start-hbase.sh

./bin/hbase shell

????????

????????

最后退出数据库操作,输入exit命令即可退出,注意:这里退出HBase数据库是退出对数据库表的操作,而不是停止启动HBase数据库后台运行

?