学习目标:

搭建spark2.4.0并用jsp查看master、slave1、slave2上的进程

学习内容:

搭建spark 2.4.0

学习时间:

- 周一至周五晚上 7 点—晚上9点

- 周六上午 9 点-上午 11 点

- 周日下午 3 点-下午 6 点

学习产出:

这次搭建是基于云创Hadoop大数据平台,并且已经起好hadoop的进程

1.将spark2.4.0下载并解压

scp?-r?root@10.30.56.2:/usr/local/spark*?/usr

tar vxfz? spark-2.4.0-bin-without-hadoop.tgz

mv?spark-2.4.0-bin-without-hadoop? spark(将解压后的文件改为spark)

不难发现我们现在解压的spark在usr下,进入/usr/cstor 路径下,发现已经存在一个spark(那是旧的那个版本我们要把它改掉)

cd /usr/cstor

mv spark spark-old

cd ..

mv spark? /usr/cstor(将usr下的spark移到cstor)

2.接下来只需要改3个配置文件我们就可以启动spark了

2.1.配置slaves

cd /usr/cstor/spark/conf

cp slaves.template slaves

vim slaves将里面的localhost换成

slave1

slave2

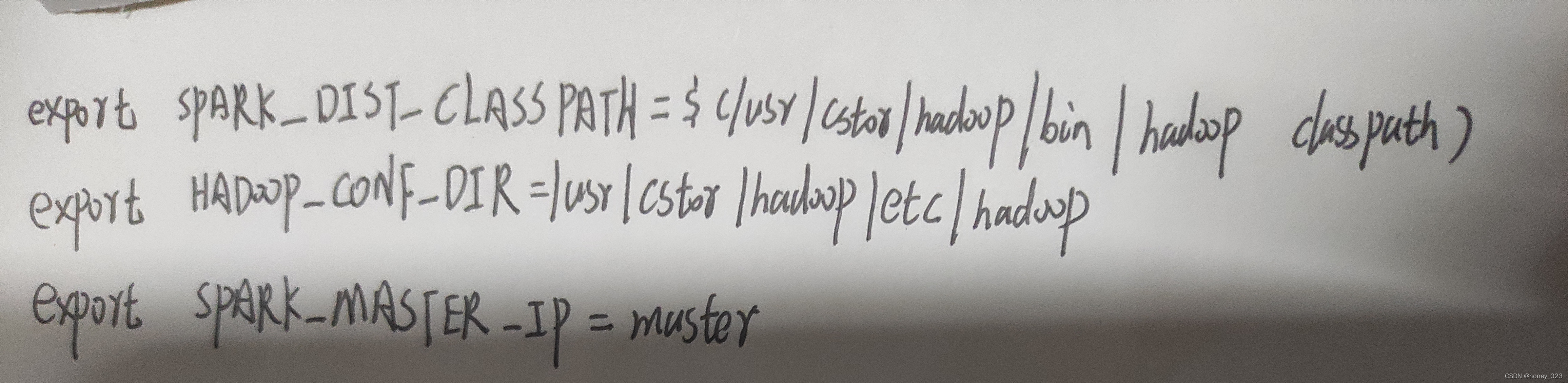

2.2.配置spark-env.sh文件

cd /usr/cstor

mv spark-env.sh.template spark-env.sh

vim spark-env.sh将图片上的3个export添加进去

添加好了我们将spark拷贝到slave1、slave2节点上去

?scp?-r?root@master:/usr/cstor/spark?slave1:/usr/cstor

?scp?-r?root@master:/usr/cstor/spark?slave2:/usr/cstor

2.3.配置bashrc

cd /usr/cstor/spark/sbin

vim ~/.bashrc将export添加进去

export SPARK_HOME=/usr/local/jdk1.8.0_161(后面jdk版本由你当前的版本而定不确定就用

echo $JAVA_HOME 查看)

source? ~/.bashrc

在slave1和slave2中都要配一遍java_home

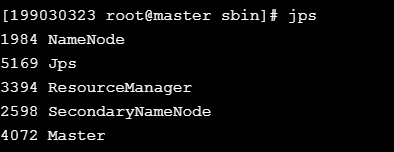

3.启动spark

cd /usr/cstor/spark/sbin

sh start-master.sh

sh start-slaves.sh

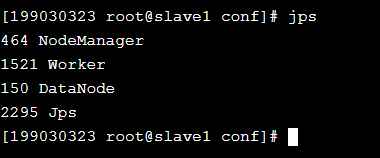

用jsp查看进程

启动spark

pyspark

最后的结果如下

?

?

?

?

?

?以上就是今天的基于云创的spark2.4.0的搭建,嘿嘿,一个小白,有问题大家多多帮助,有问题也希望大家留言。我们一起加油吧!