提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

前言

Hadoop 3.3.1(HA)+Zookeeper3.4.10+Hbase2.4.4(HA)搭建高可用集群。

由于一个HDFS集群由一个NameNode节点和多个DataNode节点组成,一旦NameNode节点宕机,那么HDFS将不能进行文件的上传与下载。

由于一个Yarn集群由一个ResourceManager节点和多个NodeManager节点组成,一旦ResourceManager节点宕机,那么YARN集群将不能进行资源的调度。

提示:以下是本篇文章正文内容,下面案例可供参考

一、Hbase是什么?

HBase 是一个分布式的、面向列的开源数据库,该技术来源于 Fay Chang 所撰写的 Google 论文“Bigtable:一个结构化数据的分布式存储系统”。就像 Bigtable 利用了 Google 文件系统(File System)所提供的分布式数据存储一样,HBase 在 Hadoop 之上提供了类似于 Bigtable 的能力。HBase 是 Apache 的 Hadoop项目的子项目。HBase 不同于一般的关系数据库,它是一个适合于非结构化数据存储的数据库。另一个不同的是 HBase 基于列的而不是基于行的模式。

二、使用步骤

1.环境准备

操作系统:Windows 10

虚拟机:VMware 15.5

集群系统:Centos 7 64位

Zookeeper版本:zookeeper-3.4.10

Hadoop版本:hadoop-3.3.1

HBase版本:Hbase2.4.4

2.集群规划

| IP | HostName | Software | Process |

|---|---|---|---|

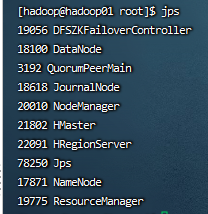

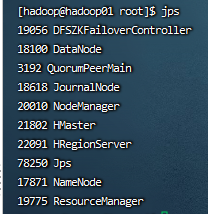

| 192.168.74.88 | hadoop01 | hadoop,zookeeper,hbase | DataNode,NodeManager,QuorumPeerMain,JournalNode,NameNode,DFSZKFailoverController,ResourceManager,HMaster,HRegionServer |

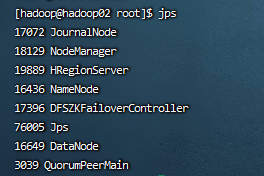

| 192.168.74.89 | hadoop02 | hadoop,zookeeper | DataNode,NodeManager,QuorumPeerMain,JournalNode,NameNode,DFSZKFailoverController,HRegionServer |

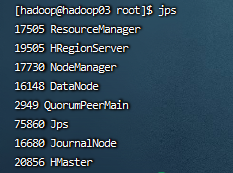

| 192.168.74.90 | hadoop03 | hadoop,zookeeper,hbase | DataNode,NodeManager,QuorumPeerMain,JournalNode,ResourceManager,HMaster,HRegionServer |

3.Hadoop (HA)+zookeeper安装

配置(示例):

1.关闭防火墙

2.JDK安装

3.设置静态IP和主机名

4.修改hosts文件

5.设置集群机器SSH免登

6.zookeeper分布式集群安装

# 配置系统环境变量

# 配置zoo.cfg

# 分发zookeeper安装包到其他节点

# 配置myid

# 启动zookeeper集群

zkServer.sh start

# 查看zookeeper集群状态

zkServer.sh status

hadoop01:follower

hadoop02:follower

hadoop03:leader

7.hadoop集群安装配置

# 配置系统环境变量

# 配置core-site.xml

# 配置hdfs-site.xml

# 配置mapred-site.xml

# 配置yarn-site.xml

# 配置workers文件

# 分发Hadoop安装包到其他节点

# 启动Hadoop集群

start-all.sh

hadoop01:jps

hadoop02:jps

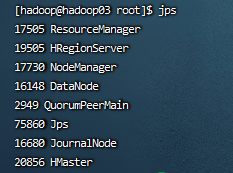

hadoop03:jps

测试高可用:

HDFS

http://192.168.74.88:9870 (active)

http://192.168.74.89:9870 (standby)

YARN

http://192.168.74.90:8088/cluster/cluster(active)

http://192.168.74.90:8088/cluster/cluster(standby)

Hadoop HA 集群启动完毕

2.HBase (HA)安装

配置(示例):

# 配置系统环境变量

# 修改hbase-site.xml

# 修改regionservers文件

# 创建pid文件保存目录

# 拷贝HBase到其他机器

# 启动HBase

stop-hbase.sh

start-hbase.sh

hbase shell

hadoop01:start-hbase.sh

hadoop03:start-hbase.sh

测试 Hbase 故障转移(主备)

http://192.168.74.88:16010/ (Master)

http://192.168.74.90:16010/ (Backup Master)

hbase shell

HBase HA 集群启动完毕

总结

记录点点滴滴