1.建表

CREATE TABLE `dws.dws_transaction_header_np`(

`oneid` string COMMENT '用户唯一id',

`transaction_header_id` string COMMENT '交易订单号(包括下单和退款的订单号)',

`transaction_date` date COMMENT '交易日期',

`cdp_data_source` string COMMENT 'cdp外部数据来源',

`create_time` timestamp COMMENT '数据从外部系统新增接入时 入sqlserver的时间',

`update_time` timestamp COMMENT '数据从外部系统变更接入时 入sqlserver的时间',

`invoice_no` string COMMENT '发票号')

ROW FORMAT SERDE

'org.apache.hadoop.hive.ql.io.orc.OrcSerde'

WITH SERDEPROPERTIES (

'field.delim'=',',

'serialization.format'=',')

STORED AS INPUTFORMAT

'org.apache.hadoop.hive.ql.io.orc.OrcInputFormat'

OUTPUTFORMAT

'org.apache.hadoop.hive.ql.io.orc.OrcOutputFormat'

LOCATION

'hdfs://azurepana01:9820/user/hive/warehouse/dws.db/dws_transaction_header_np'

;

CREATE TABLE `dws.dws_transaction_header_hive`(

`oneid` string COMMENT '用户唯一id',

`transaction_header_id` string COMMENT '交易订单号(包括下单和退款的订单号)',

`cdp_data_source` string COMMENT 'cdp数据来源',

`create_time` timestamp COMMENT '数据从外部系统新增接入时 入sqlserver的时间',

`update_time` timestamp COMMENT '数据从外部系统变更接入时 入sqlserver的时间',

`invoice_no` string COMMENT '发票号')

PARTITIONED BY (

`transaction_date` date)

ROW FORMAT SERDE

'org.apache.hadoop.hive.ql.io.orc.OrcSerde'

WITH SERDEPROPERTIES (

'field.delim'=',',

'serialization.format'=',')

STORED AS INPUTFORMAT

'org.apache.hadoop.hive.ql.io.orc.OrcInputFormat'

OUTPUTFORMAT

'org.apache.hadoop.hive.ql.io.orc.OrcOutputFormat'

LOCATION

'hdfs://azurepana01:9820/user/hive/warehouse/dws.db/dws_transaction_header'

2.参数配置

// hive-site.xml 默认参数配置 (允许使用动态分区)

<property>

<name>hive.exec.dynamic.partition</name>

<value>true</value>

</property>

<property>

<name>hive.exec.dynamic.partition.mode</name>

<value>nonstrict</value>

</property>

<property>

<name>hive.exec.max.dynamic.partitions</name>

<value>10000</value>

</property>

<property>

<name>hive.exec.max.dynamic.partitions.pernode</name>

<value>10000</value>

</property>

3.数据导入demo

// 在Hql和spark sql中可以使用正则表达式,指定你要查询的列

// HQL使得``内的内容表示正则表达式,不设置则无法使用正则表达式

SET hive.support.quoted.identifiers = none;

//spark sql 使得``内的内容表示正则表达式,不设置则无法使用正则表达式

SET spark.sql.parser.quotedRegexColumnNames=true;--非分区表数据导入分区表demo

insert overwrite table dws.dws_transaction_header_hive

select `(transaction_date)?+.+`,transaction_date

from dws.dws_transaction_header_np;

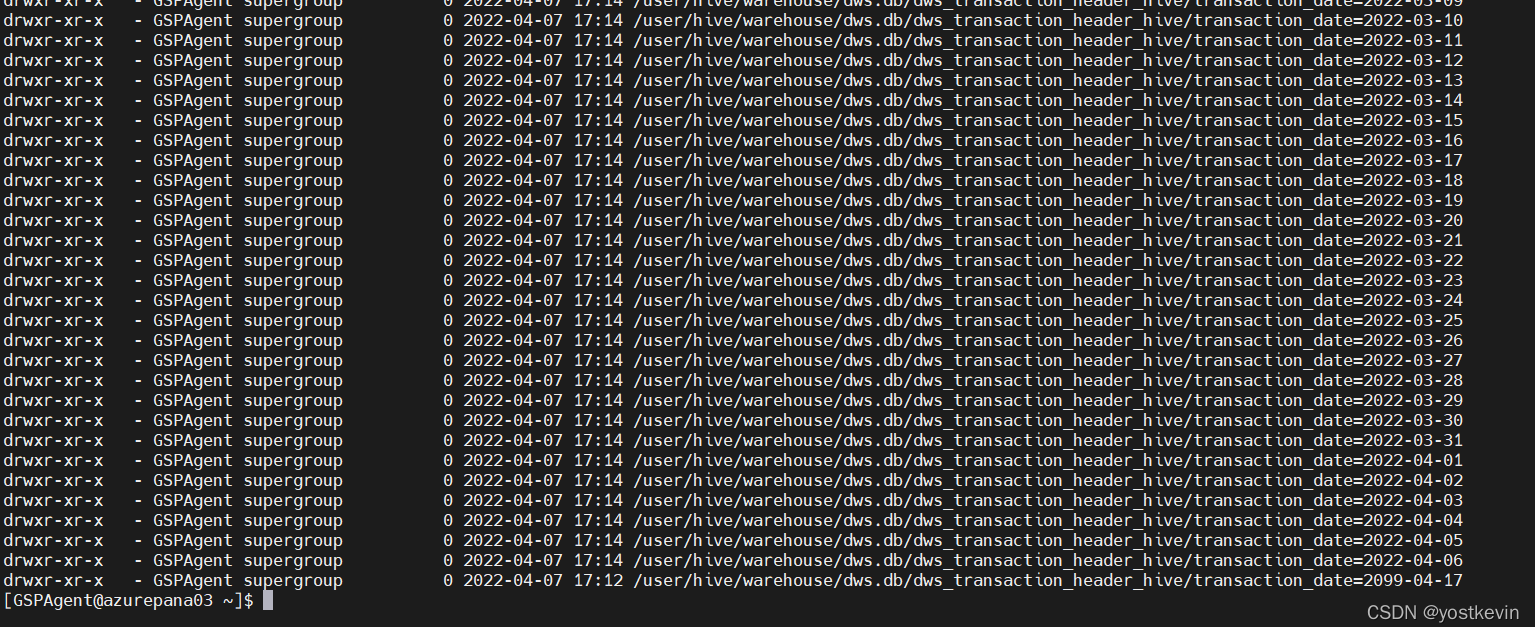

4.hdfs分区目录查询

?